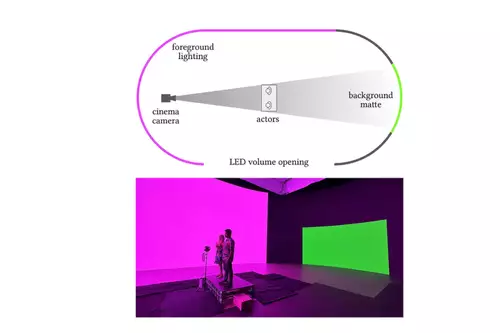

Wir hatten ja schon berichtet über den KI-gestützen Bildgenerator DALL-E 2 und darüber, daß es nur noch eine Frage der Zeit ist, bis ähnliches auch für Videos verfügbar ist. Nun ist es bald so weit - früher als gedacht: Der Heidelberger KI Forscher Patrick Esser hat auf Twitter eine Demonstration davon gezeigt, was bald an textbasiertem Editing von Video möglich sein wird im Rahmen des Online Video Editors Runway, bei dem Esser arbeitet. In einem kleinen Clip mit einem Tennisspieler wird gezeigt, wie der Hintergrund des Tennisplatzes nur mittels unterschiedlicher Textprompts dynamisch geändert wird. Der Algorithmus beruht auf dem bildgenerierenden DeepLearning Netzwerk Stable Diffusion, das bald auch kostenlos auf Heim PCs verfügbar sein wird.

So wird der Untergrund des Tennisplatzes etwa zu einem Strand oder das Match findet auf dem Mond oder in einer Phantasielandschaft statt. Im Democlip scheint das dynamische Freistellen des Tennisspielers samt Schatten und Ball in Echtzeit zu erfolgen, inklusive Tracking der Bewegung, um den Hintergrund korrekt zu bewegen, sowie der Generierung eines neuen Hintergrundes. Wie gut die Bildqualität letztendlich sein wird, kann aufgrund der recht niedrigen Qualität des Clips noch nicht beurteilt werden, aber wenn die Funktion erst einmal umgesetzt ist, lassen sich durch Optimierung des Algorithmus und mehr Rechenpower verschiedene Aspekte des Algorithmus auch recht einfach verbessern.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30-40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Diese Demo zeigt ein noch recht frühes Stadium von auf Machine Learning basierenden Funktionen - es scheint nur der Hintergrund auswechselbar zu sein -, aber sie zeigt schon eindrücklich, welch mächtige Funktionen schon bald durch das objektbasierte Editieren/Generieren von Videos (sei es wie hier mit Textkommandos oder auch durch Skizzen) möglich sein wird.

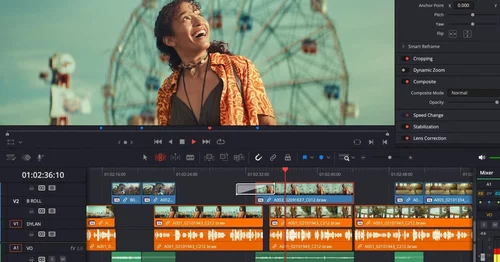

Der kollaborative Online-Videoeditor Runway bietet schon jetzt einige interessante KI Funktionen wie das intelligente Entfernen oder Maskieren von Objekten. Wir sind gespannt, wann die hier gezeigte, neue Funktionalität verfügbar sein wird.