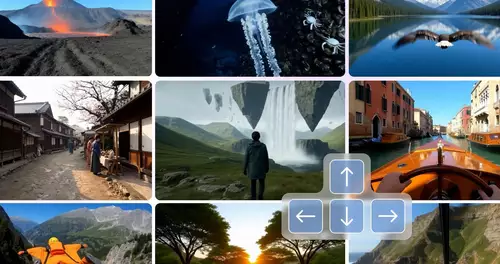

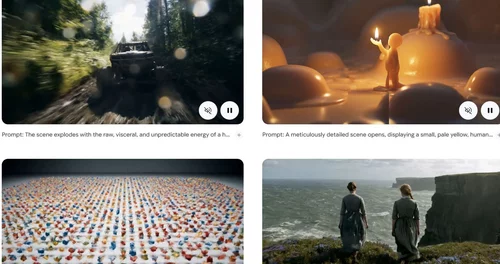

Video-KIs sind rasend schnell immer besser geworden und generieren inzwischen Videos, die kaum noch von gefilmter Realität zu unterscheiden sind. Um dies zu erreichen, müssen sie allen komplexen Gesetzen der Physik bei der Darstellung von Szenen folgen: Objekte im Vordergrund verdecken Objekte im Hintergrund, manche Objekte sind transparent, Lichtbrechung, Schattenwurf, Bewegung von Flüssigkeiten usw. – ganz abgesehen von den Besonderheiten der Bewegung von belebten Objekten oder menschlichen Gesichtsausdrücken.

Die beeindruckenden Fortschritte der Video-KIs haben zu einer leidenschaftlich geführten wissenschaftlichen Debatte geführt: Lernen Videomodelle – nur anhand der Videos, mit denen sie gefüttert wurden – sogenannte „Weltmodelle“ und entdecken physikalische Gesetze, oder sind sie lediglich hochentwickelte Pixel-Vorhersagemodelle, die visuellen Realismus ohne Verständnis physikalischer Prinzipien erreichen?

Eine Hauptfrage, die sich dabei aufdrängt, ist: verstehen KIs die Welt oder extrapolieren sie nur aus dem enormen Trainingsmaterial? Thema war das bereits bei der Vorstellung der ersten realistischen Video-KI, OpenAIs Sora vor anderthalb Jahren, als OpenAI begleitend den Artikel Video generation models as world simulators veröffentlichte, der in dem Satz endete: "Wir glauben, dass die heutigen Fähigkeiten von Sora zeigen, dass die fortlaufende Skalierung von Videomodellen ein vielversprechender Weg zur Entwicklung leistungsfähiger Simulatoren der physischen und digitalen Welt sowie der darin lebenden Objekte, Tiere und Menschen ist.".

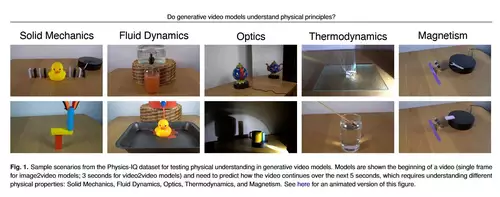

Ein Team von Forschern von Googles DeepMind hat vor knapp einem Jahr diesen Glauben einem Test unterzogen und untersucht, ob moderne Video-KIs wirklich physikalische Gesetze "verstehen". Dazu haben sie einen Physik-IQ genannten Benchmark entwickelt, der nur durch ein tiefes Verständnis verschiedener physikalischer Prinzipien wie Fluiddynamik, Optik, Festkörpermechanik, Magnetismus und Thermodynamik gelöst werden kann.

// Top-News auf einen Blick:

- Kameras, Objektive, Drohnen: Bis zu 1.530 Euro sparen bei Sony, Nikon & Co.

- Nahtloser 1-9x Zoom dank neuartiger optischer Konstruktion?

- Wenn man den Kotzschlauch sieht - Peinliche Fehler in neuer 4K Version von Mad Men

- Antigravity A1 - die erste 360° Drohne ist da

- Sony FX3 Sensor-Test - Dynamik, Debayering und Rolling Shutter

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

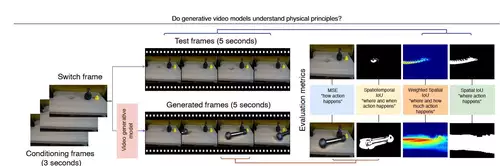

Jeder Test zeigt anhand eines echten Videos den Beginn eines Ereignisses und fordert dann eine Video-KI auf, die nächsten Sekunden vorherzusagen. Diese Vorhersage wird dann mit dem tatsächlichen Verlauf verglichen – durch Bewegungsanalysen, die prüfen, wo, wann und wie stark sich Dinge bewegen. Je nachdem, wie weit die Vorhersagen mit der Realität übereinstimmen, wird ein Physik-IQ Wert errechnet.

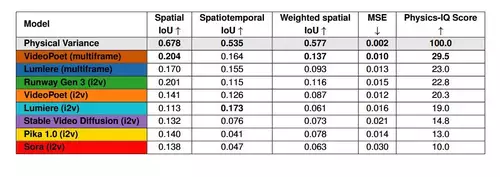

Die Ergebnisse zeigen, dass das physikalische Verständnis bei allen untersuchten Video-KIs (wie Sora, Runway, Pika, Lumiere, Stable Video Diffusion und VideoPoet) stark eingeschränkt ist und in keinem Zusammenhang mit dem visuellen Realismus steht.

So sind etwa die von Sora generierten Videos zwar am schwersten von echten Videos zu unterscheiden, doch die Physikbewertung des Modells ist niedrig – was zeigt, dass Realismus und physikalisches Verständnis nicht korreliert sind.

Einige Testszenarien wurden dennoch erfolgreich gelöst und von manchen Modellen richtig vorhergesagt. Dies deutet darauf hin, dass das Erlernen bestimmter physikalischer Prinzipien allein durch Beobachtung möglich sein könnte – jedoch bestehen weiterhin erhebliche Herausforderungen. Die Forscher rechnen in naher Zukunft mit schnellen Fortschritten, aber ihre Arbeit demonstriert, dass visueller Realismus kein echtes, physikalisches Verständnis und damit ein internes Weltmodell impliziert.