Der KI-Algorithmus zum Austauschen von Videohintergründen, dem wir gerade eine eigene News gewidmet haben, nutzt als Grundlage zur Bilderstellung die offene bildgenerierende KI Stable Diffusion. Sie wurde von den KI Forschern Patrick Esser und Robin Rombach entwickelt und gerade als geschlossene Beta gestartet. Das Spannendste ist, daß Stable Diffusion schon bald als Software veröffentlicht werden wird, welche auf Consumer-PCs läuft. Es reicht schon eine Grafikkarte mit 5 GB VRAM (wie etwa eine Nvidia GeForce GTX 1660, RTX 2060 oder eine AMD Radeon RX 5600) aus, um 512x512 Pixel große Bilder in wenigen Sekunden zu erzeugen.

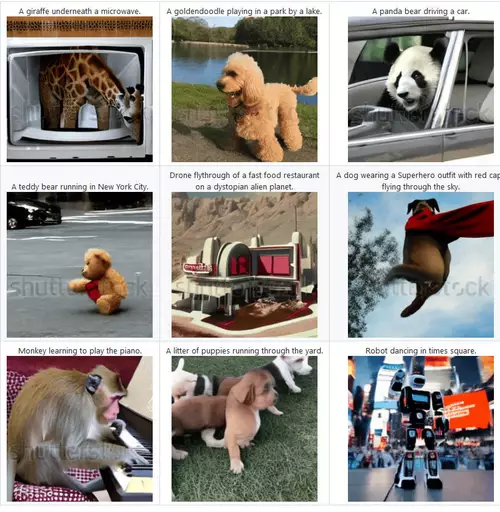

So wird die Generierung von Bildern per Text, die bisher nur einem eher engen Kreis von Menschen zugänglich war (oder nur wenige kostenlose Generierungen zuließ), wie etwa per DALL-E 2 und Midjourney), bald für sehr viel mehr Menschen erfahrbar, die damit selbst ohne jede Beschränkung experimentieren können.

// Top-News auf einen Blick:

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Kommt die Sony Alpha 7 V am Dienstag?

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

- Blackmagic PYXIS 12K - Sensor-Test - Rolling Shutter und Dynamik

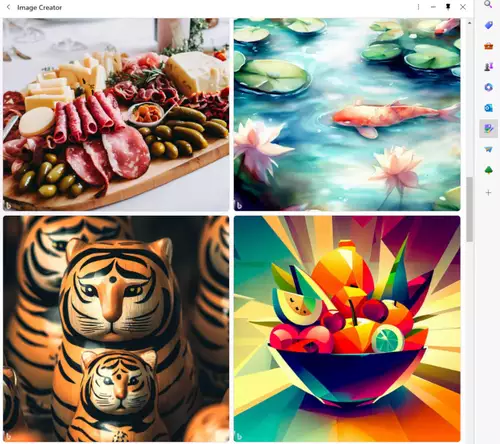

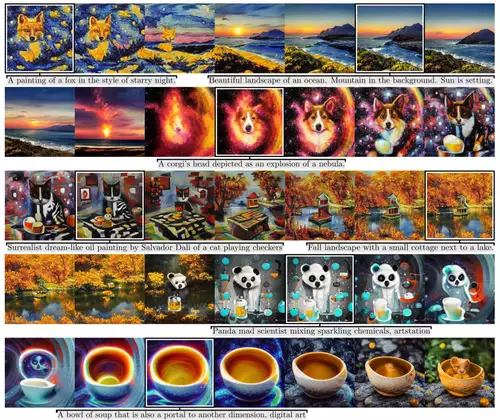

Diese Asymmetrie ist typische für neuronale Netzwerke, bei denen viel Rechenpower in das Training gesteckt werden muss, das daraus resultierende spezifische Modell, also das neuronale Netz mit all seinen Gewichtungen der einzelnen Knotenpunkte, dann aber viel weniger Leistung benötigt. Kein Wunder - besteht doch zum Beispiel das für Stable Diffusion verwendete, öffentliche Laion B5 Dataset aus einer 240 TB großen Sammlung von 5 Milliarden Bildern samt mehrsprachigen Bildbeschreibungen (das hier durchsucht werden kann), das für ein Trainingslauf eingelesen und gelernt werden muss. Wir sind jedenfalls gespannt auf die ersten selbst erzeugten Bilder und freuen uns auf die Experimente damit. Bis dahin hier ein schöner Vergleich einiger aktueller bildgeneriernder KIs und ihrer besonderen Stile und zwar DALL-E 2, Stable Duffusion, Crayon, Midjourney und DALL-E Flow.