Im Rahmen von Adobe Firefly lassen sich beim Generieren auch KI-Modelle von anderen Anbietern nutzen - nun wurden zwei weitere Modelle zur Bildgenerierung sowie zur Hochskalierung von Videos integriert. Hinzugekommen sind außerdem neue Funktionen, die noch mehr Kontrolle und Auswahlmöglichkeiten bei der Erstellung von Videos bieten.

Der zur MAX angekündigte Firefly-Videoeditor, mit dem sich nicht nur KI-Videos generieren, sondern auch mehrere Clips auf einer Timeline kombinieren und vertonen lassen, ist nun als Beta-Version verfügbar. Zudem bietet Adobe wieder allen Abonnenten (ab Pro) bis zum 15. Januar unbegrenzte Bildgenerierungen mit allen Modellen (wie Googles Gemini 3 Nano Banana und Imagen, FLUX.1, OpenAIs GPT Image) sowie unbegrenzte Videogenerierung mit dem eigenen Firefly-Modell.

Neue Modelle zum Hochskalieren und Bilder generieren

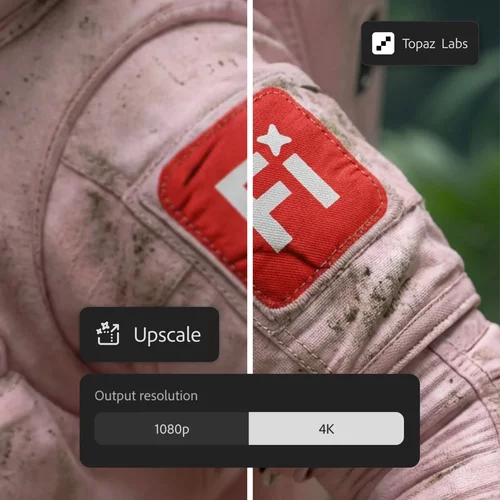

Adobe ergänzt das bisher schon große Angebot an unterstützten Video-Modellen anderer Hersteller (wie unter anderem Google Veo 3.1, OpenAIs Sora 2, Lumas Ray, Runway Gen-2 Aleph) in Firefly um das auf die Hochskalierung von Video spezialisierte Astra-Modell von Topaz. Mit dessen Hilfe können niedrig aufgelöste (alte) Videos auf aktuelle Auflösung von 1080p (1.920 x 1.080) oder auch 4K (3.840 x 2.160 Pixel) hochskaliert bzw. geschärft werden.

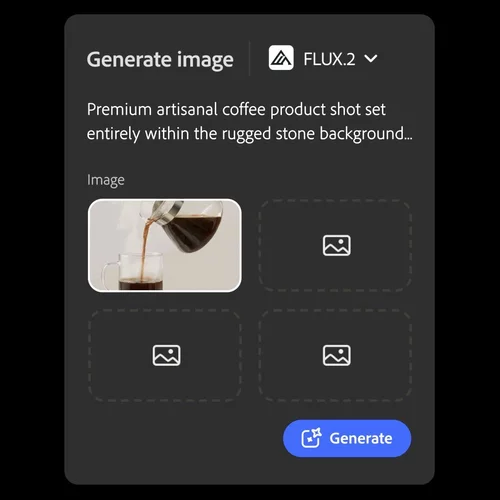

Zudem wird die Auswahl an Bild-KIs um das neueste Bildmodell FLUX.2 von Black Forest Labs erweitert, mit dessen Hilfe Bilder mit einer Auflösung von bis zu 1 Megapixel und flexiblen Seitenverhältnissen generiert und auch bearbeitet werden können. FLUX.2 kann auch fotorealistische Details sowie Texte in Bildern generieren und unterstützt bis zu vier Referenzbilder. FLUX.2 ist in den Firefly-Modulen „Text to Image“, „Prompt to Edit“ und „Firefly Boards“ sowie in Photoshop Desktop und ab Januar auch in Adobe Express verfügbar.

Videos per Prompt bearbeiten

Ein Problem, auf das User oft beim Generieren von Videos stoßen: das Ergebnis entspricht nur teilweise der Vorstellung, wie das Video aussehen soll, eines der Objekte ist etwa nicht so wie gewünscht. Doch wird der Clip neu generiert, ist das wie beim Würfeln; vielleicht wird der neue Clip besser – oder auch nicht. Ein Vorgehen, bei dem wertvolle Credits verbraucht werden.

// Top-News auf einen Blick:

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

- Datacolor SpyderPro - Überragendes Feature-Upgrade für Videografen

Das soll jetzt nicht mehr nötig sein, denn mit der neuen Funktion „Prompt to Edit“ können Clips per Prompt jetzt nachträglich gezielt mittels Runways Aleph-Modell bearbeitet werden. So können zum Beispiel Personen oder Objekte per Prompt aus dem Video entfernt oder durch andere ersetzt werden. Auch der Bildausschnitt oder die Kamerabewegung eines vorhandenen Clips (KI-generiert oder echt gefilmt) lassen sich auf diesem Wege ändern.

Kamerasteuerung per Referenzvideo

Eine weitere neue Funktion ermöglicht eine präzisere Kontrolle über die Bewegung der virtuellen Kamera in einem Clip. So lässt sich ein Startbild im Zusammenspiel mit einem Referenzvideo hochladen, welches die gewünschte Kamerabewegung zeigt.

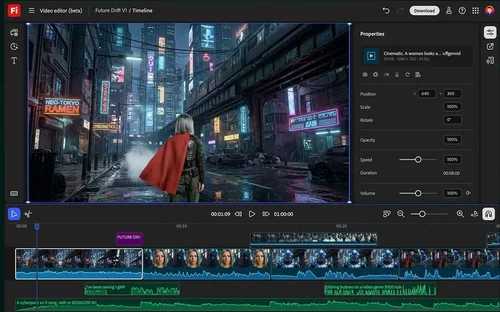

Firefly Video-Editor im Browser

Neu ist die verfügbarkeit des Firefly Video-Editors, der nun in einer öffentlichen Beta-Version genutzt werden kann. Mit seiner Hilfe können direkt im Browser komplette Videos erstellt werden, indem generierte Clips, Sounds und Bildmaterial sowie gegebenenfalls auch eigenes (nicht generiertes) Filmmaterial in einer mehrspurigen Timeline kombiniert werden kann.

Auf der Timeline wird das Video ganz klassisch direkt editiert oder – etwa bei Interviews oder anderen Aufnahmen von Gesprächen – mittels der Bearbeitung des transkribierten Textes. Das fertige Video kann in verschiedenen (Social Media tauglichen) Formaten exportiert werden.