Die Zeiten ändern sich - und das deutlich schneller als erwartet. Während ARRI mit seinem ALEXA ALEV3-Sensor die letzten 12 Jahre praktisch unverändert DEN Hollywood Cinema Look definierte (und den letztlich jeder andere Kamerahersteller einzuholen versuchte) werden die nächsten 12 Jahre sicherlich nicht mehr so ruhig verlaufen.

ARRI hat zwar mit der ALEXA35 nun die Dynamik Referenz für cinematische Anwendungen um weitere 3 Blendenstufen angehoben und die S35-Auflösung zugleich nicht nur fürs Kino sondern auch für Netflix auf 4,6K gehievt, doch die Weichen für das nächste Jahrzehnt stellen in den kommenden Jahren wahrscheinlich andere Player.

Ähnlich wie sich die Filmtechnik ab 2010 mit der Vorstellung der ALEXA dann doch schneller als erwartet vom analogen Film trennte, stehen wir heute und hier wieder vor großen Veränderungen. Wahrscheinlich ist es nicht übertrieben, in diesem Zusammenhang von einem cinematischen Paradigmenwechsel der Filmtechnik zu sprechen.

Aufgrund der sich rasend schnell entwickelnden KI Technologien sehen wir im Monatsrhythmus neue Verfahren, um die Qualität von Bewegtbildern markant zu verbessern. Am treffendsten lassen sich diese Verbesserungen unter dem Begriff "Computational Cinematography" zusammenfassen.

Hierunter fallen nicht nur klassische Bereiche wie beispielsweise Denoising oder Color Correction. Stattdessen rückt durch die Möglichkeiten des Deep Learnings das kreative "Ergänzen" von fehlenden Bildinformationen in den Vordergrund. Dies ermöglicht nicht nur die synthetische Erhöhung der Frameraten oder der Auflösung durch Supersampling, sondern wird letztlich auch in einer synthetischen Erweiterung der Dynamik resultieren. Und auch wenn es noch für viele illusorisch klingt: Mittelfristig wird wahrscheinlich überhaupt keine "richtige" Kamera mehr vonnöten sein, um sich von einer KI hochqualitative Filmsequenzen nach persönlichen Vorgaben erstellen zu lassen.

Doch bis dies soweit ist, werden noch ein paar Jahre vergehen - währenddessen man mit KI-Modellen das aufgezeichnete Kamerabild über "Computational Filter" immer weiter optimieren kann. Und diese Zeit ist bereits angebrochen. Was uns zum eigentlichen Thema dieses Artikels führt: Wie kann ich bereits heute bestmöglich für eine Postproduktion filmen, die aktuelle (KI-)Methoden zur Bildoptimierung nutzt?

Egal, wie atemberaubend Deep Learning Ergebnisse auch ausfallen, es gilt noch mindestens bis ins nächste Jahrzehnt die Old School Regel: "Je besser der Input desto besser der Output." Weshalb wir die folgenden Input-Regeln für gute Ergebnisse beim Einsatz von "Computational Cinematography" näher erklären wollen:

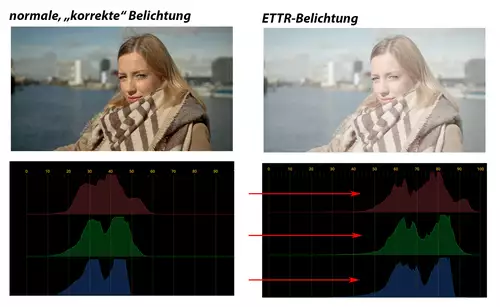

ETTR-Belichtung

Unter ETTR versteht man, das Bild so zu belichten, dass helle Bildbereiche gerade nicht oder nur kaum überbelichtet werden. Die Bezeichnung ETTR bedeutet "Exposure To The Right", weil man bei dieser Belichtung versucht, die Helligkeitswerte im Histogramm möglichst weit rechts anzusiedeln.

Um auch den letzten Rest Dynamik und damit Bildqualität aus dem Sensor zu kitzeln, ist ETTR technisch gesehen Pflicht - weil der Anteil des Rauschens am Bildsignal dadurch verringert wird. Man kann ETTR auch mit dem "Aussteuern" bei einer Audioaufnahme vergleichen. Auch hier versucht man, möglichst nahe an den digitalen Nullpegel heranzukommen (ab dem das Audiosignal übersteuern/clippen würde), damit das Rauschen möglichst wenig Anteil am gesamten Audiosignal hat.

Bei ETTR geht es also nicht darum, in der Kamera ein ansehnlich belichtetes Bild zu erzeugen, sondern so wenig Rauschen wie möglich aufzuzeichnen. Wer dagegen die Kür wählt und nach Mittelgrau belichtet, bekommt zusätzliches Rauschen und damit weniger nutzbare Bildinformation für die Nachbearbeitung.

Zu wenig Rauschen gibt es übrigens nicht und es macht heutzutage kaum noch Sinn dieses Rauschen bei der Aufnahme als Stilmittel mit aufzuzeichnen. Rauschen oder auch spezielles Filmkorn lässt sich mittlerweile gut simulieren und digital hinzufügen. Dies kann übrigens nachträglich sehr hilfreich sein, um zwei oder mehr Szenen in ihrer Anmutung in der Timeline aneinander anzugleichen.

RAW...

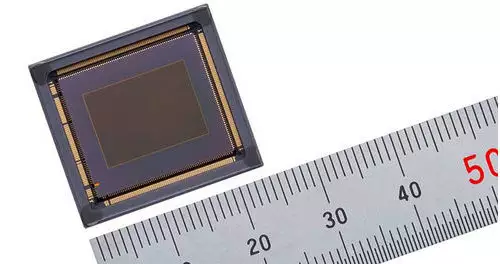

RAW ist ebenfalls das Tool der Wahl, wenn man die letzten Reserven eines Sensors ausnutzen will. 10 Bit 4:2:2 (möglichst wenig komprimiert) ist meistens die nächstbeste verfügbare Alternative. Dabei ist übrigens All-I nicht grundsätzlich besser als Interframe-Kompression, da bei ALL-I dem Codec pro Bild oft weniger Speicherplatz zur Verfügung steht, als bei einer gut vorhersehbaren GOP-Kompression.

All-I macht meistens nur den Schnitt angenehmer (weil flüssiger), ist aber keinesfalls ein Garant für weniger Artefakte pro Frame. Problematisch können LongGOP-Codecs dennoch sein - weil sie manchmal noch eigene Bildinformationen in ihrer Zwischenbild-Prognose hinzu erfinden, die in der Post dann vielleicht einer korrekten Bildanalyse entgegenstehen.

... und Noise

Ein spezieller Fall ist hierbei die interne Rauschunterdrückung eines Codecs. Erfordert die Postproduktion noch weiteres Denoising, so gelingt dies mit bereits komprimiertem Rauschen meistens nicht mehr so gut. Nicht zuletzt kann die Postproduktion das Material für ein Denoising immer weitaus sorgfältiger analysieren als eine Kamera in Echtzeit bei der Aufnahme.

Allerdings darf man auch im Hinterkopf behalten, dass mittlerweile viele RAW-Formate ebenfalls ein Denoising in der Kamera durchführen, was sich in der Regel auch nicht mehr komplett abschalten lässt.

Dennoch gilt grundsätzlich: Je purer der Noise aufgezeichnet wird, desto besser kann die Noise Reduction in der Post arbeiten. Und dafür ist RAW mit niedriger Kompressionsrate meistens die beste Wahl.

Verschluss - Shutter

Wer den perfekten cinematischen Look sucht, bekommt auf die Frage nach der perfekten Shutter-Zeit eine eindeutige Antwort aus der Vergangenheit: Filme werden seit ungefähr einem Jahrhundert mit 24 Bildern pro Sekunde und einem 180 Grad Shutter gedreht. Wer also die "gleiche" Motion-Blur Anmutung erzielen will, sollte den Shutter seiner Kamera ebenso einstellen - bzw. bei 24p möglichst "nahe" an 1/48s - falls die Kamera keine digitale Winkeleinstellung besitzt.

Gemessen an typischen heutigen Schärfegewohnheiten aus der professionellen Fotografie ist die dabei aufgezeichnete Bewegungsunschärfe (engl. Motion Blur) extrem unscharf. Das ist meistens gewollt und bewirkt einen großen ästhetischen Unterschied gegenüber weitaus schärferen Video-Broadcast/Live Anwendungen mit kürzeren Shutter Zeiten.

Doch was im finalen Produkt dem Auge schmeichelt, verschlechtert die Möglichkeiten in der Postproduktion. Egal ob Denoising, Stabilizing, Objekt- oder Szenen-Tracking. Je schärfer die erkennbaren Objekte (und deren Kanten), desto besser die Ergebnisse der digitalen Nachbearbeitungs-Möglichkeiten.

Und darum gilt für für die Computational Postproduction: Weniger Motion Blur ist immer besser. Und damit analog: Je kürzer die Belichtungszeit, desto besser. Motion Blur lässt sich übrigens nachträglich durch eine Optical Flow Simulation in guter Qualität wieder hinzurechnen - mit einer kräftigen GPU mittlerweile sogar in Echtzeit.

Rolling Shutter

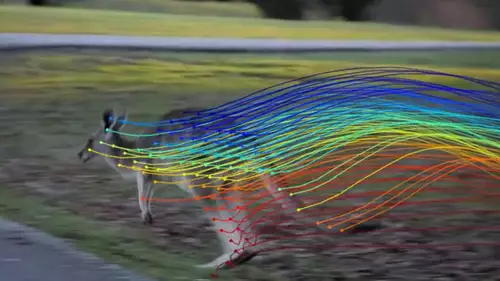

Wenn man die Wahl zwischen verschiedenen Kameramodellen hat, sollte man auch die Zeiten für den Rolling Shutter in die Entscheidungsfindung einbeziehen. Denn selbst wenn man ohne stark bewegte Kamera filmt, verkrümmt der Rolling Shutter jedes Objekt, das sich vor der Kamera bewegt. Nicht unbedingt für das Auge direkt wahrnehmbar, stellt dies trotzdem für Bildanalyse-Algorithmen eine unnötige zusätzliche Hürde dar. Ein möglichst kurzer Rolling Shutter ist daher niemals verkehrt, solange er nicht auf Kosten der Bildqualität geht. So kann ein Sensor beispielsweise seine Auslesezeit verkürzen, indem er Zeilen auslässt - was der Bildqualität jedoch sichtbar schadet.

HFR - Hohe Frameraten

Fraglos ist mit einer cinematischen Ästhetik auch die Bewegungsauflösung verbunden. Die 24p, mit denen ebenfalls schon seit ungefähr 100 Jahren Kino gemacht werden, sorgen für leicht abgehackte Bewegungen. Der Grund liegt vor allem darin, dass mit dem 180 Grad Verschluss immer rund die Hälfte der Zeit eines Bildes weggeworfen (bzw. erst gar nicht aufgezeichnet) wird. Es fehlt im zeitlichen Verlauf also immer rund die Hälfte eines Bewegungsvorgangs, bevor das nächste Einzelbild belichtet wird. Filmt man mit 48p und hält die Belichtungszeit bei 1/48s, so entspricht dies einem 360 Grad Shutter und es geht keine Bewegungsphase zwischen den Bildern verloren. Dies sieht im Vergleich zum klassischen Film meistens hyperrealistisch aus und wird darum in der Regel nicht für szenische Aufzeichnung genutzt. Man kann übrigens ganz leicht aus 48p Material mit 360 Grad Shutter eine cinematische Bewegungsauflösung generieren, indem man in der Timeline einfach jeden zweiten Frame wegwirft.

Es macht viel Sinn, die zusätzlichen Frames dennoch mit(auf)zunehmen, denn die digitale Analyse einer Szene gelingt in der Regel umso besser, je mehr Informationen vorliegen. Gerade beim temporalen Denoising helfen zusätzliche Frames oft ungemein, wenn der Denoiser mehr Nachbar-Frames auswerten kann. Auch beim Stabilisieren mit Optical Flow helfen mehr Frames für das "Lösen der Szene". Für das Retiming gilt dies naheliegenderweise ebenfalls. Aus eben solchen Gründen kann man nie genug Frames/Sekunde für die Postproduktion einsammeln.

Wie bereits erwähnt, lassen sich 48p ohne Einschränkung der Belichtungszeit auf 24p reduzieren, weshalb man für 24p Projekte auch guten Gewissens mit 48p aufzeichnen kann. Für höhere Frameraten ist dagegen Abwägung gefragt, weil man mit kürzeren Belichtungszeiten eben auch Belichtungsspielräume des Sensors einbüßt. Zugleich bedeuten kürzere Shutterzeiten allerdings auch weniger Motion Blur, der ja digital kompensiert werden sollte (s.o.).

Fazit:

Wer für eine "Computational Potproduktion" bestens aufgestellt sein will, sollte aus den angeführten Gründen mit hohen Frameraten und maximaler Sensorauflösung bei möglichst kurzen Shutterzeiten in RAW mit geringer Kompression und ETTR-Belichtung filmen.

Anschließend kann man das Material in der Post besser denoisen und stabilisieren, um eine gute Ausgangsbasis für weitere Korrekturen zu haben. Hat die Kamera wenig Rolling Shutter lässt sich so in manchen Fällen sogar unstabilisiert aus der Hand arbeiten. Wer letzteres plant, sollte für eine 4K Produktion dazu mit maximaler Auflösung (6-12K) arbeiten, damit der digitale Stabilizer noch genügend Rand zum Korrigieren vorfindet.

Abschließend lässt sich das Projekt dann in 24p (mit entsprechender Bildauslassung) sowie mit synthetisiertem Motion Blur ausspielen und im Grading eventuell noch mit zusätzlichem Grain verfeinern.