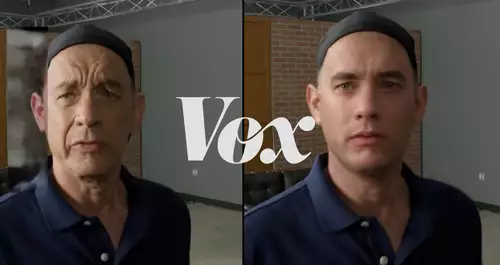

Wer würde nicht gerne mit minimalem Aufwand Geld verdienen? Das haben sich wohl Schauspieler gedacht, die für mehrere tausend Dollar ihren digitalen Doppelgänger an einen Anbieter von KI-Avataren lizenziert haben. Ein unschönes Erwachen allerdings erlebten viele, die dann sehen, wofür ihr Avatar eingesetzt wurde: für fragwürdige Werbung, Scams oder sogar politische Propaganda – und die menschlichen Vorbilder haben keine Möglichkeit mehr, das zu verhindern.

Billige KI-Avatare als Alternative zu echten Drehs

KI-gestützte Dienste wie das mit rund 2 Milliarden Dollar bewertete Synthesia bieten sich als billige Alternative zu Produktionen mit echten Schauspielern an, hauptsächlich für Talking-Heads-Videos, zum Beispiel für Marketing, Social Media oder Videobotschaften. Das Ausgangsmaterial liefern halbtägige Greenscreen-Videodrehs mit echten Schauspielern, die verschiedene Emotionen darstellen müssen. Aus diesem Material werden dann per KI Avatare generiert, die in Videos für die Kunden genutzt werden können. Zwar können Avatare, die wie echte Menschen aussehen, auch rein per KI generiert werden, aber die auf Schauspieler-Scans beruhenden Avatare sollen in Bezug auf die Ausdruckskraft (noch) realistischer wirken.

Kunden der Plattform können dann einen von vielen Avataren auswählen und ihn in beliebigen Sprachen und Tonlagen mit eigenen Texte füttern; die KI generiert daraus echt aussehende Talking-Head-Videos.

Weitreichende Verträge

Doch die Verträge, die die Schauspieler unterschrieben haben, haben es in sich: Einige Unternehmen nutzen weitreichende, nicht widerrufliche Lizenzen mit weltweiter Gültigkeit, gegen die nachträglich kein Einspruch eingelegt werden kann. So sind Schauspieler machtlos, wenn ihre digitalen Klone online in fragwürdigen Kampagnen eingesetzt werden.

So kassierte beispielsweise der New Yorker Schauspieler Adam Coy 1.000 Dollar für die Nutzung seines digitalen Avatars, welcher dann als Zeitreisender vor Katastrophen warnte. Der britische Schauspieler Connor Yeates fand sich wieder als Sprachrohr des Präsidenten von Burkina Faso, und der südkoreanische Schauspieler Simon Lee musste feststellen, dass sein virtuelles Ebenbild mal als Gynäkologe, mal als Chirurg auf TikTok und Instagram Werbung für Zitronenmelissentee zum Abnehmen oder Eisbäder gegen Akne auftrat.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Synthesia räumte auf Presseanfragen ein, dass seine Plattform durch zeitweilige Lücken in der Inhaltskontrolle irreführende und propagandistische Clips generiert wurden, und gelobt nun Besserung. Allerdings haben andere KI-Avatar-Plattformen noch lockerere Regeln. Experten fordern daher mehr Transparenz, rechtliche Vorgaben und Aufklärung – denn hinter jedem Avatar steckt ein realer Mensch, der sich mit realen Konsequenzen konfrontiert sehen kann.

Der Kampf um die KI-Klone in Hollywood

Dieser Konflikt spiegelt im Kleinen den großen Kampf um das Recht am eigenen Avatar wider, der auch in einem größeren Maßstab in Hollywood ausgefochten wird, wo Schauspieler im letzten Jahr per Streik durchgesetzt hatten, die Kontrolle über den Einsatz ihrer Avatare sowie Kompensation dafür zu erhalten.

Schauspieler dagegen, die nicht gewerkschaftlich organisiert sind oder mit Avatar-Firmen Verträge abschließen, sollten sich über die Tragweite ihrer Entscheidungen klar sein – ihr Abbild wird ohne ihr Wissen womöglich für Kampagnen eingesetzt, die ihren Ruf schädigen und sich so negativ auf ihre Karriere als Schauspieler auswirken können.