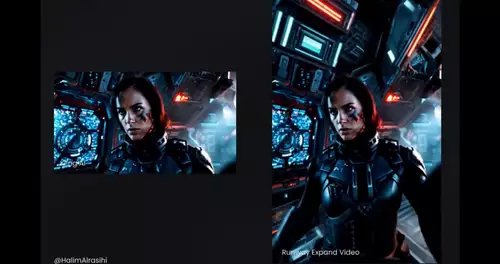

Runway hat gestern das Feature "Gen-4-Referenzen" in allen kostenpflichtigen Tarifen freigeschaltet. Hiermit können Anwender ab sofort konsistente Charaktere, Orte und andere Objekte in virtuelle Clips einfügen, ohne hierfür besondere technische Fähigkeiten mitbringen zu müssen.

Mit Referenzen lassen sich schon seit längerer Zeit in diversen KI-Modellen Fotos, generierte Bilder, 3D-Modelle oder Selfies verwenden, um darauf basierend ein künstliches Bild zu erschaffen. Ein bisher dabei auftretendes Problem ist dabei die Charakter-Konsistenz. So haben künstlich generierte Bilder zwar oft eine große Ähnlichkeit mit der Referenz, jedoch unterliegt diese trotzdem meistens gewissen statistischen Abweichungen. Nutzte man beispielsweise das Foto eines Schauspielers als Referenz über mehrere Szenen verteilt, so sah dieser bislang in jeder Szene ein bisschen anders aus.

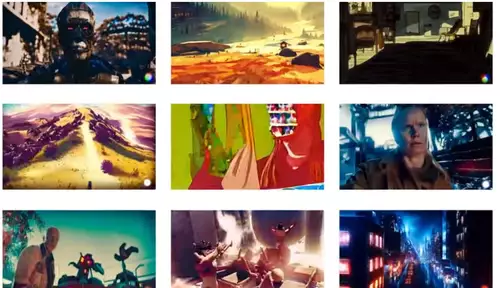

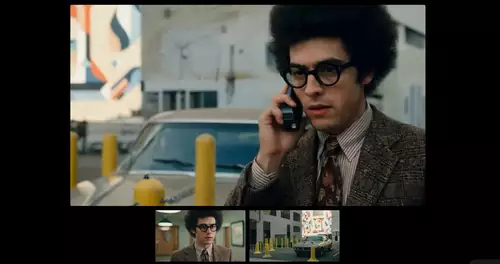

Wie nun die neuen Beispiel-Clips von Gen 4 belegen, ist das Problem der konsistenten Charaktere auf einem sehr guten Weg, bald gelöst zu sein. Bereits jetzt können die Ergebnisse der neuen Funktion in Gen4 in vielen Fällen überzeugen, wie man beispielsweise in diesem längeren Demo-Clip schön sehen kann:

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30-40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Aktuell funktionieren die neuen Gen-4-Referenzen am besten mit Personen und Locations, aber Runway verspricht in naher Zukunft auch die Zusammenarbeit mit anderen Objekten.

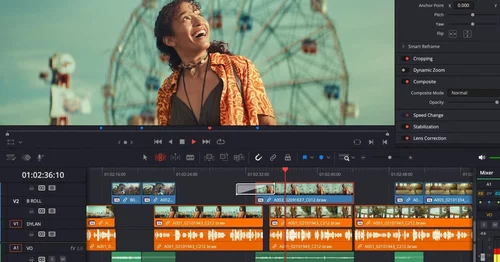

Und wer sich dafür interessiert, wie man das Ganze in der Praxis benutzen kann, der findet hier einen kleinen Workshop, der die grundsätzliche Bedienung in Runway erklärt: