Obwohl wir fast wöchentlich neue Forschungsfortschritte bei der diffusionsbasierten Videogenerierung sehen, existiert hier ein grundsätzliches Problem: Die bestehenden Diffusionsmodelle lassen nur relativ kurze Modelle zu, da der Bildinhalt sich (noch?) nicht über längere Zeiträume konsistent generieren lässt.

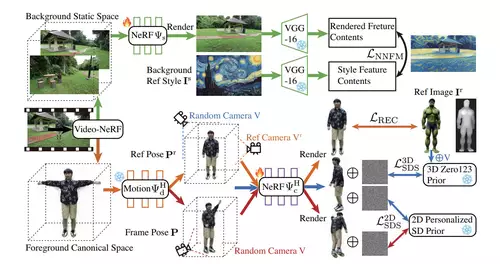

Ein neues Projekt namens DynVideo-E versucht, dieses Problem nun mit einem recht analytischen Ansatz für einen Spezialfall exemplarisch zu lösen: Das Input Video ist dabei immer ein sich bewegender Mensch, der von einer bewegten Handkamera verfolgt wird.

Durch die Nutzung von dynamischen NeRFs (Neural Radiance Fields) versucht man, die gesamte Aufnahme zuerst einmal als texturierten 3D-Raum zu begreifen, der aus den Blickwinkeln der bewegten Kamera gewonnen wird. Der im Originalvideo vorkommende Mensch wird dabei auf die Bewegung seiner Posen reduziert.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Auch wenn die Ergebnisse noch weit davon entfernt sind, fotorealistisch zu sein, zeigt das Projekt die prinzipielle Möglichkeit auf, einzelne Objekte in einem Video gezielt zu modifizieren. Nicht zuletzt ist es auch denkbar, DynVideo-E-Clips anschließend als Input für ein weiteres diffusionsbasiertes Modell zu nutzen, welches dann noch fotorealistischer "rendern" könnte.

Dass KI-Modelle beeindruckende Bilder schaffen können, dürfte mittlerweile unbestreitbar sein. DynVideo-E zeigt dagegen eine mögliche Idee, wie sich KI-Modelle im Allgemeinen auch zuverlässiger steuern lassen könnten. Denn im Bereich der exakten Kontrolle über das Bild dürfte in nächster Zeit besonders viel Forschung gefragt sein.