Runway hat mit Aleph ein neues Videomodell vorgestellt, das zahlreiche Funktionen speziell zur nachträglichen Videobearbeitung per KI mitbringt und dadurch im Handumdrehen aufwändige Spezialeffekte ermöglicht, ohne die sonst dafür notwendigen Fachkenntnisse und Tools. Traditionelle VFX-Werkzeuge wie Keying, Maskierung und Rotoscoping werden dabei durch simple Prompts ersetzt. Einige der Funktionen wie In-Painting oder Style-Transfer sind bereits in verschiedenen Video-KIs vorhanden, Aleph vereint jedoch viele Möglichkeiten unter einem Dach.

KI-Funktionen wie diese von Aleph werden über absehbare Zeit die Filmproduktion revolutionieren, denn sie ermöglichen tiefgreifende kreative Entscheidungen auch noch nach dem eigentlichen Dreh in der Postproduktion und dadurch auch völlig neue Freiheiten beim Filmdreh selbst: Die echten Filmaufnahmen sind nur das Rohmaterial, das zu völlig unterschiedlichen Ergebnissen geformt werden kann mit der Hilfe von KI.

Grundlage der neuen Funktionen ist vorhandenes Filmmaterial, das dann per Prompt (und manchmal auch einem Referenzbild) transformiert werden kann. Mit der Hilfe von Aleph können Filmer nicht nur gezielt einzelne Objekte in einem Video entfernen oder verändern, sondern auch neue Einstellungen einer Szene aus anderen Kamerawinkeln synthetisieren oder auch den Stil, die Beleuchtung oder den Hintergrund einer Szene nachträglich ändern. Dabei erfolgen Änderungen anders als beim klassischen Compositing nicht nur selektiv an einem Objekt, sondern – dank dem physikalischen Verständnis der KI der gesamten Szene und ihrer Objekte – quasi ganzheitlich, d. h. wird ein bestimmtes Objekt geändert, ändern sich automatisch auch die Beleuchtung oder der Schattenwurf entsprechend.

Im folgenden Video werden die neuen Funktionen demonstriert – leider nur sehr kurz, sodass schwer zu beurteilen ist, wie gut aktuell die Qualität der Effekte ist. So richtig State-of-the-Art kommt uns das ganze noch nicht vor:

Die Funktionen von Runway Aleph:

Neue Kameraperspektiven generieren

Aleph ermöglicht es, Aufnahmen aus einem alternativen Blickwinkel auf eine Szene zu erstellen – und zwar nicht nur synthetisierte Aufnahmen aus einem leicht veränderten Kamerawinkel, sondern aus vollkommen anderen Kamerapositionen. So kann aus einem seitlichen Medium Shot ein Close-up, eine Rückansicht oder eine Untersicht generiert werden – ohne dass das Ausgangsmaterial physisch neu gefilmt werden muss. Soll die gefilmte Szene aus einer anderen Perspektive gezeigt werden, wird der neue Hintergrund samt anderer im Originalvideo nicht sichtbarer Bildausschnitte/Objekte per generativer KI passend hinzuerfunden.

So kann der Cutter oder Regisseur in der Postproduktion fehlende Kameraeinstellungen nachträglich generieren und befreit sich so von der sonst absoluten Abhängigkeit vom vorhandenen Material.

Den nächsten Shot generieren

Aleph kann auch eine auf eine Szene folgende Anschlusseinstellung generieren samt Kontinuität der Objekte, des Hintergrundes und allgemeinen Stils der Urszene.

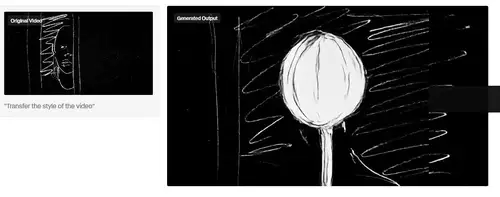

Jeden Stil auf ein Video übertragen

Diese Funktion ist schon seit den frühesten Bild-KIs als "Style Transfer" bekannt und ermöglicht es, einem Video einen völlig neuen ästhetischen Stil (sei es ein bestimmter Filmlook, ein Animations-, Mal- oder Zeichenstil) per Prompt (und vermutlich auch per Beispielbild- oder Video) zu verpassen.

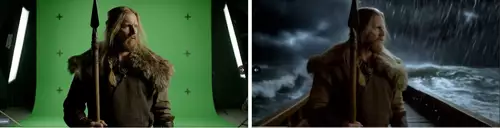

Umgebungen, Orte, Jahreszeiten und Tageszeiten ändern

Mächtig ist die Möglichkeit, das Setting einer Szene grundlegend zu verändern – etwa von Tag zu Nacht, von Sommer zu Winter oder von einer Straßenszene in einer Großstadt zu einer ländlichen Umgebung. Gewöhnliches Filmmaterial kann so auf ein neues Niveau gehoben werden und eine langweilige Umgebung in ein spektakuläres Setting versetzt werden – samt der passenden Lichtstimmung. Dabei kann bestimmt werden, wie viel oder wenig vom ursprünglichen Material beibehalten werden soll.

Elemente zu einer Szene hinzufügen

Ebenfalls spannend ist die Funktionalität, beliebige Objekte nahtlos in eine Szene per Prompt einzufügen. So kann etwa ein leeres Sportstadium im Hintergrund mit Menschenmassen gefüllt werden, ein Feuerwerk im Himmel abgefackelt werden oder neue Requisiten im Vordergrund einer Szene nachträglich hinzugefügt werden.

Runway Aleph can precisely control specific parts of a video, including manipulating ambient, atmospheric and directional light sources with accuracy. All you need to do is tell Aleph what you want. pic.twitter.com/fC5WHBLpco

— Runway (@runwayml) August 4, 2025

Elemente aus einer Szene entfernen

Analog dazu gibt es die Möglichkeit, Objekte lückenlos nachträglich aus einem Video zu entfernen. Eine Stadt kann so etwa menschenleer gemacht werden oder es kann die Reflexion der Kamera aus einem Spiegel oder einer Schaufensterscheibe entfernt werden.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Objekte in einer Szene ändern

Objekte oder Personen in bestehenden Videos können einfach durch andere ersetzt werden mittels Texteingabe oder Referenzbild. Besonders interessant ist das zum Beispiel, um nachträglich etwa das Aussehen von Akteuren gezielt zu verändern und ihnen etwa eine andere Kleidung, Makeup oder Frisur zu verpassen.

Bewegung eines Videos auf ein Bild übertragen

Die Kamerabewegung einer Aufnahme kann auf eine andere Szene, die durch ein einzelnes Bild repräsentiert wird, übertragen werden.

Das Aussehen eines Charakters verändern

Per Aleph können Schauspieler auch nachträglich verjüngt oder gealtert werden – Große Hollywoodproduktionen wie etwa Scorseses "The Irishman" haben diese Funktion schon eingesetzt, um ansonsten unmögliche Aufnahmen herzustellen und einen Charakter

Elemente einer Szene umfärben

Eine Unterart des Objekteditings bietet die Umfärbe-Funktion, die es ermöglicht, anhand eines Beispielbildes mit einer Farbe ein Objekt gezielt umzufärben.

Aufnahmen neu ausleuchten

Extrem mächtig ist die Relighting-Funktion – mit ihrer Hilfe kann eine Szene beliebig neu ausgeleuchtet werden. So kann ebenso die Lichtstimmung wie auch die Tageszeit nachträglich geändert werden und zum Beispiel eine bei Mittagslicht gemachte Aufnahme in ein goldenes Sonnenuntergangslicht umgemünzt werden. So muss das Filmteam nicht mehr früh aufstehen, um die goldene Morgenstimmung einzufangen. Die Beleuchtung wird automatisch über die gesamte Szene hinweg angepasst – einschließlich Schatten, Reflexionen und Farbtemperatur.

Green Screen für jedes Objekt, jede Person oder Situation

Personen oder Objekte können einfach per Prompt maskiert und aus dem umgebenden Bild herausgetrennt werden. Sie können dann wahlweise mit grünem Hintergrund, transparentem Hintergrund oder einer beliebigen Vollfarbe für eine nahtlose Integration in andere Projekte exportiert werden.

KI als mächtiges Werkzeug für Filmemacher

Runways Aleph (sowie ähnliche Tools auch) eröffnet Kreativen mächtige neue Möglichkeiten in der Postproduktion – das gefilmte Material verliert seine Endgültigkeit und mit der Hilfe von KI können auch kleine 1-Person-Produktionen nachträgliche Änderungen an den Bildern vornehmen, die bisher VFX-Profis vorbehalten waren und entsprechend teuer waren. Der qualitative Unterschied zwischen großen Hollywood Produktionen und kleinen Projekten wird sich mit so mächtigen KI Tools verwischen und auch bei kleinem Budget hochwertig aussehende Bilder ermöglichen.

Allerdings werden diese Möglichkeiten zusammen mit generativer KI auch zu einer Flut von visuell glitzernden Filmen und massenhaft "eye candy" führen – echte Qualität wird sich perspektivisch von KI Slop kaum mehr – zumindest auf den ersten Blick – im Aussehen unterscheiden, sondern eher in der Qualität des Storys, der Schauspielerführung und der Gesamtwirkung – also dem, was der Film beim Zuschauer auslöst durch seine emotionale Tiefe, künstlerische Handschrift oder echte Originalität. KI-Tools wie Aleph könnten auch bei (noch) ungenpgneder Qualität profesioenllen Produktionen als Preview-Werkzeug diene, mit dessen Hilfe visuelle Ideen schnell entwickelt werden können.

Das maximal 5-Sekunden lange Demomaterial lässt allerdings noch keine Rückschlüsse darauf zu, wie gut und verlässlich die Ergebnisse im Endeffekt für professionelle Produktionen sein werden, mit anderem Quellmaterial und anderen Prompts, doch das Potenzial für tiefgreifende Veränderungen ist unübersehbar.

UPDATE 29. Juli: Ab sofort können Enterprise und Creative Partner Aleph nutzen. Es gibt auch schon erste Clips von Usern auf X:

Runway Aleph lets you explore AI video like never before.

— Jerrod Lew (@jerrod_lew) July 29, 2025

You can alter so many things whilst preserving the composition of the video input.

Here I tried to push it to the limits. pic.twitter.com/zVjqdTS8d2

Yup, I&m having waaaaaaaay too much fun with @runwayml Aleph. I&m going to spend a whole bunch of time trying to explore all sorts of use cases. There are certain things I&ve experimented with where I was surprised that it actually managed to do it. I replaced a shotgun with a… pic.twitter.com/EtJa1a6MRA

— Travis Davids (@MrDavids1) July 29, 2025

I got early access to Runway’s new Aleph. They’re changing the rules of how we film elements for good. pic.twitter.com/gPxIYj7OlP

— Jeff_synthesized (@JeffSynthesized) July 29, 2025

Just got early access to Aleph, a new in-context video model from @runwayml.

— William Lamkin (@WilliamLamkin) July 29, 2025

Here’s a snippet of my first experiment using a toy car.

Audio added with the MMAudio @Gradio demo on @huggingface spaces https://t.co/SqjDZ8jg5c pic.twitter.com/vSBc9IGZAR

I just got access to @runwayml Aleph & it&s insane! This doesn&t even scratch the surface of what it can do.🤯 pic.twitter.com/GuYhfXsXlT

— Blaine Brown (@blizaine) July 29, 2025

Quick test of Runway&s Aleph and it&s very impressive. The first clip is a real five second clip of me walking through London. The next clip uses that clip as a reference for the first shot, then the rest are are all fully AI generated from that shot using just natural language… pic.twitter.com/ZBp9sAQaDz

— Uncanny Harry AI (@Uncanny_Harry) July 29, 2025

Edited with Runway Aleph using Chat Mode.

— ぽんず🐕 AIクリエイター (@ponzponz15) July 29, 2025

Referenced a single image for each transformation.

→ Forest.

→ Snow mountain.

→ Red car.

→ Boar.

Guess which one is the original? https://t.co/DAs4VxWPnw pic.twitter.com/jJaHv8eZMj