Ja, is‘ denn heut‘ scho‘ Weihnachten? Seit Jahren haben wir gewartet und gezweifelt, ob wir das noch jemals erleben dürfen (was für den Kaiser Franz jetzt ja leider nicht mehr rechtzeitig geklappt hat): Nvidia bringt mit der neuen Geforce GPU RTX 50 Serie jetzt echtes 10 Bit 4:2:2 Decoding in Hardware!

Und das wurde auch dringend Zeit, denn neben RAW ist eine 10 Bit 4:2:2 Log-Aufnahme das effizienteste Format, um mit modernen Kameras Videoaufnahmen für professionelle Nachbearbeitung aufzuzeichnen. Apple unterstützt diese Formate bereits seit Jahren im Hardware-Decoding, doch am PC unter Windows war dies bislang nur mit Intel-CPUs möglich. Wer dagegen in seinem Rechner nur AMD oder Nvidia Komponenten verbaut hatte, musste diese Codecs in Software decodieren – was unnötige Rechenkapazitäten verschlingt und nicht selten in ruckeliger Wiedergabe auf der Timeline resultiert.

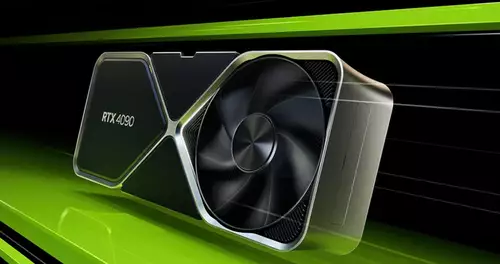

Nvidia spricht übrigens in diesem Zusammenhang vom „4:2:2-Profi-Farbformat“ (Pro-Grade 4:2:2 Color). Bereits eine Hardware-Decoding-Einheit der neuesten, sechsten Generation soll nun bis zu acht 4K-Streams mit 60 fps decodieren können. Zudem sollen die RTX 5090 und die RTX 5080 gleich mit zwei Decodern ausgestattet sein. Die RTX 5070 (und auch das TI-Modell) werden dagegen nur mit einer Decoding-Einheit ausgeliefert.

// Top-News auf einen Blick:

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

- Nikon ZR Lesertester gesucht! Nikon ZR zu gewinnen

Und auch die Encoder-Einheiten wurden weiter aufgebohrt. Die RTX 5090 erhält nun sogar drei an der Zahl, die RTX 5080 sowie die RTX 5070 Ti noch zwei und nur die bislang günstigste RTX 5070 (ohne Ti) wird über einen einzigen Encoder verfügen.

Doch selbst mit nur einem En- und Decoder sollte die aktuell kleinste RTX 5070 mit 649 Euro UVP für günstige Videoschnittsysteme eine höchst interessante Wahl werden. Mit rund 30 FP32 TFLOPS und 672 GB/s Speicherdurchsatz liefert sie bereits ähnliche Leistungswerte wie die aktuell maximale Mac Studio Ultra Ausstattung. Allerdings natürlich noch ohne die Vorteile eines Unified Memory.

Da in allen aktuellen Schnittprogrammen die NVDEC direkt unterstützt wird, nivelliert Nvidia nun einen von den zwei großen Apple-Vorteilen bei der Videobearbeitung. Und wer weiß, vielleicht macht Project DIGITS im Mai dann auch noch Apples Unified Memory als Mini-Resolve-Workstation-Konkurrenz.