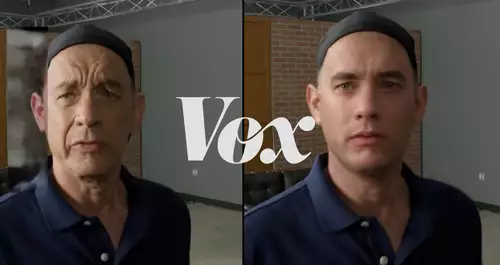

Károly Zsolnai-Fehér von"Two Minute Papers" führt in diesem Video einige interessante Möglichkeiten des semantischen Photoeditings per KI vor, das durch neuere Entwicklungen möglich geworden ist. So konnten bisher schon neuronale Netzwerke durch das Training mit vielen Tausenden von Photos eines Gegenstandes - sei es ein Gesicht, Auto oder eine Katze - lernen, diesen nicht nur zu erkennen, sondern auch frei zu generieren, doch waren bislang die Möglichkeiten, bei dieser Generierung Einfluss auf bestimmte Parameter zu nehmen sehr beschränkt.

So konnte zwar von einem Bild eines Gegenstands zu einem anderen gemorpht werden, aber der Algorithmus konnte z.B. nicht zwischen Vorder- und Hintergrund oder bestimmten Eigenschaften eines Objekts unterscheiden, um darauf gezielt Einfluss zu nehmen.

Das ist jetzt aber mithilfe des GANSpace getauften neuen Verfahrens möglich - so kann etwa ein Gesicht anhand von Parametern wie etwa Alter, Geschlecht, Gesichtsausdruck, Beleuchtung oder Betrachtungswinkel frei manipuliert werden oder es kann eine Brille oder einen Bart ergänzt (oder ein vorhandener entfernt) werden - dynamisch und interaktiv einfach per Schieberegler.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30-40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Ebenso kann der Charakter von Portrait-Gemälden detailliert geändert werden wie etwa die Art des Pinselstriche, den Malstil, die Gesichtsfarbe oder Ausrichtung des Gesichts.

Wir sind gespannt, wann solche per DeepLearning eröffneten Möglichkeiten des objektbasierten semantischen Editings auch für Videos verfügbar sind. Wir hatten uns dazu ja schon in unserem Artikel Schnitt- und Compositing-Trends 2030 - Videoanwendungen im nächsten Jahrzehnt Gedanken gemacht.