Adobe hat soeben Firefly vorgestellt. Hierbei handelt es sich um eine neue Produktfamilie kreativer generativer KI-Modelle, die sich im ersten Schritt auf die Erstellung von Bildern und Texteffekten konzentriert. Firefly ist Teil einer Reihe kommender generativer KI-Dienste von Adobe Sensei, die in allen Clouds von Adobe angeboten werden.

Wie auch mit bereits gängigen KI-Modellen können mittels Firefly Worte in kreative Vorstellungen verwandelt werden. Adobe will hier in Zukunft nicht nur die Erstellung von Bildern ermöglichen, sondern auch die Ausgabe von Audio, Vektoren, Videos und 3D bis zu Pinseln, Farbverläufen und Videotransformationen anbieten. Mit Firefly soll es möglich werden Content-Variationen zu erstellen und immer wieder Änderungen vorzunehmen – und das alles konsistent zum zugrundeliegenden Bild.

Adobe will Firefly auch in naher Zukunft in seine branchenführenden Tools und Dienste integrieren. Die ersten Applikationen, die von der Firefly-Integration profitieren sollen sind Adobe Express, Adobe Experience Manager, Adobe Photoshop und Adobe Illustrator.

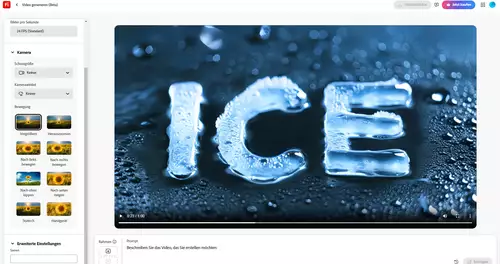

Adobe hat heute eine erste Beta-Version von Firefly veröffentlicht, die jedoch als Webservice und nur mit Einladung nach Zugriffsanfrage funktioniert. Wer einen Zugang besitzt, kann dort anschließend Bilder erzeugen und Texteffekte erstellen.

Trainingsmaterial und generierter Content ohne ungeklärte Urheberrechtsfragen

Adobes erstes eigenes Modell wurde mit Adobe Stock-Bildern, offen lizenzierten Inhalten und Public Domain-Inhalten, deren Copyright abgelaufen ist, trainiert. Es konzentriert sich auf Bilder und Texteffekte. Hiermit generierte Inhalte sollen für die kommerzielle Nutzung sicher sein. Adobe will hiermit garantieren, dass Firefly keine Inhalte generiert, die auf dem geistigen Eigentum anderer Personen oder Marken basieren.

Interessant klingt auch, dass Adobe plant, seine generativen KI-Dienste so zu gestalten, dass die Kund*innen ihre Prompting-Talente zu Geld machen können. Ähnlich wie bei Adobe Stock und Behance sollen neue Verdienstmöglichkeiten für Adobe Stock-Designer*innen eingeführt werden. Sobald die Beta-Phase beendet ist, sollen auch Details zur Entlohnung bekannt gegeben werden.

// Top-News auf einen Blick:

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

- Blackmagic PYXIS 12K - Sensor-Test - Rolling Shutter und Dynamik

Adobe plant zudem, Firefly über APIs auf verschiedenen Plattformen verfügbar zu machen, um Kund*innen die Integration in benutzerdefinierte Workflows und Automatisierungen zu ermöglichen.

Viele weitere KI-Funktionen angekündigt

Auf der frisch gestarteten Webseite von Firefly sieht man zudem, welche Dienste Adobe in nächster Zeit noch plant. Dies sind unter anderem Inpainting, Text to Vector, objektbasierte Bildbearbeitung per Textprompt, Upscaling (Superresolution), Smart Portrait, Randergänzung, 3D-Model to Image, Text to Pattern, Text to Brush, Sketch to Image, Bildgenerierung per Farbreferenzbild, Kombination von Photomotiven sowie Text to Template. Auch das Trainieren mit eigenen Bildern von speziellen Objekten für die Integration in KI-generierte Bilder soll möglich sein. Die verschiedenen Funktionen werden im folgenden Clip schön demonstriert:

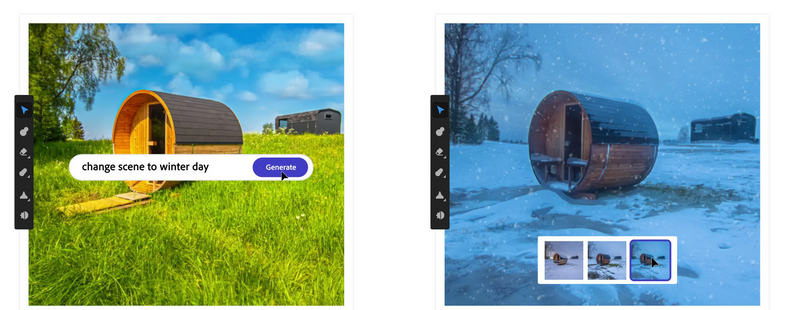

Auch Videoediting per KI

Besonders interessant für die Videoproduktion ist das angekündigte objektbasierte Videoediting, ähnlich dem von Runway Gen 1. Hier soll es möglich sein, per Textprompt zum Beispiel den Stil eines Videos zu ändern - auf der Webseite wird demonstriert, wie in einem Video die Jahreszeit von Sommer zu Winter gewechselt wird. Wie mächtig die Editingmöglichkeiten sein werden (können auch gezielt einzelne Objekte im Video ausgewechselt oder geändert werden?) ist noch nicht klar.

Adobe nutzt für Firefly - ebenso wie zum Beispiel auch Runway - NVIDIAs neuen Picasso Cloud Webservice, welcher per API sowohl KIs fpr die Generierung von Bildern als auch von Video und 3D-Modellen bietet.