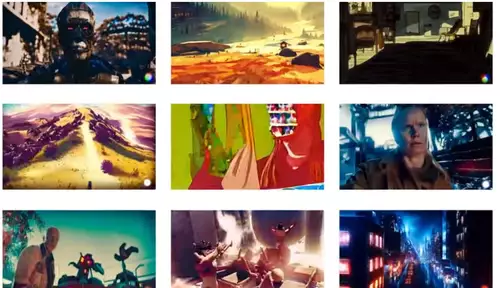

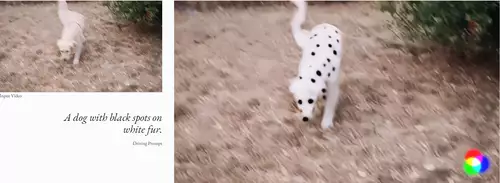

Und zack! Da ist sie also, die erste quasi marktreife Video-KI - es lag ja schon länger in der Luft. Soeben präsentiert Runway Research, das Unternehmen hinter der Bild-KI Stable Diffusion, das KI-System Gen-1 für die Video-Generierung. Wie im September schon geteasert, ist Gen-1 ausgehend von einem Textprompt oder einem Beispielbild in der Lage, den Stil, die Komposition oder der Inhalt eines Videos zu manipulieren (ähnlich wie das neulich gezeigte, jedoch weniger ausgereifte Tune-a-Video). Video-to-Video nennt sich dieser Ansatz, da ein Ausgangsvideo benötigt wird. Das Resultat sieht in den ersten Demovideos beeindruckend kohärent aus.

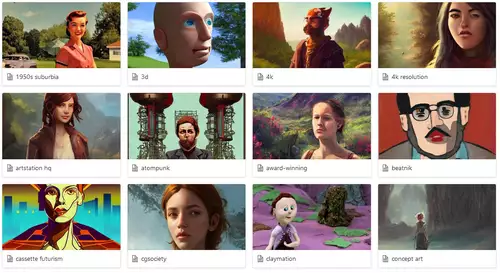

Es stehen zum Start fünf Möglichkeiten zur Bearbeitung zur Auswahl, welche man so ähnlich schon von den Bild-KIs her kennt - das Besondere ist, das dies jetzt auch mit bewegten Bildern funktioniert. In einem Stilisierungsmodus kann der Stil oder Look eines Clips per Textbeschreibung verändert werden, während sich im Storyboard-Modus eine einfache, bewegte Skizze in eine fertige Animation umwandeln läßt. Ein dritter Modus bietet eine Maskenfunktionalität - Objekte können zB. per Text ausgewählt und verändert werden.

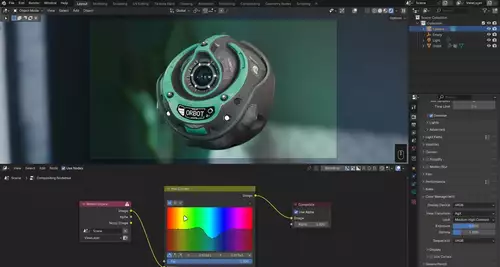

Der vierte Modus nimmt krude 3D-Modelle und ergänzt Texturen, sodass gerenderte Objekte entstehen. Und schließlich soll es in einem weiteren Customization-Modus möglich sein, Gen-1 zusätzlich auf eigene Bedürfnisse anzupassen.

Auch wenn die Videos (noch) nicht fotorealistisch aussehen: Gen-1 verspricht, per textgesteuertem und objektbasiertem Editing vieles (nicht nur) im Bereich Video-VFX einfacher zu machen. Es sei wie Filmen, nur ohne zu Filmen, heißt es bei Runway - No lights. No cameras. All action.

Ganz öffentlich ist Gen-1 allerdings noch nicht, man kann aktuell nur einen frühen Zugang beantragen (zu Forschungszwecken).