Das KI-Modell hinter dem chinesischen, multimodalen Videogenerator Vidu wurde weiterentwickelt - die neue Version 1.5 bringt laut Shengshu Technology eine "Multi-Entitäten-Konsistenz". Dies will heißen, dass das Modell in der Lage ist, Abbildungen von verschiedensten Objekten, Figuren oder Umgebungen sinnvoll miteinander zu einem Video zu verweben. Was wiederum bedeutet, dass man bei der Generierung von KI-Clips mehr Kontrolle über die erstellten Bilder gewinnt, indem man inhaltliche Komponenten genauer vorgeben kann.

Multimodal AI With New Emergence!

— Vidu AI (@Viduforhuman) November 9, 2024

We&re thrilled to launch Vidu-1.5 next week, the world’s first multimodal model to support Multi-Entity Consistency! Vidu-1.5 can seamlessly integrate people, objects, and environments to generate stunning videos, overturning traditional… pic.twitter.com/41GyqezNcd

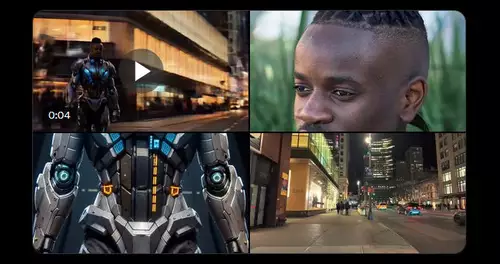

Werden etwa Abbildungen einer Person, eines bestimmten Kleidungsstücks sowie eines Mofas hochgeladen als Referenz, errechnet Vidu 1.5 ein Video, in welchem diese Person wie gewünscht gekleidet ist und Mofa fährt - diese Funktionalität findet sich laut der Entwickler momentan in keinem anderen KI-Videomodell. Darüberhinaus sollen die Referenzobjekte (beziehungsweise -figuren und -umgebungen) im generierten Video in sich konsistent dargestellt werden und nicht, wie so häufig in KI-Videos, nach und nach ineinander morphen oder sich auflösen.

VIDU Multi-Entity Consistency

— Hungry Donk-E (@hungrydonke) November 13, 2024

Give Vidu 2/3 images and it’ll turn them into a video—it’s pure magic!

Your own characters interacting with objects and in the exact environment you want!

Ads, movies… endless possibilities, and this is just the beginning!

Thanks… pic.twitter.com/xq7gmlStxt

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Erweiterte Kontrolle soll sich auch über die gewünschte (virtuelle) Kamerabewegung ausüben lassen, sodass sich horizontale und vertikale Schwenks sowie Zoomfahrten, auch in Kombination miteinander, für anspruchsvolle Einstellungen generieren lassen. Für Zeichentrick-Fans sind neue Animations-Styles sind hinzugekommen wie japanischer Fantasy oder Hyperrealismus.

Bilddetails sollen in den von Vidu 1.5 erstellten Clips nun genauer generiert werden, die maximale Auflösung beträgt wie bisher 1080p. Gleichzeitig soll es auch schneller gehen - um 4 Sekunden Bewegtbild zu generieren, sollen 25 Sekunden Rechenzeit ausreichend sein. Dank Fortschritten beim semantischen Verständnis soll das neue KI-Modell Textprompts präziser als zuvor interpretieren, sodass sich auch komplexe Szenen umsetzen lassen sollen.

Trend: Mehr Kontrollmöglichkeiten für Video-KIs

Mehr Kontrollmöglichkeiten über das Bild und eine bessere visuelle Konsistenz werden aktuell auch bei konkurrierenden Video-KIs angestrebt. So soll ein großes neues Feature im kommenden Kling 1.5 die Möglichkeit sein, eigene Charaktere trainieren zu können, um sie dann quasi als virtuelle Schauspieler zu nutzen. Runway wiederum erlaubt es mit dem neuen Gen-3 Alpha Turbo-Modell, über eine neue Kamerasteuerung ins Bild rein- oder rauszuzoomen, nach links oder rechts, nach oben oder unten zu schwenken oder das Bild zu rotieren.