Das chinesische Technologieunternehmen ShengShu-AI und die Tsinghua-Universität haben am Wochenende ein KI-Video-Modell vorgestellt, welches nach nach eigenen Angaben mit Open AIs Sora auf Augenhöhe agieren kann.

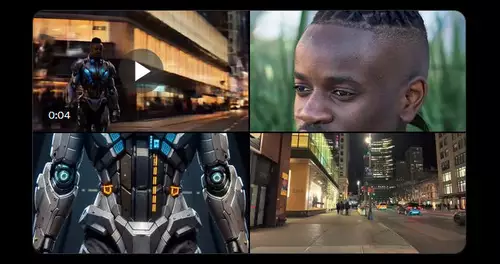

Das Vidu getaufte Modell wurde auf dem gerade beendeten Zhongguancun-Forum in Peking vorgestellt und kann mit einem Klick aus einem Text Prompt einen 16-sekündigen 1080P-Videoclip erstellen.

Es basiert laut den Entwicklern auf einer visuellen Transformationsmodellarchitektur namens Universal Vision Transformer (U-ViT), die zwei Text-zu-Video-KI-Modelle (Diffusion und Transformer) kombiniert.

Diese U-ViT Kombination ist dem Sora-Modell grundsätzlich ähnlich und wurde im September 2022 vom Vidu-Forschungsteam begonnen- also noch weit bevor OpenAI mit Sora offiziell seine ersten Ergebnisse von der Kombination aus Diffusion und Transformern der Öffentlichkeit präsentierte.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Die Ergebnisse wirken auf den ersten Blick zwar ziemlich gut, jedoch hat bislang OpenAI bei der Veröffentlichung seiner besonders gelungenen Clip-Perlenen noch definitiv die Nase vorne.

Dennoch darf auch nicht vergessen werden, dass Vidu nun gerade einmal zwei Monate nach Sora das Licht der Welt erblickt, und damit zeigt, dass OpenAI mit Sora kein technologisches Alleinstellungsmerkmal besitzt. Während der erste Vidu Live Demo zeigte ShengShu-AI, wie Vidu die reale physische Welt simulieren und Szenen mit komplexen Details im Einklang mit realen physikalischen Gesetzen erzeugen konnte. Was belegt, dass auch hier eine gewisse Weltkenntnis bei der Generierung von Szenen vorhanden sein muss.