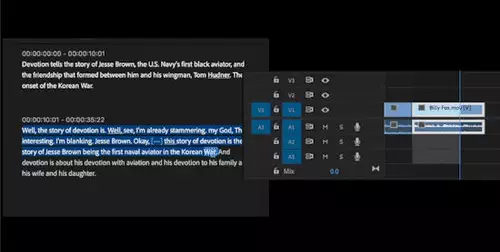

Die automatische Transkription von menschlicher Sprache in Text funktioniert im allgemeinen ganz gut, ein Problem haben aber bis jetzt komplexere Gesprächssituationen wie etwa Diskussionen dargestellt, in denen mehrere Sprecher manchmal gleichzeitig reden - bisher für die Spracherkennungsalgorithmen ein unüberwindbares Hindernis.

Microsoft hat das Problem jetzt mit einem ganz besonderen Ansatz gelöst. Die Besonderheit des Projekt Denmark getauften, auf einem neuronalen Netz basierenden Algorithmus ist seine Fähigkeit, auch mehrere gleichzeitig redende Stimmen in Echtzeit zu identifizieren, um die von ihnen gesprochenen Worte in Text umzuwandeln.

Zur optimalen Erkennung der verschiedenen Stimmen und des Gesagten verwendet Microsoft mehrere im Raum verteile Mikrophone - praktischerweise können anstatt dezidierter Mikrophonen auch mehrere in Smartphones oder etwa Notebooks integrierte Mikrophon - via Cloud zusammengeschaltet - genutzt werden. Diese bilden eine Art virtuelle Mikrophonmatrix, um so die Stimmen aus mehreren Positionen im Raum aufzunehmen und die zusätzlichen Informationen (wie die unterschiedliche Lautstärke und Laufzeit der Signale) zur Analyse nutzen zu können.

// Top-News auf einen Blick:

- Blackmagic Resolve Studio für 236,81 bei Teltec - und weitere Angebote

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Ausgewählte Angebote - DJI Mavic 4 Pro, Canon R5 C, Sachtler aktiv12T...

- Die besten Black Friday Deals für Sony und Canon DSLMs und Objektive

- Blackmagic bietet bis zu 30% Rabatt auf seine 6K Kameras

- Große Übersicht - Black Friday Deals 2025 für Foto+Video - Kameras, Objektive, Zubehör usw.

Der neue Transkriptionsalgorithmus ist über Microsofts Azure Speech Service für größere Unternehmen verfügbar und hoffentlich auch bald in Form einer App/Plugins oder Dienstes für Endanwender.