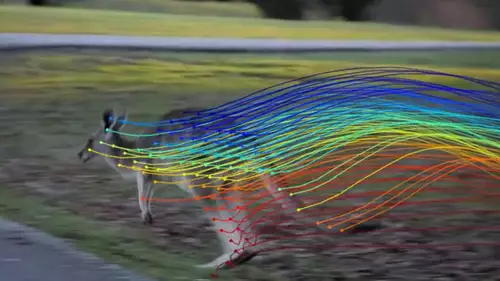

Und mal wieder ein KI-Paper, das man eigentlich schon vorhersehen konnte - und trotzdem staunt, dass solche Dinge nun einfach möglich sind. Diesmal geht es es darum, tanzende Menschen aus Youtube Videos in jeder Phase ihrer Bewegung von allen Seiten "schätzen" zu können. Klingt erst mal sperrig, darum am Beispiel erklärt. Nachdem sich HumanNeRF ein Video aus dem Netz angesehen hat, kann es...

a) den tanzenden Menschen im Video aus einem nahezu beliebigen Hintergrund freistellen und

b) die Kamera beliebig um das erzeugte menschliche 3D-Objekt fahren lassen.

Die KI lernt also aus einem relativ willkürlichen Tanz, wie das Objekt von allen Seiten aussieht und kann somit auch zu jedem Frame seine Vorstellung dazu rendern, wie das Objekt aus einem anderen Blickwinkel aussehen würde. Dies geht soweit, dass sogar der korrekte Faltenwurf der Kleider simuliert wird.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Die Qualität der erzeugten Perspektivenänderung ist sehr unterschiedlich und natürlich extrem von dem Trainingsmaterial abhängig. Allerdings liegt sie deutlich über älteren KI-Verfahren und meistens mindestens auf dem Niveau einer guten Videospiel 3D-Simulation. Und somit schon heute sicherlich brauchbar um Menschen in einer Virtuellen Umgebung im Hintergrund mitzubewegen oder im Bokeh unscharf verschwimmen zu lassen.

Im Gegensatz zu speziellen 3D-Scans gewinnt HumanNeRF seine Daten nur durch das Betrachten einer Bewegung. Es muss also nicht spezifisch getanzt werden. Der Körper sollte nur einmal von allen Seiten gesehen worden sein. Fantastische Zeiten....