Gerade hatten wir erst unseren aktuellen Artikel über generative KI Videos freigeschaltet, da kommt Google schon mit dem nächsten interessanten Projekt um die Ecke.

Neural Dynamic Image-Based Rendering (kurz und kryptisch: DynIBaR) nennt sich eine Technik, die es ermöglicht, aus einer einzigen Kameraperspektive eine Kamerafahrt um ein Objekt wie bei einem eingeschränkten Bullet Time Effekt zu generieren. Da das KI-Modell hierbei viele Voraussagen über die Bildkomposition errechnet, fallen als Nebeneffekte auch noch Slow Motion, Bildstabilisierung sowie synthetische Tiefenschärfe/Bokeh ab.

Im folgenden Video lässt sich die mögliche Qualität von DynIBaR näher betrachten:

Interessant ist dabei, dass dieses KI-Modell letztlich bereits viele KI-Postproduktionsschritte auf einmal beherrscht, die wir in unserem Grundlagenartikel "Wie filmt man am besten für eine computational Postproduction?" beschrieben haben.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Wir glauben tatsächlich, dass bereits in wenigen Jahren ein Filmkomposition über solche "Modifier" funktionieren kann und wird. D.h. man generiert für einen Film mittels generativer KI die notwendigen Standbilder für eine Art Storyboard und animiert diese dann über virtuelle Kamerafahrten und steuert dazu die Objektbewegungen wie Marionetten.

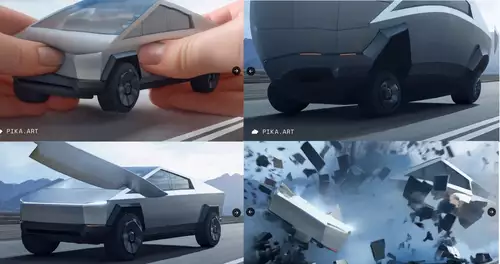

Klingt noch wie die entfernte Zukunft? Offensichtlich hat sie jedenfalls schon begonnen...