Das Forscherteam der Stanford Universität, des Max-Planck-Insituts für Informatik und der Universität Erlangen-Nürnberg, das vor einigen Monaten schon ein Verfahren vorgestellt hatte zur quasi Fernsteuerung von Gesichtern in Echtzeit, hat dieses noch einmal weiterentwickelt, sodass es jetzt mittels beliebiger Videoaufnahmen ohne Zuhilfenahme von 3D-Tiefeninformationen (RGB-D) von Gesichtern anwendbar sein soll.

So kann nun ein per Webcam aufgenommenes Gesicht ein anderes, in einem (z.B. YouTube)-Video vorkommendes Gesicht in Echtzeit steuern, d.h. es die eigenen Mimiken, Kopf- und Lippenbewegungen ausführen lassen. Ermöglicht wird das durch eine ganze Reihe von einzelnen Prozessschritten, wie dem exakten Ausmessen und Modellieren beider Gesichter (inklusive kleiner Fältchen bei einem besonderen Gesichtsausdruck und des Mundinnenraums samt Zähnen) und dem Übertragen der erfassten Mimik von einem auf das andere Gesicht und einem nahtlosen Einfügen in das Zielvideo samt korrekter Beleuchtung. Besondere Aufmerksamkeit wurde auch auf eine realistische Anpassung des Mundinnenraums verwendet, der bisher oft eine Problemzone dargestellt und zu Fehlern bei der realistischen Darstellung geführt hat.

Mit einem so einfach anzuwendenden Verfahren sind (sobald es in Software gegossen allgemein verfügbar und von jedermann anwendbar ist) natürlich ebenso sinnvollen wie zweifelhaften Anwendungen jetzt Tür und Tor geöffnet. Gesichter in beliebigen Videos können damit simpel manipuliert werden, ohne das dies auf den ersten (und vielleicht auch zweiten) Blick erkennbar unrealistisch und somit als Fälschung erkennbar ist. Ähnlich könnte auch der Algorithmus verwendet werden, der es erlaubt ein nur aus Photos rekonstruiertes Gesicht nachträglich per Video zu animieren.

Angesichts der jetzt schon massenhaft auftauchender Videoclips, die die unterschiedlichsten Verschwörungen oder Missgriffe bekannter Persönlichkeiten beweisen (sollen), steht uns dann wohl bald eine Inflation solcher manipulierten Videos bevor, was zu einer allgemeinen Vorab Fake-Vermutung gegenüber jedem Video führen könnte. Und in einem nächsten Schritt dann zum Ruf nach neuen Verfahren, um die Echtheit und Manipulationsfreiheit von Videos sicherzustellen.

Für perfekte Manipulationen in Bild und Ton allerdings fehlt allerdings noch ein ähnliches Verfahren für eine Umwandlung von Gesagtem in den passenden Tonfall und Stimmlage einer Zielperson. Vorerst müssten dazu noch Soundsamples der zu manipulierenden Person verwendet werden.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Andererseits sind natürlich auch nützliche Anwendungen denkbar - abgesehen von (posthumen) Scherzen mit berühmten Gesichtern, werden gerade für Filmemacher so nachträgliche substanzielle inhaltliche Änderungen an einem Video wie z.B. der Performance eines Schauspielers oder dem Gesagten leicht und kostensparend ohne Nachdreh leicht möglich. Auch die nachträgliche Anpassung der Lippenbewegungen eines Schauspielers im Orginalfilm an die eines Synchronsprechers wäre dann leicht möglich und könnte störende Differenzen zwischen Ton und Bild vermeiden helfen.

Andere Anwendungsbereiche sind natürlich VR/AR und Spiele, in denen eine solche Synthese von real und virtuell/animiert die Grenzen zunehmend verschwinden lassen wird. Als ähnlich hilfreich könnte sich auch das Verfahren erweisen, aus mehreren Takes einer Szene einen idealen Take zu synthetisieren.

Wirklich unheimlich wird das ganze Verfahren wohl jedem spätestens dann, wenn er/sie das eigene Gesicht mal fremd-ferngesteuert eigenartige Sachen machen sieht. (Danke an Bergspetzl für die Meldung)

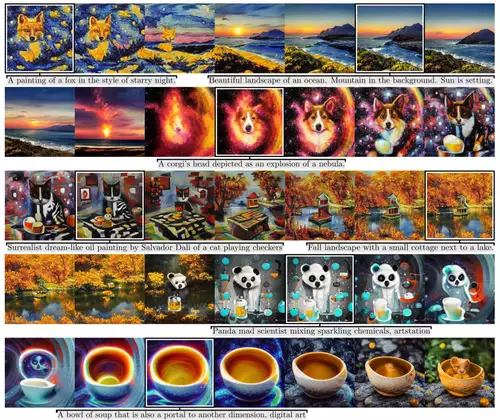

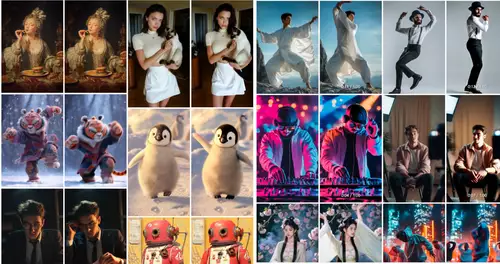

mehr Bilder zur News: