Beim Wechsel der analogen Videoformate in das digitale Zeitalter gab es bei der Konvertierung mehrere zentrale Themen. Neben der Framerate, Auflösung und dem Deinterlacing konnte man besonders oft über falsche Videopegel stolpern, was unter anderem bei uns zu Holger Scheels viel zitiertem slashCAM-Klassiker " Der Canopus Unterschied" führte.

Wer jetzt seinen Augen nicht traut: DOCH wirklich! Dieser Artikel ist mittlerweile fast 20 Jahre alt! Und er ist tatsächlich derart in Vergessenheit geraten, dass viele jüngere Anwender heute Begriffe wie Full-/Studio-Swing und/oder Video-/Data Levels wirklich noch nie gehört haben. Und der Idealzustand wäre natürlich auch, dass man sich damit nicht mehr abgeben muss, denn die analogen Zeiten liegen ja weit genug zurück.

Doch in der Praxis kann man auch heute noch immer über derartige, analoge Relikte stolpern, weshalb wir diese "Pegel-Geschichte" noch etwas in Erinnerung halten wollen.

Habe ich ein Problem mit dem Videopegel?

Dass man ein Pegel Problem hat bemerkt man in der Regel, wenn man die eigene Ausspielung auf einem fremden Wiedergabegerät sieht und dort die Kontraste merklich anders aussehen als am eigenen Schnittsystem. Das kann ebenso in einem Kino wie auch einfach nur bei Youtube der Fall sein. Entweder wirkt das Bild irgendwie verwaschen und kontrastlos oder extrem kontrastreich ohne Details in den Schatten und/oder mit überstrahlenden hellen Flächen. Auf jeden Fall so auffällig anders, dass es sich nicht nur durch eine leichte Gamma-Abweichung erklären lässt...

Was ist denn der Pegel?

Der Pegel (engl. Level) beschreibt die Stärke eines Videosignals an einer Stelle im Bild, wobei die dunkelste mögliche Stelle 0 Prozent und die hellste mögliche Stelle 100 Prozent entsprechen soll. Klingt erstmal einfach, doch der Teufel steckt im Wort "soll". Denn es gibt zum Beispiel Kameras die auch 109% Prozent Videopegel aufzeichnen können, also weißer als weiß (sog. Super-White). Und auch der Blacklevel, also der Punkt, der absolutes Schwarz beschreiben soll ist grundsätzlich "fließend" und muss vom Hersteller irgendwo im Rauschen des Sensors gewählt werden.

Digitale Grenzen

Bei einer digitalen Aufzeichnung gibt es jedoch grundsätzlich sehr klar definierte Grenzen für das Signal. Bei einer 8 Bit Aufzeichnung entspricht das kleinstmögliche Signal dem Wert 0 und das größtmögliche (hellste) Signal dem Wert 255. Darum wäre es einfach nur schlüssig bei der Speicherung 0 für den dunkelsten Punkt (Black-Level) und 255 für den hellstmöglichen Punkt (White-Level) zu definieren.

Da digitales Video jedoch einen entsprechenden analogen Vorgänger hatte hat man -einfach gesprochen- noch ein paar Reserven im Signal vorhalten wollen und bei vielen 8 Bit Formaten den Wert 16 als 0% Black-Level und den Wert 235 als 100% White-Level definiert. Damit konnten einige Kameras bei der digitalen Speicherung wie bereits erwähnt sogar leicht übersteuert aufzeichnen (109% entspricht dem digitalen 8 Bit Wert 255).

Da mit der Zeit aber auch Fernseher digital wurden mussten sich diese ebenfalls an die analogen Wandlungs-Normen halten. Erkennt ein Fernseher ein digitales Videosignal, so stellt dieser sein "schwärzestes Schwarz" bei einem 8 Bit Wert von 16 dar. Werte unter 16 werden also nicht mehr dunkler dargestellt.

Ganz anders jedoch ein Display am PC (oder wenn der Fernseher glaubt, ein PC-Signal zu erkennen). Hier ist die digitale Null der dunkelste Punkt und digital 16 ist schon sichtbar heller. Für das weitere Verständnis (und der Einfachheit weiter in 8 Bit) sieht die Situation also folgendermaßen aus:

Am Computermonitor entspricht Schwarz der 0 und am Fernseher 16.

Weiß ist am Computermonitor 255 und am Fernseher 235.

Für diese zwei digitalen "Kontrast-Räume" haben sich im Laufe der Zeit viele unterschiedliche Begriffe etabliert:

0-255 (8 Bit) oder 0-1023 (10 Bit) steht für Full/Data Level, Full Swing, extended Range oder -7-109 IRE

16-235 (8 Bit) oder 64-940 (10 Bit) steht für Video Level, Studio Swing, legal Range, 0-100 IRE

Der Mix macht´s (problematisch)

Solange sich die Systeme nicht vermischen, lässt sich mit zwei verschiedenen Pegeln problemlos arbeiten, aber leider gottes haben sich die Systeme über die Zeit "vermischt": Denn was soll beispielsweise der korrekte Schwarzwert sein, wenn am PC ein Software-DVD-Player in einem Fenster einen FIlm abspielt?

In der Praxis handeln dies der Monitor und der Software-Player mit dem Betriebssystem aus. Doch dafür müssen alle Komponenten auch klar kommunizieren und korrekte Metadaten mitbringen. Dies ist bei einem DVD-Player heute meistens kein Problem mehr, weil hier die Authoring-Programme in der Regel gut auf den korrekten Pegel beim Mastern aufpassen.

Wilder geht es dagegen bei YouTube zu. So ist prinzipiell nirgendwo in irgendeiner Spezifikation zu lesen, ob Youtube lieber Data- oder Video-Level angeliefert bekommt. Tatsächlich konvertiert Youtube beim Upload einfach die Levels bei Bedarf - sofern die Metadaten richtig interpretiert werden können.

Metadaten machen den Unterschied

Die korrekten Metadaten bleiben jedoch Anwendersache, d.h man sollte beim Export darauf achten die richtigen Levels einzustellen. Und während ein Authoring-Programm hier explizit darauf achtet, alles richtig zu machen, tut dies ein Schnittprogramm eher nicht.

Resolve erlaubt gleichwertig den Export von Data- oder Video-Pegeln in praktisch jedem Codec. Damit der Export mit korrekten Metadaten gelingt muss wiederum die Timeline schon "wissen" was die korrekten Levels im Projekt sind. Und das hängt wiederum von den individuellen Projekteinstellungen ab. Resolve arbeitet im Default mit Full/Data-Pegeln, während Avid im Default die Timeline auf Studio Swing steht.

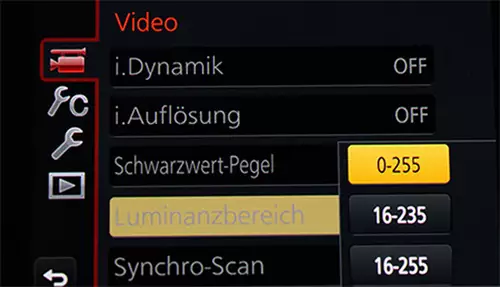

Erweitert kommt hinzu, dass man auch beim Import darauf achten muss, mit welchen Pegeln die importierten Clips aufgezeichnet wurden. Panasonic erlaubt beispielsweise sogar in seinen Lumix Kameras die Einstellung des digitalen Encoding-Pegels. Wer RAW filmt hat die Level beim Debayering sowieso buchstäblich fließend in der Hand.

Und wer RAW- oder Log-Material extrem farbkorrigiert lächelt sowieso nur über die vorgeschlagenen Schwarz- und Weißpunkte. Denn hierbei muss man in der Regel eine weitaus größere Dynamik des Sensors in sendefähige 8 Bit "quetschen" und dabei letztlich immer die Schwarz- und Weiß-Level der Kamera von Hand transformieren.

Und was bedeutet das für mich konkret?

Wer sich nun nicht in den gesamten technischen Background der Videopegel einlesen will sollte zumindest eine Ahnung davon haben, dass es diese zwei wichtigen Level gibt. Und dass man hier nach einer Lösung suchen kann, falls man einmal auf ein entsprechendes Problem stößt. Dass die Lösung trotzdem nicht unbedingt trivial ausfallen muss, lässt folgender, seit 18 Monaten unbeantworteter Forumsthread erahnen.

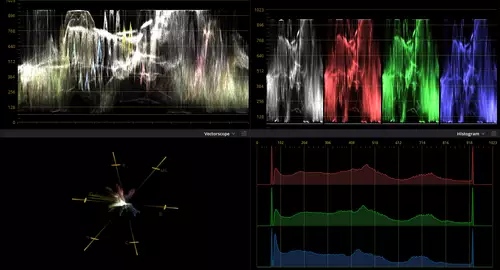

Tatsächlich finden in einem Programm wie Resolve an zahlreichen Stellen Farbraumkonvertierungen statt. Und an fast jeder entsprechenden Stelle kann auch der zugehörige Pegel eingestellt werden. Beispielsweise kann der Pegel des Vorschau-Monitors ein anderer sein, als der in der Timeline, der sich wiederum vom Import- oder Export-Pegel unterscheiden kann.

Wenn man sich nicht explizit auskennt hilft es in der Praxis die entsprechenden Schalter dort zu verändern, wo man das Problem vermutet und gegebenenfalls durch Trial and Error den eigenen Workflow festzuklopfen.

Am wichtigsten ist jedoch, sich von der Vorstellung zu lösen, dass man einen bestimmten Pegel abliefern muss. Die meisten Programme können heutzutage mit beiden Pegeln problemlos zurecht - solange sie die genutzen Pegel richtig erkennen und in der Folge transformieren können. Wichtig ist es daher vor allem, dass die Metadaten im Clip korrekt gesetzt sind - dann passt der Rest in der Regel auch. In falsch geschriebenen oder falsch interpretierten Metadaten liegt dagegen meistens der Hund begraben, wenn der Kontrast bei der "Wiedergabe in fremder Umgebung" nicht stimmt.