Das Lehrbuchwissen zur Sensordynamik definiert den Sachverhalt eigentlich sehr stringent: Die Dynamik des Sensorsignals wird in den Schatten durch die Grenze zum Rauschen definiert, was den Herstellern bereits viel Spielraum für vage Dynamikangaben lässt. Auf der anderen Seite des Signals, also in den Lichtern, ist die Dynamik dagegen durch das Clipping/FullWell der Sensel (Sensorpixel) beschränkt. Eigentlich logisch: Wenn der Sensor nicht mehr Photonen zählen kann, weil er buchstäblich überläuft, ist das Limit erreicht. Diese Grenze ist -im Gegensatz zum Rauschen- sehr klar definierbar. Schließlich lässt sich für einen Sensor fast auf das Photon genau sagen, wie viel Licht ein einzelnes Sensel (Sensorpixel) maximal fassen kann.

Somit gibt es eigentlich eine native Dynamik-Grenze, die durch die Fläche eines Sensels physikalisch fest steht. Doch so mancher Kamerahersteller scheint diese Grenze der Physik zu umgehen.

Bisher sind wir immer davon ausgegangen, dass solche erhöhten Dynamik-Angaben ausschließlich durch eine stärkere Noise Reduction zu erzielen sind. Doch auch in den Lichtern, also im Bereich des Sensor-Clippings, gibt es bei näherer Betrachtung noch ein paar Blendenstufen “zu ergaunern”. Und zwar durch ein trickreiches Debayering…

Worum gehts?

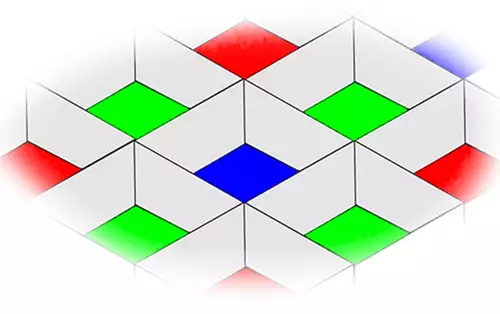

Um das weitere Vorgehen zu verstehen, sollte man grundsätzlich wissen, was beim Debayering eigentlich passiert. Vor den lichtempfindlichen Senseln des Sensors sind Farbfilter angebracht, die nur einen gefilterten Spektralbereich des Lichtes durchlassen. So kann jedes Sensel nur entweder den roten, den grünen oder den blauen Teil des eintreffenden Lichts messen.

Für ein fertiges Bild muss die RGB-Farbinformation eines Pixels daher immer aus Informationen von benachbarten Senseln gewonnen werden. Beispiel: Um den Blau- und den Grünanteil eines roten Sensels zu schätzen, interpoliert man diese Werte aus den blauen und grünen Nachbar-Senseln des roten Sensels.

Will man wissen, aus welchen Teilen sich die Helligkeit eines RGB-Pixels zusammensetzt, dann hilft ein Blick auf klassische YUV-RGB-Formeln. Dort sieht man, dass sich die Helligkeit Y aus folgenden RGB-Farbanteilen addiert:

Y = 0.299R + 0.587G + 0.114B

Die grüne Komponente trägt also fast 60 Prozent zur Berechnung Bildhelligkeit bei, während Rot ungefähr 30 Prozent und Blau nur 11 Prozent beiträgt.

Die entscheidende Frage stellt sich nun beim Clipping eines Sensels. Denn die Formel deutet bereits an, dass bei einer hellen, weißen Lichtquelle die grünen Sensel als erstes clippen, weil sie die meisten Photonen durchlassen. Grüne Sensel sind daher meistens früher gesättigt und clippen, weil ihr FullWell-Wert erreicht ist. Werte der roten und blauen Sensel liegen bei dieser Helligkeit jedoch noch deutlich unter ihrem FullWell. Als Daumenregel (und je nach Lichttemperatur) kann man ungefähr davon ausgehen, dass bei der Aufzeichnung einer weißen Lichtquelle die roten Sensel ungefähr eine Blendenstufe über den grünen clippen während die blauen Sensel sogar noch ca. zwei Blenden unter ihrem FullWell liegen.

Debayering-Strategien

Das Debayering kann nun auf mehrere Arten auf die geclippten Sensel reagieren. Die klassische Lehrbuch-Methode besteht darin, alle RGB-Werte auf 100 Prozent (z.b. 255 in 8 Bit) zu setzen, sobald ein beteiligtes Sensel clippt. So gibt es beim Clipping im Bild immer nur vollweiße Bereiche, die oft ohne sanften Übergang im Bild eine Überbelichtung deutlich signalisieren.

Bei “intelligenten” Methoden nutzt man dagegen den Rot- oder Blauwert für die Helligkeits-Bestimmung und schätzt für Grün aufgrund der ermittelten Helligkeit einen höheren Wert über seinem FullWell. Die Schätzung kann dabei auf unterschiedlichen Ideen basieren, die allesamt unter den Begriff Highlight Recovery Algorithmen fallen.

In der Praxis

Wem bei dieser Erklärung der Kopf raucht, dem sei einfach einmal der Einsatz in der Praxis demonstriert, denn hier wird so manches klarer. Wir haben hierfür unseren Testkasten mit einer URSA MIni 4,6K aufgezeichnet und dabei die Belichtungszeit so variiert, dass unser heller Puschel links oben im Bild bei manchen Aufnahmen schon klar in der Überbelichtung liegt. Dazu haben wir sowohl in ProRes als auch in RAW aufgezeichnet, um den Effekt schön demonstrieren zu können.

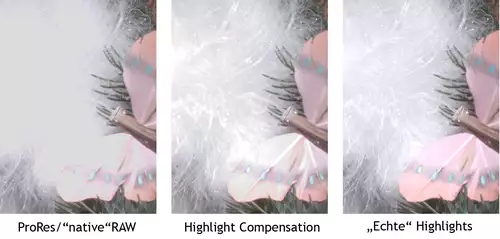

Die interne ProRES-Aufnahme der URSA Mini clippt an der Stelle, an der die grünen Sensel clippen. Hier saß auch das 100% Zebra der URSA Mini. Und ab hier wird der gesamte Bereich des Bildes als überstrahlendes Weiß aufgezeichnet:

Auch die normal debayerte RAW-Aufzeichnung liefert in Resolve dieses Bild.

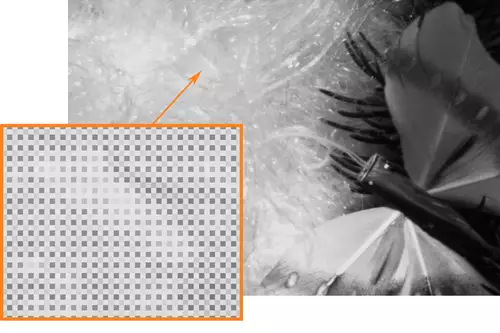

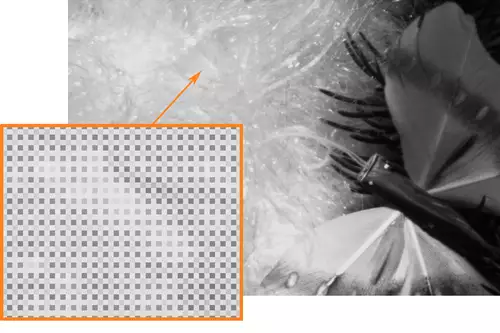

Betrachtet man ohne Debayering jedoch das Bayer-Pattern des überstrahlten Bereichs so sieht man deutlich, dass die Blauen und teilweise auch die roten Sensel noch bei weitem nicht clippen:

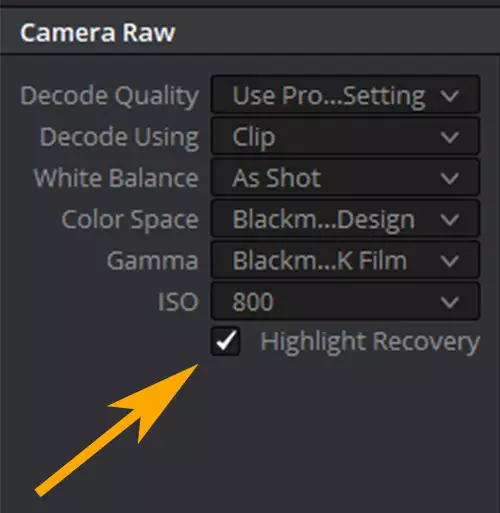

Und tatsächlich kann man in diesem Bereich auch noch Details “sichtbar” machen, indem man in Resolve bei der Entwicklung der RAW Datei die Option “Highlight Recovery” auswählt.

So bekommt man noch mindestens eine Blendenstufe in den Lichtern geschenkt, die nur in der RAW-Aufzeichnung, aber nicht in der ProRES-Aufnahme vorliegt. Ganz einfach, weil das interne ProRES-Debayering in der Kamera keine Highlight Recovery vornimmt.

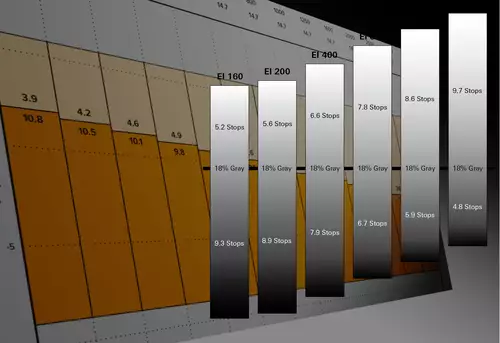

Bei einer standardisierten Dynamik-Messung (z.B, mit dem gängigen Xyla-Chart) sind diese zusätzlichen Blendenstufen klar zu messen und zu sehen.

Dies dürfte auch ein Teil der Erklärung sein, womit Blackmagic und Red ihre 15-16 Blendenstufen rechtfertigen. Eine solche Angabe dürfte demnach aber auch nur für RAW-Aufnahmen gelten. Oder die ProRES Aufzeichnung müsste mit Highlight Recovery erfolgen, was zumindest bei unserer URSA Mini 4,6K nicht der Fall ist. Auf jeden Fall ist die Highlight Recovery somit ein weiterer Pluspunkt für RAW gegenüber ProRES in den höchsten Qualitätsstufen.

Nur Vorteile durch Highlight Recovery?

Auf den ersten Blick klingt die Highlight Recovery somit wie ein Allheilmittel, das man immer auf jeden Fall nutzen sollte, doch ganz problemlos ist deren Einsatz nicht. Man kann zwar nicht in die Algorithmen der Hersteller hineinsehen, jedoch stehen alle vor dem selben Problem. Wenn der Grünkanal und oder Rotkanal clippt, kann man zwar über den Blaukanal seine Helligkeit schätzen, jedoch nicht mehr seine Farbdifferenz zu den benachbarten Senseln.

Die zusätzliche Dynamik kann also im besten Fall vielleicht noch zwei bis drei Blendenstufen dazu zaubern, jedoch werden diese in der Regel dann lieber farblos, als falsch mit einem Farbstich geschätzt. Spätestens wenn Grün UND Rot clippen, dürften faktisch alle Algorithmen aus Sicherheitsgründen daher nur noch graue Abstufungen erzeugen. Und auch feine Details gehen natürlich in solchen Bereichen in der Interpolation dann teilweise unter. Dies lässt sich übrigens auch leicht nachweisen. Wir haben unsere Testaufnahme auch noch einmal mit einer Blendenstufe weniger aufgezeichnet und dann in der Post eine Blendenstufe hochgezogen:

Vergleicht man dieses Bild mit der Highlight Recovery, so sieht man hier die echten Farben des Schmetterling-Flügels sowie noch mehr feine Details.

Für alle, die nicht hin- und herblättern wollen, hier noch einmal die drei relevanten Ausschnitte, nebeneinander…

Spätestens wenn man ETTR belichtet, können farblose Lichter zum handfesten Problem werden. Denn wenn man solche farblosen Bereiche ein paar Blendenstufen herunterzieht, gibt es in diesen wiederhergestellten Bereichen auch keine ansehnlichen Farben mehr. Sitzt die ETTR-Belichtung dagegen knapp unter der Helligkeit, an der das erste Sensel clippt, so kann man diese Bereiche bei RAW-Aufnahmen auch oft 4-5 Blenden herunterziehen, ohne dass man die korrekte Farbgebung verliert. So gesehen macht das 100 Prozent Zebra für RAW in der URSA Mini auch wieder Sinn.

Und wir beenden dieses Thema für heute mit der Hoffnung, dass nun mehr Leser verstehen, warum man sich vor der Angabe einer Zahl für die “nutzbaren Blendenstufen” einer Kamera hüten sollte.