Und schon wieder ein großer Fortschritt in der generativen KI-Forschung, den Nvidia zur Siggraph 2023 offiziell präsentieren will und wird: "Perfusion" nennt sich eine neue Text zu Bild (Text-to-Imange, T2I)-Individualisierungs-Methode, die es besonders einfach erlauben soll, eigene Personen und Objekte in einen KI-Bildgenerator "einzutrainieren".

Bislang war es nur mit Spezialwissen möglich, KI-Modelle wie Stable Diffusion um eigene Inhalte zu erweitern. Über sogenanntes Lora-Finetuning lässt sich beispielsweise die eigene Person in künstlich geschaffenen Bildern über einen Text-Prompt ins Modell einbringen. Das neuronale Netz muss dafür anhand von Beispielfotos und den richtigen Prompt die zusätzliche Person lernen, was bislang jedoch nicht mit einem einfachen Mausklick zu bewerkstelligen war. Außerdem muss man die Finetuning-Änderungen an den Gewichten irgendwie als eine Art Patch ins Modell bringen, was bei Cloud-Anwendungen manchmal mit sehr großen Datentransfers für die neuen, veränderten Gewichte einhergeht.

All das soll nun laut Nvidias Perfusion-Paper in Zukunft in mehrfacher Hinsicht leichter werden. So sollen eigene Objekte auf einer einzigen A100 GPU (mit ca. 27GB Speicherverbrauch) in nur 4 Minuten hinzutrainiert werden können. Zugleich soll die Modifikations-Datei mit den veränderten Gewichten gerade einmal 100 Kilobyte (!!, richtig gelesen) klein sein. Die Personalisierung eines Diffusion-Modells für die eigenen Anwendungsfälle sollte hiermit in naher Zukunft für jedermann also einfach möglich werden.

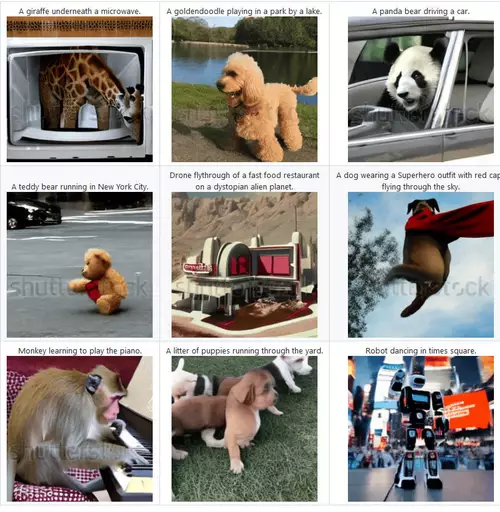

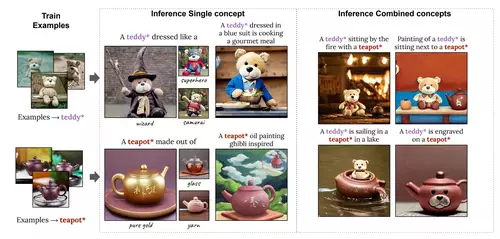

Auch die Anwendung ist denkbar einfach. Man präsentiert dem Netz einfach ein paar Photos und liefert dazu einen Text-Prompt, der beschreibt, welche typische Kategorie in den Bildern zu sehen ist, direkt gefolgt von einem Stern (*).

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Dieser Begriff mit dem Stern lässt sich anschließend im Diffusions-Modell einfach mit den übrigen Prompt-Worten zur Bildbeschreibung nutzen. Es sollen sogar mehrere Objekte auf diesem Wege "eintrainiert" werden können.

Die Schlüsselinnovation in Perfusion nennt sich "Key-Locking". Bei diesem Ansatz werden neue, vom Benutzer gewünschte Konzepte, wie z. B. eine bestimmte Katze oder ein Stuhl, während der Bilderzeugung mit einer breiteren Kategorie verknüpft. So wird beispielsweise die Katze mit der allgemeinen Vorstellung einer "Katze" verknüpft. Diese Technik ermöglicht eine präzisere Anpassung, wobei das Spezielle der hinzu trainierten Objekte in der Darstellung der allgemeinen Kategorie berücksichtigt wird. Es ist also anzunehmen, dass in der Folge alle Katzen der hinzutrainierten Katze stark ähneln werden. Was ein Training mehrerer unterschiedlicher Katzen oder Personen erschweren könnte.

Der breiten, lokalen Anwendung wird trotz einer zeitnahen Veröffentlichung des Codes jedoch die benötigte GPU-Speichergröße von 27GB entgegenstehen. Denn die größten Consumer-GPUs von Nvidia werden aktuell nur mit maximal 24GB ausgeliefert und sind damit knapp zu klein, um Perfusion auszuprobieren.

Genau auf solche kommenden Probleme hatten wir zuletzt in einem speziellen SlashCAM Artikel im April 2023 hingewiesen. Dieser ist leider aktueller denn je, nur mit dem Unterschied, dass AMD tatsächlich in der Software-Unterstützung mächtig aufholt. Doch gerade Perfusion wird mit Sicherheit zuerst einmal nur auf Nvidias Karten laufen...