ETTR steht als Abkürzung für "Exposure To The Right". Gemeint ist damit, ein Motiv immer so zu belichten, dass sich seine Tonwerte möglichst weit rechts im Histogramm ansammeln. Einfach gesprochen soll man bei ETTR also immer soweit überbelichten, bis die hellsten Pixel im Bild kurz vor der Clipping Grenze stehen.

Ist ETTR nicht einfach Zebra-Belichtung?

Das klingt erst einmal ganz und gar nicht neu, sondern erinnert doch sehr stark das Konzept der Zebra-Belichtung, das man schon seit den Camcordern in der 90er Jahren kennt. Doch beim "Zebra" ging es ursprünglich um etwas anderes. Zu der Zeit als das Zebra-Muster als Belichtungskontrolle eingeführt wurde, hatten die CCDs der Videokameras für Videoaufnahmen einen typischen Dynamikumfang von ca. 6 Blendenstufen. Daher gab es faktisch überhaupt keinen Belichtungsspielraum beim Motiv. Schon wenn ein Motiv einigermaßen gut abgebildet wurde, rissen regelmäßig die Lichter aus, weil der Sensor so schnell clippte. Man wählte über das Zebrapattern letztlich nur, wie viel Clipping man in der Aufnahme haben wollte. So wurde (bis auf wenige Ausnahmen) praktisch jede Belichtung durch das frühe Clipping quasi von oben festgelegt.

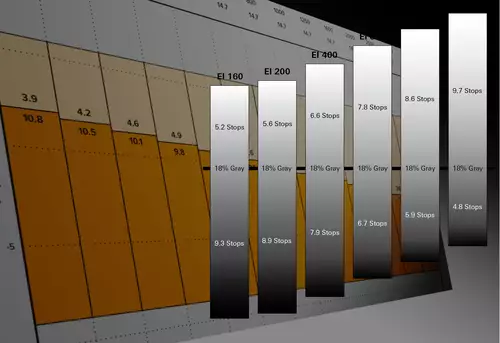

Heutige Kameras bieten dank der großen Sensel und fortgeschrittener Sensortechnik dagegen typischerweise 10-14 Blendenstufen. Sie erlauben damit bei vielen Motiven einen Belichtungsspielraum von mehreren Blendenstufen, innerhalb derer der Kameramann über seine Belichtung frei entscheiden kann. Dies ist möglich, weil für die Betrachtung an einem SDR-Sichtgerät (wie der Monitor oder Fernseher, typischerweise mit REC.709 bzw. sRGB) das Motiv nachträglich auf ca. 7 Blendenstufen zusammengefasst werden muss. Wer also nicht HDR produziert, muss sich immer entscheiden wie er sein Motiv letztlich in den 7 Blendenstufen abbilden will.

Mehr Dynamik = größerer Entscheidungsspielraum

Je größer die Dynamik des Sensors, desto größer ist damit auch der Entscheidungsspielraum des Kameramanns. Das relevante ist nun, dass man diese Entscheidung nicht unbedingt bei der Aufnahme fällen muss. So kann man die Blendenstufen entweder in der Nachbearbeitung (Postproduktion) zusammenstauchen oder schon in der Kamera. Letzteres passiert notgedrungen und mehr oder weniger automatisch, wenn man in einem (Standard)profil in einen 8 Bit Codec aufzeichnet.

Bildprofile sind in erster Linie dazu da, die hohe Sensordynamik nach typischen Sehgewohnheiten auf eine geringere Dynamik zusammenzufassen. Darum gibt es meist auch spezielle Profile (beispielsweise für Landschaft, Nachtaufnahmen, Portrait oder Feuerwerk) bei denen die Sensordynamik anders verteilt wird als im Standardprofil.

RAW und Log

Als Gegenkonzept gibt es die RAW-Aufzeichnung. Diese erlaubt es faktisch die gesamte Sensordynamik aufzuzeichnen und erst in der Postproduktion das Bild zu entwickeln, also in der Nachbearbeitung auf eine geringere Dynamik wie Rec709 oder sRGB abzubilden.

In der Mitte steht noch die Log-Aufzeichnung. Hier wird die Sensordynamik über eine logarithmische Kurve leicht zusammengefasst aufgezeichnet und vor der "Entwicklung" wieder entstaucht, was in Praxis meist nahe die Möglichkeiten von RAW heranreicht. Allerdings nur, wenn die Log-Aufzeichnung auch genügend Tonwertabstufungen bereit hält.

Wird Log in 8 Bit aufgezeichnet, so können nur sehr wenig Tonwertabstufungen pro Blendenstufe aufgezeichnet werden, was in sichtbaren Farbtreppen (Posterisation) resultieren kann. Zur Erinnerung: In 8 Bit kann man maximal 256 Helligkeitswerte speichern, was bei 14 Blendenstufen nur ca. 19 Helligkeitswerten pro Blendenstufe entspricht. Bei 10 Bit Aufzeichnung stehen dagegen schon über 70 Helligkeitswerte pro Blendenstufe zur Verfügung.

Wer also in einen 8 Bit Codec (oder ein 8 Bit-JPEG) abspeichert, tut gut daran, die Verteilung der Sensordaten schon vor der Speicherung in der Kamera berechnen zu lassen. Was nicht prinzipiell schlecht aussehen muss. Denn um die Dynamik einer SDR-Anzeige (Monitor/Fernseher ohne HDR) zu "füttern" reichen die 8 Bit ja prinzipiell gut aus.

Wer jedoch mit den Profilen in der Kamera nicht zufrieden ist oder tiefer in die Entwicklung (also Zusammenfassung der Sensordaten) eingreifen möchte, kann dies auch nachträglich tun, solange man in 10 Bit Log oder RAW aufgezeichnet hat. Denn mit diesen Formaten hält man sich einen großen Entwicklungsspielraum für die Nachbearbeitung offen.

ETTR - den Belichtungsspielraum voll ausreizen

Und hier schließt sich endlich der Kreis zu ETTR. Denn wenn man seine Entwicklung vom Kameraprofil in die Postproduktion verlegt, sollte man sich natürlich fragen, wie man den Sensor ab besten belichten sollte, um nachher noch den größtmöglichen Spielraum zu haben.

Natürlich kann man den Sensor einfach weiterhin wie in 8 Bit mit einem Bildprofil "korrekt" belichten. Durch Log/RAW hat man bereits in diesem Fall noch größere Korrekturmöglichkeiten. Die größte Qualität erzielt man jedoch, wenn man den Sensor so knapp wie möglich unterm Clipping überbelichtet (oder vielleicht sogar ein paar clippende Highlights in Kauf nimmt).

Der Grund hierfür liegt in der Art, wie ein Sensor Helligkeit aufnimmt - nämlich linear. Das Auge dagegen nimmt Helligkeit logarithmisch war. So kann ein Auge klar einen Unterschied zwischen keiner und einer Kerze wahrnehmen. Und auch den Unterschied zwischen 2 und 4 Kerzen, sowie einen Unterschied zwischen 64 und 128 Kerzen wird man deutlich erkennen, weil man diese Unterschiede als ziemlich genau doppelt so hell wahrnimmt. Diese Beispiele entsprechen übrigens immer dem Helligkeits-Unterschied von einer Blendenstufe. Oder von einem zusätzlichen Bit. (Grundlagen hierzu gibt es unter anderem im Artikel Einfach Erklärt: Sensor-Dynamik, Blendenstufen und Bits - und Kerzen.)

Den Unterschied zwischen 127 und 128 Kerzen wird man dagegen kaum wahrnehmen. Und noch weniger den Unterschied zwischen 254 und 255 Kerzen. Ein Sensor-Pixel (übrigens eindeutiger als Sensel bezeichnet), sammelt und zählt Licht (also Photonen) wie Kerzen. Je mehr Lichteinheiten es aufsammelt, desto mehr negativ geladene Elektronen (e-) gibt es ab. Der Zusammenhang zwischen eintreffenden Photonen und abgegebenem Strom ist linear. Oder einfach gesagt: Ein Sensor zählt jede Kerze.

Um die Dynamik einer einzigen Blendenstufe aufzuzeichnen, braucht man nur 1 Bit. Es gibt nur hell oder dunkel. Um acht Blendenstufen linear aufzuzeichnen, benötigt man folglich 8 Bit, bzw ein Byte. Ein 12Bit Sensor kann in einer optimalen Situation 12 Blendenstufen messen. Und ein heute typischer 14 Bit Sensor folglich 14 lineare Blendenstufen.

Sieht man sich nun einen Sensor mit 14 Blendenstufen näher an, so kann dieser die meisten Werte in der hellsten Blendenstufe 14 aufnehmen. Exakter: Es findet sich die Hälfte aller möglichen Messwerte in der hellsten Blendenstufe 14. In der Blendenstufe 13 darunter liegt die Anzahl der möglichen Blendenwerte schon nur noch bei einem Viertel aller möglichen Werte. In der Blendenstufe 12 ist es nur noch ein Achtel (12,5%). Und in der Blendenstufe 11 liegen nur noch 6,25% aller Messwerte. Es klingt unglaublich, aber bei einem 14 Bit Sensor liegen somit 93,75% aller möglichen Messwerte in den Blendenstufen 11-14!

Heller = weniger Rauschen = höhere Qualität

Doch eine Blendenstufe ist nicht gleich Blendenstufe: Nicht nur, dass die niedrigeren Blendenstufen weitaus weniger Tonwertabstufungen haben - sie sind noch mit einem anderen Problem belastet: Wenn eine Blendenstufe nur wenige Abstufungen hat, sind diese viel anfälliger für Fehlmessungen, die wir mal salopp als Rauschen bezeichnen wollen. Denn je weniger Messwerte eine Blendenstufe aufweist, desto mehr fällt ein einzelnes falsch gemessenes Elektron auf.

Deswegen ist eine Blendenstufe im Sensor in der Regel sauberer, je höher sie in der Helligkeit liegt. Auch ohne diesen theoretischen Background dürfte es für die meisten Filmer nachvollziehbar sein, dass man in den dunklen Bereichen eines Motivs (also in den tieferen Blenstufen) meistens ein deutliches Rauschen wahrnehmen kann, welches man in den hellen Bildbereichen in der Regel nicht findet.

Und genau darum macht es Sinn sein Motiv möglichst in den qualitativ besten (= hellsten) Blendenstufen aufzuzeichnen und diese in der Nachbearbeitung "tiefer zu legen". Nur dies garantiert den Sensor wirklich mit bester Qualität auszureizen.

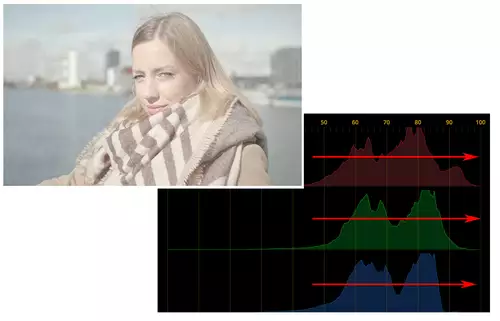

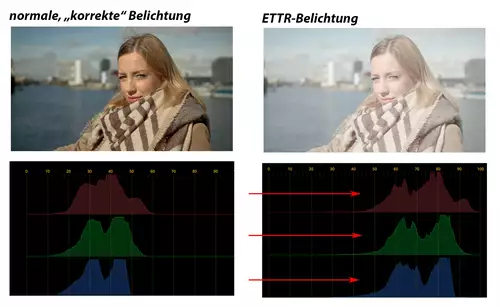

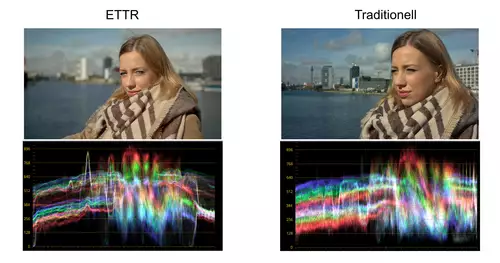

Wichtig ist hierfür allerdings auch ein funktionierendes Color-Management in der Nachbearbeitung. Denn nur allzu leicht verändern sich die Farben beim Absenken der Helligkeit. Nur ein korrekt eingerichteter Farbworkflow kann für konstante Farben sorgen und nur dann macht ETTR auch wirklich Sinn. Hier einmal ein Beispiel, wie sich ETTR auf den Waverform-Monitor eines Motivs auswirkt:

Das linke Bild wurde mit ETTR überbelichtet und dann wieder auf eine normale Belichtung "zurückhgeholt", während das rechte Bild schon in der Kamera korrekt belichtet wurde. Man sieht dabei im Waverform-Monitor sehr klar, wie positiv sich ETTR auf das Rauschen auswirkt. Mehr zu diesem Testaufbau gibt es hier bei uns nachzulesen: Ursa Mini 4.6K korrekt belichten: Zebra, False Color….

Abschließend sollte man nicht unerwähnt lassen, dass sich Zebra und ETTR in der Praxis gut ergänzen, jedoch gleichzeitig eine beliebte Fehlerquelle darstellen. Denn das Zebra in der Kamera ist oft darauf eingestellt, die Überbelichtung für 8 Bit/Rec709 Farbräume anzuzeigen. In solchen Fällen zeigt es dann bei der Log/RAW-Aufzeichnung eine Überbelichtung an, obwohl man sich noch weit von der eigentlichen RAW-Clipping-Grenze befindet.

Wer mit ETTR filmen will, sollte daher vorher die Kamera so einstellen, dass in Zebra, Histogramm und/oder Waveform-Monitor der Clipping Punkt auch wirklich zuverlässig für eine Log- oder RAW-Aufnahme dargestellt wird.