Wie schon im ersten Teil der Artikelserie erwähnt nutzen viele Schnittprogramme die Grafikkarte (GPU).

Diese spielt bei der Videobearbeitung eine besondere Rolle. Sie berechnet mittlerweile nicht nur die meisten 4K-Filter und Effekte sondern kann in manchen Fällen auch noch als Preview-Karte fungieren. Während für einige Applikationen schon eine einfache Mittelklasse-Grafikkarte für einfache 4K-Bearbeitung völlig ausreicht, kann DaVinci Resolve sogar mehrere GPUs im System ans Limit bringen. Der Grund liegt darin, dass Resolve ohne Vorberechnungen auch echte Optical Flow-Effekte auf der GPU in Echtzeit erstellen kann. Dazu gehören u.a. Slow-Motion-Berechnungen, Denoiser sowie das nachträgliche Einrechnen von Motion Blur.

Premiere, Vegas, Final Cut Pro und Edius müssen solche Effekte (sofern überhaupt vorhanden) immer rendern, während DaVinci Resolve versucht diese auf der Grafikkarte in Echtzeit zu berechnen. Selbst drei GPUs der Spitzenklasse können bei der Kombinationen komplexer 4K-Effekte dann noch zu wenig sein.

Prozessoren mit eingebauter GPU bieten in der Regel zu wenig Leistung für gehobenen Videoschnitt in 4K. Auch beim Kauf eines Laptops lohnt es sich daher, auf eine separate GPU zu achten. Eventuell ändert sich dies mit AMDs neuen RYZEN G-Modellen, jedoch konnten wir hiermit noch keine persönlichen Erfahrungen sammeln.

Speicherfragen

Wenn man eine neue Grafikkarte kauft, sollte man darauf achten, dass diese mindestens 8GB eigenen Speicher besitzt. Der Aufpreis gegenüber 4GB ist in der Regel nicht der Rede wert, verspricht jedoch mehr Zukunftssicherheit. Nach unserer Erfahrung kann man zwar in Premiere, Vegas und Edius selbst 4 GB Speicher mit extremen Effektorgien kaum zum Überlaufen bringen. Unter Resolve haben wir jedoch mit 4GB GPU Speicher schon Speicherüberläufe erlebt, besonders wenn man das GPU-Debayering und sowie viele Optical Flow-Effekte mit OFX-Plugins kombiniert. Um für solche Fälle und die Zukunft im Allgemeinen gewappnet zu sein, sind 8GB sicherlich bessere Wahl. Für die kostenlose Version von Resolve spielt GPU-RAM übrigens fast gar keine Rolle, da es hier keine Optical-Flow-Algorithmen gibt. Und mit “normalen” Nodes haben wir auch noch keinen Überlauf bei 4GB Videospeicher erlebt.

Besonders relevant erscheint uns die Geschwindigkeit des angeschlossenen Speichers. Diese korreliert nach unserer Erfahrung noch mehr mit der Leistungsfähigkeit in einem Schnittprogramm als die TFlops. Schnell (und breit) angebundener DDR5-Speicher kann heute fast 500 MB/s erreichen, mit HBM sind aktuell fast 900 MB/s möglich (Nvidia Quadro GV100). Diesbezüglich dürfte die kommende Generation an Grafikkarten in 2018 wieder einen größeren Sprung machen, während eine Steigerung der reinen Tflops eher moderat ausfallen wird.

Mehrere GPUs?

Beim Abspielen von der Timeline unterstützt nach unserem aktuellen Kenntnisstand nur Resolve den Einsatz mehrerer GPUs. Kombiniert man mehrere Karten so kann sich die Leistung teilweise deutlich steigern. Das gilt allerdings nicht für alle Effekte. Eine temporale Noise Reduction in höchster Qualität gewinnt durch eine zweite GPU fast gar nicht, gut unterstützte Effekte gewinnen dagegen zwischen 50 und 80 Prozent Leistung.

Was sich keinesfalls addiert ist der Speicher. Eine schnelle GPU mit 8GB Speicher zeigt also keinesfalls weniger Performance als zwei halb so schnelle Karten mit 8GB. Übrigens müssen die eingebauten GPUs nicht zwingend aus der gleichen Serie stammen, jedoch haben sich unsere Erfahrungen hierzu in den letzten Jahren deutlich verschlechtert. Früher gelang der Mix zwischen GPU-Generationen fast immer problemlos, heute ist es eher ein Glücksspiel, das wir nicht mehr empfehlen können. Hinzu kommen andere Probleme: Sobald jedoch nur eine der Karten zu wenig Speicher hat funktionieren die speicherhungrigen Optical Flow Algorithmen nicht mehr, da alle GPUs sich am Speicher der "kleinsten" Karte orientieren. Außerdem ist es für Resolve offensichtlich leichter, die Leistung effektiv zu verteilen wenn es identische GPUs vorfindet.

Und auch wenn es preislich manchmal interessanter erscheint zwei schwächere Karten statt einer starken zu kaufen, raten wir mittlerweile deutlich lieber zu einer einzigen schnellen GPU. Zum einen profitieren davon alle Applikationen (nicht nur Resolve). Außerdem gibt es immer wieder OFX-Plugin-Effekte (u.a. für Resolve und Vegas), die nur eine GPU nutzen können.

Weiters werden bei einer einzigen GPU weniger PCIe-Lanes und Gehäuse-Platz im System verbraucht. Durch weniger Hardware ist das System dann weniger komplex und in der Folge nicht so fehleranfällig. Und nicht zuletzt lässt sich durch die Reduktion auf eine Grafikkarte mit Desktop-CPU-Plattformen ein gut konfiguriertes System erstellen, das noch eine schnelle M2-SSD und eine Vorschau-Karte beinhalten kann, ohne ans Limit der PCIe-Lanes zu stoßen. ( Siehe hierzu auch ersten Teil dieses Artikels ).

Der Ratschlag, dass man für DaVinci Resolve eine eigene Grafikkarte zur Oberflächendarstellung nutzen sollte, ist nach unserer Erfahrung mit aktuellen GPUs kaum noch relevant. Erst recht, wenn PCI-Steckplätze knapp sind. Bei unseren Tests beschleunigte eine zusätzliche GUI-GPU die Effekte immer nur noch marginal. Deutlich mehr Leistung erhält man durch den Vollausbau der freien PCI-Slots mit möglichst potenten Karten, von denen dann die potenteste das GUI darstellt UND mitrechnet.

Eine weitere Erkenntnis aus unserer Praxis mit dual GPU Setups: Mit der schnelleren Effekt-Berechnung kommt es nach unserer Erfahrung auch zu einem nervigen Nachteil, den wir Synchonisations-Latenz nennen wollen. Bei zwei GPUs im System dauert es nach unserer Erfahrung immer etwas länger bis die GUI nach einem "Raumwechsel" bereit steht. In dieser Zeit scheint der Rechner die Miniatur Thumbnails zwischen den GPUs abzugleichen. Das fällt besonders auf, wenn beim Wechsel zwischen den Oberflächen in Resolve die Miniaturen behäbig aktualisiert werden. Auch dies spricht folglich dafür, dass man lieber in eine sehr gute, als in zwei mittelmäßige GPUs investieren sollte, solange man nicht unbedingt auf die Performance von zwei oder drei Oberklassen-GPUs angewiesen ist.

Übrigens können auch geschickte Caching Mechanismen wie Background-Rendering die Notwendigkeit für mehr GPUs teilweise überflüssig machen. So kann das Geld in einer besonders schnellen Cache-SSD vielleicht deutlich besser angelegt sein.

AMD, Intel oder Nvidia?

Eine relevante Frage ist Wahl des GPU-Herstellers. Nvidia bedient diesen Markt bereits am längsten und stellte mit seiner CUDA-Schnittstelle lange den professionellen de Facto Standard dar. Auf dem Papier sind die unverbindlichen Preisempfehlungen der Nvidia Karten dafür deutlich teurer als vergleichbare AMD-Modelle. In unserem letzten Test landete eine optimierte AMD Vega 56 Karte für 400 Euro Listenpreis in Resolve auf dem Leistungsniveau einer Nvidia GTX 1080 Ti für 800 Euro Listenpreis. Doch aufgrund des Preischaos durch das Mining von Kryptowährungen kostete eine Vega 56 zeitweise mehr als eine Nvidia 1080 Ti. Doch hier deutet sich nach fast einem Jahr mit Wucherpreisen nun endlich spürbare Entspannung an. So sind erstmals seit der Vorstellung AMDs Vega Karten wieder in größeren Stückzahlen lieferbar und bewegen sich auch wieder in richtig vernünftiger Preise. Allerdings bekommt man unseren "Listenpreis/Leitungs-Favoriten" AMD Vega 56 immer noch nicht unter 500 Euro (Juni 2018). (Listenpreis ist eigentlich 400 Euro).

AMD unterstützt mit OpenCL einen offenen Standard, der sich sowohl bei Adobe als auch bei Resolve mittlerweile als praktisch gleichwertig durchgesetzt hat. Sonys Vegas setzte schon seit jeher einzig und allein auf OpenCL. Mittlerweile unterstützt auch Nvidia diesen neuen Standard, allerdings immer noch etwas halbherzig. Schließlich will man ja weiterhin die Hersteller zu CUDA überreden, das es nur für Nvidia-Karten gibt. Für OpenCL spricht allerdings, dass sogar Intel dies unterstützt. Sowohl Premiere als auch Vegas laufen daher sogar mit den integrierten GPUs in aktuellen Consumer Core i7-Prozessoren. Diese Intel GPUs kommen in der Leistung nicht an dedizierte Grafikkarten heran, können allerdings auf dem Laptop für eine ganz passable Beschleunigung sorgen.

In der Vergangenheit galten AMD-Modelle bzw. deren Treiber als nicht ganz so stabil wie die Nvidia Pendants. Wir haben jedoch in der Redaktion schon seit längerem ein Dual Vega 56 Setup in unserem Hauptrechner laufen und können uns nicht über größere Probleme beschweren als bei Nvidia Karten. Grundsätzlich laufen unsere AMD-GPUs ebenso rund. Dies dürfte wiederum auch darauf zurückzuführen sein, dass Apple nur noch ausschließlich AMD-GPUs verbaut. Und wenn man als Hersteller seine Schnittsoftware für Apple optimiert, so bedeutet dies automatisch für AMD zu optimieren, wovon wiederum die PC-Version offensichtlich ebenfalls profitiert. Zuletzt hat sich übrigens auch Intel mit AMD zusammengefunden und bietet eine Intel-Prozessor-AMD-GPU Kombination für besonders kompakte Rechner an. Damit sollte auch der breitflächige Support für AMDs Lösungen in Zukunft außer Frage stehen.

In der Praxis sollte man jedoch auch nicht außer Acht lassen, dass Nvidia meistens mehr Partnerkarten mit oft besseren Kühllösungen bieten kann. Nvidia Karten sind daher oft leiser und verbrauchen etwas dazu etwas weniger Strom.

Was uns persönlich jedoch missfällt sind die Geschäftspraktiken, mit denen Nvidia im Markt immer wieder auffällt. So gab es 4GB Karten bei denen nur 3,5GB des Speichers schnell angebunden waren, ohne dass dies offen kommuniziert wurde. Weiters gibt es Verträge, die es untersagen Gaming-Grafikkarten kommerziell in Servern zu betreiben. Und es gab deutliche Hinweise darauf, dass Nvidia Dritthersteller unter Druck setzen wollte, keine AMD-Karten anzubieten.

Dies erweckt (nicht nur bei uns) den Anschein, dass Nvidia immer wieder versucht, seine marktbeherrschende Stellung nicht unbedingt im besten Sinne des Kunden auszunutzen.

Vorschau über GPU oder dediziert?

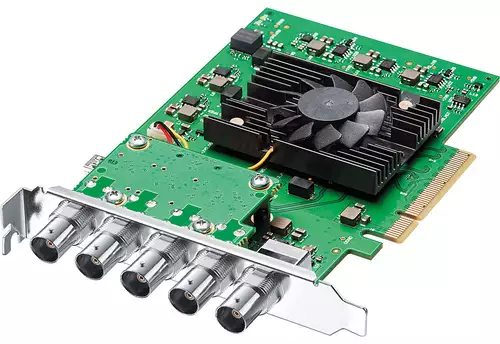

Ein weiteres wichtiges Thema ist die Videovorschau. Denn sowohl Premiere als auch Vegas ermöglichen es, einen zweiten Video-Ausgang der Grafikkarte dazu zu nutzen, um eine Video-Vorschau anzuzeigen. DaVinci Resolve dagegen zwingt den Anwender hierfür eine spezielle Videoschnittkarte anzuschaffen, die jedoch auch unter anderen Schnittprogrammen funktioniert. Für 4K-Ausgabe mit bis 30p kostet das günstigste Modell ca. 200 Euro (z.B. DeckLink Mini Monitor 4K oder Intensity Pro 4K). Vorteil einer solchen Lösung ist dabei, dass diese Blackmagic-Karten auch eine echte 10 Bit Ausgabe ermöglichen. Und sie waren lange die einzige Möglichkeit um unter Linux beim Videoschnitt mit Resolve Ton auszugeben. 4K/60p sind dagegen erst ab ca. 670 Euro zu haben, und das nur über SDI.

Auch wenn teure Nvidia Quadro oder AMD FirePro-Modellen mit SDI früher explizit für solche Anwendungen beworben wurden, sind dies heute keine Alternativen zu einer Vorschau-Karte. Uns ist dazu keine derartige 4K-Lösung mit 6G oder 12G SDI bekannt.

Wem eine 8 Bit Ausgabe reicht der kann sich unter Premiere oder Vegas dagegen die Investition für eine dedizierte Schnittkarte sparen, wenn die Grafikkarte mit brauchbaren Ausgängen bestückt ist. Man sollte sich dabei allerdings bewusst sein, dass die Übertragung zum Monitor dann in RGB und nicht in YUV mit teilweise nicht frei wählbaren Bildwiederholraten erfolgt, was Schnitt-Puristen in der Regel früher oder später doch zu einer dedizierten Vorschaukarte treibt.

Ob die Anschlüsse für einen selbst “brauchbar” sind, definiert sich in diesem Fall nach den eigenen Ansprüchen. Eine Grafikkarte mit SDI-Ausgängen kostet meist weitaus mehr als eine dedizierte Videoschnittkarte plus "normale"Grafikkarte. Dagegen dürfte es vielen Anwendern auch genügen, wenn das Hauptdisplay mit 1920 x 1200 Pixeln bei 60Hz über HDMI angesteuert wird, und ein 4K-Vorschaumonitor über den 60Hz-Displayport-Anschluss läuft.

Solange man in erster Linie für das Internet produziert, dürfte eine mögliche 8 Bit sRGB-Vorschau mit 60Hz sogar viel mehr der Zielgruppe entsprechen als eine 10 Bit REC709 YUV-Vorschau auf einem Broadcast-Referenzmonitor. Mit etwas Recherche lassen sich so günstige Grafikkarten-Lösungen finden, die dann natürlich auch von den Videoapplikationen unterstützt werden müssen. Besonders sticht in dieser Disziplin Vegas hervor, das die meisten Einstellmöglichkeiten für die Einrichtung des Vorschaumonitors bietet. Premiere offeriert hier schon weniger Optionen. EDIUS und Resolve verlangen - wie schon erwähnt- nach einer separaten Preview-Karte, die in 4K mit 60Hz mindestens 670 Euro kostet und dazu nur SDI-Ausgänge besitzt. Wer 4K über HDMI 2.0 mit 50 oder 60 Hz sehen will, muss schon fast 1000 Euro in die Hand nehmen (z.B. für eine DeckLink 4K Extreme 12G).