Nachdem in unserer neuen 4K Datenbank auch die 4K-Debayering Testbilder zum direkten Vergleich aufgerufen werden können, wollen wir in einem separaten Grundlagenartikel darstellen, auf welche Stellen es in diesem Bild besonders ankommt.

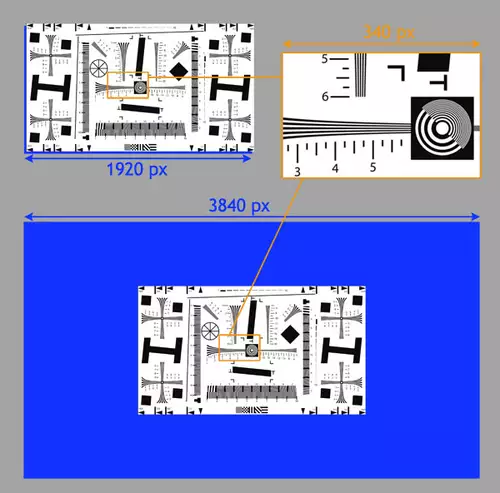

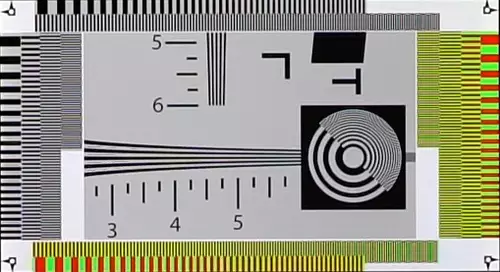

Zu Beginn noch ein letztes mal etwas grundsätzliches: Für unseren 4K Schärfe/Debayering-Test filmen wir unseren virtuellen Testchart-Ausschnitt so ab, dass der orange gekennzeichnete Bereich in der Aufnahme möglichst genau 340 Pixel breit ist.

In FullHD (oben links) würden die 340 Pixel des Ausschnitts erreicht, wenn man das Chart exakt bildschirmfüllend abfilmt. In 4K/UHD muss man den Kamera-Abstand zu dem virtuellen Chart jedoch vergrößern, damit der geplante Ausschnitt wieder 340 Pixel breit wird. Nur so erreicht man in 4K auch kritische Frequenzbereiche in der Kreisen mit dem klassischen ISO 11223 Chart-Ausschnitt.

Aufgrund dieses neuen Abstands sind die Bildergebnisse zwischen dieser neuen 4K-Messung und den alten FullHD-Messungen NICHT vergleichbar. Wir haben unser Testbild jedoch in den letzten Jahren etwas erweitert, um noch mehr Informationen zur Sensorauslesung und zum allgemeinen Schärfeverhalten der Kamera beim Debayering zu erhalten. Doch auf welche Stellen im Bild sollte man besonders achten und was bedeuten interessante Veränderungen bzw. Bildfehler?

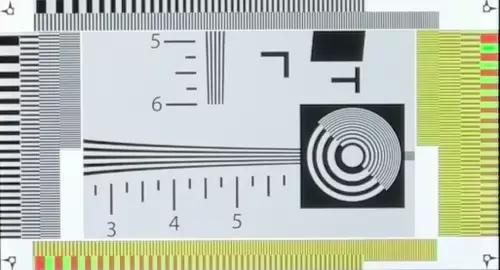

Zu Beginn vielleicht das bislang perfekteste 4K Debayering, das wir bislang in unserer Reaktion hatten: Die leider kaum noch erhältliche Samsung NX1 darf sich diese Krone stolz aufsetzen:

In der Mitte sehen wir den 340 Pixel-Ausschnitt aus dem ISO11223-Chart. Darum herum haben wir so genannte Sweeps gelegt. Dies sind immer feiner zusammenlaufende Linenpaare. Einmal schwarz weiß und einmal rot-grün, sowohl vertikal als auch horizontal: Im hier gezeigten Samsung-NX1-Ergebnis lässt sich auch noch in den “feinsten” Abschnitten der Sweeps ein originalgetreues Muster erkennen. Doch sehen wir uns einmal an, was beim Debayering auch so alles schief gehen kann.

Die größten Probleme hat eine Kamera, wenn für jedes Pixel im Bild nur ein Sensel des Sensors zur Verfügung steht (1:1 Sensor Readout). Dann muss die Farbinformation aus benachbarten Senseln gewonnen werden. Fast alle aktuellen 4K-Kameras arbeiten mit einem sogenannten Bayer-Pattern. Um die fehlenden Farbinformationen in der Kamera zu interpolieren haben die Hersteller in der Regel drei Optionen:

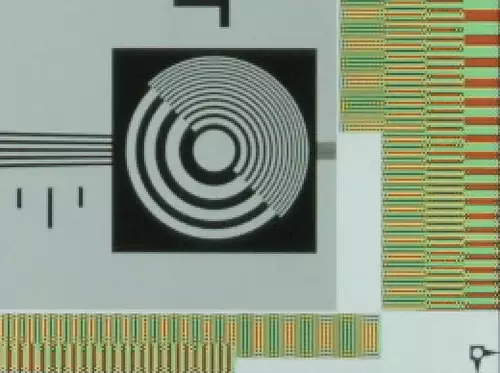

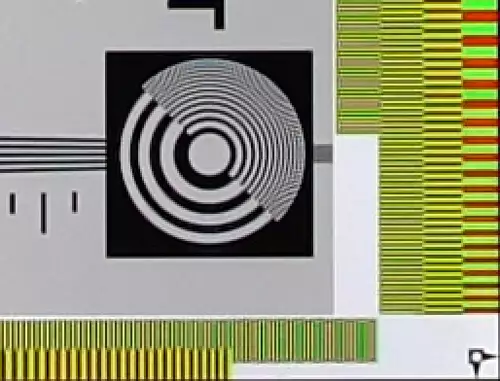

Luma dominiert bevorzugen. In so einem Fall sind die Kreise im Bild nahezu perfekt. Auch viele schwarz/weiß-Kontrastkanten sehen gut aus, solange der Weißabgleich korrekt ausgeführt wurde. In den farbigen Chroma-Sweeps kommt es im Gegenzug zu starken Verpixelungen. Ein typisches Beispiel ist hierfür die erste Generation von Blackmagics 4K Kameras mit dem CMOSIS Sensor:

Eine Vergrößerung der kritischen Bereiche zeigt deutlich dass ein Zusammenlegen der Farbinformationen praktisch gar nicht stattfindet. Der Farbeffekt entsteht hier mehr durch eine Art Dithering, das visuell ähnliche Probleme machen kann wie Aliasing:

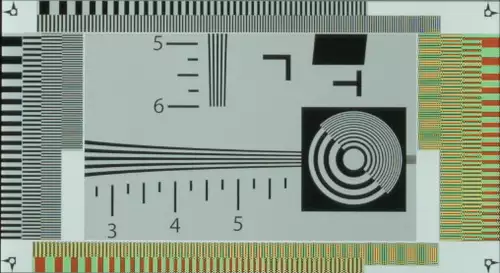

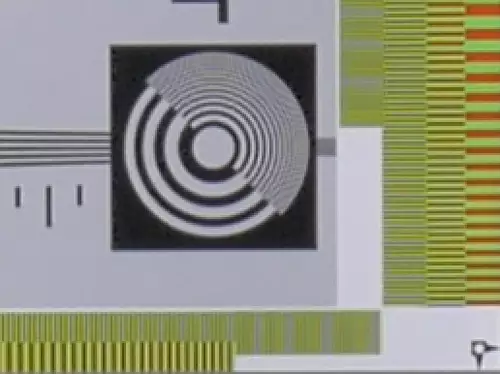

Die meist bilineare Interpolation ist das typische Verhalten großer Hersteller (so u.a. fast alle 4K-Kameras von Sony und Canon mit einem 1:1 Pixel Readout). Hier wird die fehlende Farbinformation durch ihre Nachbarpixel interpoliert, also gemittelt:

Dies sorgt dann typischerweise für Falschmuster in den feinen Luma-Kreisstrukturen, dafür werden im Gegenzug die Chroma-Details nicht so stark verpixelt und besitzen weniger Aliasing-Probleme wie im ersten Fall.

Hier eine Vergrößerung des relevanten Bereiches:

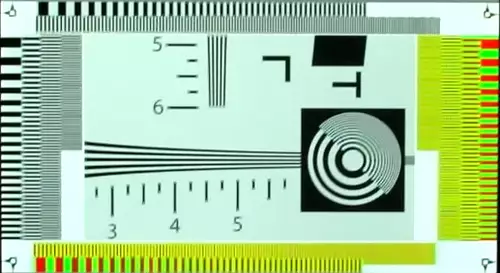

Der dritte Weg ist eine Art Filterung feiner Details. Panasonic geht unter anderem bei der GH4 (aber auch anderen Kameras) diesen Weg:

Die Vergrößerung macht gut sichtbar, dass Details in einer Art Weichzeichung untergehen. Dafür kämpft man fast gar nicht mit Moire-Problemen. Für Cinema-Ästetik ist dies in der Regel ein Vorteil, der bei teureren Cine-Kameras meist durch optische Lowpass Filter (OLPs) erzielt wird.

Andere Kameras übertreiben jedoch manchmal auch stark mit ihrer Filterung oder legen etwas seltsame Pattern an den Tag, wie beispielsweise die JVC GY-LS300:

Dieses Bild ist nicht verwackelt sondern der Sensor scheint eine Art diagonale Filterung vorzunehmen. Diese lässt horizontale und vertikale Luma-Messungen relativ gut aussehen, aber diagonale Details verschwinden fast komplett. Solche Debayering-Verfahren bekommt man jedoch eher selten zu Gesicht.

Kurz gesagt:

Um ein einwandfreies Debayering bei einem Bayer Pattern Sensor hinzubekommen reicht ein 1:1-Pixel Readout nicht. Wird jedes Sensor-Sensel später ein Pixel, muss der Hersteller beim Debayering einen Kompromiss eingehen. Und dieser spiegelt sich immer in den aufgeführten Fällen (oder einem Mix daraus) wieder. Das gilt übrigens auch für RAW-Aufzeichnung. Nur muss man dann die Debayering-Entscheidung (sofern überhaupt möglich) in der Postproduktion treffen.

Dass es auch besser geht zeigt(e) Samsung oder aktuell auch Sony mit der A7RII. Denn wenn man mehr Sensel des Sensors nutzen kann, kann man durch herunterrechnen der höheren Sensor-Auflösung ein nahezu perfektes 4K/UHD-Debayering erzielen. Allerdings bedeuten mehr Sensel auch kleinere Sensel und damit weniger Dynamik sowie mehr Read-Out-Zeit und damit verschlechterte Rolling Shutter Werte. Aber das ist mal wieder schon ein neues Thema für einen eigenen Artikel. An dieser Stelle wollten wir nur zeigen, worauf man bei unseren Testbildern am besten achtet, wenn man das Debayering der Kamera einschätzen will.