Eine besonders interessantes Feld für den Einsatz von neuronalen Netzwerken ist die Interpolation perspektivischer Ansichten aus einigen Bildern (view synthesis) mittels sogenannter NeRFs (Neural layered Radiance Representation) - die Kunst besteht darin, aus möglichst wenigen solcher Bilder eines Objekts weitere fotorealistische Ansichten zu errechnen, was zum Teil schon überraschend gut funktioniert - auch bei Bildern mit Schattenwürfen oder Spiegelungen.

So hatte Ende letzten Jahres schon ein Team von Google und der Universität Oxford einen interessanten neuen AI-Algorithmus zur Manipulation von bewegten Personen in Videos gezeigt, welcher verschiedene bewegte Objekte in einem Video erkennt und sie unterschiedlichen Ebenen zuweist, wodurch eine Vielzahl interessanter Effekte per Compositing der einzelnen Layer in Bezug zueinander möglich wird.

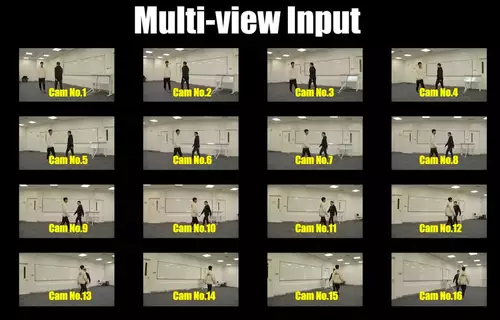

Der Ansatz des Teams der ShangHaiTech Universität geht einen anderen Weg und versucht auf der Grundlage einer großen Anzahl von simultanen Ansichten -- es werden 16 Kameras eingesetzt für einen Sichtbereich von insgesamt 180°-- neue Möglichkeiten des objektbasierten, räumlichen Videoediting zu eröffnen.

Und tatsächlich - der neue Algorithmus ("space-time coherent neural layered radiance representation" aka ST-NeRF) vermag in Videos nicht nur verschiedene bewegte Objekte im Vordergrund vom Hintergrund zu trennen, er rekonstruiert auch korrekt verdeckte Hintergründe, ermöglicht das Klonen, Ändern der Größe und Re-Timing bewegter Objekte. All das auch per virtueller Kamera aus verschiedenen Perspektiven, die gleitend geändert werden können per virtueller Dollyfahrt.

// Top-News auf einen Blick:

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

- Blackmagic PYXIS 12K - Sensor-Test - Rolling Shutter und Dynamik

Die Möglichkeiten des Verfahrens gerade zum Beispiel für Musikvideos wird extra in Democlips der Forscher vorgeführt - so kann die Tanzperformance zweier Tänzerinnen etwa nachträglich perfekt synchronisiert werden, die zwei Tänzerinnen zu einer ganzen Tanzgruppe multipliziert werden oder Performer können über die Bühne schweben. Ein weiterer Einsatzzweck sind virtuelle Kamerafahrten, die nachträglich frei nach Wahl der Regie aus den Perspektiven der einzelnen Kameras synthetisiert werden können oder auch eine Dollyfahrt einer eingefrorenen Szene (aka Bullet-Time Effekt).

mehr Bilder zur News: