Im Bereich der KI erfolgt der Schritt von der Studie zum Startup ziemlich schnell - so demonstriert das neue Unternehmen LumaLabsAI seine Luma AI App, welche auf einem Smartphone 3D-Ansichten (und auch Modelle) von Objekten nur anhand einiger Photos generieren kann. Vorerst ist das Projekt noch in einer geschlossenen Beta (man kann sich für einen Zugang bewerben), aber es gibt schon einige eindrucksvolle Beispiele von verschiedenen per Luma AI erzeugen 3D-Modellen. Vorerst ist Luma AI nur für iOS verfügbar, eine Android-Version ist aber geplant.

Wir hatten schon früher öfter über über Neural Radiance Fields (NeRFs) berichtet, die zugrundeliegende KI-Technologie von LumaAI - wie etwa Nvidia Instant NeRF oder Googles NeRF in the Wild - virtuelle Kamerafahrten aus Photos. Unseres Wissen ist LumaAI aber das erste Projekt, welches NeRFs in Form einer Smartphone-App einem großen Kreis von Usern allgemein zugänglich machen wird.

(Quelle Twitter @Erisdraw3D)

NeRFs per Rundum-Video

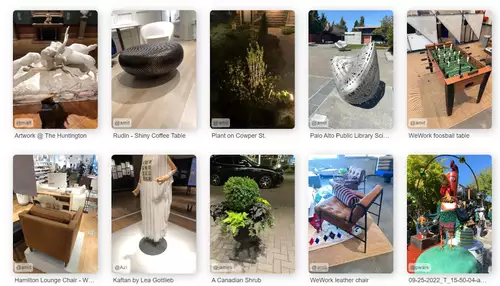

Anders als vorherige NeRF-Methoden benötigt Luma AI nicht eine Vielzahl von Photos als Input, sondern einen Videorundgang um das gewünschte Objekt. Das Objekt kann nach erfolgtem Capturing und dessen Verarbeitung dann sowohl in seiner Umgebung als auch isoliert von allen Seiten interaktiv betrachtet werden - sogar Zoomfahrten in das Objekt sind (begrenzt) möglich, oder auch synthetisierte Photos aus beliebigen Perspektiven. Ebenso kann die App eine 360°-Ansicht eines Raumes generieren, welcher dann mittels eines virtuellen 360° Kameraschwenks angeschaut werden kann. Laut einem der Entwickler dauert die Generierung einer 3D-Ansicht (welche online per Cloud erfolgt) eines Raumes allerdings noch ca. 30 Minuten.

Die Anwendungsmöglichkeiten einer solchen App sind zahlreich - so kann das 3D-Objekt dann zum Beispiel in einem 3D-Modelingprogramm wie Blender oder einer Game-Engine wie Unreal weiter editiert, in einer bestimmten Ansicht als Photo exportiert oder in Augmented oder Virtual Reality Umgebungen importiert werden.

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

Virtuelle Filmproduktionen

LumaLabsAI hat aber auch spezifische, die Filmproduktion betreffende Anwendungsgebiet im Blick: so soll ein Plugin für Unreal entwickelt werden, welches den direkten Import von per Luma AI gescannten Umgebungen und Objekten ermöglicht, um in virtuellen Filmproduktionen eingesetzt zu werden, zum Beispiel für In-Camera-VFX oder virtuelles Location Scouting.

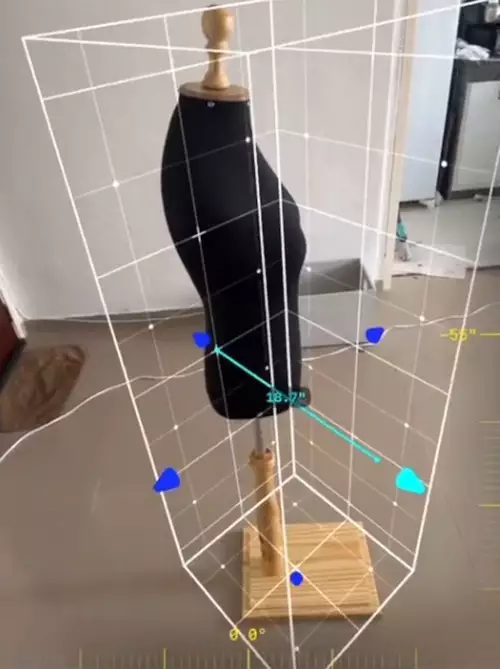

Im folgenden Video ist zu sehen, wie die Luma AI App funktioniert: in einer Augmented Reality Ansicht des Live-Kamerabildes kann der User in der App eine virtuelle 3D-Box um ein Objekt ziehen, welches gecapturet werden soll. Dann muss man im Kreis gehen, die Kamera immer auf das Objekt gerichtet, um Ansichten aus allen Seiten einzufangen.

Zusammen mit Algorithmen wie DreamFusion, welches die Generierung von 3D Modellen nur nach Textbeschreibung ermöglicht, ergeben sich immer mehr Möglichkeiten, 3D-Modelle einfach zu einzusetzen. LumaAI wird mit Sicherheit nicht die einzige Anwendung bleiben, welche NeRFs zur Synthese von 3D-Modellen aus Videos oder Photos nutzt - wir dürfen gespannt sein auf die nächsten Apps.