Heute Nacht hat Stability AI die Version 2 des bahnbrechenden KI-Bilderzeugungstools Stable Diffusion - weiterhin unter einer OpenSource Lizenz - angekündigt. Das Tool hat übrigens auch lokale Wurzeln: Ein Team mit Robin Rombach (Stability AI) und Patrick Esser (Runway ML) von der CompVis-Gruppe an der LMU München unter der Leitung von Prof. Dr. Björn Ommer leitete das ursprüngliche Stable Diffusion V1 Release.

Stable Diffusion 2.0 bietet nun eine Reihe wichtiger Verbesserungen und Funktionen im Vergleich zur ursprünglichen V1-Version:

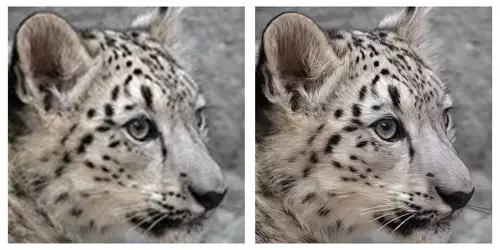

Die neue Version enthält robustere Text zu Bild-Modelle, die mit einem brandneuen Text-Encoder (OpenCLIP) trainiert wurden, der die Qualität der generierten Bilder im Vergleich zu früheren V1-Versionen erheblich verbessern soll. Die Text-zu-Bild-Modelle in dieser Version können Bilder mit Standardauflösungen von 512x512 Pixeln und 768x768 Pixeln erzeugen. Stable Diffusion 2.0 enthält ein Upscaler-Diffusionsmodell, das die Auflösung von Bildern um den Faktor 4 erhöht. In Kombination mit den Text-zu-Bild-Modellen kann Stable Diffusion 2.0 somit Bilder mit einer Auflösung von 2048x2048 und höher erzeugen.

// Top-News auf einen Blick:

- Affinity Photo, Designer und Publisher ab sofort in einer kostenlosen App

- DJI Neo 2 bringt Rundum-Hinderniserkennung samt LiDAR

- Künftige Xbox Next: Vollwertiger Windows-PC mit Potenzial für Videobearbeitung

- LG UltraFine 40U990A-W - 40 5K2K Monitor mit Thunderbolt 5

- Neue Firmware für Panasonic LUMIX S5 II, S5 IIX, S9, GH7 und G9 II

Es werden übrigens auch weiterhin nicht jugendfreie Inhalte mit dem NSFW-Filter vor der Ausgabe unterdrückt.

In den nächsten Tagen sollen die neuen Modelle in die Stability AI API Platform (platform.stability.ai) und DreamStudio eingebunden werden. Wir sind gespannt, was mit den neuen Tools auf uns zukommen wird...