Newsmeldung von slashCAM:

Mit der Ankündigung von Final Cut Pro 10.4.1 für nächsten Montag hat Apple auch ProRes RAW angekündigt.

ProRes RAW soll die Qualitäts- und Workflow-Vorteile von RAW m...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Neues Apple ProRes RAW Format angekündigt // NAB 2018

Antwort von ZacFilm:

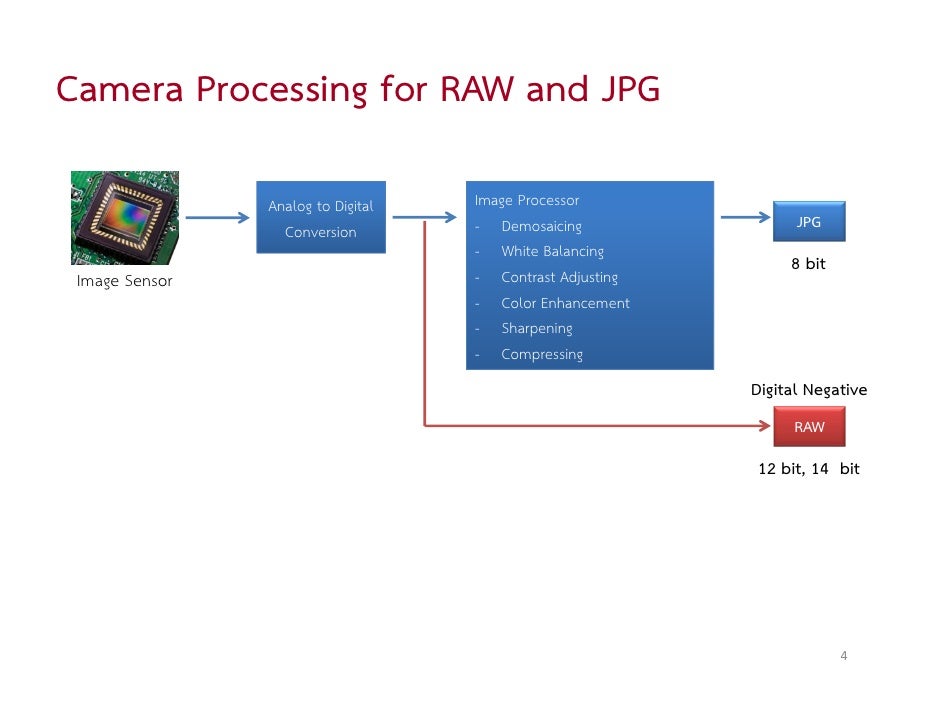

Das heißt 12 Bit?

Antwort von WoWu:

Das heißt, dass sich erst mal Kamerahersteller finden müssen, die das unterstützen und das wird sicher etwas mit den Lizenzbedingungen, Preisen und Kompatibilitäten auch zu ändern Schnittprogrammen zu tun haben.

Dann wird sich vermutlich auch die Frage stellen, wo die vermeintlichen Vorteile zu eigenen Kamers-RAW Formaten liegen.

Nicht umsonst hat sich DNG nicht durchgesetzt.

Antwort von -paleface-:

Vermutlich wird es da auf der NAB was geben. Sowas klärt man ja meist vorher.

Würde lachen wenn es BMD wäre :-D

Antwort von Jott:

Atomos und DJI sind schon mal im Boot. BM - traditionell Apple-affin - könnte auch ein Kandidat sein. Who knows. Ein paar Tage noch warten ...

Antwort von freezer:

Das kommt jetzt doch ziemlich überraschend.

Apple hätte zumindest die Möglichkeit und den Willen so etwas als Standard am Markt unterzubringen.

Antwort von mash_gh4:

WoWu hat geschrieben:

Das heißt, dass sich erst mal Kamerahersteller finden müssen, die das unterstützen und das wird sicher etwas mit den Lizenzbedingungen, Preisen und Kompatibilitäten auch zu ändern Schnittprogrammen zu tun haben.

naja, wenn man sich anschut welche gravierenden probleme es gibt, wenn prores od. dbxhr als intermediate fomat in ACES od. anderen auf linearen farbräumen basierenden systemen mit sich bringen, macht es ganz gewiss sinn, dass in diese richtung verbesserungsvorschläge gemacht werden. dass das im falle von apple nicht sonderlich offen ausfällt und den den relativ breit gesetreuten anwendungswünschen nur bedingt entgegenkommt, überrascht aber leider nicht wirklich. vermutlich zielt es also eher wieder nur darauf ab, mit einem weiteren inkompatiblen zuckerl ihre eigenen systeme gegenüber konkurrierenden produkten weiter abzuschotten.

WoWu hat geschrieben:

Nicht umsonst hat sich DNG nicht durchgesetzt.

das würde ich nicht so sehen. in seinem ausgesprochen eng abgestckten feld ist es durchaus als einigermaßen offener standard allgemein akkzeptiert und vernünftig verwendbar.

Antwort von Axel:

Es hieß, ProRes Raw könne ohne weiteres von FCP 10.4.1 (ab Montag also) importiert werden. Toll. Und dann?

Denn ein eigenes "Camera Raw" Tool hat FCP nicht im "neuen" (4 Monate alten) Color-Tab. Wäre nur konsequent, wenn das auch käme.

Ich weiß, dass ich hierfür Prügel kriege, ich sage es dennoch. Die Einzeltools für Farbkorrektur sind echt nicht schlecht, ein paar kleinere Bugs werden ab Montag sicher verschwunden sein. Aber ich persönlich finde, dass ein wirklich umfassendes Grading bei, sagen wir, *bloß* 100 Clips in der Timeline (ich erwähne das, weil die Notwendigkeit, Clips miteinander zu vergleichen, in dieser Version gar nicht berücksichtigt ist! Und ich

kenne auch die Tricks: 1. gegradeter Browser-Clip als Referenz mit Viewer und Canvas. 2. Toggeln von "S", sodass das angezeigte Bild zwischen Playhead und Skimmer zum Vergleich wechselt. 3. Verbinden eines Referenz-Standbildes mit Sichern des "Grades" als Effekt-Voreinstellung.) soviel redundantes Geklicke, Getippe und Geschiebe bedeutet, dass es m.E. Apples Anspruch, Benutzerfreundlichkeit an erste Stelle zu setzen, nicht würdig ist. Und ich

benutze schon ctrl+tab und ctrl+shift+tab, um zwischen Effekt- und Farbpalette zu switchen.

Wer ernsthaft das Beste aus diesem ProRes Raw herausholen will, wird vor allem darauf hoffen, dass Resolve schnell mit an Bord ist.

Antwort von Paralkar:

Blackmagic ist ja auch normalerweise schnell bei sowas, bin mal gespannt,

Was is das Wavelet wie bei Red???

Hört sich gut an, mich hats schon immer genervt ProRes über 2k laufen zu lassen, weil unnötig hohe Datenmengen zu Stande kommen im Vergleich zu Cinema DNG (4:1)

Außerdem wäre compressed Raw für die Alexas geil, hoffentlich zieht Arri mit und das ganze geht hardwaretechnisch überhaupt.

Antwort von Axel:

Axel hat geschrieben:

Es hieß, ProRes Raw könne ohne weiteres von FCP 10.4.1 (ab Montag also) importiert werden. Toll. Und dann?

Denn ein eigenes "Camera Raw" Tool hat FCP nicht im "neuen" (4 Monate alten) Color-Tab. Wäre nur konsequent, wenn das auch käme.

Okay, im Whitepaper zu ProRes Raw steht's. Es gibt drei Möglichkeiten. Erstens die neue Clip-Eigenschaft im Inspektor:

Raw zu Log-Konversion. Zweitens die LUT, entweder als Clip-Eigenschaft oder als Effekt Benutzer-LUT. Drittens das Graden ohne Seil und doppelten Boden.

Antwort von Jott:

Paralkar hat geschrieben:

Was is das Wavelet wie bei Red???

Nö. Solche Fragen und mehr beantwortet das aufschlussreiche White Paper:

https://www.apple.com/final-cut-pro/doc ... _Paper.pdf

Antwort von Frank Glencairn:

Nö, tut es nicht.

Ich hab jedenfalls kein Wort über die Kompression gefunden.

Antwort von CameraRick:

Ich frage mich ja, ob es sich ggf sogar so verhält wie Cineform RAW. Also, mit der "active Metadata"; reine Spekulation aufgrund des Namens.

Vom Whitepaper ausgehend scheint das erstmal nicht so.

Apple täte gut daran, dass nicht nur auf seine eigenen Applikationen laufen zu lassen; ich fand es zugegeben recht erstaunlich dass sie jetzt mit so einem Ding um die Ecke kommen, solang Du das Zeug aber nicht in einen Resolve oder baselight bekommst sehe ich da nicht so die große Zukunft in der Akzeptanz. Da ja FCPx anscheinend nur eine RAW zu Log conversion anbietet ist das Ganze ja schon in sich recht limitiert, wenn man mal in eine andere Anwendung will, wenn einem Motion oder so zB mal nicht zu sagt. Ich habe natürlich auch nur ein sehr eingeschränktes Sichtfeld, indem niemand FCPx oder Motion benutzt, kann den Markt da schlecht einschätzen :/

Antwort von Abercrombie:

Ob man wohl komfortabel CinemaDNGs in ProRes RAW umwandeln werden können ohne nennenswert Informationen zu verlieren?

Antwort von Axel:

Abercrombie hat geschrieben:

Ob man wohl komfortabel CinemaDNGs in ProRes RAW umwandeln werden können ohne nennenswert Informationen zu verlieren?

Umkodieren geht grundsätzlich nicht. Es ist, wie gesagt, nur ein Aufnahmevodec.

Antwort von nic:

Axel hat geschrieben:

Abercrombie hat geschrieben:

Ob man wohl komfortabel CinemaDNGs in ProRes RAW umwandeln werden können ohne nennenswert Informationen zu verlieren?

Umkodieren geht grundsätzlich nicht. Es ist, wie gesagt, nur ein Aufnahmevodec.

Theoretisch geht das schon. Nur wird Apple wohl kein entsprechendes Programm anbieten...

Antwort von Jott:

"Frank Glencairn" hat geschrieben:

Nö, tut es nicht.

Ich hab jedenfalls kein Wort über die Kompression gefunden.

Ich schon, gleich im Intro:

„Apple ProRes RAW is based on the same principles and underlying technology as existing ProRes codecs, but is applied to a camera sensor’s pristine raw image data rather than conventional image pixels.“

Steilvorlage für wowu („30 Jahre altes DCI“)! :-)

Antwort von nic:

Jott hat geschrieben:

"Frank Glencairn" hat geschrieben:

Nö, tut es nicht.

Ich hab jedenfalls kein Wort über die Kompression gefunden.

Ich schon, gleich im Intro:

„Apple ProRes RAW is based on the same principles and underlying technology as existing ProRes codecs, but is applied to a camera sensor’s pristine raw image data rather than conventional image pixels.“

Steilvorlage für wowu („30 Jahre altes DCI“)! :-)

Wavelet statt DCT wäre schon sinnvoll gewesen...

Antwort von CameraRick:

7nic hat geschrieben:

Wavelet statt DCT wäre schon sinnvoll gewesen...

Aber dann müsste man ja was neues entwickeln... :)

Cineform RAW hat den Ansatz ja, leider ist der nicht komplett lizenzfrei für die Implementierung in Hardware und erfreut sich offenbar keiner großer Beliebtheit. Eine Schande, eigentlich finde ich das Format ganz gut.

Antwort von mash_gh4:

7nic hat geschrieben:

Axel hat geschrieben:

Umkodieren geht grundsätzlich nicht. Es ist, wie gesagt, nur ein Aufnahmevodec.

Theoretisch geht das schon. Nur wird Apple wohl kein entsprechendes Programm anbieten...

dieser schritt ist normalerweise der erste, den man unternimmt, wenn man die unterstützung für ein neues raw format in freier software umsetzt, da die entsprechenden raw converter von adobe wirklich immer fast alles vernünftig unterstützen. in wahrheit sind raw formate aber verhältnismäßig einfach aufgebaut und sehr schnell nachzubilden.

Antwort von Frank Glencairn:

Jott hat geschrieben:

[

Ich schon, gleich im Intro:

„Apple ProRes RAW is based on the same principles and underlying technology as existing ProRes codecs, but is applied to a camera sensor’s pristine raw image data rather than conventional image pixels.“

"the same principles and underlying technology as existing ProRes" noch schwammiger gings nicht mehr?

Von einem "White Paper" erwarte ich normal schon etwas mehr Substanz, als von einer Pressemeldung.

Antwort von mash_gh4:

"Frank Glencairn" hat geschrieben:

Jott hat geschrieben:

[

Ich schon, gleich im Intro:

„Apple ProRes RAW is based on the same principles and underlying technology as existing ProRes codecs, but is applied to a camera sensor’s pristine raw image data rather than conventional image pixels.“

"the same principles and underlying technology as existing ProRes" noch schwammiger gings nicht mehr?

Von einem "White Paper" erwarte ich normal schon etwas mehr Substanz, als von einer Pressemeldung.

naja -- während die tatsächlichen technischen dokus von apple meist ganz brauchbar sind, schauen whitepapers eben immer ungefähr so aus. das ist aber bei avid und seinen veröffentlichungen zu dnxhr um kein bischen besser...

inhaltlich ist die sache aber ohnehin klar.

raw-aufufzeichnungsformate haben grundsätzlich mehr ahnlichkeit mit einer s/w aufzeichnung bzw. enthalten nur einen kanal. dafür gibt's ein paar zusätzliche metadaten angaben, die festlegen, wie die farbige anordnung der sensel zu interpretieren ist, und ein paar faktoren betreffend weißabgleich und aussteuerung der einzelnen farben. der größte unterschied zu den klassischen videoufzeichnungsformaten besteht aber in der verteilung der aufgezeichneten werte. die kameras bzw. raw daten liegen ja normalerweise annähernd in linearer darstellung vor, was man normalerweise aber besser in log od. div. fließkomma darstellungen abspeichert, um eine gleichmäßigere verteilung bzw. bessere komprimierbarkeit zu erreichen. wenn man diese anpassung nicht richtig vornimmt od. beachtet -- also bspw. ProRes od. DNxHR im resolve als cache-format für ACES projekte einstellt od.ä. -- hat das fatale auswirkungen auf die resultierende qualität.

Antwort von Paralkar:

Welche sind diese? Also meinst du Timeline Color Space oder was genau?

Im Endeffekt muss er doch nur Linear in Rec 709 für die Cache Files umrechnen.

Antwort von WoWu:

Ich würde erst mal abwarten, was der Codec überhaupt transportiert denn wenn er nicht in der Kamera sitzt und das eigentliche Luminanzsognal des Sensors führt, sondern die de-mosaicten Prozesswerte, ist es nicht anderes, als ein neues Etikett, das alten Verfahren aufgedrückt wurde.

Also, erst mal abwarten, was da kommt.

Antwort von Paralkar:

Nein im White Paper steht schon undebayerte Raw Daten. Die Frage is wie sie die Komprimierung hinkriegen, ich schätze ganz stark Wavelet (steht nix drin), bei den Datenraten.

Ich denke Apple wird sich schon bei den Kameraherstellern erkundigt haben, obs Interesse gibt.

Hoffe das ganze kommt in die Alexas. Wäre doch mal schön komprimiertes Raw zu haben und Alternativ Arri Raw

Antwort von Jott:

Man könnte das Whitepaper lesen:

"ProRes RAW directly encodes the Bayer pattern image. Demosaicing and processing are deferred to the time of playback and are performed by application software."

ProRes Raw wird also - bis jetzt nur von DJI - direkt in der Kamera komprimiert (so wie Red das schon immer macht), oder ein externer Recorder (Atomos) komprimiert das, was aus dem Raw-Ausgang einer Kamera rauskommt. Atomos leistet dazu diverse gängige Modelle wie FS700 oder FS5, mit denen das klappt.

In beiden Fällen also nicht de-bayertes Raw. Das De-Bayering macht fcp x dann live bei der Wiedergabe, und gleich für mehrere Streams. Oder kann man das anderes lesen/interpretieren/verstehen?

Wavelet? Nö, Apple schreibt im Whitepaper von gleicher technischer Basis wie ProRes. Ebenso auf bestmögliche Performance hin entwickelt.

Antwort von nic:

Paralkar hat geschrieben:

Nein im White Paper steht schon undebayerte Raw Daten. Die Frage is wie sie die Komprimierung hinkriegen, ich schätze ganz stark Wavelet (steht nix drin), bei den Datenraten.

Ich denke Apple wird sich schon bei den Kameraherstellern erkundigt haben, obs Interesse gibt.

Hoffe das ganze kommt in die Alexas. Wäre doch mal schön komprimiertes Raw zu haben und Alternativ Arri Raw

DCT.

Antwort von cantsin:

Wollen wir wetten, dass Resolve 15 (das wahrscheinlich am Montag vorgestellt wird) ProRes RAW unterstützen wird - und dass zumindest Blackmagics neuere Kameras ProRes RAW per Firmwareupdate bekommen werden?

Blackmagic hat bisher alle ProRes-Codecs in seiner Hardware und Software implementiert und wird das hier wahrscheinlich schon lange in Zusammenarbeit mit Apple vorbereitet haben.

Antwort von Jott:

Da würde ich nicht gegenhalten wollen! :-)

Antwort von Alf_300:

@Cantsin

Du mußt viel Gekd haben

Von mir 10 Euro dagegen.

Antwort von WoWu:

cantsin hat geschrieben:

Wollen wir wetten, dass Resolve 15 (das wahrscheinlich am Montag vorgestellt wird) ProRes RAW unterstützen wird - und dass zumindest Blackmagics neuere Kameras ProRes RAW per Firmwareupdate bekommen werden?

Blackmagic hat bisher alle ProRes-Codecs in seiner Hardware und Software implementiert und wird das hier wahrscheinlich schon lange in Zusammenarbeit mit Apple vorbereitet haben.

Das kann ich mir auch gut vorstellen ... nur eine Schwalbe macht natürlich noch keinen Sommer ... und die Frage bleibt eben, was steckt drin, in dem „RAW“.

Antwort von Frank Glencairn:

Jott hat geschrieben:

In beiden Fällen also nicht de-bayertes Raw. Das De-Bayering macht fcp x dann live bei der Wiedergabe, und gleich für mehrere Streams. Oder kann man das anderes lesen/interpretieren/verstehen?

Ja, so schaut's aus.

Antwort von wolfgang:

cantsin hat geschrieben:

Wollen wir wetten, dass Resolve 15 (das wahrscheinlich am Montag vorgestellt wird) ProRes RAW unterstützen wird - und dass zumindest Blackmagics neuere Kameras ProRes RAW per Firmwareupdate bekommen werden?

Blackmagic hat bisher alle ProRes-Codecs in seiner Hardware und Software implementiert und wird das hier wahrscheinlich schon lange in Zusammenarbeit mit Apple vorbereitet haben.

Na ich hoffe stark dass Resolve 15 das kann. Denn ich will ja 5.7K ProRes Raw aus meinem Shogun Inferno verarbeiten können, und bisher wird lediglich gesagt dass dies nur FCP X können wird. Und damit wären Windows Anwender außen vor.

Antwort von cantsin:

wolfgang hat geschrieben:

Na ich hoffe stark dass Resolve 15 das kann. Denn ich will ja 5.7K ProRes Raw aus meinem Shogun Inferno verarbeiten können, und bisher wird lediglich gesagt dass dies nur FCP X können wird. Und damit wären Windows Anwender außen vor.

Als Canon sein proprietäres Canon RAW-Format mit der C200 brachte, unterstützte Resolve es eine Woche später per Softwareupdate. Würde mich wundern, wenn es hier anders laufen würde.

Antwort von DV_Chris:

Nachdem erstmal nur wenige Kamerabesitzer mit Shogun Inferno bzw Sumo das Format aufzeichnen werden können, könnte es durchaus sein, dass die Implementierung in anderen NLE nicht höchste Priorität hat.

Antwort von Jott:

Keine Panik.

Antwort von wolfgang:

DV_Chris hat geschrieben:

Nachdem erstmal nur wenige Kamerabesitzer mit Shogun Inferno bzw Sumo das Format aufzeichnen werden können, könnte es durchaus sein, dass die Implementierung in anderen NLE nicht höchste Priorität hat.

Na so wenige Kameras sind es nicht wo das mit Montag funktionieren wird. Inzwischen werden von Inferno ja etliche Kameras mit Raw Ausgabe unterstützt.

Antwort von Funless:

Ich spekuliere: April 2018 wird als „der Beginn von RAW Video für jedermann“ in die Geschichte eingehen.

Antwort von nic:

Funless hat geschrieben:

Ich spekuliere: April 2018 wird als „der Beginn von RAW Video für jedermann“ in die Geschichte eingehen.

War das nicht eher der Release der BMCC? Seitdem kann doch jeder in RAW drehen, wenn er nur will...

Antwort von cantsin:

7nic hat geschrieben:

Funless hat geschrieben:

Ich spekuliere: April 2018 wird als „der Beginn von RAW Video für jedermann“ in die Geschichte eingehen.

War das nicht eher der Release der BMCC? Seitdem kann doch jeder in RAW drehen, wenn er nur will...

Hardware-seitig ja. Software-seitig ist doch die Unterstützung von RAW in allen Mainstream-NLEs erstaunlich dürftig und lückenhaft geblieben.

Antwort von Frank Glencairn:

Also ich hätte das PrawRes genannt :-)

Antwort von nic:

cantsin hat geschrieben:

7nic hat geschrieben:

War das nicht eher der Release der BMCC? Seitdem kann doch jeder in RAW drehen, wenn er nur will...

Hardware-seitig ja. Software-seitig ist doch die Unterstützung von RAW in allen Mainstream-NLEs erstaunlich dürftig und lückenhaft geblieben.

Ich hätte nichts dagegen, wenn ProRes RAW das ‚poor man‘s redraw‘ werden würde. Ob das Potential dazu da ist, werden wir wohl nach der NAB wissen...

Antwort von nic:

"Frank Glencairn" hat geschrieben:

Also ich hätte das PrawRes genannt :-)

Ich eher ProRaw, Final Raw oder iRAW.

Antwort von cantsin:

7nic hat geschrieben:

Ich hätte nichts dagegen, wenn ProRes RAW das ‚poor man‘s redraw‘ werden würde. Ob das Potential dazu da ist, werden wir wohl nach der NAB wissen...

Von den großen Kameraherstellern (Sony, Canon, Panasonic, aber auch von Fuji, Nikon, Olympus) erwarte ich da nichts. Die haben in ihren Consumer- und Prosumerkameras noch nie ProRes (oder vergleichbar breitbandige Codecs angeboten) und werden es auch in naher Zukunft nicht tun.

Antwort von Funless:

cantsin hat geschrieben:

7nic hat geschrieben:

Ich hätte nichts dagegen, wenn ProRes RAW das ‚poor man‘s redraw‘ werden würde. Ob das Potential dazu da ist, werden wir wohl nach der NAB wissen...

Von den großen Kameraherstellern (Sony, Canon, Panasonic, aber auch von Fuji, Nikon, Olympus) erwarte ich da nichts. Die haben in ihren Consumer- und Prosumerkameras noch nie ProRes (oder vergleichbar breitbandige Codecs angeboten) und werden es auch in naher Zukunft nicht tun.

Brauchst auch nicht erwarten. Jede Wette, dass das nächste iPhone Videos in ProRes RAW aufzeichnen können wird. Und dann wird sich zeigen, wie lange die großen Kamerahersteller mit dem Nachziehen warten werden.

Wie gesagt, reine Spekulation meinerseits, aber irgendwie habe ich da so‘n Gefühl. ;-)

Antwort von nic:

cantsin hat geschrieben:

7nic hat geschrieben:

Ich hätte nichts dagegen, wenn ProRes RAW das ‚poor man‘s redraw‘ werden würde. Ob das Potential dazu da ist, werden wir wohl nach der NAB wissen...

Von den großen Kameraherstellern (Sony, Canon, Panasonic, aber auch von Fuji, Nikon, Olympus) erwarte ich da nichts. Die haben in ihren Consumer- und Prosumerkameras noch nie ProRes (oder vergleichbar breitbandige Codecs angeboten) und werden es auch in naher Zukunft nicht tun.

Panasonic ist über Atomos ja schon dabei. PRR ist die einzige Möglichkeit an das 5.7K Raw der EVA zu kommen. Sony ist im gleichen Zuge ja auch schon dabei. BMD ist ja sicher auch dabei...

Antwort von cantsin:

Funless hat geschrieben:

Jede Wette, dass das nächste iPhone Videos in ProRes RAW aufzeichnen können wird.

Da wette ich gegen Dich. Bei einer Datenrate von mehr als 1000 Mbit/s bei 4K reichen selbst 128MB freier interner Speicher gerade mal für eine Viertelstunde Aufzeichnung. Vor allem aber nützt RAW-Aufzeichnung beim Smartphone sehr wenig, weil da die Bildqualität nicht aus dem Rohsignal, sondern dem Hoch- und Schönrechnen der Signals in der Hardware kommt.

Antwort von cantsin:

7nic hat geschrieben:

Panasonic ist über Atomos ja schon dabei. PRR ist die einzige Möglichkeit an das 5.7K Raw der EVA zu kommen. Sony ist im gleichen Zuge ja auch schon dabei.

Ich hatte ja explizit von Consumer- und Prosumerkameras geschrieben, nicht von Kameras in der Güte- und Geldklasse von EVA & Co.

Antwort von nic:

cantsin hat geschrieben:

7nic hat geschrieben:

Panasonic ist über Atomos ja schon dabei. PRR ist die einzige Möglichkeit an das 5.7K Raw der EVA zu kommen. Sony ist im gleichen Zuge ja auch schon dabei.

Ich hatte ja explizit von Consumer- und Prosumerkameras geschrieben, nicht von Kameras in der Güte- und Geldklasse von EVA & Co.

Ist die EVA nicht prosumer?

Antwort von Funless:

7nic hat geschrieben:

Sony ist im gleichen Zuge ja auch schon dabei.

Am Montag ist ja die Sonys NAB PK und vielleicht sehen wir bei einer evtl. Ankündigung einer A7sIII dann auch ProResRAW Support via Atomos für das Gerät. Wer weiß? Sind ja alle hier unisono, dass Sony im DSLM Bereich irgendwas gegen die 10Bit intern der GH5/GH5s entgegensetzen muss.

cantsin hat geschrieben:

Funless hat geschrieben:

Jede Wette, dass das nächste iPhone Videos in ProRes RAW aufzeichnen können wird.

Da wette ich gegen Dich. Bei einer Datenrate von mehr als 1000 Mbit/s bei 4K reichen selbst 128MB freier interner Speicher gerade mal für eine Viertelstunde Aufzeichnung. Vor allem aber nützt RAW-Aufzeichnung beim Smartphone sehr wenig, weil da die Bildqualität nicht aus dem Rohsignal, sondern dem Hoch- und Schönrechnen der Signals in der Hardware kommt.

ProResRAW geht ja auch compressed wenn ich‘s nicht falsch verstanden habe. Apple setzt seit zwei iPhone Generationen immer größeren Schwerpunkt auf Kamerafeatures (die anderen Hersteller wie bspw. Samsung, etc. aktuell ja auch). Außerdem weiß keiner was nun die Hydrogen bringen wird. Und Marktanteile im Smartphone Markt sind hart umkämpft, so dass nicht davon auszugehen ist, dass Apple sich auf seinem Platzhirsch Status ausruhen wird.

Wie bereits oben gesagt, alles Spekulation von mir, bin kein Insider. Doch für mich persönlich würde es Sinn machen.

Antwort von cantsin:

Funless hat geschrieben:

Am Montag ist ja die Sonys NAB PK und vielleicht sehen wir bei einer evtl. Ankündigung einer A7sIII dann auch ProResRAW Support via Atomos für das Gerät. Wer weiß? Sind ja alle hier unisono, dass Sony im DSLM Bereich irgendwas gegen die 10Bit intern der GH5/GH5s entgegensetzen muss.

Niemals wird Sony einen Apple-Codec lizenzieren, die haben ihre eigenen Codecs.

cantsin hat geschrieben:

Da wette ich gegen Dich. Bei einer Datenrate von mehr als 1000 Mbit/s bei 4K reichen selbst 128MB freier interner Speicher gerade mal für eine Viertelstunde Aufzeichnung. Vor allem aber nützt RAW-Aufzeichnung beim Smartphone sehr wenig, weil da die Bildqualität nicht aus dem Rohsignal, sondern dem Hoch- und Schönrechnen der Signals in der Hardware kommt.

ProResRAW geht ja auch compressed wenn ich‘s nicht falsch verstanden habe.

Die genannten Bitraten sind bereits compressed und beziehen sich auf die Angaben in der Slashcam-Newsmeldung.

Apple setzt seit zwei iPhone Generationen immer größeren Schwerpunkt auf Kamerafeatures (die anderen Hersteller wie bspw. Samsung, etc. aktuell ja auch).

Ja, aber vor allem durch computational imaging - also Signalschönrechnung durch maximalen algorithmischen Aufwand. Das ist genau das Gegenteil von RAW.

Antwort von Jott:

cantsin hat geschrieben:

Bei einer Datenrate von mehr als 1000 Mbit/s bei 4K reichen selbst 128MB freier interner Speicher gerade mal für eine Viertelstunde Aufzeichnung.

Es ist etwa halb so viel bei ProRes raw. Also immerhin ein Stündchen 4K/25p auf 256 GB, was ja wohl das Mindeste wäre, wenn man so was mit einem Smartphone vorhätte. Und wenn‘s auch HD tut, sind’s gleich ein paar Stunden. Zudem pumpt das iPhone laufend Bilder und Videoclips in die Cloud und macht Speicher wieder frei. Soderbergh würde auch einen Hunderter drauflegen und eins mit 512 GB kaufen! :-)

Red will ja definitiv ein Handy mit Redraw bringen. So völlig aus der Luft gegriffen finde ich das daher gar nicht mit einem Raw-Edel-iPhone. Dass die Mini-Kameratechnik riesige Sprünge macht, ist ja wohl nicht abzustreiten. Vielleicht knallt ja Apple mit so was in den Markt, noch bevor Red in die Hufe kommt?

Keiner weiß, was es da für Roadmaps gibt. Ich find‘s spannend.

Antwort von cantsin:

7nic hat geschrieben:

Ist die EVA nicht prosumer?

Da haben wir unterschiedliche Begriffe von "Prosumer". Ich dachte dabei eher an Kameras wie die GH5/s, nicht an einen 7500-Euro-Body.

Antwort von cantsin:

Jott hat geschrieben:

cantsin hat geschrieben:

Bei einer Datenrate von mehr als 1000 Mbit/s bei 4K reichen selbst 128MB freier interner Speicher gerade mal für eine Viertelstunde Aufzeichnung.

Es ist etwa halb so viel bei ProRes raw.

Nein.

Apple spezifiziert die Datenrate von ProRes Raw im dazugehörigen White Paper als variabel zwischen der von ProRes HQ und der von ProRes 444.

Laut diesem anderen White Paper liegt die Datenrate von ProRes HQ bei 4K bei 754 Mbit/s (24fps) bzw. 943 Mbit/s (30fps) und die von ProRes 444 bei 1131 bzw. 1414 Mbit.

Also habe ich da noch zurückhaltend gerechnet.

Red will ja definitiv ein Handy mit Redraw bringen.

Stimmt so auch nicht. Es wird ein Handy mit anflaschbaren RedRaw-Kameramodul geben (so ähnlich, wie das als Fotokamera die DxO One macht), aber kein Raw-Recording im Handy selbst.

Antwort von Jott:

Da kursieren verschiedene Stories und Vermutungen. Facts gibt es noch keine.

Ist ja auch egal. Die Welt hat andere Probleme.

ProRes Raw liegt übrigens variabel zwischen 422 und HQ. Du musst schon richtig lesen. Du nennst die Werte von ProRes Raw HQ, der High End-Variante, was in einem Handy nun wirklich Schwachsinn wäre.

Antwort von cantsin:

Jott hat geschrieben:

ProRes Raw liegt übrigens variabel zwischen 422 und HQ. Du musst schon richtig lesen. Du nennst die Werte von ProRes Raw HQ, der High End-Variante, was in einem Handy nun wirklich Schwachsinn wäre.

Da hast Du in der Tat recht und ich nehme meinen Punkt zurück.

Werde aber meine Wette gegen Alf gewinnen. Blackmagic wird eine neue 4K Pocket vorstellen, und Resolve 15. Beide höchstwahrscheinlich mit ProRes RAW. Blackmagics Betatester/Influencer John Brawley sagt, dass er (wohl wegen NDA) noch nicht viel sagen kann, bestätigt aber sowohl die Echtheit des 4K-Pocket-Plakats, als auch das folgende: "I’ve seen iterations of working with ProRes with the same controls you get with shooting any RAW format in the way we all would understand a real RAW format to work. Umm..so its’ actually awesome. I mostly shoot ProRes these days anyway and now ProRes will be even better :-)"

Antwort von Funless:

Und wenn die BMPCC4K so um die 1.000 - 1.500 Euro kosten sollte plus die PRR Implentierung in Resolve 15 (also auch für die Windows Welt), liege ich doch mit meiner spekulativen Vorhersage „RAW Video für Jedermann“ gar nicht mal so verkehrt. :-)

Antwort von WoWu:

„I mostly shoot ProRes these days anyway and now ProRes will be even better :-)"

Das ist ja nun auch nicht besonders schwer.

Den meisten Distributionscodecs fällt das ja noch nicht mal schwer.

Daher sagt das noch nichts über die effektive Qualität aus.

Antwort von cantsin:

Funless hat geschrieben:

Und wenn die BMPCC4K so um die 1.000 - 1.500 Euro kosten sollte plus die PRR Implentierung in Resolve 15 (also auch für die Windows Welt), liege ich doch mit meiner spekulativen Vorhersage „RAW Video für Jedermann“ gar nicht mal so verkehrt. :-)

Nur, dass sich da eigentlich nicht soviel ggü. früher verändert hat. Die erste Pocket ist seit 2013 für 1000 EUR auf dem Markt, und schneiden kann man mit Resolve schon seit Version 11, die 2014 'rauskam.

"RAW Video für Jedermann" wäre dann doch eher Raw-Video in unter-2500-Euro-Kameras, die à la GH5, A7 oder XC10 Autofocus, Stabilisierung, brauchbare interne Mikrofone und lange Batterielaufzeit mitbringen und keine IR-Cut-Filter brauchen - und was sich dann anschließend problemlos in Premiere, FCPX & Co. schneiden lässt inkl. einfacher Einstellungsmenüs für Raw-Bildparameter (wie Weißabgleich und Gain).

Antwort von WoWu:

Vielleicht überraschen sie uns ja alle und führen eine vectorbasierte Compression der RAW Signale ein.

Das wäre allerdings der „Durchbruch“ für ein „RAW für Jedermann“ und der erste Schritt zu einem Umdenken in Sachen Kompression.

Wir werden es sehen. Die Datenraten wären dafür schon mal richtig.

Antwort von Funless:

Eben, warten wir ab und harren der Dinge die da kommen. Interessant finde ich es allemal.

Antwort von Axel:

Apple hätte wenig davon, PRR gegen eine bescheidene Gebühr unter‘s Volk zu bringen. Da dieses hier so eine Art Vorhersage-Wette wird, hier meine: PRR wird nichts welterschütternd Neues, nur eine Art aufgebohrtes Cineform Raw mit etwas schlankeren Datenraten. Es wird für wenigstens ein Jahr nicht auf Resolve verfügbar sein und deswegen wohl auch nicht auf BM Kameras. Denn die sind, wie cantsin sehr richtig sagte, das „Raw für jedermann“. Nicht allein durch CDNG auf ihren günstigen Kameras, sondern durch die Software, das „Ökosystem“. Das will FCP jetzt auch schaffen, mit einem alternativen Ansatz.

Antwort von Jott:

Wieso vermutet ihr Wavelet oder gar irgend eine fancy Vectorkompression?

Im Whitepaper steht doch, dass es ProRes ist wie gehabt, nur eben auf „Bayerpixel“ angewandt. Luminanz plus Metadaten. Es geht Apple ja um Speed, damit werben sie, 8 Raw-Streams realtime in fcp x de-bayert bla bla.

Dafür spricht ja auch, dass die Implementierung von ProRes Raw für DJI und Atomos ein simples Firmware-Update ist. Müsste auch bedeuten, dass jeder andere Kamerahersteller, der bisher schon ProRes anbietet - also praktisch alle - ebenfalls problemlos mitspielen könnte.

Der NAB-Pressetag naht.

Antwort von Frank Glencairn:

Interresant

Antwort von cantsin:

"Frank Glencairn" hat geschrieben:

Interresant

Eigentlich sagt er durch die Blume, dass CinemaDNG als Standard wegen seiner Usability und mangelhaften Unterstützung gescheitert ist, und dass die Initiative für ProRes Raw nicht von Apple, sondern von Atomos ausging.

Antwort von Frank Glencairn:

Was CinemaDNG betrifft, redet er ein bisschen einen Schmarrn, was verständlich ist, er will ja gerade ein Konkurrenzprodukt etablieren, deshalb kann man ihm das nachsehen. Und ja, sieht so aus, als ob nicht Apple sondern Atomos die Idee hatten.

Antwort von nic:

"Frank Glencairn" hat geschrieben:

Was CinemaDNG betrifft, redet er ein bisschen einen Schmarrn, was verständlich ist, er will ja gerade ein Konkurrenzprodukt etablieren, deshalb kann man ihm das nachsehen. Und ja, sieht so aus, als ob nicht Apple sondern Atomos die Idee hatten.

CDNG ist schon ein Kack und hat alle Erwartungen massiv untertroffen.

Antwort von Frank Glencairn:

Hä? Welche "Erwartungen"?

Antwort von wolfgang:

"Frank Glencairn" hat geschrieben:

Was CinemaDNG betrifft, redet er ein bisschen einen Schmarrn, was verständlich ist, er will ja gerade ein Konkurrenzprodukt etablieren, deshalb kann man ihm das nachsehen. Und ja, sieht so aus, als ob nicht Apple sondern Atomos die Idee hatten.

Und damit sind die Windows Anwender mal wieder draußen, zumindest nach heutigem Stand. Na vielleicht hilft Resolve 15.

Antwort von nic:

"Frank Glencairn" hat geschrieben:

Hä? Welche "Erwartungen"?

Dass sich ein sinnvoller compressed raw-Standard entwickeln könnte, der sich auf allen gängigen NLEs ordentlich verarbeiten lässt.

Antwort von Frank Glencairn:

Da musst du dich beim NLE Hersteller deines Vertrauens beklagen, wobei das bei Adobe ja extrem bizarr ist, daß die sich weigern ihr eigenes Format vernünftig zu unterstützen.

Antwort von rush:

"Frank Glencairn" hat geschrieben:

Was CinemaDNG betrifft, redet er ein bisschen einen Schmarrn, was verständlich ist, er will ja gerade ein Konkurrenzprodukt etablieren, deshalb kann man ihm das nachsehen.

Dann mal Butter bei die Fische... welcher Hersteller bietet denn CDNG in seinem aktuellen Kamera-Portfolio? Da bleiben neben Blackmagic nur noch eine Hand voll übrig... und einige Hersteller davon existieren heute doch de facto gar nicht mehr beim Blick auf Wikipedia... vielleicht noch die Weisscam... aber die anderen dort aufgeführten? Eher in der Versenkung versunken :D https://de.wikipedia.org/wiki/CinemaDNG

Der Rest sind eher die paar Rekorder-Hersteller die hier und da auch mal CDNG anbieten um überhaupt von sich Rede zu machen und dem Kunden was anbieten müssen...

Ein wirklicher Standard hat sich daraus leider nicht etabliert.

Irgendwie schwimmen doch alle viel lieber in Ihrer eigene Soße mit popraritären RAW-Formaten... egal ob Arri, RED, Kinefinety, Sony und wie sie alle heißen.

Ob da ProRes RAW was dran ändern wird? Ich bin eher skeptisch... aber wünschenswert wäre ein etwas breiter aufgesteller Standard ja schon, auch die für Hersteller von NLE's, Gradinggedöns und Co...

Antwort von nic:

"Frank Glencairn" hat geschrieben:

Da musst du dich beim NLE Hersteller deines Vertrauens beklagen, wobei das bei Adobe ja extrem bizarr ist, daß die sich weigern ihr eigenes Format vernünftig zu unterstützen.

Alleine die Idee auf Einzelbilder in Ordnern zurückzugreifen macht das Format auf Dateiebene unsinnig langsam und umständlich.

Antwort von cantsin:

7nic hat geschrieben:

"Frank Glencairn" hat geschrieben:

Hä? Welche "Erwartungen"?

Dass sich ein sinnvoller compressed raw-Standard entwickeln könnte, der sich auf allen gängigen NLEs ordentlich verarbeiten lässt.

Ich wüsste nicht, was im CinemaDNG-Standard fehlt, ausser dass die Ordner-/Einzelframestruktur ein Usability-Problem ist, dass man sehr einfach durch einen tar- oder zip-Container lösen könnte, wodurch die Äquivalenz von Clip und Datei wiederhergestellt wäre.

Das echte Problem ist doch, dass CinemaDNG von den großen Softwareanbietern stiefmütterlich behandelt wird, allen voran vom Erfinder des Formats, Adobe. Es ist unbegreiflich, warum man die Adobe Camera Raw-Parameter von CinemaDNG-Aufnahme zwar in Lightroom einstellen kann, aber nicht bzw. nur äußerst rudimentär in Premiere.

Man könnte da Verschwörungstheorien entwickeln, weil CinemaDNG von den großen Kameraherstellern links liegen gelassen und nur von den Spezial- und Nischenanbietern implementiert wurde. Die Hoffnung ist wohl, dass mit ProRes RAW endlich eine Mainstream-Lösung für RAW-Video kommt.

Antwort von wolfgang:

7nic hat geschrieben:

"Frank Glencairn" hat geschrieben:

Hä? Welche "Erwartungen"?

Dass sich ein sinnvoller compressed raw-Standard entwickeln könnte, der sich auf allen gängigen NLEs ordentlich verarbeiten lässt.

Was eine nette Vision ist.

Antwort von Frank Glencairn:

7nic hat geschrieben:

Alleine die Idee auf Einzelbilder in Ordnern zurückzugreifen macht das Format auf Dateiebene unsinnig langsam und umständlich.

Etwas langsamer beim kopieren - okay, läßt sich aber durch Plattenoptimierung immerhin ein bisschen beschleunigen - der Unterschied zwischen DNG Ordner kopieren und Clip kopieren ist definitiv da, aber so klein, daß er für mich kein Dealbreaker ist. Läuft sowieso im Hintergrund, während ich was anderes arbeite.

Aber ob ich einen Ordner mit Einzelbildern, Ton- und Metadaten drin anfasse und irgendwo hin schiebe, oder einen Clip, macht nun wirklich keinen Unterschied. Is ja sowieso nur eine Desktop Metapher - unter dem .mov Symbol befinden sich ja auch nur Einzelbilder, du kommst nur nicht dran, weil sie in dem Container verpackt sind. In der NLE macht es sowieso keinen Unterschied, die DNGs tauchen auf wie ganz normale Clips.

rush hat geschrieben:

Dann mal Butter bei die Fische... welcher Hersteller bietet denn CDNG in seinem aktuellen Kamera-Portfolio? .

Ein wirklicher Standard hat sich daraus leider nicht etabliert.

..

Naja - das sind dann immerhin um die 10-12 Kameras (und ein paar Recorder)

Wie viel Kameras können ProRes schreiben? Ungefähr genauso viel - nach deiner Logik wäre also ProRes

auch kein wirklich etablierter Standard.

Antwort von WoWu:

Wobei der Atomos Mann ja auch auf das eigentliche Problem im Hinblick auf DNG hingewiesen hat und sagt, dass es keinen Sinn macht, ein Video-Signal zu verarbeiten.

Denn die alte Frage ist ja, ist eine codierung in DNG noch RAW. Er beantwortet das in dem Interview eher mit NEIN denn er weist direkt darauf hin, dass PRR ein Sensorsignal enthält, das nicht in Frame-Formatierung vorliegt sondern in individuellen Pixelpaketen, losgelöst von Frameformaten.

Das deutet ja eigentlich darauf hin, dass wir es mit soetwas wie einem echten RAW zu tun haben.

Und genau das war auch für mich der schwächste Punkt von DNG, weil es eigentlich nur ein flaches Videoformat mit geringer Kompression war.

Ich bin mal gespannt, was da herauskommt denn Zeit wäre es, ein neues Format zu etablieren.

Und wenn es sich tatsächlich um ein Vectorformat handelt, bin ich mal auf Sony gespannt, weil die ja ebenso auf diesen „Zug“ setzen.

Antwort von Peppermintpost:

ich hab den Beitrag ja nicht kompl gelesen, evtl ist das was ich schreibe obsolet, aber mir scheint die grösste "Krücke" am ProRes (egal welche Geschmacksrichtung) das es halt unter Windows nicht durchgängig funktioniert. Ich habe weil ich immer mehr auf Windows mache und grosser ProRes Fan bin Mirazon ProRes installiert und bis jetzt scheint es auch gut zu funktionieren. Es gibt natürlich auch einige Software die ProRes Schreiben kann, aber grundsätzlich finde ich ist es der Job von Apple das mal einheitlich für alle Plattformen zur Verfügung zu stellen.

Antwort von Frank Glencairn:

Vor allem in 64bit

Antwort von WoWu:

Das Problem, und darin liegt der Unterschied in „Standards“ besteht darin, dass dazu ein Format festgeschrieben wird und mit einer Referenzimplementierung dokumentiert wird.

Dann können sich alle Hersteller daran halten und sind sicher, das 100% Kompatibilität entsteht und das ganze nicht schon wieder (nach der nächsten Modifizierung seitens des Codechetstellers) Anpassungen erforderlich werden.

Das ist auch das Problem der freien „Standards“.

Insofern wäre Apples Sache gewesen, es z.B. von der SMPTE standardisieren zu lassen. Dann wäre eine platformübergreifende Akzeptanz eher gegeben.

Aber Apple hat ja ganz bewusst den Codec proprietären gehalten, um die eigene Platform zu stärken.

Da wundert es niemanden, dass viele Hersteller nicht mit fliegenden Fahnen mitmachen.

Antwort von Jott:

Stimmt, da macht kaum einer mit. Außer dieser Handvoll unbekannter Firmen vielleicht:

https://support.apple.com/de-de/HT200321

Wowu mal wieder im Kreuzzug-Modus! :-)

Antwort von R S K:

WoWu hat geschrieben:

Dann wird sich vermutlich auch die Frage stellen, wo die vermeintlichen Vorteile zu eigenen Kamers-RAW Formaten liegen.

Die Stichworte heißen Performance und Datenrate und Kamera-Hersteller unabhängig, insofern lizensiert und keine Transcodierung um überhaupt damit (mit multiplen Streams!) arbeiten zu können und Performance… ach ja und Performance.

Das mit der Unabhängigkeit reicht mir schon. Und ich denke über kurz oder lang wird keiner drumrum kommen es in der einen oder anderen Form zu implementieren, insofern die hardware es grundsätzlich hergibt.

Z.B. eine Shogun kann cDNG in 4K gerade mal mit 30p aufzeichnen. In ProRes raw… mit 60p.

WoWu hat geschrieben:

Nicht umsonst hat sich DNG nicht durchgesetzt.

Genau. Deswegen weil es nicht von einem Kamerahersteller kam. Nicht weil es eine halb gare Anpassung eines Formats war/ist, was eigentlich für Bilder gedacht war, gar nicht für Bewegtbilder. Dementsprechend auch unerträglich in der Benutzung, Verwaltung und Performance ist. Nee. Deswegen nicht. 😏

Beide überhaupt vom Grundsatz her vergleichen zu wollen ist allein schon ziemlich… ach, egal.

WoWu hat geschrieben:

Da wundert es niemanden, dass viele Hersteller nicht mit fliegenden Fahnen mitmachen.

Gut erkannt. Weshalb auch absolut niemand die sechs anderen Geschmacksrichtungen von ProRes übernommen hat, richtig? So unfassbar wichtig ist ihnen die Standardisierung. 👍🏼

cantsin hat geschrieben:

Niemals wird Sony einen Apple-Codec lizenzieren, die haben ihre eigenen Codecs.

Genau! Die FS7, FS5 und und und und und machen es schon seit 2014 illegal!

😄😄😄

- RK

Antwort von Frank Glencairn:

"R S K" hat geschrieben:

..Nicht weil es eine halb gare Anpassung eines Formats war/ist, was eigentlich für Bilder gedacht war, gar nicht für Bewegtbilder.

Ach deswegen heißt es CINEMA-DIGITAL-NEGATIVE, weil es nicht für "Bewegtbilder" gedacht ist.

Kopfschüttel

Antwort von R S K:

"Frank Glencairn" hat geschrieben:

Ach deswegen heißt es CINEMA-DIGITAL-NEGATIVE, weil es nicht für "Bewegtbilder" gedacht ist.

:-))))

Au weia.

"Frank Glencairn" hat geschrieben:

Kopfschüttel

Allerdings.

Antwort von nic:

CDNG ist ganz klar ein RAW-Format... die Möglichkeit RGB-Werte je Pixel aufzuzeichnen ist für Foveon und 3-chipper gedacht. Ansonsten speichert es nur Sensordaten im Bezug auf ein color filter array.

Antwort von PowerMac:

Cinema DNG ist scheisse. Hat schonmal jemand probiert, 20 TB davon auf LTO-Band zu archivieren? Die kleinen Dateien und dann Tausende davon sind ein Graus. Die LTO-Archivierung dauert fünf bis zehnmal so lange, wie man bei der Dateigröße annehmen könnte.

Antwort von R S K:

PowerMac hat geschrieben:

Cinema DNG ist scheisse.

Auf den Punkt gebracht. :-)))

Habe mal eine ca. 2 Minuten Sequenz, vielleicht auch etwas länger, in FCP laden wollen. Hat sage und schreibe 22 Minuten gebraucht. Scheisse ist gar kein Ausdruck.

Ach, und bevor sich jemand hämisch, lechzend draufstürzt, habe die gleiche Sequenz in PPro importiert... wo es doch von Adobe ist, war ich mir sicher ich würde neidisch werden... 28 Minuten.

[Edit: Habe es auf den „ersichtlichen” Weg gemacht. Wenn es einen anderen, besseren Weg gibt, super. Dieser ist dann aber wohl nicht gerade ersichtlich)

Warum auch immer, haben es sowohl Motion als auch After Effects wiederum in zwei Klicks als einzelnen Clip importiert. Nicht mal einen Balken. Versteh wer will. Ich muss es nicht. cDNG ist für mich gestorben. ProRes raw FTW.

- RK

Antwort von cantsin:

"R S K" hat geschrieben:

Warum auch immer, haben es sowohl Motion als auch After Effects wiederum in zwei Klicks als einzelnen Clip importiert. Nicht mal einen Balken. Versteh wer will. Ich muss es nicht.

Na, ist doch einfach. Dein Beispiel zeigt doch, dass die Performance nicht an cDNG liegt, sondern an dessen durchwachsener Software-Unterstützung, die schon an Boykott grenzt. Adobe signalisiert ja sozusagen mit dem Zaunpfahl, cDNG nur als Motion Graphics-, nicht aber als Mainstream-Videoformat zu akzeptieren.

Mich würde nicht wundern, wenn es da Mauscheleien bzw. vertragliche Absprachen zwischen den großen NLE-Herstellern und den großen japanischen Kameraherstellern gab, die nicht wollten, dass Blackmagic ihnen den Markt versaut. Wozu ja auch dann die Tatsache passt, dass Blackmagic sein eigenes Resolve (wohl aus Not) zum NLE mit vorbildlicher cDNG-Unterstützung ausgebaut hat.

Antwort von Axel:

"R S K" hat geschrieben:

Habe mal eine ca. 2 Minuten Sequenz, vielleicht auch etwas länger, in FCP laden wollen. Hat sage und schreibe 22 Minuten gebraucht. Mehr muss ich nicht sagen. Scheisse ist gar kein Ausdruck.

Ach, und bevor sich jemand hämisch, lechzend draufstürzt... habe die gleiche Sequenz in PPro importiert... wo es doch von Adobe ist, war ich mir sicher ich würde neidisch werden... 28 Minuten! UPS.

CDNGs werden in Premiere wie in Resolve als Clips und nicht als Sequenz importiert, wenn man statt über cmd+i über den Mini-Explorer des Medienbrowser (oder wie das heißt) unten links geht. Importzeit: Sekundenbruchteile, Performance gefühlt etwas schlechter als in Resolve.

Antwort von R S K:

Interessiert mich auch wie gesagt nicht die Bohne. ProRes raw FTW.

Antwort von Frank Glencairn:

"R S K" hat geschrieben:

Habe mal eine ca. 2 Minuten Sequenz, vielleicht auch etwas länger, in FCP laden wollen. Hat sage und schreibe 22 Minuten gebraucht.

So ist es halt, wenn man mit einem Messer zu einer Schießerei kommt.

"R S K" hat geschrieben:

Ach, und bevor sich jemand hämisch, lechzend draufstürzt... habe die gleiche Sequenz in PPro importiert... wo es doch von Adobe ist, war ich mir sicher ich würde neidisch werden... 28 Minuten! UPS.

..und wenn du nicht zu ignorant wärst, hätte der Import in PP nur ne Sekunde gedauert, wie in Resolve auch.

Aber Hauptsache erst mal ne große Klappe, und sich großmäulig hier vor allem zum Horst machen - gratuliere.

Antwort von R S K:

😂😂😂

Danke für's vormachen.

So armselig.

Antwort von wolfgang:

Was mich mehr als die große Klappe von irgendwem stört ist, dass mit ProRes RAW mal wieder schlagartig alle Windows Anwender von dem Material ausgeschlossen worden sind. Vielleicht ist das gleich am Montag mit Resolve 15 anders. Aber da kaufst dir eine EVA1, auch wegen der Ankündigung dass die 5.7K raw ausgibt. Dann wartest fast ein halbes Jahr darauf. Und dann kommen Atomos und Panasonic und innovieren ProRes RAW welches erst wieder für Windowsnutzer nicht verwendbar ist. Warten wir also wieder ein halbes Jahr um zu sehen, ob das unsere anderen Applikationen auch können werden. :(

Da kommt man sich schon über den Tisch gezogen vor. Denn von einer Einschränkung, dass 5.6K RAW nur der Mac Welt zu Verfügung stehen wird, war ja nie die Rede.

Antwort von Frank Glencairn:

Ist das eigentlich sicher?

Jede andere ProRes Variante ist doch auch auf Win problemlos lesbar

Antwort von cantsin:

"Frank Glencairn" hat geschrieben:

Ist das eigentlich sicher?

Jede andere ProRes Variante ist doch auch auf Win problemlos lesbar

Ich sehe da auch keine Einschränkungen, denn ProRes kann man ja unter Windows vor allem nicht schreiben/exportieren. Dass ist bei ProRes Raw aber irrelevant. Und Hersteller wie Atomos und DJI würden niemals auf ProRes Raw setzen, wenn das eine Mac-only-Lösung wäre.

Antwort von R S K:

"Frank Glencairn" hat geschrieben:

Ist das eigentlich sicher?

Im Moment, ja. FCP X wird ab morgen bis auf weiteres die einzige App sein die PR raw lesen/bearbeiten kann. Allerdings anzunehmen, dass Apple nicht an eine größtmögliche Verbreitung interessiert ist wäre natürlich Mumpitz. Resolve beispielsweise wird wahrscheinlich in üblicher Manier mit die erste App sein die es kann. In Wochen wenn nicht Tagen.

- RK

Antwort von motiongroup:

Klar ist das Geseire Mumpitz denn hätten die Entwickler eine Lizenz von Apple dafür geordert wäre es auch unter Windows kein Problem gewesen...

Wie viele NLE Hersteller gibt es die für spezielle Codec extra Lizenkosten von den Kunden einfordern..

Antwort von R S K:

motiongroup hat geschrieben:

Klar ist das Geseire Mumpitz denn hätten die Entwickler eine Lizenz von Apple dafür geordert wäre es auch unter Windows kein Problem gewesen...

Jepp. Zu behaupten der Export anderer ProRes Formate unter Windows ist per se nicht möglich ist natürlich völliger Unsinn.

- RK

Antwort von wolfgang:

Stand heute ist das von mir gepostet sicher, und wurde sowohl vom Produktmanager Panasonic Mitch Gross wie auch von Atomos Stephan Kexel auf Facebook bestätigt. Unmittelbar geht das nur mit FCP X.

VIELLEICHT unterstützt ja das kommende Resolve 15 auch in der Windows-Welt das neue ProRes RAW. Sonst wird’s wohl eher unmittelbar eng.

Vom Export spricht zunächst noch niemand, sondern zunächst mal vom Import und der Verarbeitung.

Antwort von Jott:

wolfgang hat geschrieben:

Vom Export spricht zunächst noch niemand

Auch in Zukunft nicht, da völlig sinnbefreit.

Antwort von nic:

wolfgang hat geschrieben:

Stand heute ist das von mir gepostet sicher, und wurde sowohl vom Produktmanager Panasonic Mitch Gross wie auch von Atomos Stephan Kexel auf Facebook bestätigt. Unmittelbar geht das nur mit FCP X.

VIELLEICHT unterstützt ja das kommende Resolve 15 auch in der Windows-Welt das neue ProRes RAW. Sonst wird’s wohl eher unmittelbar eng.

Vom Export spricht zunächst noch niemand, sondern zunächst mal vom Import und der Verarbeitung.

Mitch Gross sagt prinzipiell nichts zu den Strategien anderer Firmen. Dass er sich dir gegenüber aus dem Fenster lehnt, wage ich zu bezweifeln.

Er bestätigt vielleicht, dass bisher niemand sonst den Support angekündigt hat - dass es niemand wird, sicher nicht.

Antwort von R S K:

Weil H.264, DNG und und und und vor ihrem eigentlich Release schon von allem und jeden Unterstütz wurden? Die Logik darf gerne mal einer erklären.

BMD kam bisher auch „erst” 2-3 Tage NACH einem Release mit einem Update mit Unterstützung für neue FCPXML Versionen raus, was es im übrigen diesmal auch geben wird. Den Zynismus sollte man sich also vielleicht erstmal aufsparen für die nächste Apple Meldung, oder zumindest den eigentlichen Release? Auch wenn das hier ein pathologischer Zwang für mache ist.

- RK

Antwort von wolfgang:

7nic hat geschrieben:

wolfgang hat geschrieben:

Stand heute ist das von mir gepostet sicher, und wurde sowohl vom Produktmanager Panasonic Mitch Gross wie auch von Atomos Stephan Kexel auf Facebook bestätigt. Unmittelbar geht das nur mit FCP X.

VIELLEICHT unterstützt ja das kommende Resolve 15 auch in der Windows-Welt das neue ProRes RAW. Sonst wird’s wohl eher unmittelbar eng.

Vom Export spricht zunächst noch niemand, sondern zunächst mal vom Import und der Verarbeitung.

Mitch Gross sagt prinzipiell nichts zu den Strategien anderer Firmen. Dass er sich dir gegenüber aus dem Fenster lehnt, wage ich zu bezweifeln.

Ich sagte im ersten Posting nichts über die Strategie anderer Firmen. Aber die Bestätigung liegt vor dass 5.7K nur zu ProRes RAW im Atomos Sumo/Shogun Inferno aufgenommen wird. Und dass die Verarbeitung nicht in Applikationen erfolgen kann die ProRes verarbeiten können, sondern Stand Heute nur in FCP X.

Kannst gerne auf Facebook nachlesen, bist ja in den entsprechenden Gruppen drinnen.

Und es geht gar nicht mal gegen Apple - sondern das ist aus Sicht des EVA1 Users mit Windows Anwendungen primär ein Panasonic Thema. Die 5.7K versprechen und dann in der Business to Business Abstimmung ganz offensichtlich zustimmen dass die nur in ProRes RAW aufgezeichnet wird. Mit entsprechenden Konsequenten für Windows User.

Wie gesagt, wenn wenigstens Resolve 15 Studio das kurzfristig unterstützt entspannt sich das ein wenig. Hoffentlich.

Antwort von wolfgang:

Ach ja, und von „pathologischen Zwängen“ würde ich nach einiger deiner Postings hier an deiner Stelle weniger sprechen. ;)

Antwort von R S K:

ist scheinbar auch viel zu viel verlangt einfach mal auf den Release zu warten und der Sache auch nur EINE WOCHE zu geben. Als ob irgendjemand dich MORGEN dazu zwingen wird mit einer Atomos 5.7K in PR raw aufzuzeichnen. Es gibt ja auch keine Alternativen. Die verschwinden auch mit dem Update. So mächtig ist Apple. 😄

BMD ist im übrigen ganz offensichtlich auf dem Beta-Team. Die wissen schon was, ob, wann passiert was das angeht. Die wollen es vermutlich auch nur für v15 aufsparen um es für sich PR-technisch zu melken. Dass sie PR raw über kurz oder lang unterstützen werden steht denke völlig ausser Frage.

- RK

Antwort von wolfgang:

Merkst du eigentlich selbst noch was du da für einen Unsinn schreibst?

Antwort von R S K:

Nimmst mir die Worte aus dem Mund.

Antwort von nic:

wolfgang hat geschrieben:

7nic hat geschrieben:

Mitch Gross sagt prinzipiell nichts zu den Strategien anderer Firmen. Dass er sich dir gegenüber aus dem Fenster lehnt, wage ich zu bezweifeln.

Ich sagte im ersten Posting nichts über die Strategie anderer Firmen. Aber die Bestätigung liegt vor dass 5.7K nur zu ProRes RAW im Atomos Sumo/Shogun Inferno aufgenommen wird. Und dass die Verarbeitung nicht in Applikationen erfolgen kann die ProRes verarbeiten können, sondern Stand Heute nur in FCP X.

Kannst gerne auf Facebook nachlesen, bist ja in den entsprechenden Gruppen drinnen.

Und es geht gar nicht mal gegen Apple - sondern das ist aus Sicht des EVA1 Users mit Windows Anwendungen primär ein Panasonic Thema. Die 5.7K versprechen und dann in der Business to Business Abstimmung ganz offensichtlich zustimmen dass die nur in ProRes RAW aufgezeichnet wird. Mit entsprechenden Konsequenten für Windows User.

Wie gesagt, wenn wenigstens Resolve 15 Studio das kurzfristig unterstützt entspannt sich das ein wenig. Hoffentlich.

Es gibt momentan einfach kein RAW-Format, das die 5.7K der EVA wegspeichern kann. Technisch möglich wäre das nur mit r3d. Panasonic hat von Anfang an mit offenen Karten gespielt: Sie werden die 5.7K RAW bis zum SDI-Port bringen, alles danach ist Sache der externen Rekorderhersteller. Und war bis dato Spekulation. Dass das nicht mit CDNG passieren wird und nicht von heute auf morgen geht, war mir klar. PRR ist für mich eine Überraschung und es freut mich, dass Apple wieder Interesse am professionelleren Videomarkt zeigt. FCP ist wieder da. Der iMac Pro ist ordentlich geworden. CUDA kommt. Ein neuer MacPro ist in Arbeit... Apple wird die Tür durch eine künstliche Beschränkung von PRR auf FCPX nicht wieder zuschlagen. Die kommen um zu bleiben.

|

Antwort von Jott:

Was ist denn die Panik mit der EVA? Die gibt jetzt raw aus, fein, aber es ist doch egal, wie und womit man das abgreift? Muss doch nicht das plötzlich unerwartet aufgetauchte ProRes raw sein? Oder doch? Das würde dann aber bedeuten, dass die EVA bisher auf gut Glück gekauft wurde, ohne zu wissen, was man mit dem raw-Ausgang anfangen soll? Also gezockt? Ich versteh‘s nicht, muss ich aber auch nicht.

Antwort von R S K:

Jott hat geschrieben:

… es ist doch egal, wie und womit man das abgreift? Muss doch nicht das plötzlich aufgetauchte ProRes raw sein?

Mein Reden. Danke. Aber… ist ja UNSINN! Wie kannst du nur. ;-P

Hauptsache aufgeregt. Wie immer. 💤

- RK

Antwort von wolfgang:

Nachdem raw nicht definiert ist, sind viele Lösungen denkbar. Mir hätte es etwa schon gereicht wenn man das Material in den Rekordern in herkömmlichen ProRes abgelegt hätte.

im Produktfolder von Panasonic steht nur unter raw Output Format 5.7 raw mit späterem Firmware Update. Und mit keiner Einschränkung auf die Mac Welt.

Das Versprechen, raw 5.7K mit Ende März zu liefern, wurde daher nicht eingehalten. Denn es ist nicht geliefert wenn man es nicht nutzen kann obwohl man die im Vorfeld genannte Hardware hat (EVA1 und Shogun Inferno).

Antwort von wolfgang:

Jott hat geschrieben:

Was ist denn die Panik mit der EVA? Die gibt jetzt raw aus, fein, aber es ist doch egal, wie und womit man das abgreift? Muss doch nicht das plötzlich unerwartet aufgetauchte ProRes raw sein? Oder doch?

Es ist erst seit zwei Tagen klar dass es ProRes RAW bei 5.7K sein MUSS. Die Dauerei ist eben dass das vorher nicht gesagt worden ist.

Und es gibt bisher keine andere Möglichkeit das raw einer EVA1 „abzugreifen“ wie du es nennst. Denn das geht nur wenn der Kamerahersteller an Third Parties die erforderlichen Daten liefert oder selbst Rekorder baut. Das ist kein freier Markt sondern ein kleines Oligopol.

Antwort von nic:

wolfgang hat geschrieben:

Nachdem raw nicht definiert ist, sind viele Lösungen denkbar. Mir hätte es etwa schon gereicht wenn man das Material in den Rekordern in herkömmlichen ProRes abgelegt hätte.

im Produktfolder von Panasonic steht nur unter raw Output Format 5.7 raw mit späterem Firmware Update. Und mit keiner Einschränkung auf die Mac Welt.

Das Versprechen, raw 5.7K mit Ende März zu liefern, wurde daher nicht eingehalten. Denn es ist nicht geliefert wenn man es nicht nutzen kann obwohl man die im Vorfeld genannte Hardware hat (EVA1 und Shogun Inferno).

Wenn du den RAW Output in ProRes debayerst, hast du kein RAW mehr. Natürlich kannst du den gecroppten 4K RAW Stream als CDNG, ProRes oder DNxHD speichern. Nur eben nicht die 5.7K. Das geht vorerst nur in PRR. Und, dass der Inferno mit den 5.7K umgehen können wird, stand auch nirgendwo.

Antwort von nic:

wolfgang hat geschrieben:

Jott hat geschrieben:

Was ist denn die Panik mit der EVA? Die gibt jetzt raw aus, fein, aber es ist doch egal, wie und womit man das abgreift? Muss doch nicht das plötzlich unerwartet aufgetauchte ProRes raw sein? Oder doch?

Es ist erst seit zwei Tagen klar dass es ProRes RAW bei 5.7K sein MUSS. Die Dauerei ist eben dass das vorher nicht gesagt worden ist.

Und es gibt bisher keine andere Möglichkeit das raw einer EVA1 „abzugreifen“ wie du es nennst. Denn das geht nur wenn der Kamerahersteller an Third Parties die erforderlichen Daten liefert oder selbst Rekorder baut. Das ist kein freier Markt sondern ein kleines Oligopol.

Den RAW-Stream der EVA kann jeder abgreifen. Nur fehlt das Format, um es abzuspeichern und an NLEs weiterzureichen. Das ist eben Neuland. Sei froh, dass Apple ohne Not in die Bresche gesprungen ist.

Antwort von R S K:

wolfgang hat geschrieben:

Das Versprechen, raw 5.7K mit Ende März zu liefern, wurde daher nicht eingehalten.

Klar wurde es eingehalten. Schreibst du selbst. Halt (vorerst) für 2,5+ Millionen Leute, zu denen du halt nicht gehörst. Deine Entscheidung, nicht deren Schuld.

„Merkst du eigentlich selbst noch was du da für einen Unsinn schreibst?” Geliefert oder nicht?

Antwort von nic:

"R S K" hat geschrieben:

wolfgang hat geschrieben:

Das Versprechen, raw 5.7K mit Ende März zu liefern, wurde daher nicht eingehalten.

Klar wurde es eingehalten. Schreibst du selbst. Halt (vorerst) für 2,5+ Millionen Leute, zu denen du halt nicht gehörst. Deine Entscheidung, nicht deren Schuld.

„Merkst du eigentlich selbst noch was du da für einen Unsinn schreibst?” Geliefert oder nicht?

Du schreibst aber auch mehr Unsinn als nicht, insofern dürftest du dich mit Kommentaren gerne zurückhalten.

Antwort von R S K:

Welcher Teil genau? Kannst du auch sachlich argumentieren oder bist du jetzt auch nur auf persönliche Attacken reduziert?

Antwort von nic:

"R S K" hat geschrieben:

Welcher Teil genau? Kannst du auch sachlich argumentieren oder bist du jetzt auch nur auf persönliche Attacken reduziert?

So ziemlich jeder deiner Beiträge beginnt mit einer überheblichen Geste und endet mit einer Provokation. Das vergiftet die Atmosphäre und nervt nur noch...

Antwort von R S K:

7nic hat geschrieben:

und endet mit einer Provokation.

Die Zitate die ich einfüge. Ja da hast du recht. Wird aber irgendwie dann zu meiner Provokation. Faszinierend. Andere wiederum dürfen umkommentiert (umprovoziert) regelrecht ausfallend werden, aber wenn ich mal jemand seine eigenen Worte auftische bin ich der überhebliche Provokant. Alles klar. :-)))

Versteh schon. Lass gut sein… ich bin dann mal in der Sonne. Müsste es ja inzwischen besser wissen mich auf die kleine Clique hier einzulassen. My bad. Tschö. ??

Antwort von DV_Chris:

Wer das Interview mit Jeromy Young aufmerksam verfolgt wird zu folgenden Schlüssen gelangen:

1. Die Idee zu ProRes RAW kam von Atomos. Vor allem deshalb, weil die DNG Verarbeitung zu aufwendig schien.

2. Seit Firmengründung ist Apple Partner von Atomos, also war das der erste Ansprechpartner.

3. Als Launch Partner ist die Verarbeitung erstmal FCPX vorbehalten.

4. Jeromy hofft auf eine breite Unterstützung in Soft- und Hardware in den kommenden Monaten.

5. Den High End Markt (Arri) hat er bewusst nicht im Visier, er will Raw for the masses, das mit geringen Anforderungen zurecht kommt. Somit ideal für AIO Rechner ohne performante OpenGL Hardware oder CPU Leistung.

Antwort von mash_gh4:

ich glaub der einzige wirklich bedeutsame unterschied dieses formats besteht darin, dass es nicht mit bildsequenzen sondern einem kontinuierlichen aufzeichnungsstream arbeitet. das ist ein ein ganz entscheidender punkt, der ja nicht nur RAW betrifft, sondern auch andere professionelle RAW und intermediate formate wie OpenEXR od. DPX. während aber letztere formate nur in einem umfeld zur anwendung kommen, wo die die verwendete hardware die entsprechenden leistungsreserven aufzubringen vermag, ist das bei mobilen geräten und kameras bzw. eben der RAW-aufzeichnung weit problematischer. dort macht es also besonders großen sinn, dieses problem auszumerzen. trotzdem ist das natürlich keine sonderlich aufregende innovation, über die man viele worte verlieren muss. ähnliche und z.t. deutlich weitreichendere versuche hat es ja immer wieder gegeben (bspw.: OpenMOX). es erscheint mir daher reichlich absurd, wenn jetzt um apples völlig proprietären lösung, die ja wieder nur einem ganz kleinen teil der realen anwendungsmöglichkeiten offen steht, ein solcher wind gemacht wird.

Antwort von cantsin:

mash_gh4 hat geschrieben:

es erscheint mir daher reichlich absurd, wenn jetzt um apples völlig proprietären lösung, die ja wieder nur einem ganz kleinen teil der realen anwendungsmöglichkeiten offen steht, ein solcher wind gemacht wird.

So kann man das aus technischer Perspektive sehen. Aus einer Marketing- bzw. Produktentwicklungsperspektive bedeutet es aber mehr, nämlich, dass es endlich signifikante Industrie-Bestrebungen gibt, um Raw-Video Mainstream zu machen. Bis vor kurzem hat die Industrie - mit der einzigen Ausnahme von Blackmagic - das für Kameras unterhalb der Klasse von Arri und RED offenbar nur als ein esoterisches Geek-Feature gesehen und mehr als stiefmütterlich behandelt.

Sehr interessant finde ich auch, dass Atomos jetzt seinen 5"-HDMI-Recorder neben ProRes Raw bewirbt. Die Frage ist daher, ob es in irgendeiner Form Raw über HDMI geben wird - und ob da eventuell auch größere Kamerahersteller (wie z.B. Sony mit der anstehenden A7sIII) mitspielen werden.

Antwort von Jott:

Gut beobachtet. „ProRes raw für DSLR und Mirrorless“ ist der Slogan. Da steigt wohl ein noch viel größerer Ballon als bisher gedacht.

Antwort von mash_gh4:

cantsin hat geschrieben:

So kann man das aus technischer Perspektive sehen. Aus einer Marketing- bzw. Produktentwicklungsperspektive bedeutet es aber mehr, nämlich, dass es endlich signifikante Industrie-Bestrebungen gibt, um Raw-Video Mainstream zu machen. Bis vor kurzem hat die Industrie - mit der einzigen Ausnahme von Blackmagic - das für Kameras unterhalb der Klasse von Arri und RED offenbar nur als ein esoterisches Geek-Feature gesehen und mehr als stiefmütterlich behandelt.

ich würde das zwar natürlich auch gerne so sehen, da ich die damit verbundenen möglichkeiten in erschwinglichen kameras persönlich immer sehr stark vermisse, halte es aber leider trotzdem für ein wunschdenken, mit dem ich nicht sehr viel realistische hoffnungen verbinde.

das blackmagic diesen weg beschritten hat, hat in meinen augen ausschließlich damit zu tun, dass sie zum zeitpunkt des erscheinens ihrer ersten kameras einfach nicht in der lage gewesen wären, ein andere lösung umzusetzten. RAW aufzuzeichnen und die nachbearbeitung auf leistungsstärkere rechner in der postproduktion auszulagern ist ja bekanntlich deutlich einfacher als jede form einer befriedigenden internen aufbereitung in der kamera. blackmagic hat hier also einfach nur aus der not eine tugend gemacht -- aber eben auch weiter nichts damit zu verlieren gehabt. bei den meisten anderen kameraproduzenten, die ja bekanntlich fast alle die eigentlichen sensoren vom gleichen fremhersteller beziehen, sieht die sache da ein bisserl anders aus. dort kommt der differenzierung über die firmenspezifischen farbvorstellungen ein ganz anderes gewicht zu, schließlich will ja keiner, dass das ergebnis völlig gleich wie bei der konkurrenz ausssieht, wie es bei zugang zu den RAW daten der fall wäre.

blackmagic hat aber damals, um diese lösung tatsächlich plausibel verkaufen zu können, auch einfach davinci aufkaufen und um entsprechende RAW-import möglichkeiten aufbohren müssen. das ist eine lösung, die nicht alle gehen wollen. ich sehe es in diesem zusammenhang weiterhin als ein ganz gravierendes problem, wie weit die gegenwärtig verfügbaren film-RAW-entwickler in ihren möglichkeiten hinter vergleichbaren programmen im foto-umfeld nachhinken. auch resolve ist diesbezüglich in meinen augen maximal ein akzeptabler kompromiss, aber nicht wirklich überzeugend.

cantsin hat geschrieben:

Die Frage ist daher, ob es in irgendeiner Form Raw über HDMI geben wird - und ob da eventuell auch größere Kamerahersteller (wie z.B. Sony mit der anstehenden A7sIII) mitspielen werden.

das ist technisch kein problem -- kann man schon länger am bsp. des apertus projekts praktisch demonstriert und erklärt bekommen:

https://www.apertus.org/axiom-beta-uhd- ... e-may-2016

sony macht das bei seinen raw-aufzeichnungsmöglichkeiten im zusammenhang mit externen rekordern nicht anders, nur dass dort halt ein großes geheimnis daraus gemacht wird...

Antwort von cantsin:

mash_gh4 hat geschrieben:

das blackmagic diesen weg beschritten hat, hat in meinen augen ausschließlich damit zu tun, dass sie zum zeitpunkt des erscheinens ihrer ersten kameras einfach nicht in der lage gewesen wären, ein andere lösung umzusetzten. RAW aufzuzeichnen und die nachbearbeitung auf leistungsstärkere rechner in der postproduktion auszulagern ist ja bekanntlich deutlich einfacher als jede form einer befriedigenden internen aufbereitung in der kamera.

Blackmagics Kameras hatten schon immer exzellentes 10-Bit ProRes in Log und Rec709. Da gab es keinen Zwang zu Raw. Im Gegenteil, hätte man Kameras wie die Pocket als reine ProRes-Kameras verkauft, hätten die meisten Käufer damit weniger Probleme gehabt und wäre die Kamera eventuell erfolgreicher am Markt gewesen.

Antwort von WoWu:

„Sehr interessant finde ich auch, dass Atomos jetzt seinen 5"-HDMI-Recorder neben ProRes Raw bewirbt.“

Lass uns erst mal abwarten, ob das überhaupt (echtes) RAW ist oder vielleicht nur wieder flaches Video.

Antwort von Jott:

Das Whitepaper zu lesen ist unter wowus Würde.

Antwort von Peppermintpost:

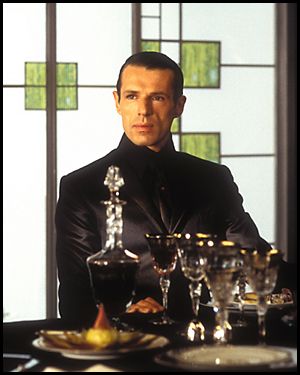

Ich glaube ich hab da irgend einen Verständniss Fehler. Wenn ich den HDMI Ausgang einer Kamera auslese, dann hab ich ja debayertes Rec709, das hat ja mit RAW erstmal so garnichts zu tuen. Selbst wenn ich einen aufzeichnungs LUT benutze, dann sehen meine Farben zwar anders aus aber RAW ist das immer noch nicht. RAW ist doch die Sensordaten auszulesen oder nicht? Ohne debayering einfach luma Informationen in ein File schreiben, also Sensor_2_File.

Ist jetzt vereinfacht, ist mir auch klar, natürlich hockt da auch noch ein Prozessor dazwischen, aber wir reden ja grundsätzlich von Sensordaten und halt nicht von einem bereits mit einem Farbraum versehenen Bild.

Was soll mir dieses RAW Format also im Falle eines Atomos der schön den HDMI einer Nikon ausliest bringen? Verstehe ich nicht? Jetzt sehen wir aus dem sog. Whitepaper das da offensichtlich noch eine Kompression am Werke ist die noch härter zuschlägt als ProRes es sowieso schon tut (ca. 1:6) und das es sich jetzt durch eine besondere Bit Tiefe auszeichnet hab ich auch nicht gelesen.

Was ist jetzt also genau die Frohe Botschaft? Wieso haben wir schon wieder 4 Seiten Hass Komentare?

Antwort von cantsin:

Peppermintpost hat geschrieben:

Ich glaube ich hab da irgend einen Verständniss Fehler. Wenn ich den HDMIWas soll mir dieses RAW Format also im Falle eines Atomos der schön den HDMI einer Nikon ausliest bringen? Verstehe ich nicht?

ProRes Raw aus einer (heutigen) Nikon per HDMI auslesen, geht sowieso nicht.

Was Atomos aber in der Vergangenheit gemacht und hingekriegt hat, ist, in Zusammenarbeit mit Kameraherstellern (wie Sony bei der FS5 und Panasonic bei der EVA) ein undebayertes Signal über SDI auszulesen und als CinemaDNG Raw aufzuzeichnen. Ich vermute, mit proprietären Protokollen/Handshakes.

Auf ihrer Website geben sie an, ProRes Raw via SDI mit zwei ihrer Recorder aus einer Handvoll Panasonic- (EVA + Varicam), Sony- und Canon (C200)-Kameras aufzeichnen zu können.

Ausserdem bewerben sie jetzt auf der NAB einen neuen 5"-HDMI-Recorder direkt neben ProRes Raw. Die Frage ist also, (a) ob es in der Zukunft Kameras geben wird, die über ein (proprietäres) Protokoll undebayerte Videosignale per HDMI an Atomos-Recorder schicken können, die dann in ProRes Raw aufgezeichnet werden, und - falls das so kommt - ob dann (b) es eine neue Klasse von Consumer-/Prosumerkameras mit externer Raw-Aufzeichnung geben wird. HDMI findet man ja eher bei A7, GHx und Konsorten. Wenn man jetzt noch weiter spekuliert, liegt die Frage auf der Hand, ob eventuell die künftige A7sIII sowas anbieten wird.

Antwort von wolfgang:

7nic hat geschrieben:

wolfgang hat geschrieben:

Nachdem raw nicht definiert ist, sind viele Lösungen denkbar. Mir hätte es etwa schon gereicht wenn man das Material in den Rekordern in herkömmlichen ProRes abgelegt hätte.

im Produktfolder von Panasonic steht nur unter raw Output Format 5.7 raw mit späterem Firmware Update. Und mit keiner Einschränkung auf die Mac Welt.

Das Versprechen, raw 5.7K mit Ende März zu liefern, wurde daher nicht eingehalten. Denn es ist nicht geliefert wenn man es nicht nutzen kann obwohl man die im Vorfeld genannte Hardware hat (EVA1 und Shogun Inferno).

Wenn du den RAW Output in ProRes debayerst, hast du kein RAW mehr. Natürlich kannst du den gecroppten 4K RAW Stream als CDNG, ProRes oder DNxHD speichern. Nur eben nicht die 5.7K. Das geht vorerst nur in PRR. Und, dass der Inferno mit den 5.7K umgehen können wird, stand auch nirgendwo.

Wer sagt denn dass ich unbedingt das 5.7K Material als raw benötigt hätte? Mir hätte es als ProRes gereicht.

Antwort von wolfgang:

"R S K" hat geschrieben:

wolfgang hat geschrieben:

Das Versprechen, raw 5.7K mit Ende März zu liefern, wurde daher nicht eingehalten.

Klar wurde es eingehalten. Schreibst du selbst. Halt (vorerst) für 2,5+ Millionen Leute, zu denen du halt nicht gehörst. Deine Entscheidung, nicht deren Schuld.

„Merkst du eigentlich selbst noch was du da für einen Unsinn schreibst?” Geliefert oder nicht?

Für einen Usersnteil von um die 12%.

Großartig.

Antwort von wolfgang:

DV_Chris hat geschrieben:

Wer das Interview mit Jeromy Young aufmerksam verfolgt wird zu folgenden Schlüssen gelangen:

1. Die Idee zu ProRes RAW kam von Atomos. Vor allem deshalb, weil die DNG Verarbeitung zu aufwendig schien.

2. Seit Firmengründung ist Apple Partner von Atomos, also war das der erste Ansprechpartner.

3. Als Launch Partner ist die Verarbeitung erstmal FCPX vorbehalten.

4. Jeromy hofft auf eine breite Unterstützung in Soft- und Hardware in den kommenden Monaten.

5. Den High End Markt (Arri) hat er bewusst nicht im Visier, er will Raw for the masses, das mit geringen Anforderungen zurecht kommt. Somit ideal für AIO Rechner ohne performante OpenGL Hardware oder CPU Leistung.

Alles richtig, genau so habe ich auch sein Interview verstanden. Er ist und bleibt halt ein energiegeladener und stärker Visionär, und solche Leute setzten ihre Vision auch um und sind damit durchaus oft erfolgreich.

Ob das mit ProRes RAW klappen kann wird man sehen. Ob er die Unterstützung von Adobe, Blackmagic, Grass Valley und Magix bekommt wird man sehen. Schlecht wäre es nicht, um aus dem raw Durcheinander rauszukommen. Skeptisch darf man aber sein.

Antwort von Jott:

Atomos baut doch keine Geräte nur für die „12%“. Die sind ja nicht bescheuert, waren sie bisher auch nicht. Vielleicht ein paar Tage oder Wochen Geduld?

Jeder NLE- und Kamerahersteller wird wenige Minuten nach Messeöffnung von all den Bloggern als erstes gefragt werden: Unterstützung von ProRes RAW? Die Antwort geht dann sofort um die Welt. Bis dahin einfach noch in die Sonne legen.

Antwort von wolfgang:

cantsin hat geschrieben:

Peppermintpost hat geschrieben:

Ich glaube ich hab da irgend einen Verständniss Fehler. Wenn ich den HDMIWas soll mir dieses RAW Format also im Falle eines Atomos der schön den HDMI einer Nikon ausliest bringen? Verstehe ich nicht?

ProRes Raw aus einer (heutigen) Nikon per HDMI auslesen, geht sowieso nicht.

Was Atomos aber in der Vergangenheit gemacht und hingekriegt hat, ist, in Zusammenarbeit mit Kameraherstellern (wie Sony bei der FS5 und Panasonic bei der EVA) ein undebayertes Signal über SDI auszulesen und als CinemaDNG Raw aufzuzeichnen. Ich vermute, mit proprietären Protokollen/Handshakes.

Auf ihrer Website geben sie an, ProRes Raw via SDI mit zwei ihrer Recorder aus einer Handvoll Panasonic- (EVA + Varicam), Sony- und Canon (C200)-Kameras aufzeichnen zu können.

Ausserdem bewerben sie jetzt auf der NAB einen neuen 5"-HDMI-Recorder direkt neben ProRes Raw. Die Frage ist also, (a) ob es in der Zukunft Kameras geben wird, die über ein (proprietäres) Protokoll undebayerte Videosignale per HDMI an Atomos-Recorder schicken können, die dann in ProRes Raw aufgezeichnet werden, und - falls das so kommt - ob dann (b) es eine neue Klasse von Consumer-/Prosumerkameras mit externer Raw-Aufzeichnung geben wird. HDMI findet man ja eher bei A7, GHx und Konsorten. Wenn man jetzt noch weiter spekuliert, liegt die Frage auf der Hand, ob eventuell die künftige A7sIII sowas anbieten wird.

Oder sie verpassen dem Ninja doch nur eine SDI Schnittstelle. ;)

|

Antwort von nic:

Peppermintpost hat geschrieben:

Ich glaube ich hab da irgend einen Verständniss Fehler. Wenn ich den HDMI Ausgang einer Kamera auslese, dann hab ich ja debayertes Rec709, das hat ja mit RAW erstmal so garnichts zu tuen. Selbst wenn ich einen aufzeichnungs LUT benutze, dann sehen meine Farben zwar anders aus aber RAW ist das immer noch nicht. RAW ist doch die Sensordaten auszulesen oder nicht? Ohne debayering einfach luma Informationen in ein File schreiben, also Sensor_2_File.

Ist jetzt vereinfacht, ist mir auch klar, natürlich hockt da auch noch ein Prozessor dazwischen, aber wir reden ja grundsätzlich von Sensordaten und halt nicht von einem bereits mit einem Farbraum versehenen Bild.

Was soll mir dieses RAW Format also im Falle eines Atomos der schön den HDMI einer Nikon ausliest bringen? Verstehe ich nicht? Jetzt sehen wir aus dem sog. Whitepaper das da offensichtlich noch eine Kompression am Werke ist die noch härter zuschlägt als ProRes es sowieso schon tut (ca. 1:6) und das es sich jetzt durch eine besondere Bit Tiefe auszeichnet hab ich auch nicht gelesen.

Was ist jetzt also genau die Frohe Botschaft? Wieso haben wir schon wieder 4 Seiten Hass Komentare?

Wie cantsin schon schrieb: es muss natürlich von Kameraseite ein RAW-Stream anliegen und kein Videosignal. Bei Panasonic gibt es am SDI-port zB einen 10bit RAW in log. Bei Sony 12bit linear. Ob das jetzt über HDMI, SDI oder Rauchzeichen als Schnittstelle geschieht, ist ja irrlelvant, sofern sich Kamera und Rekorder verstehen. Das muss dann nur weggespeichert werden in einem Format, das auch die NLEs verstehen.

Bedenke: PRR muss nur 1/3 der Werte (RAW) von PR 444 (RGB) komprimieren mit vergleichbarer Datenrate aber mit einem vergleichbaren Algorithmus. Welche Kompression stärker zuschlägt, kannst du dir denken.

|

Antwort von Jott:

Ninja mit SDI? Dann wäre die Werbung „ProRes raw für DSLR und Mirrorless“ aber sinnbefreit. Filmende Fotoapparate mit SDI im Anflug? Glaube ich jetzt mal nicht. Raw-Signale über die HDMI-Buchse anbieten ist wohl realistischer.

Antwort von wolfgang:

Na warten wir es ab. Kann ja sein dass so eine innovative HDMI Lösung naht und du recht hast . Oder aber man kommt einfach drauf dass der Shogun doch für viele recht schwer und groß ist, zusätzlich zu einer S35mm Kamera.

Antwort von DV_Chris:

Im professionellen Umfeld kann sich wohl niemand eine Aufwertung von HDMI wünschen, solange es nicht mal eine standardisierte mechanische Fixierung gibt...

Antwort von Jott:

Das ist allerdings wahr. Ich würde so was nie ernsthaft benutzen, zu labberig, aber das hat nichts zu sagen. Externe HDMI-Recorder sind schon seit vielen Jahren hip und quasi Zwangszubehör! :-)

Antwort von Axel:

DV_Chris hat geschrieben:

Im professionellen Umfeld kann sich wohl niemand eine Aufwertung von HDMI wünschen, solange es nicht mal eine standardisierte mechanische Fixierung gibt...

Was ist denn heute "das professionelle Umfeld"?

Gibt es etwa keine Profis (hauptberufliche), die nicht zumindest auch mit spiegellosen Systemkameras hantieren? Wegen Größe und Handlichkeit z.B.?

Benutzen die dann nie HDMI-Fieldrecorder oder HDMI-Monitore?

Sind die kleinen Kabelklemmen/Zugentlastungs-Stopper, die es, je nach Hersteller für 7-70 € gibt, weniger sicher als ein (vergleichsweise auch starres) SDI-Kabel?

Antwort von Frank Glencairn:

mash_gh4 hat geschrieben:

das blackmagic diesen weg beschritten hat, hat in meinen augen ausschließlich damit zu tun, dass sie zum zeitpunkt des erscheinens ihrer ersten kameras einfach nicht in der lage gewesen wären, ein andere lösung umzusetzten.