Newsmeldung von slashCAM:

Eine weitere Version der kleinen RED Komodo wird aktuell entwickelt - in einem live gestreamten Gespräch mit Scott Balkum und Phil Holland hat sich Jarred Land einige - t...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Komodo-X: RED teasert neue Super35-Kamera

Antwort von Jott:

Nix für Slashcam-Filmer, ohne Vollformat kann man sich doch nicht mehr blicken lassen.

Antwort von Drushba:

Jott hat geschrieben:

Nix für Slashcam-Filmer, ohne Vollformat kann man sich doch nicht mehr blicken lassen.

Das stimmt. Andererseits kann man unter Vorlage der Cam bei der Deutschen Bahn sicher auf dem Kinderticket zum APSC-Tarif mitreisen. Nur nichts sagen, wenn man mit Avid schneidet, sonst gilt man als Erwachsener und muss nachlösen.)

Antwort von roki100:

Jott hat geschrieben:

Nix für Slashcam-Filmer, ohne Vollformat kann man sich doch nicht mehr blicken lassen.

Ich filme mehr im S35-Modus. FF eigentlich nur in Innenräumen, bei wenig Licht, also da, wo Komodo nur Noise produzieren würde.

Antwort von Darth Schneider:

@roki

Ich wechsle ab, mit der 4K Pocket filme ich logischerweise nie mit Fullframe mit der S5 aber so gut nie mit S35mm Crop…

Beim Fotografieren sieht das anders aus ich fotografiere mit der S5 öfters mal mit dem 35mm Crop, wenn ich näher ran will und mit den Füssen nicht kann.

Ach ja, und Red verkauft doch auch Kameras mit grösseren Sensoren, für die die ihre Projekte nicht mit S35 filmen wollen.

Also schlechter wird das Fullframe Format zum filmen bestimmt auch nicht sein.

Es entspricht immerhin dem 35mm analog/Kino Filmformat…;)

Mit anderen Worten, wer nur mit S35 filmt kauft sich doch dafür keine Fullframe Kamera…

Nur meine Meinung.

Gruss Boris

Antwort von iasi:

Komodo mit HFR.

Das macht Sinn.

Der RF-Lock ist auch gehört eigentlich zu einer Red.

Ansonsten - was könnte da noch kommen?

Audio interessiert mich nicht sonderlich bei einer Kamera.

Antwort von roki100:

"Darth Schneider" hat geschrieben:

Mit anderen Worten, wer nur mit S35 filmt kauft sich doch dafür keine Fullframe Kamera…

Wenn das Gesamtpaket bei FF besser ist, dann kauft man es. Es ist mehr im Paket drin.

Man kann in FF fotografieren oder in S35 RAW 60p filmen , weil (wie in meinem Fall) dann der AF super funktioniert, oder vielleicht den viel besseren Rolling Shutter nutzen, oder wegen APS-C Objektive... und natürlich, wenn es dunkeler ist, kann man auf FF umschalten usw

Antwort von andieymi:

iasi hat geschrieben:

Komodo mit HFR.

Das macht Sinn.

Der RF-Lock ist auch gehört eigentlich zu einer Red.

Ansonsten - was könnte da noch kommen?

Audio interessiert mich nicht sonderlich bei einer Kamera.

Global Shutter bleibt, das ist schon klar. S35+ auch wohl.

Das heißt tatsächlich "nur":

- Etwas größerer / längerer Body

- Rückseitige Module inkl. "fixem, modulbasiertem V-Mount" (vmtl. besser integriert als vorhandene Adapter, ähnlich DSMC2 - da ist die Frage, wie sehr Red da wieder die Kasse klingeln lassen will und ab wann V-Raptor günstiger kommen würde, 2500€ für ein Modul kann ich mir schon wieder vorstellen)

- Höhere Framerates ("Wouldn't make camera bigger if we didn't have to" - das heißt im Endeffekt - Kühlung. Da der Sensor S35 bleibt -> Framerates)

- Besseres internes Audio

- RF-Lock

- Es wird ein nicht SDI-basiertes Sucher/Monitorsystem geben (ähnlich DSMC2), den Sucher dafür entwickelt Red gerade.

- CF-Express(!)

Das ist alles, was man bis jetzt fix weiß. Also keine Spekulation. Am 16. sollte es die Specs geben. Ansonsten macht das Red-Teaservideo keinen Sinn, denn eigentlich kennt man die Specs. Was also verstellen, wenn nicht die GENAUEN Specs?

Aber, deutlicher Fokus auf A-Cam, auch innerhalb des Red-Universums, vermutlich Sucher/Monitor und Bildfunk parallel ohne Loop-Through (zusätzlich 2. SDI über Modul?), etwas größerer Body (zumindest in 1 Dimension größer).

Gewisse Aussagen machen allerdings noch keinen Sinn:

"Längerer Body wegen größerem internen Monitor"? Sofern sie den nicht 90° gedreht verbauen, müsste die Kamera hauptsächlich breiter werden. Oder aber sie positionieren die Buttons um (darüber, darunter) und nutzen den frei gewordenen Platz für einen größeren Monitor.

Antwort von macaw:

...ich weiss nicht, immer wenn ich diesen Jarred Land mit seiner Kappe sehe denke ich: Hillbilly...kann den einfach nicht ernst nehmen...

Antwort von RUKfilms:

macaw hat geschrieben:

...ich weiss nicht, immer wenn ich diesen Jarred Land mit seiner Kappe sehe denke ich: Hillbilly...kann den einfach nicht ernst nehmen...

Musst du auch nicht, aber seine Firma solltest du schon ernst nehmen bzw zeigt er damit, dass man ihn ernst nehmen "muss" :-).

Antwort von pillepalle:

Videodata listet die Komodo X Stormtrooper jetzt für 9850,-€ Netto (11721,50 € inkl. MwSt) und gibt folgende Verbesserungen/neue Features an:

Doppelte Bildrate mit bis zu 6K/80p, 4K/120p und 2K/240p

Verbesserte Details und Farben in den Schatten

Micro V-Lock Akkuplatte

Verbesserte PDAF Funktion (mit Face Tracking über Red-Control App)

Erweiterte Shutter Kontrolle bis zu 1/6 Sek.

Fünfmal längere Prerecord-Zeiten

Verbesserte Audio-Vorverstärker

16,5+ Stops Dynamic Range

ProRes 4K 4444XQ und 4444 formate

Zusätzliche zuweisbare Tasten

Verriegelbarer RF-Mount

Demnächst soll auch noch ein EF zu PL-Mount Adapter mit eingebautem VariND und relativ geringem Colorshift erscheinen (Clear und 2-7 Stops)

VG

Antwort von iasi:

Gute Modellpflege.

Es wurde so ziemlich alles das nun nachgereicht, das man bei der Komodo noch vermisst hatte.

Antwort von andieymi:

iasi hat geschrieben:

Gute Modellpflege.

Es wurde so ziemlich alles das nun nachgereicht, das man bei der Komodo noch vermisst hatte.

Ja, eine Sache hätte es schon noch sein dürfen:

Wenn jetzt 12-14.8V direkt über V-Mount direkt kommen, was wäre dabei gewesen 1-2 2-Pin-Lemo am Body hinten mitzuverbauen? Ich weiß es wird die Module geben - und viel wurde tatsächlich nachgebessert, aber das wäre noch fein gewesen.

Ansonsten ist die 100% Frameraten-Steigerung (80 vs 40 @6K 17:9, 120 vs 60 @4K 17:9) schon beachtlich. 80 fps mit Global Shutter in 6K in R3D HQ für unter 10000€ gabs halt bisher auch nicht. Production Model wird wohl auch wieder nen 1000er weniger kosten, das in Karten gesteckt und man ist mit (auf dem Investitionslevel wohl ohnehin vorhandenen V-Mounts) wieder bei den 10K.

Ich hab letzte Woche beim Händler auch mal ein bisschen Zubehör behirnt und so gern ich von CFast weg möchte - irgendwie bringt mir zur vorhandenen "Normalen" nichts von der X wirklich was, auch wenn sämtliches Zubehör von der Komodo wohl weiter nutzbar wäre:

- Ich hatte noch nie ein Problem mit 40fps. 90% läuft sie auf 25/25, <10% auf 24/24 und 1% auf 33-40/25. Für das eine Mal im Jahr 80fps brauchen ist mieten besser und da will man in Wirklichkeit auch eher ne V-Raptor mit 120 und mehr - und keine 80.

- Sound spielt keine Rolle. Mitm F3 als externen Recorder und Preamp für besseren Referenzton funktioniert auch das normale Audio für die niedrigen Ansprüche, ansonsten einfach Timecoden, da ist eh ein Audio dann mit dabei wenn Sound eine Rolle spielt.

- So cool in anderen Kameras ProRes4444 wäre, so wenig braucht es die X wirklich: Mit R3D von HQ bis ELQ gibt es einfach für jede Anwendung auch ein Raw-Format.

- Der Locking Mount ist nett für Leute, die RF und Focus by Wire verwenden wollen - ich hab ohnehin nur verschiedene Kipperties (EF/PL) und die sind fix am Cage verschraubt.

Die vertikal integrierte V-Mount Platte ist tatsächlich das, was mich (haptisch) am meisten reizt (und wenn man 2-Pin-Lemo braucht ist man aber da wieder bei ner Distro-Plate), aber von einer inkl. Spezialzubehör (Cage, RF-Kipperties "interne NDs") lang abbezahlten Komodo weg, die seitdem quasi mit jedem Projekt Geld druckt und nicht mal im Wiederverkauf noch nennenswert gesunken ist (oder wird, die X ist zum Glück teuer genug) ist der Grund für den Umstieg echt nicht so dringend.

Klassische Bequemlichkeitssachen: Bessere V-Mount-Lösung, etwas längerer Body macht Kamera tatsächlich einfacher zu Riggen, CF-Epress für bessere Offloading-Zeiten.

Spannend wird was wirklich die bessere Dynamik angeht, aber ich tippe auf homöopatisch. Da finde ich die OG-Komodo immer noch besser als vieles andere am Markt - inkl. der Hardware-HLR ist man da auch auf über 13 Blenden, das ist schon ok. Andere sind da bei 11.9. Wegen 0.3 SNR2-Blenden mehr auf der X (viel mehr wird es sich wohl nicht spielen?) ist die X auch das Upgrade nicht wert.

Antwort von iasi:

@andieymi

Da hast du schon recht. Ein Upgrade von einer Komodo auf eine Komodo-X ist nicht zwingend nötig.

HFR ist jedoch für mich schon ein wichtiger Punkt.

Die 40fps der Komodo sind leider nicht Fisch, nicht Fleisch.

Antwort von roki100:

pillepalle hat geschrieben:

Ich finde die beiden Objektive, die er da benutzt, sehr gut.

16,5+ Stops Dynamic Range

stimmt das? Bin mir da nicht sicher https://www.cined.com/red-komodo-6k-lab ... tude-test/ wird bei X auch nicht anders sein. Da ist auch noch standardmäßig Highlight Recovery aktiviert.

Antwort von Frank Glencairn:

roki100 hat geschrieben:

stimmt das? Bin mir da nicht sicher

Das ist wie beim Crop, da muß man umrechnen.

16,5+ RS (Red Stops) = 12 normale Blenden

Antwort von Darth Schneider:

Dann dürften es schätzungsweise bei meiner S5, beziehungsweise 4K Pocket wo was von /12-14 Stops behauptet wird, 8 oder höchstens 10 Stops sein, wenn überhaupt..;)))

Oder ?

Gruss Boris

Antwort von cantsin:

"Darth Schneider" hat geschrieben:

Dann dürften es schätzungsweise bei meiner S5, beziehungsweise 4K Pocket wo was von /12-14 Stops behauptet wird, 8 oder höchstens 10 Stops sein, wenn überhaupt..;)))

Bei der alten Komodo hat CineD 12,2 (ProRes)-12,5 (Raw) Stops bei SNR=2 gemessen, bei Deiner S5 12,1 Stops.

Antwort von Darth Schneider:

Gibt es diesbezüglich gerade bei den sehr teuren Kameras eigentlich auch wissenschaftliche und von mehr fachen Stellen überprüfte Messungen oder nur solche von YouTubern ?

Wenn das zweite der Fall ist ja dann ist das doch eh nur wie Religion, glauben..;))

Gruss Boris

Antwort von iasi:

"Darth Schneider" hat geschrieben:

Dann dürften es schätzungsweise bei meiner S5, beziehungsweise 4K Pocket wo was von /12-14 Stops behauptet wird, 8 oder höchstens 10 Stops sein, wenn überhaupt..;)))

Oder ?

Gruss Boris

Da spielen viele Faktoren mit hinein.

Bei einer Sony 7S3 holt man mit Raw via HDMI noch etwas mehr DR heraus.

Red kann ebenfalls die NR-Vorteile der Post ausschöpfen.

Antwort von iasi:

"Darth Schneider" hat geschrieben:

Gibt es diesbezüglich gerade bei den sehr teuren Kameras eigentlich auch wissenschaftliche und von mehr fachen Stellen überprüfte Messungen oder nur solche von YouTubern ?

Wenn das zweite der Fall ist ja dann ist das doch eh nur wie Religion, glauben..;))

Gruss Boris

https://www.dxomark.com/red-helium-8k-d ... gh-score2/

Es ist doch auch immer eine Frage des optimalen Einsatzes und wo man beim Rausch-Signal-Abstand die Grenze zieht.

Mit gutem NR in der Post hebt man auch noch Zeichnung aus dem Rauschen, wo kameraintern alles weggebügelt wird.

Mir ist es sowieso nicht ganz klar, weshalb der DR immer auf solch einen hohen Sockel gehoben wird, wo doch üblicherweise Licht auch in minimalster Weise gesetzt wird.

Für die extremen und seltenen Fälle bei denen man einen enormen Lichtkontrast bewältigen muss, würde ich mir HDRx wünschen.

Antwort von Frank Glencairn:

"Darth Schneider" hat geschrieben:

Gibt es diesbezüglich gerade bei den sehr teuren Kameras eigentlich auch wissenschaftliche und von mehr fachen Stellen überprüfte Messungen oder nur solche von YouTubern ?

Wissenschaftlicher als IMATEST wird's nicht mehr.

Antwort von roki100:

cantsin hat geschrieben:

Bei der alten Komodo hat CineD 12,2 (ProRes)-12,5 (Raw) Stops bei SNR=2 gemessen

Ohne eingebackene HR, ca 11.

Antwort von iasi:

roki100 hat geschrieben:

cantsin hat geschrieben:

Bei der alten Komodo hat CineD 12,2 (ProRes)-12,5 (Raw) Stops bei SNR=2 gemessen

Ohne eingebackene HR, ca 11.

Das reicht.

Für eine GlobalShutter-Kamera ist das übrigens ein herausragender Wert.

Antwort von roki100:

iasi hat geschrieben:

roki100 hat geschrieben:

Ohne eingebackene HR, ca 11.

Das reicht.

Für eine GlobalShutter-Kamera ist das übrigens ein herausragender Wert.

ja ungefähr wie Blackmagic Production Camera 4k mit dem GlobalShutter.

Antwort von iasi:

roki100 hat geschrieben:

iasi hat geschrieben:

Das reicht.

Für eine GlobalShutter-Kamera ist das übrigens ein herausragender Wert.

ja ungefähr wie Blackmagic Production Camera 4k mit dem GlobalShutter.

Da fehlt aber ein ;) oder :)

Antwort von andieymi:

roki100 hat geschrieben:

cantsin hat geschrieben:

Bei der alten Komodo hat CineD 12,2 (ProRes)-12,5 (Raw) Stops bei SNR=2 gemessen

Ohne eingebackene HR, ca 11.

Ich feiere die CineD tests extrem, weil's wirklich die vergleichbarste synthetische Dynamikmessung ist, die es im Moment im Netz gibt. Aber: Die Komodo ist die einzige Kamera bisher mit eingebackener, algorithmusbasierter HL-Recovery und wie CineD das integriert hat ist zumindest erwähnenswert. Wenn es nicht mehrere Kameras gibt, die das Feature aufweisen, finde ich es extrem inkonsistent, das nicht zu berücksichtigen. Andernfalls müsste man einfach alle nach reproduzierbarer Postproduktion mit NR testen - quasi am Ende der Pipeline, aber dann kann man die Tests auch quasi lassen. Also ich versteh's, aber ich hab das Gefühl dass der Komodo mit dem Wert eigentlich nicht genüge getan wird, auch aus der Praxis.

@Rush: Man muss sich nur die Zählweise in den Xylas anschauen: Da sind 13 Stops in Summe, der 14te liegt im Noisefloor, die zählen halt einfach den obersten nicht. Kann man so machen,

https://www.cined.com/red-komodo-6k-lab ... tude-test/

Das ist halt einfach gleich viel wie eine S5 (etwas mehr), ohne überhaupt den 1 Stop zu berücksichtigen und ohne den Global Shutter irgendwie zu erwähnen. Eine BMPCC6K (11.8 stops at SNR = 2)) hat fast ne Blende weniger, ohne den Highlight-Stop zu zählen und ohne Global Shutter.

Ich versteh die Herangehensweise von CineD - aber es bringt eben das Problem der Vergleichbarkeit: Es gibt nicht mehr Kameras, die das integriert so lösen, der Roll-Off ist gut und in der Praxis ist das wie eine nutzbare Blende mehr - wenn auch ohne perfekte RGB-Separation aber mit quasi algorithmusbasierter Recovery. Bei der praktischen Wolke links hinten oben kurz vor Clipping ist mir ehrlich gesagt recht egal, ob die noch komplette RGB Trennung hat oder ich mir die halt noch ein bisschen blauer oder wärmer ziehen kann. Wer ETTR so betreibt, dass er irgendwas wichtiges (Gesichter?) in die Blende legt, hat irgendwas anderes nicht verstanden - das ist auch der Grund wieso ich die Slashcam-Tests (im Gegensatz zur dezenten Kritik hier an CineD) nicht gut finde, weil da im Endeffekt ETTR-Fähigkeiten und praxisfremderes Arbeiten statt "gut ausreichende, aber on point Belichtung" statt Maximaldynamik in einem Frame gemessen werden, der maximal den Arbeitsanspruch von Einzelpersonen, die das Projekt von der Kamera bis zur Delivery selbst betrauen abbildet. Das hat für mich wenig mit praktisch nutzbarer Dynamik zu tun, da ist trotz der Synthetik der Imatest wertvoller meiner Meinung nach. Ich muss am Set so belichten können, dass Skintones da liegen wo sie liegen. Wenn da draußen ein Fenster 2 Blenden heller ist, hilft mir die ETTR-Quali einer Kamera nicht, wenn ich trotzdem nicht 100% Kontrolle über das Bild habe - und das trifft einfach leider praktisch nur unter Studiobedienungen zu. Alles was Crew on location Wett machen kann, kann Zeit wieder killen und die Dynamik interessiert mich in erster Linie in Fällen wo sie erforderlich ist, nicht wo ich eh alles in die 7-8 Blenden gelegt bekomme.

Also wer jetzt sagen will das ist ein "Mimimimi" von mir kann das gern machen. Man kann auch einfach sagen, dass es 12.5 sind, Global Shutter dabei ist und eine völlig nutzbare Blende mehr schon so aus der Kamera mitkommt, was es nicht zu 13.5 macht, aber spürbar, belichtbar, praktisch mehr als z.B. Pockets oder teilweise FullFrame Kameras wie eine S1H.

Antwort von roki100:

andieymi hat geschrieben:

Ich feiere die CineD tests extrem, weil's wirklich die vergleichbarste synthetische Dynamikmessung ist, die es im Moment im Netz gibt. Aber: Die Komodo ist die einzige Kamera bisher mit eingebackener, algorithmusbasierter HL-Recovery und wie CineD das integriert hat ist zumindest erwähnenswert.

Die einzige RED Kamera die das intern macht ist Komodo(wahrscheinlich auch die X). Bei den anderen RED macht das IPP2 Nachträglich. Also so oder so, ist HR bei RED standardmässig aktiv.

Panasonic macht (höchstwahrscheinlich) auch HR Kameraintern (HLG).

BMD überlässt es dem Nutzer, nachträglich HR zu (de)aktivieren und den + Stops Wert durch HR, wird nicht zu den eigentliche DR Wert, die der Sensor tatsächlich schafft (db-Wert), dazugezähl...

Und bei ProResRAW scheint HR dabei zu sein und funktioniert (nach meiner Erfahrung) nur mit FCP.

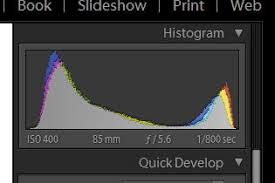

Ich finde HR soweiso sehr interessant. Ich aktiviere eigentlich immer nachträglich HR (CinemaDNG) und bin immer wieder überrascht, welche Details in den Highlights noch wiederhergestellt werden, obwohl ich eigentlich auf Histogramm oder Zebrastreifen vorher geachtet habe. Ganz gut zu sehen ist das ganze, wenn man zB Wolken filmt und dann HR einsetzt, wie viele Details da noch zurückgeholt werde, ist schon verrückt.

Das einzige Negative, das ich finde (gegenüber Kunden), sind die übertriebenen DR-Werte von RED. Das ist aber nur meine persönliche Meinung. Als Kunde, der eine Bosch-Waschmaschine kauft, weil sie angeblich 1750 Umdrehungen macht, in Wirklichkeit aber nur 1000 kann, ist nicht okay - was ich als Kunde soweiso nicht bemerke, weil die Umdrehungen zu schnell sind, um jede Umdrehung mit dem bloßen Auge zu zählen.... ;)

Antwort von andieymi:

roki100 hat geschrieben:

Die einzige RED Kamera die das intern macht ist Komodo(wahrscheinlich auch die X). Bei den anderen RED macht das IPP2 Nachträglich. Also so oder so, ist HR bei RED standardmässig aktiv.

Panasonic macht (höchstwahrscheinlich) auch HR Kameraintern (HLG).

BMD überlässt es dem Nutzer, nachträglich HR zu (de)aktivieren und den + Stops Wert durch HR, wird nicht zu den eigentliche DR Wert, die der Sensor tatsächlich schafft (db-Wert), dazugezähl...

Und bei ProResRAW scheint HR dabei zu sein und funktioniert (nach meiner Erfahrung) nur mit FCP.

Ich finde HR soweiso sehr interessant. Ich aktiviere eigentlich immer nachträglich HR (CinemaDNG) und bin immer wieder überrascht, welche Details in den Highlights noch wiederhergestellt werden, obwohl ich eigentlich auf Histogramm oder Zebrastreifen vorher geachtet habe. Ganz gut zu sehen ist das ganze, wenn man zB Wolken filmt und dann HR einsetzt, wie viele Details da noch zurückgeholt werde, ist schon verrückt.

Vermutlich auch die X - deshalb wäre auch spannend, wie viel mehr nutzbare DR die dann wirklich bietet.

Aus meinen knapp 2,5 Jahren Erfahrungen mit der Komodo jetzt funktioniert einfach die HL Recovery deutlich besser, als ich viele andere Systeme - wo man meinen könnte, das in der Post irgendwie genau und passend hinzufriemeln - wie z.B. bei Blackmagic und DSMC2. Ich kannte davor auch die HLR von CinemaDNG und DSMC2 und verglichen damit ist die interne deutlich "organischer" als alles, was ich von besagten in der Post hinbekommen hätte. Und das straight aus der Kamera. Die interne HL Recovery gepaart mit dem Roll-Off in der aktuellen Entwicklungsstufe von IPP2 in DSCM3 schaut wirklich gut aus, selbst wenn mal was clippt - und auch deutlich besser als DSMC2 wenn mal was clippt.

Auch deshalb find ich es etwas - nun ja - seltsam von CineD, dieses Alleinstellungsmerkmal quasi gegen die Kamera zu verwenden in den Imatests. Aus der Praxis finde ich die Dynamik die die Komodo an den Start bringt deutlich besser, als vieles andere was es bisher im riesigen Segment unter 10K gab und dann halt erst deutlich besser bei Arri & DSMC3 und etwas besser bei DSMC2 (wo die Preise für Packages jetzt fast vergleichbar sind - Gemini gibt's mittlerweile als halbwegs drehfertiges Kit für 9K Netto, das entspricht fast nem fertigen Komdodo-Setup.)

Und ich würde auch aus der Praxis die letztendlich nutzbare Dynamik deutlich höher ansetzen, als von vielen Kameras die im Endeffekt im Imatest zwar auch bei 12.5 rauskommen, aber in Summe das halt nicht im Un-Entrauschten Raw tun (da fällt auch ganz gut auf, welches Raw funktioniert und höhere Werte als ProRes liefert, und wo im Endeffekt das entrauschte Kameramaterial mehr Dynamik inne hat als das Raw, aber keinerlei Ressourcen mehr für die Post - wie das sehr oft bei Sony der Fall ist, teilweise auch bei Canon.)

roki100 hat geschrieben:

Das einzige Negative, das ich finde (gegenüber Kunden), sind die übertriebenen DR-Werte von RED. Das ist aber nur meine persönliche Meinung. Als Kunde, der eine Bosch-Waschmaschine kauft, weil sie angeblich 1750 Umdrehungen macht, in Wirklichkeit aber nur 1000 kann, ist nicht okay - was ich als Kunde soweiso nicht bemerke, weil die Umdrehungen zu schnell sind, um jede Umdrehung mit dem bloßen Auge zu zählen.... ;)

Volle Zustimmung. Aber das war wohl bei Red schon immer so, was es nicht besser macht. Eher das Problem scheint mir jetzt, dass sich andere Hersteller mittlerweile ähnlich versteigen wie Fuji, wo "lt. eigenen Tests" die X-2H dann 14+ Blenden in F-Log aufzeichnet, im Imatest waren es nur mehr 11.9 - und das ist halt einfach unter den "magischen 12", die im Moment ohnehin noch kaum jemand meistert, schon gar nicht in der Preisregion. Geschweige denn die echten 13.5 aufwärts.

Macht nicht besser, dass Red so übertreibt - aber da weiß man es im Wettlauf mit Arri halt seit Jahren, dass mittlerweile etliche andere Hersteller mit Werten um sich schmeißen die einfach aufgebläht sind, macht das Ganze nicht unbedingt besser.

Antwort von iasi:

andieymi hat geschrieben:

Volle Zustimmung. Aber das war wohl bei Red schon immer so, was es nicht besser macht. Eher das Problem scheint mir jetzt, dass sich andere Hersteller mittlerweile ähnlich versteigen wie Fuji, wo "lt. eigenen Tests" die X-2H dann 14+ Blenden in F-Log aufzeichnet, im Imatest waren es nur mehr 11.9 - und das ist halt einfach unter den "magischen 12", die im Moment ohnehin noch kaum jemand meistert, schon gar nicht in der Preisregion. Geschweige denn die echten 13.5 aufwärts.

Macht nicht besser, dass Red so übertreibt - aber da weiß man es im Wettlauf mit Arri halt seit Jahren, dass mittlerweile etliche andere Hersteller mit Werten um sich schmeißen die einfach aufgebläht sind, macht das Ganze nicht unbedingt besser.

Wo zieht man denn z.B. in den Schatten die Grenzen?

Mit guten NR holt man auch noch aus dem mit Rauschen überlagerten Signal ein Struktur heraus.

Was mich weit mehr interessiert als die DR-Blendenzahlen ist u.a. wie weit ich die Mitten unterbelichten kann, um die Lichter zu schützen, und sie dann ohne Einbußen in der Post wieder anheben kann.

Antwort von roki100:

iasi hat geschrieben:

Was mich weit mehr interessiert als die DR-Blendenzahlen ist u.a. wie weit ich die Mitten unterbelichten kann, um die Lichter zu schützen, und sie dann ohne Einbußen in der Post wieder anheben kann.

Wie es dann im Schattenbereich aussieht, kannst du an die LowLight-Kameravergleichen sehen. Da kannst Du anheben, nur dank NeatVideo...

Antwort von Darth Schneider:

@iasi

Warum willst du das denn überhaupt tun können ?

Doch nur weil du dich womöglich beim Dreh viel zu wenig um die Schauspieler/Akteure, das Framing, Leuchten, das Set, die Props/Kostüme/Make Up, die Farben und die Lichter mit samt den Schatten „live“ bei der Aufnahme kümmerst ?

Wenn du das nämlich genau so tust, musst du genau mal gar nix zurückholen in Post, sondern du kannst einfach nur ganz kreativ Colorgrading machen.

Und das geht eigentlich sicher heute mit absolut jeder anständigen aktuellen (ab) 10 Bit Kamera…

Welche ?

Je nach persönlichen Vorlieben..;)

Alles andere sind doch eigentlich nur faule Ausreden, finde ich zumindest.

Gruss Boris

Antwort von roki100:

andieymi hat geschrieben:

Volle Zustimmung. Aber das war wohl bei Red schon immer so, was es nicht besser macht. Eher das Problem scheint mir jetzt, dass sich andere Hersteller mittlerweile ähnlich versteigen wie Fuji, wo "lt. eigenen Tests" die X-2H dann 14+ Blenden in F-Log aufzeichnet, im Imatest waren es nur mehr 11.9 - und das ist halt einfach unter den "magischen 12", die im Moment ohnehin noch kaum jemand meistert, schon gar nicht in der Preisregion. Geschweige denn die echten 13.5 aufwärts.

Macht nicht besser, dass Red so übertreibt - aber da weiß man es im Wettlauf mit Arri halt seit Jahren, dass mittlerweile etliche andere Hersteller mit Werten um sich schmeißen die einfach aufgebläht sind, macht das Ganze nicht unbedingt besser.

Ja...und das mit Fuji, uff, da landet man schnell in OffTopic Mülleimer weil einige das nicht gerne lesen und dickköpfig werden viewtopic.php?f=17&t=156191&hilit=14+stops#p1144589

Antwort von Frank Glencairn:

"Darth Schneider" hat geschrieben:

@iasi

Warum willst du das denn überhaupt tun können ?

Doch nur weil du dich womöglich beim Dreh viel zu wenig um die Schauspieler/Akteure, das Framing, Leuchten, das Set, die Props/Kostüme/Make Up, die Farben und die Lichter mit samt den Schatten „live“ bei der Aufnahme kümmerst ?

Wenn du das nämlich genau so tust, musst du genau mal gar nix zurückholen in Post, sondern du kannst einfach nur ganz kreativ Colorgrading machen.

Und das geht eigentlich sicher heute mit absolut jeder anständigen aktuellen (ab) 10 Bit Kamera…

Welche ?

Je nach persönlichen Vorlieben..;)

Alles andere sind doch eigentlich nur faule Ausreden, finde ich zumindest.

Gruss Boris

Man sollte bei der ganzen Dynamic Range Diskussion nicht vergessen, daß das eigentlich hauptsächlich ein typisches Hobbyfilmer/Low/No Budget Thema ist - ähnlich wie ISO (und zu einem gewissen Grad auch Auflösung und "Schärfe").

Wenn man bedenkt das einige der besten Filme der Geschichte mit 50/100 ISO und 8-10 Blenden DR gedreht wurden (z.B. Batman Returns - 100T, JFK - 50D, Men in Black - 100T), wird klar, warum diese Themen in der Branche bestenfalls ganz unten auf der Liste stehen - wenn überhaupt.

Ich glaub der EXR 200T kam erst so Anfang/Mitte der 90er raus, wenn ich mich richtig erinnere.

Hat sich damals bei den ersten Testaufnahmen angefühlt, als ob wir nie mehr Licht mitnehmen müßten :D

Antwort von roki100:

"Frank Glencairn" hat geschrieben:

Man sollte bei der ganzen Dynamic Range Diskussion nicht vergessen, daß das eigentlich hauptsächlich ein typisches Hobbyfilmer/Low/No Budget Thema ist - ähnlich wie ISO (und zu einem gewissen Grad auch Auflösung und "Schärfe").

Wie jetzt? :)

Als Arri daran arbeitete, den Look oder das gewisse Etwas im Bild von analogen Filmkameras so identisch wie möglich bei Alexa digital zu übernehmen, wurde der Dual-Gain-Sensor genau deshalb entwickelt, um mehr DR zu erreichen? Das scheint kein typisches Hobbyisten-Low- oder No-Budget-Thema zu sein, sondern der eigentliche Grund war auch DR einer Arri-Filmkamera, so nahe wie möglich in digitale Welt zu übernehmen?

Auch bei der neue S35 4.6k Arri, wurde eine andere (scheinbar bessere) Technologie verwendet, um noch mehr DR zu erreichen (deswegen auch 13Bit...?).

Auflösung, Schärfe... das ja.

Antwort von Darth Schneider:

@roki

Alles rund um die Kamera herum ist sehr wichtig (am meisten die, hoffentlich sehr talentierte Film Crew, egal ob 100 Mann oder ein Mann)

Und nicht zu vergessen vor allem auch das Wichtigste.

Nämlich das was vor der Kamera abläuft, und mitsamt dem Film Licht dem Film Ton, der Musik und mit dem was ganzen im Edit/Sound/Bild Mix und Design Segment passiert.

Meist schon im Vorfeld voll genau festgelegt und ganz genau bis ins kleinste Detail definiert..;)

Das macht immer noch den wirklichen massgeblichsten Unterschied zwischen Amateur/Prosumer und einem High End Kinofilm ( sprich dem Kinolook) aus.

Nämlich eigentlich nix anderes als eine sehr penible Planung und die möglichst exakte Umsetzung davon…

Und nur ganz zuletzt spielt (die Kamera Technik), egal ob:

Arri, Panavision, Sony (Venice), Red, Blackmagic, Canon, Panasonic…

Und auch DR, Dual Gain, Dual Iso, Colorgrading, DR, und die ganzen anderen Bild technischen Details, irgend eine verhältnismässig (zu allem anderem) eigentlich eine völlig unbedeutende Rolle..

Vor allem heute, wo schon die Smartphones sehr, sehr schön in 10 Bit und sogar RAW/ProRes filmen können..

Gruss Boris

Antwort von Frank Glencairn:

roki100 hat geschrieben:

Als Arri daran arbeitete, den Look oder das gewisse Etwas im Bild von analogen Filmkameras so identisch wie möglich bei Alexa digital zu übernehmen, wurde der Dual-Gain-Sensor genau deshalb entwickelt, um mehr DR zu erreichen?

Lattitude mit DR verwechselt?

Wie schon gesagt, der Durchschnittsfilm hat zwischen 8 und 10 nutzbare Blenden (Positiv Film teilweise nur 5).

Um das zu simulieren hätte es die 13-14 Blenden der Alexa nicht gebraucht.

roki100 hat geschrieben:

Auch bei der neue S35 4.6k Arri, wurde eine andere (scheinbar bessere) Technologie verwendet, um noch mehr DR zu erreichen (deswegen auch 13Bit...?).

Bittiefe hat nix mit DR zu tun. Sollte doch langsam klar sein.

Antwort von roki100:

"Frank Glencairn" hat geschrieben:

Lattitude mit DR verwechselt?

k.A. :) Aber soweit ich mich eriennere gibt es von Arri ein Bericht, wo genau das so erwähnt wird. Ich meine, Arri scheint DR nicht umsonst so wichtig zu sein, Alexa S35 laut cined: 15.1 stops at a signal-to-noise (SNR) ratio of 2, and 16.3 stops at SNR = 1

Bittiefe hat nix mit DR zu tun. Sollte doch langsam klar sein.

Im Schattenbereich mehr details...?

"As expected, in ProRes 4444 XQ results are a tad worse – in ARRIRAW we are having 13bits at our disposal, in ProRes 4444 XQ "only" 12 bits. This shows especially in the noisy, shadow stops when they are being pushed up."

https://www.cined.com/arri-alexa-35-lab ... lus-video/

k.A. was Arri mit 13bit-log (18bit linear?) mehr kann als wie bisher 12bit-log (16bit linear) besser macht. Klar ist, dass Dual Gain mehr details in schatten und lichter aufnehmen kann, mit jeweils 14Bit.

Antwort von Darth Schneider:

@roki

Natürlich hat das nix miteinander zu tun…

Das eine sind die Anzahl Farben das andere ist ist Dynamik Range…

Das was du jetzt dich drauf fixierst ist eben nur pures Pixelpeepen, und das hat eigentlich gar nix mit Filme machen und auch mit irgend einem Filmlook an sich zu tun…

Glaube es oder nicht, es ist so.

Gruss Boris

Antwort von Darth Schneider:

"Darth Schneider" hat geschrieben:

@roki

Natürlich hat das nix miteinander zu tun…

Das eine sind die Anzahl Farben das andere ist ist Dynamik Range…

Das was du jetzt dich abgesehen davon drauf fixierst ist eben nur pures Pixelpeepen, und das hat eigentlich gar nix (beziehungsweise nix wichtiges) mit Filme machen und auch mit irgend einem Filmlook an sich zu tun…

Glaube es oder nicht, es ist so.

Gruss Boris

Antwort von roki100:

"Darth Schneider" hat geschrieben:

@roki

Natürlich nicht…Das eine sind die Anzahl Farben das andere ist ist Dynamik Range…

Das was du jetzt dich drauf fixierst ist eben nur pures Pixelpeepen, und das hat eigentlich gar nix mit Filme machen und auch mit irgend einem Filmlook an sich zu tun…

Glaube es oder nicht, es ist so.

Gruss Boris

Nur das extra für dich dann wieder iognore ;)

For more than 10 years, ARRI ALEXA cameras have been trusted by the world’s top filmmakers. A

key reason for their widespread adoption is the high dynamic range of the cameras. The high dynamic

range allows images to be rendered with a soft, film-like roll-off in the highlights, and provides the

exposure latitude needed in challenging situations. When it comes to these attributes, ALEXA has set

the benchmark against which all others are measured.

This document explains how ARRI measures the dynamic range of its cameras. The design of the

sensor in the original ALEXA cameras was so advanced that it led the industry in terms of dynamic

range for 12 years. During that time, larger format versions of the sensor were introduced that

combined the superior dynamic range with greater resolution. It was only when ARRI released the

ALEXA 35, with its new 4.6K Super 35 format sensor, that even greater dynamic range was achieved.

Since the introduction of the ARRI ALEXA camera family, filmmaking has changed. Wide gamut and

HDR displays have emerged and content for these displays is produced by OTT providers. With an

increased range of tonal values in the display, the camera needs to have a greater dynamic range to

maintain the creative possibilities for color grading. On the lighting side, LED illumination has

appeared on set and everywhere else. ARRI’s lighting fixtures can be used to illuminate sets or stages

in pure colors. Capturing the highly saturated colors from these fixtures also requires a large dynamic

range in the camera

https://www.arri.com/resource/blob/2954 ... r-data.pdf

Antwort von Jott:

"Frank Glencairn" hat geschrieben:

Bittiefe hat nix mit DR zu tun. Sollte doch langsam klar sein.

Siehe Arri: die Amira-Bilder sehen im 8Bit-Modus (XDCAM für Sender) genauso gut aus wie mit „voller Pulle“.

Antwort von Darth Schneider:

@roki

Ist das nicht ein wenig zu übertreiben viel zu viel Pixelpeepen und viel zu dummes Geschreibe von dir (mit einfach nur Copy Paste) ?

Für einen schnöden Hobbyfilmer und Typen der noch niemals irgend eine Arri selber überhaupt in der Hand hatte ?

In einer Red Debatte, obwohl du ebenfalls noch gar nie überhaupt eine Red in der Hand hattest ?

PS:

Ich antworte gar nicht darauf, was du schreiben wirst…

Ist mir viel zu dumm und du kannst diesbezüglich gar nicht kompetent sein.

Sorry, für dich, wenn du das nicht mal bemerkst..;)))

Und drohe mir nicht mit der Ignorliste.

Das kann ich auch..;)

DU bist schon längst dort auf meiner, mach so in dem Stil wie jetzt weiter und ich werde dann endlich konsequent, und ignoriere dich immer.

Dann aber endgültig.

Es gibt mehr als genug sehr kompetente und coole Leute hier auf SlashCAM.

Gruss Boris

Antwort von Frank Glencairn:

roki100 hat geschrieben:

Im Schattenbereich mehr details...?

"As expected, in ProRes 4444 XQ results are a tad worse – in ARRIRAW we are having 13bits at our disposal, in ProRes 4444 XQ “only” 12 bits. This shows especially in the noisy, shadow stops when they are being pushed up."

https://www.cined.com/arri-alexa-35-lab ... lus-video/

Willst du uns auf den Arm nehmen?

Das ist bei einem Latitude Test (nicht DR) von 8(!) Blenden Unterbelichtung - natürlich kommt da der alte DCT Codec von Prores an seine Grenzen.

Here is the 8 stops underexposed image using noise reduction for EI800 in ProRes 4444 XQ

Zumal das raw Material an dem Punkt ebenfalls schon völlig unbrauchbar war - egal wie viel bit.

Noise reduction cannot save this image without destroying all details – game over!

Im Normalbetrieb und was den DR betrifft sieht das laut CineD in Wirklichkeit natürlich völlig anders aus.

By the way, ProRes 4444 XQ showed very similar results, here is the IMATEST graph:

Antwort von roki100:

@Frank, das hier meinte ich;

ARRIRAW is the same as before?

Essentially, yes. We do a non-linear recording of the RAW images

and 512 digital numbers are allocated per exposure stop. But,

because in the new ARRIRAW we have to encode two more stops,

we need 1,024 more numbers in our range. That’s why we needed

to add one bit to the file format, so ARRIRAW is encoded in the

ALEXA 35 in 13-bit, whereas ARRIRAW is encoded in 12-bit in

in the ALEXA LF.

...

https://www.fdtimes.com/pdfs/free/115FD ... 04-150.pdf

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

Im Normalbetrieb und was den DR betrifft sieht das laut CineD in Wirklichkeit natürlich völlig anders aus.

By the way, ProRes 4444 XQ showed very similar results, here is the IMATEST graph:

Und doch wird in unkomprimiertem Raw mit den Alexas gefilmt.

Nun frag dich mal: Warum?

Antwort von Frank Glencairn:

iasi hat geschrieben:

Und doch wird in unkomprimiertem Raw mit den Alexas gefilmt.

Natürlich, was denn sonst - man wär ja auch mit dem Klammerbeutel gepudert in ProRes aufzunehmen, wenn man doch raw haben kann.

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

iasi hat geschrieben:

Und doch wird in unkomprimiertem Raw mit den Alexas gefilmt.

Natürlich, was denn sonst - man wär ja auch mit dem Klammerbeutel gepudert in ProRes aufzunehmen, wenn man doch raw haben kann.

Aber du stellst es doch so dar, dass es "im Normalbetrieb und ... in Wirklichkeit" keine Rolle spielt.

Also was denn nun?

Antwort von Frank Glencairn:

Zunächst mal stell ich gar nix, sondern zitiere nur CineD.

Und was die gesagt hatten ist, daß - was DR betrifft - quasi kein Unterschied zwischen raw und Prores ist, völlig egal wie viel Bit.

Und das ist ja auch genau das was zu erwarten ist, da ja beides vom selben Sensor kommt, und - wie ich schon sagte - Bit-Tiefe nichts mit DR per se am Hut hat.

Und natürlich hat raw jede Menge Vorteile gegenüber ProRes, aber mit DR hat das halt nix zu tun.

Hier werden ständig Äpfel mit Birnen nicht nur verglichen, sondern auch noch verwechselt.

Hört auf euch mit sowas verrückt zu machen, und lernt lieber mit 8-10 Blenden DR pro aktiv ein ordentliches Bild zu machen, statt euch immer nur hinter der Technik zu verstecken.

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

Zunächst mal stell ich gar nix, sondern zitiere nur CineD.

Und was die gesagt hatten ist, daß - was DR betrifft - quasi kein Unterschied zwischen raw und Prores ist, völlig egal wie viel Bit.

Und das ist ja auch genau das was zu erwarten ist, da ja beides vom selben Sensor kommt, und - wie ich schon sagte - Bit-Tiefe nichts mit DR per se am Hut hat.

Und natürlich hat raw jede Menge Vorteile gegenüber ProRes, aber mit DR hat das halt nix zu tun.

Hier werden ständig Äpfel mit Birnen nicht nur verglichen, sondern auch noch verwechselt.

Und das stimmt dann so eben doch auch nicht.

Bei ProRes wurden die Sensordaten schon in der Kamera nach dem 0815-Prinzip bearbeitet.

Mit Raw lassen sich die Sensordaten in der Post sehr viel genauer und angepasster bearbeiten.

Wir reden hier von digitalisierten Werten, die "oben" das Maximum erreichen (Lichter) und "unten" von Rauschsignalen überlagert werden.

Bei ProRes sind die RGB-Werte und das Rauschen schon verbacken, während bei Raw die Ausgangswerte (in möglichst genauer Abstufung) noch vorhanden sind.

Du kannst mit temporalem NR dann eben doch noch mehr herausholen und das Clippen von einem oder zwei RGB-Werten durch die verbleibenden Werte ausgleichen.

"Frank Glencairn" hat geschrieben:

Hört auf euch mit sowas verrückt zu machen, und lernt lieber mit 8-10 Blenden DR pro aktiv ein ordentliches Bild zu machen, statt euch immer nur hinter der Technik zu verstecken.

Da gebe ich dir recht.

Jedoch ist es in der Praxis eben doch ein Unterschied, ob ich die 8 Blenden Motivkontrast über das gesamte Histogram erstreckt oder nach links hin noch ein ordentlicher Abstand besteht - wo der Signal-Rauschabstand immer geringer wird.

https://encrypted-tbn0.gstatic.com/imag ... Q&usqp=CAU

https://encrypted-tbn0.gstatic.com/imag ... Q&usqp=CAU

zum Bild

Eine möglichst feine Abstufung ist dann hilfreich, da die Aufnahmewerte in der Post gestreckt werden müssen.

Antwort von Frank Glencairn:

iasi hat geschrieben:

Und das stimmt dann so eben doch auch nicht.

Bei ProRes wurden die Sensordaten schon in der Kamera nach dem 0815-Prinzip bearbeitet.

Du scheinst ja tiefe Einsichten in das interne Signalprocessing von Arri zu haben.

Erleuchte uns doch mal mit ein paar mehr Details, was Arri da genau macht.

Antwort von roki100:

"Frank Glencairn" hat geschrieben:

Und natürlich hat raw jede Menge Vorteile gegenüber ProRes, aber mit DR hat das halt nix zu tun.

Was meinte dann Arri hiermit? viewtopic.php?f=2&t=158319&start=35#p1181014

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

iasi hat geschrieben:

Und das stimmt dann so eben doch auch nicht.

Bei ProRes wurden die Sensordaten schon in der Kamera nach dem 0815-Prinzip bearbeitet.

Du scheinst ja tiefe Einsichten in das interne Signalprocessing von Arri zu haben.

Erleuchte uns doch mal mit ein paar mehr Details, was Arri da genau macht.

Meinst du, dass in einer Alexa eine KI arbeitet, die jede Aufnahme analysiert?

Denkst du, dass bei einer Alexa eine temporale NR werkelt?

Erfolgt das Debayern in einer Alexa etwa KI-gesteuert für jede Einstellung?

...

Versuche Antworten darauf zu finden und schon erleuchtest du dich selbst.

Antwort von cantsin:

"Frank Glencairn" hat geschrieben:

Du scheinst ja tiefe Einsichten in das interne Signalprocessing von Arri zu haben.

Erleuchte uns doch mal mit ein paar mehr Details, was Arri da genau macht.

Bei High-End-Kameras und deren High-End-Signalverarbeitung dürfte es da keine relevanten Unterschiede geben.

Raw macht IMHO einen umso größeren Unterschied, je Consumer-mäßiger die Kamera ist. Wenn man z.B. eine Canon R5/c hat, dann ist die (laut übereinstimmenden Testberichten) schon durch eine suboptimales Log-Profil geschlagen, das DR abschneidet. Hinzu kommt dann noch bei Raw, dass man eine Blende in den Spitzlichtern durch Highlight Recovery gewinnen kann und mindestens eine Blende in den Schatten durch die Erhaltung aller Bildinformation mit Raw + Entrauschen mit Neat, wo kamerainterne h264/h265-Encoder die meiste Bildinformation wegschmeißen bzw. grobschlächtig entrauschen und nur noch unbrauchbare Schemen mit Blockartefakten übrig lassen.

Oder, anders gesagt: Raw ist eine probate Krücke, um sich eine Arri-ProRes-gleichwertige Signalverarbeitung zu spendieren, indem man sie von der Kamera in die Post verlagert...

Antwort von roki100:

iasi hat geschrieben:

Bei ProRes sind die RGB-Werte und das Rauschen schon verbacken, während bei Raw die Ausgangswerte (in möglichst genauer Abstufung) noch vorhanden sind.

Du kannst mit temporalem NR dann eben doch noch mehr herausholen und das Clippen von einem oder zwei RGB-Werten durch die verbleibenden Werte ausgleichen.

Also wenn es um details im Schattenbereich geht, siehe das:

https://www.youtube.com/watch?v=GZ90OZlUTSg

Antwort von Frank Glencairn:

iasi hat geschrieben:

Meinst du, dass in einer Alexa eine KI arbeitet, die jede Aufnahme analysiert?

Denkst du, dass bei einer Alexa eine temporale NR werkelt?

Erfolgt das Debayern in einer Alexa etwa KI-gesteuert für jede Einstellung?

Und mit welcher "KI" analysieren und debayern die gängigen die NLEs so?

Du versuchst gegen einen Imatest zu argumentieren - da ist einfach Hopfen und Malz verloren.

Antwort von iasi:

cantsin hat geschrieben:

Oder, anders gesagt: Raw ist eine probate Krücke, um sich eine Arri-ProRes-gleichwertige Signalverarbeitung zu spendieren, indem man sie von der Kamera in die Post verlagert...

Eben genau nicht.

Raw erlaubt es eine Einstellung die einen Kontrastumfang von 8 Blenden hat mit ETTR so zu belichten, dass der Signal-Rauschabstand maximal ist.

Und 12+ bit erlauben dann, diese ETTR-Aufnahme auf das Ausgabeformat zu bringen.

Gerade, wenn die Mittentöne heruntergezogen und gedehnt werden, will ich keine Abrisse.

Und:

Debayern in der Kamera kann nicht so exakt und gezielt erfolgen, wie in der Post.

Antwort von cantsin:

iasi hat geschrieben:

cantsin hat geschrieben:

Oder, anders gesagt: Raw ist eine probate Krücke, um sich eine Arri-ProRes-gleichwertige Signalverarbeitung zu spendieren, indem man sie von der Kamera in die Post verlagert...

Eben genau nicht.

Raw erlaubt es eine Einstellung die einen Kontrastumfang von 8 Blenden hat mit ETTR so zu belichten, dass der Signal-Rauschabstand maximal ist.

Und 12+ bit erlauben dann, diese ETTR-Aufnahme auf das Ausgabeformat zu bringen.

Gerade, wenn die Mittentöne heruntergezogen und gedehnt werden, will ich keine Abrisse.

Das geht alles auch mit Log-Material.

Debayern in der Kamera kann nicht so exakt und gezielt erfolgen, wie in der Post.

Nee. Resolve z.B. hat auf Echtzeit-Performance und GPU-Beschleunigung optimierte Debayering- Algorithmen, deren Ergebnisse sichtbar schlechter sind als die von (vergleichsweise schneckenlahmen) Foto-Raw-Konvertern.

Wenn Arri in seine Kameras für die eigenen Sensor optimiertes Debayering in seine Prozessoren einbaut, muss das Ergebnis nicht schlechter (und kann eventuell sogar besser) sein als in Resolve & Co.

Antwort von roki100:

cantsin hat geschrieben:

Nee. Resolve z.B. hat auf Echtzeit-Performance und GPU-Beschleunigung optimierte Debayering- Algorithmen, deren Ergebnisse sichtbar schlechter sind als die von (vergleichsweise schneckenlahmen) Foto-Raw-Konvertern.

Ich finde echt schade dass das nicht optimiert wird. So viele bugfixes und optimierungen aber nur das irgendwie nicht. Außer BRAW.

Antwort von cantsin:

roki100 hat geschrieben:

cantsin hat geschrieben:

Nee. Resolve z.B. hat auf Echtzeit-Performance und GPU-Beschleunigung optimierte Debayering- Algorithmen, deren Ergebnisse sichtbar schlechter sind als die von (vergleichsweise schneckenlahmen) Foto-Raw-Konvertern.

Ich finde echt schade dass das nicht optimiert wird. So viele bugfixes und optimierungen aber nur das irgendwie nicht. Außer BRAW.

Es ist ja optimiert, nur eben auf Performance. Wenn Du stattdessen die Debayering-Algorithmen z.B. von Adobe Camera Raw, DxO oder libraw verwenden würdest, hättest Du eine Abspiel- und Renderperformance von 1fps oder weniger.

Antwort von roki100:

cantsin hat geschrieben:

roki100 hat geschrieben:

Ich finde echt schade dass das nicht optimiert wird. So viele bugfixes und optimierungen aber nur das irgendwie nicht. Außer BRAW.

Es ist ja optimiert, nur eben auf Performance. Wenn Du stattdessen die Debayering-Algorithmen z.B. von Adobe Camera Raw, DxO oder libraw verwenden würdest, hättest Du eine Abspiel- und Renderperformance von 1fps oder weniger.

wenn man alles kompiliert und konsole benutzt, geht es etwas schneller: viewtopic.php?f=4&t=152154&hilit=libraw#p1119438

Antwort von Frank Glencairn:

roki100 hat geschrieben:

Ich finde echt schade dass das nicht optimiert wird.

Weil das nur ein Hobbyfilmer Fetisch ist, der im Rest der Welt keinerlei Bedeutung hat - im professionellen Bereich zoomt niemand 800% in ein Standbild um Pixel zu zählen.

Ich kenne keinen einzigen Kollegen aus meinem beruflichen Umfeld - egal ob Kamera oder Post - der sich auch nur im geringsten für irgendwelche alternativen Debayering Methoden interessiert.

Antwort von iasi:

cantsin hat geschrieben:

Wenn Arri in seine Kameras für die eigenen Sensor optimiertes Debayering in seine Prozessoren einbaut, muss das Ergebnis nicht schlechter (und kann eventuell sogar besser) sein als in Resolve & Co.

Arri liefert, wie auch Red und die anderen, die Debayering-Algorithmen an Resolve.

Gerade an der Color-Sience werkeln Arri und Red doch besonders intensiv.

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

roki100 hat geschrieben:

Ich finde echt schade dass das nicht optimiert wird.

Weil das nur ein Hobbyfilmer Fetisch ist, der im Rest der Welt keinerlei Bedeutung hat - im professionellen Bereich zoomt niemand 800% in ein Standbild um Pixel zu zählen.

Ich kenne keinen einzigen Kollegen aus meinem beruflichen Umfeld - egal ob Kamera oder Post - der sich auch nur im geringsten für irgendwelche alternativen Debayering Methoden interessiert.

Also an der Color Sience der Kamerahersteller sind gerade die Profis sehr interessiert.

Ansonsten würde Arri nicht so lange daran herumfeilen und sich mit neuen Kameras wie der Alexa S35 so viel Zeit lassen.

Antwort von Frank Glencairn:

Nur hat die Color Science halt überhaupt nix mit dem Debayering zu tun.

Antwort von cantsin:

iasi hat geschrieben:

Arri liefert, wie auch Red und die anderen, die Debayering-Algorithmen an Resolve.

Wie kommst Du denn darauf?

(Weißt Du überhaupt, was ein Debayering-Algorithmus ist?)

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

Nur hat die Color Science halt überhaupt nix mit dem Debayering zu tun.

Ach - beim Debayering werden dann wohl Bayern gezeugt? :)

Antwort von iasi:

cantsin hat geschrieben:

iasi hat geschrieben:

Arri liefert, wie auch Red und die anderen, die Debayering-Algorithmen an Resolve.

Wie kommst Du denn darauf?

(Weißt Du überhaupt, was ein Debayering-Algorithmus ist?)

Denkst du wirklich, dass Red die Zusammenarbeit mit BMD darauf beschränkt, Kuchenrezepte auszutauschen?

Das Debayering ist die Basis der Farbbilderzeugung. Da muss ich wohl die Frage zurückgeben.

Antwort von cantsin:

iasi hat geschrieben:

cantsin hat geschrieben:

Wie kommst Du denn darauf?

(Weißt Du überhaupt, was ein Debayering-Algorithmus ist?)

Denkst du wirklich, dass Red die Zusammenarbeit mit BMD darauf beschränkt, Kuchenrezepte auszutauschen?

Das Debayering ist die Basis der Farbbilderzeugung. Da muss ich wohl die Frage zurückgeben.

Du hast wirklich keinen blassen Schimmer und kennst den Unterschied zwischen Debayering (bzw. einem Debayering-Algorithmus) und einer Farbmatrix nicht, und glaubst ernsthaft, dass jede Kamera ihren eigenen Debayering-Algorithmus hat...

Mir verschlägt es - ganz unironisch - die Sprache, weil Du hier im Forum ein gefühltes Jahrzehnt lang der Hardcore-Raw-Apostel warst und, wie sich jetzt herausstellt, eigentlich gar nicht weisst, worüber Du schreibst....

Antwort von roki100:

RED converts red, green, and blue photosite values from the RAW sensor data into full color pixels using a high-quality de-Bayer or “demosaicing” algorithm that achieves a good combination of detail, low-noise, and speed. See The Bayer Sensor Strategy article for a background. IPP2 improves the de-Bayer algorithm to squeeze out even higher detail at the same pixel resolution. In practice, this is most apparent with fine, high contrast detail such as foliage or resolution charts.

https://support.red.com/hc/en-us/articl ... 2-Overview

Arri (ADA7):

Bildschirmfoto 2023-05-20 um 21.54.20.png

https://www.arri.com/en/learn-help/lear ... or-science

Antwort von iasi:

cantsin hat geschrieben:

iasi hat geschrieben:

Denkst du wirklich, dass Red die Zusammenarbeit mit BMD darauf beschränkt, Kuchenrezepte auszutauschen?

Das Debayering ist die Basis der Farbbilderzeugung. Da muss ich wohl die Frage zurückgeben.

Du hast wirklich keinen blassen Schimmer und kennst den Unterschied zwischen Debayering (bzw. einem Debayering-Algorithmus) und einer Farbmatrix nicht, und glaubst ernsthaft, dass jede Kamera ihren eigenen Debayering-Algorithmus hat...

Mir verschlägt es - ganz unironisch - die Sprache, weil Du hier im Forum ein gefühltes Jahrzehnt lang der Hardcore-Raw-Apostel warst und, wie sich jetzt herausstellt, eigentlich gar nicht weisst, worüber Du schreibst....

Ach - und du denkst also wirklich, dass jeder Kamerahersteller denselben Debayering-Algorithmus auf jeden Sensor anwendet.

Da verschlägt es mir nun die Sprache.

Vor allem hört es sich bei dir so an, als sei das DeBayering-Ergebnis bei allen Sensoren gleich.

ARRI nennt seinen Debayer Algorithm ADA-7.

Und dies ist - um mich selbst zu zitieren - die Basis der Farbbilderzeugung.

Überleg doch mal, wie der Farbwert eines Pixels bei einem Bayer-Sensor ermittelt wird.

Weißt du eigentlich, warum man den Foveon-Sensor so sehr für seine Farbwiedergabe lobt?

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

iasi hat geschrieben:

Meinst du, dass in einer Alexa eine KI arbeitet, die jede Aufnahme analysiert?

Denkst du, dass bei einer Alexa eine temporale NR werkelt?

Erfolgt das Debayern in einer Alexa etwa KI-gesteuert für jede Einstellung?

Und mit welcher "KI" analysieren und debayern die gängigen die NLEs so?

Du versuchst gegen einen Imatest zu argumentieren - da ist einfach Hopfen und Malz verloren.

Oh ja - vor dem NLE sitzt eine Intelligenz, die eine Aufnahme analysieren, beurteilen und dann gezielt gestalten kann.

Diese Intelligenz kann dann z.B. sehr genau ermitteln, welche Farbtemperatur für die Einstellung die richtige ist.

Antwort von cantsin:

iasi hat geschrieben:

Ach - und du denkst also wirklich, dass jeder Kamerahersteller denselben Debayering-Algorithmus auf jeden Sensor anwendet.

Da verschlägt es mir nun die Sprache.

Vor allem hört es sich bei dir so an, als sei das DeBayering-Ergebnis bei allen Sensoren gleich.

ARRI nennt seinen Debayer Algorithm ADA-7.

Und dies ist - um mich selbst zu zitieren - die Basis der Farbbilderzeugung.

Überleg doch mal, wie der Farbwert eines Pixels bei einem Bayer-Sensor ermittelt wird.

Weißt du eigentlich, warum man den Foveon-Sensor so sehr für seine Farbwiedergabe lobt?

Es ist wirklich hanebüchen, dass Du null, aber auch null Ahnung von dem hast, was Du hier seit Jahren schreibst.

Also mal langsam:

- Foveon ist kein Bayer-, sondern ein nativer RGB-Sensor, bei dem überhaupt nichts debayert bzw. gedemosaict werden muss.

- Debayering ist das Interpolieren von Mischfarben aus den monochromen Rot-, Grün- und Blau-Rasterpunkten eines Bayer-Sensors .

- Beim Debayering-Algorithmus geht es um Heuristiken, um die Mischfarben möglichst gut zu rekonstruieren und möglichst optimale Farbtrennung (bzw. keine Falschfarben, Farbsäume oder fehlende Farbdifferenzierung) zu erzielen. Das hat nichts mit kamerahersteller- oder -modellspezifischen Dingen zu tun, sondern der Algorithmus schlägt sich erst mal nur mit den Rot-/Grün-/Grün-/Blau-Rasterpunkten rum, die bei allen Bayer-Raw-Daten vorliegen.

- Wie u.a. in Wikipedia nachzulesen, gibt es verschiedene, eingeführte bzw. publizierte Debayering-Algorithmen wie VNG, PPG, AHD und AMaZE.

- Einige Raw-Konverter (wie z.B. alle, die libraw verwenden) erlauben Dir sogar die Auswahl des Debayering-Algorithmus. Wenn Du z.B. Natron statt Resolve verwendest, um Dein Video-Raw zu interpretieren, hast Du dafür ein Auswahlmenü mit diesen und noch mehr Algorithmen. Ja, und tatsächlich kannst Du die dann auf die Bayer-Raw-Daten welcher Kameramodelle und -hersteller auch immer anwenden! Und an der allgemeinen Farbwiedergabe ändert das gar nichts; Unterschiede siehst Du nur in Bilddetails, wenn Du 1:1 auf die Pixel einzoomst.

- Bei Foto-Raw ist das ja sogar ein Geschäftsmodell - dass viele Anwender z.B. auf Capture One oder DxO schwören, weil sie deren proprietäre Debayering-Algorithmen besser finden als z.B. die von Adobe. (DxO z.B. verwendet neuerdings ein Deep Learning-basiertes Verfahren, das Debayering und Entrauschen im selben Schritt erledigt.)

- Was Du für Kamerahersteller- bzw. Kameramodell-spezifische Debayering-Algorithmen hältst, in denen vermeintlich die "Color Science" verborgen liegt, ist die sogenannte "Color Conversion Matrix", die angibt, wie die debayerten/gemischten Farben korrigiert werden müssen. Im Prinzip handelt es sich hierbei um LUTs. Diese "Color Conversion Matrix" kann per EXIF in die Raw-Datei eingebettet werden (weshalb Raw-Konverter wie Resolve, Natron, Rawtherapee und Lightroom auch aus Raws von obskuren Kameras anständige Farben holen), als externe ICC-Profildatei vorliegen oder eben von Herstellern wie Arri und RED mit Blackmagic geteilt werden. In dieser Color Conversion Matrix liegt dann auch die sog. Color Science des Herstellers (die im Deutschen weniger hochtrabend "Farbtechnologie" genannt wird).

- Auch hier gibt es Software-Hersteller, die die Kamerahersteller-Color Conversion Matrix links liegen lassen, selbst Messungen anstellen und ihre eigenen Farbinterpretationen machen. Adobe macht das so in Camera Raw mit den Adobe-eigenen Bildprofilen, ebenso DxO und Capture One, und kleine Hersteller wie Cobalt Color (die Dir im Prinzip nur Color Conversion Matrixes bzw. ICC-Profile für bestehende Kameras und den Raw-Konverter Deiner Wahl anbieten).

- Möglich, dass Blackmagic einen Deal mit Arri hat, so dass ArriRaw mit Arris eigenem Algorithmus debayert wird und dass Resolve unter der Haube den Algorithmus dann switcht. Das hat dann aber nichts mit der Color Science zu tun.