Newsmeldung von slashCAM:Grundlagen: Grundlagen: 4K - Von RAW bis 4:2:0 von rudi - 17 Feb 2014 11:00:00

Mit der Ankündigung der ersten erschwinglichen 4K-Kameras wird auch die Frage des Chroma-Subsamplings wieder einmal neu aufgekocht. Dabei scheint klar: RAW, 4:4:4 und 4:2:2 sind professionell, 4:2:0 bleibt für die Amateure. Doch wenn man genau hinsieht, liegt bei 4K die Sache etwas anders...

zum ganzen Artikel

Antwort von walktheplank:

Interessanter Beitrag!

Antwort von Tiefflieger:

Die Sache geht noch weiter,

Z.B. dfie Sony AX100 hat einen 1" Sensor mit netto 14.2MP für 4K.

Auch da findet bereits ein Downsampling auf 4K statt und auf die Sensorauflösung bezogen ist das nicht weit weg von der Sony F65 und RED Dragon (welche natürlich andere Debayering und Speichermöglichkeiten haben)

Insofern ist zu erwarten, dass besonders die Sony AX100 und auch die Panasonic GH4 sehr gutes FullHD liefern.

Vorteil der Panasonic ist noch die 50p und 60p zeitliche Auflösung in 4K.

Gruss Tiefflieger

Antwort von rkunstmann:

Ich dachte die GH4 liefert 4K nur bis 30p. FHD dagegen bis 96fps (Zeitlupe auf 50 oder 60p conformed). Wenn 10 bit durch downsampling so einfach zu erreichen sind, frage ich mich, warum das bei der C300 von Anfang an ausgeschlossen wurde (und zwar sensorseitig). War das doch ein Marketingzug?

Ich bin da nicht so firm. Was mir einleuchtet ist, dass vier Pixel, die zu einem "Superpixel" zusammengefasst werden einen Farbwert berechnen können, der über 8 bit hinausgeht, aber ist das in der Praxis wirklich mit echtem 10 bit vergleichbar? Könnte man zum Beispiel Banding so wirklich effektiv verhindern? Krass ausgedrückt ergibt viermal rot 255 immer noch rot 255 oder eben dann 1023. Klar ist das Beispiel extrem, aber gerade bei 4:2:0 H.264 scheint mir das fraglich, ob hier so ein Qualitätssprung passieren würde...

Gleiches müsste man ja beobachten können, wenn man FHD nach 960/540 optimal berechnet. Müsste man mal testen, wobei die geringe Auflösung vllt. ein Problem darstellt.

Bin gespannt...

Antwort von Tiefflieger:

@rkunstmann

Du hast Recht, ich habe mich da verlesen.

Tabelle mit den Frameraten.

https://www.slashcam.de/news/single/Pan ... 11186.html

Benachbarte Pixel in 4K haben eine Farbe, die in 1080p wieder eine mathematisch genauere Mischfarbe ergeben.

Sonst hätte man Dithering welches wiederum ein Auflösungsverlust bedeutet.

Antwort von Valentino:

Eure 4k 4:2:0 zu 2k/HD 4:4:4 hat irgendwo einen Denkfehler.

Vor Jahren hattet ihr mal so ein ähnliches Gedankenspiel verfasst, das man von HD 4:2:0 auf SD 4:4:4 kommen könnte.

Bitte hier Wolfgang um Auflösung.

Von 4k 8bit kommt man aber niemals auf 10bit HD für alle drei Kanäle.

So etwas muss schon ganz früh nach dem Sensor passieren.

Einzig durch eine Art HDRx der Red Kameras könnte man sich im Nachhinein die zwei 8bit Bilder zu einem 10bit zusammenfügen, erhält dann aber noch lange keine echten 10bit und hat das Problem der Bewegungsunschärfe.

Und noch eine andere Sache, durch das Downsampling verliert man Auflösung un so z.B. bei einem Key eine Menge Details und da bringt dann auch die 4:4:4 bei HD nicht mehr viel.

Wenn das alles so einfach ist, dann wäre da bestimmt schon vorher einer auf eure Idee gekommen.

Antwort von rkunstmann:

@rkunstmann

Du hast Recht, ich habe mich da verlesen.

Tabelle mit den Frameraten.

https://www.slashcam.de/news/single/Pan ... 11186.html

Benachbarte Pixel in 4K haben eine Farbe, die in 1080p wieder eine mathematisch genauere Mischfarbe ergeben.

Sonst hätte man Dithering welches wiederum ein Auflösungsverlust bedeutet.

Genau, klar. Ich meine nur 4 identisch rote Pixel geben wieder nur einen gleich roten Pixel (also egal ob es 256 oder 1024 Abstufungen sind) und Banding entsteht ja wegen zu ähnlicher oder identischer Farben (gerade halt bei 8 bit 4:20). Aber ich lasse mich da gerne eines besseren belehren.

Antwort von kundesbanzler:

Ich hoffe inständig, dass irgendwann diese Unart mal wieder aufhört, Ideenfragmente aus Powerpoint-Folien, Twitter- bzw. SMS-Diskussionen oder sonstigen Banalitätsmedien unreflektiert in Artikelkontexte zu übernehmen und zu glauben, dies würde eine textuelle Argumentation ersetzen. Und dann auch noch als Handyscreenshot - ahh, diese Schmerzen.

Kann man auch Ulysses in Herr der Ringe konventieren, sofern sie die gleiche Anzahl an Wörtern enthalten?

Antwort von rideck:

Sehr gut, habe diese Frage gerade in einem anderen Thread auch gestellt - bin gespannt?

Antwort von rideck:

David Newman erklärt es so: 4 x 8 Bit-Werte lassen sich zu einem 10 Bit-Wert rechen. Na wenn das stimmt dann haben wir ja 10 Bit intern ;)

Antwort von Daffytroll:

.....

Von 4k 8bit kommt man aber niemals auf 10bit HD für alle drei Kanäle.

So etwas muss schon ganz früh nach dem Sensor passieren.

...

Aber setzt hier nicht die GH2/3-Hackcommunity an? :-) Also dürfte es zumindest per Hack dann irgendwann machbar sein wenns in der Post nicht funktioniert wie beschrieben ... oder?

Antwort von Spreeni:

Welche Hackcommunity? Nur weil einer per Zufall auf ein paar veränderbare Flags in der Firmware von GH1/2 gestoßen ist? Hat bei den Kameras der letzten Jahre aber nicht mehr funktioniert...

Antwort von Valentino:

Aber setzt hier nicht die GH2/3-Hackcommunity an? :-) Also dürfte es zumindest per Hack dann irgendwann machbar sein wenns in der Post nicht funktioniert wie beschrieben ... oder?

Nein definitiv wird es bei den GH Modellen kein 10bit geben, auch wenn der Aufzeichnungscodec anscheinend 10bit unterstützt wird intern immer nur 8bit verarbeitet.

Ein umschalten der Hardware auf 10bit ist nur möglich, wenn leistungsstarke DSP verbaut sind und die A/D Wandlung auf darauf ausgerichtet wurde.

@Slashcam

Das doch sehr komplexe Thema unter "Grundlagen" zu stellen halt ich für falsch, dann doch besser unter "Essay" :-)

Antwort von wolfgang:

David Newman erklärt es so: 4 x 8 Bit-Werte lassen sich zu einem 10 Bit-Wert rechen. Na wenn das stimmt dann haben wir ja 10 Bit intern ;)

Hmm, wie geht das? Jeder Pixel hat bei 8bit nur die 2^8 = 256 möglichen Farbtöne - für jeden Farbkanal. Ergibt die 256*256*256 = 16,8 Mio darstellbaren Farben.

Wenn ich also 4 Pixel nehme, bewegen sich die auch nur im Spektrum dieser 16,8 Mio Farben. Kann man durch Mischen von 4 Pixel dieses 8bit-Farbspektrums auf die bei 10bit vorhandenen 2^10 oder 1024*1024*1024 = 1.073.741.824 Farben, also 1073,7 Millionen Farben kommen?

Antwort von kundesbanzler:

Das doch sehr komplexe Thema unter "Grundlagen" zu stellen halt ich für falsch, dann doch besser unter "Essay" :-)

... oder "Glosse".

Antwort von Tiefflieger:

@Wolfgang

Wenn ich an einem 8 bit Punkt den Wert R200 habe und am folgenden R201 dann hat der Mischpixel R200.5 und den gibt es in 8 bit nicht.

In 4 K und nur für rot

R200,R201

R201,R204

Wie wäre da die Gewichtung?

Meiner Meinung nach würden mathematisch bei komplexerem RGB nur mit floating Werten die nötige Genauuigkeit erreicht.

Antwort von wolfgang:

Das ist mir bewußt. Aber es ist und bleibt eine Interpolation. Und die Frage ist wie gut das überhaupt sein kann - und ob man das gesamte Farbspektrum so wirklich darstellen kann.

Antwort von Tiefflieger:

Wie auf dem Sensor werden beim Debayering Nachbarpixel gewichtet, da der exakte Farbwert für einen Pixel nicht bestimmbar ist.

Dann gibt es noch Messfehler, wie genau ist ein Pixel überhaupt bestimmbar?

Der einfachste Weg einen Fehler zu verstecken sind die Farbnuancen zu reduzieren und genau das vermute ich in vielen Darstellungen.

Der Farbraum ist in einem Dreieck definiert, mit 10 bit und mehr wird nur der Masstab (Zwischenwerte) verändert aber nicht der extremste Punkt in der Fläche.

Im Zentrum ist der Weisspunkt.

Antwort von rkunstmann:

Das ist mir bewußt. Aber es ist und bleibt eine Interpolation. Und die Frage ist wie gut das überhaupt sein kann - und ob man das gesamte Farbspektrum so wirklich darstellen kann.

Das frage ich mich halt auch. Ein typisches Bandingproblem bei einer Kamera mit großem oder mittelgroßen Sensor, wie der GH4 stell zum Beispiel das Bokeh dar. Hier werden ja schon physikalisch Farbwerte zusammengefasst. Auch wenn dann 4K 8bit Match in 2K 10 bit Matsch gerechnet wird bringt das doch nichts, weil die Differenzierung schon weg ist. Ähnlich stellt es sich bei einem strahlend blauen Himmel dar. Die Werte klippen ja nicht überall, sondern nur an einer bestimmten Übergangskante (Sorry mir fehlt einfach das Vokabular, um mich besser auszudrücken).

Antwort von Tiefflieger:

Das ist mir bewußt. Aber es ist und bleibt eine Interpolation. Und die Frage ist wie gut das überhaupt sein kann - und ob man das gesamte Farbspektrum so wirklich darstellen kann.

Das frage ich mich halt auch. Ein typisches Bandingproblem bei einer Kamera mit großem oder mittelgroßen Sensor, wie der GH4 stell zum Beispiel das Bokeh dar. Hier werden ja schon physikalisch Farbwerte zusammengefasst. Auch wenn dann 4K 8bit Match in 2K 10 bit Matsch gerechnet wird bringt das doch nichts, weil die Differenzierung schon weg ist. Ähnlich stellt es sich bei einem strahlend blauen Himmel dar. Die Werte klippen ja nicht überall, sondern nur an einer bestimmten Übergangskante (Sorry mir fehlt einfach das Vokabular, um mich besser auszudrücken).

Ich glaube Du hast viel zu hohe Ansprüche an die Genauuigkeit der Darstellung?

- Mit einer 3-Chip Kamera sind die RGB Pixel deckungsgleich (Pixelshift und Aberration mal weggelassen). Und somit exakt definiert.

(Bei einem Camcorder ist auch das Objektiv definiert fix und die Kennwerte im Bild einberechnet (Serienstreuung)).

- Bei Singlesensorkameras ist je nach Bildauflösung in Luma und Chroma eine andere Gewichtung für Farbwerte definiert.

Ein genauer Farbwert zu einem Bildpunkt ist gar nicht messbar.

Ich behaupte mal, dass es mit Debayering 10 bit braucht um kein Banding zu erhalten, bzw. das Bildprozessing Farbwerte vorgibt (und ggf. Farbnuancen zugunsten von Farbfehlern reduziert).

Gruss Tiefflieger

Antwort von WoWu:

Das sind so Gedankenspielchen die sich aus falschen Vorstellung herleiten, weil nur wenig darüber nachgedacht wird, was Unterabtastung eigentlich ist und die Bezeichnung dazu verleitet, das auch die physikalischen Pixel des Sensors zu beziehen.

Unterabtastung ist eine Datenreduktion, die dadurch erreicht wird, dass weniger Chromawerte aus den bestehenden Pixels errechnet werden, dafür aber für jeden der errechneten Werte mehr Pixels herangezogen werden. Das Farbergebnis ist damit weniger aufgelöst als beispielsweise bei 4:2:2 oder gar 4:4:4.

Es geht also nicht um weniger Pixels, die dabei abgetastet werden, sondern darum, dass mehr Pixels zu einer Mischfarbe zusammenfasst werden, dadurch aber ein weniger differenziertes Bild ergeben.

Unterabtastung findet also (bei 1-Chip) im De-bayering-Komplex statt und eine falsche Farbe bleibt gegenüber 2 weniger interpolierten oder 4 originalfarben immer eine Unterabtastung.

Was die 10 Bit betrifft ... solange das Signal irgendwann mal in 8 Bit gemapped war, gibt es keinen weiteren Farbwert mehr vom Sensor.

Man kann jetzt in 10 Bit ummappen. dabei wird üblicherweise ge-dithert, um die fehlenden Werte zu füllen. Ausserdem wird immer in einem Pixelraster gedithert, sodass indizierte Farbdarstellung stattfindet, was sich schon häufig in der 10Bit Version dann als Banding auswirkt, spätestens aber beim Rücksprung nach 8 Bit.

Da gibt es gute oder weniger gute Algorithmen, aber es gibt keine Farbe vom Sensor., was 10 Bit eigentlich auszeichnet.

Sonst könnten wir, im Extremfall, alles wieder in 2 Bit machen (spart kolossal) und errechnen uns daraus - was wir wollen, 12,14, 16 Bit was immer man will.

Es geht aber nicht, auch nicht bei 8/10 Bit. Ganz im Gegenteil. Bei solchen Verfahren muss man auch mit den Nebeneffekten klar kommen, die hier nicht zur Diskussion stehen.

Was die 3 Farben einer 4- Pixels Fläche betrifft, gelingt das nur, wenn zwei doppelbrechende Filter eingesetzt sind, oder in meinem De-bayering zeitliche Filter verwende.

Beide Methoden kappen vorwiegend hohe Ortsfrequenzen. Nun muss man sich fragen, in welchen Grössenordnungen das liegt.

Bei sehr grossen Sensoren liegt das eher im Bereich der ohnehin eingebauten OLPF und bei Verwendung von doppelbrechenden Filtern, stellt sich die Frage, sie anstelle der OLPF zu verwenden. Vorteil ist, dass man billige Objektive einsetzen kann, denn weder die spatiale Auflösung, noch die Abbildungsleistung ist hinterher besonders hoch.

Ich glaube, das war's so im Wesentlich.

Antwort von rkunstmann:

Das ist mir bewußt. Aber es ist und bleibt eine Interpolation. Und die Frage ist wie gut das überhaupt sein kann - und ob man das gesamte Farbspektrum so wirklich darstellen kann.

Das frage ich mich halt auch. Ein typisches Bandingproblem bei einer Kamera mit großem oder mittelgroßen Sensor, wie der GH4 stell zum Beispiel das Bokeh dar. Hier werden ja schon physikalisch Farbwerte zusammengefasst. Auch wenn dann 4K 8bit Match in 2K 10 bit Matsch gerechnet wird bringt das doch nichts, weil die Differenzierung schon weg ist. Ähnlich stellt es sich bei einem strahlend blauen Himmel dar. Die Werte klippen ja nicht überall, sondern nur an einer bestimmten Übergangskante (Sorry mir fehlt einfach das Vokabular, um mich besser auszudrücken).

Ich glaube Du hast viel zu hohe Ansprüche an die Genauuigkeit der Darstellung?

- Mit einer 3-Chip Kamera sind die RGB Pixel deckungsgleich (Pixelshift und Aberration mal weggelassen). Und somit exakt definiert.

(Bei einem Camcorder ist auch das Objektiv definiert fix und die Kennwerte im Bild einberechnet (Serienstreuung)).

- Bei Singlesensorkameras ist je nach Bildauflösung in Luma und Chroma eine andere Gewichtung für Farbwerte definiert.

Ein genauer Farbwert zu einem Bildpunkt ist gar nicht messbar.

Ich behaupte mal, dass es mit Debayering 10 bit braucht um kein Banding zu erhalten, bzw. das Bildprozessing Farbwerte vorgibt (und ggf. Farbnuancen zugunsten von Farbfehlern reduziert).

Gruss Tiefflieger

Genau. Das meine ich ja:) Mir geht es ja gar nicht um den einzelnen Pixel per se oder 4k vs 2k. Ich frage mich nur, ob man aus 8 bit 4k (zumal aus 420 h.264) wirklich 10 bit kriegt und das bezweifle ich.

Ich habe die GH3 und mir reichen 1080p aus dem h.264 Auflösungstechnisch locker, aber die Farbdifferenzierung sehe ich kritischer. Gerade, wenn man mit Neat Video arbeitet, sind 8 bit halt nicht optimal. Klar ist das Jammern auf hohem Niveau und ich persönlich liebe alte Zeiss Jena Objektive oder Canon FDs an meiner GH3 + gescanntes Filmkorn, aber je besser das Ausgangsmaterial, desto mehr Freiheiten für mich:) Das ist alles, was ich sage... 8 bit Banding ist immer dann ein Problem, wenn man etwas "künstlerischer" graden will; Und das will ich halt manchmal. Gerade im Bereich Musikvideo oder Werbung kann das auch Sinn machen.

Also generell: Ich glaube die GH 4 ist eine tolle Kamera! Aber ich bezweifle, ob solche Milchmädchenrechnungen aufgehen. Prinzipiell hoffe ich, dass mein Skeptizismus zu Unrecht existiert, aber vergrößert dochmal ein 4k 4:2:0 Bild so weit, dass man 4x4 Pixel auseinander differenzieren kann. Wieviel Unterschiede bleiben da zu interpolieren? (Ich bin wirklich kein Experte, aber ich arbeite seit 13 Jahren mit After Effects und kenne meine Pixel;)

Antwort von rkunstmann:

Das sind so Gedankenspielchen die sich aus falschen Vorstellung herleiten, weil nur wenig darüber nachgedacht wird, was Unterabtastung eigentlich ist und die Bezeichnung dazu verleitet, das auch die physikalischen Pixel des Sensors zu beziehen.

Unterabtastung ist eine Datenreduktion, die dadurch erreicht wird, dass weniger Chromawerte aus den bestehenden Pixels errechnet werden, dafür aber für jeden der errechneten Werte mehr Pixels herangezogen werden. Das Farbergebnis ist damit weniger aufgelöst als beispielsweise bei 4:2:2 oder gar 4:4:4.

Es geht also nicht um weniger Pixels, die dabei abgetastet werden, sondern darum, dass mehr Pixels zu einer Mischfarbe zusammenfasst werden, dadurch aber ein weniger differenziertes Bild ergeben.

Unterabtastung findet also (bei 1-Chip) im De-bayering-Komplex statt und eine falsche Farbe bleibt gegenüber 2 weniger interpolierten oder 4 originalfarben immer eine Unterabtastung.

Was die 10 Bit betrifft ... solange das Signal irgendwann mal in 8 Bit gemapped war, gibt es keinen weiteren Farbwert mehr vom Sensor.

Man kann jetzt in 10 Bit ummappen. dabei wird üblicherweise ge-dithert, um die fehlenden Werte zu füllen.

Da gibt es gute oder weniger gute Algorithmen, aber es gibt keine Farbe vom Sensor., was 10 Bit eigentlich auszeichnet.

Sonst könnten wir, im Extremfall, alles wieder in 2 Bit machen (spart kolossal) und errechnen uns daraus - was wir wollen, 12,14, 16 Bit was immer man will.

Es geht aber nicht, auch nicht bei 8/10 Bit. Ganz im Gegenteil. Bei solchen Verfahren muss man auch mit den Nebeneffekten klar kommen, die hier nicht zur Diskussion stehen.

Was die 3 Farben einer 4- Pixels Fläche betrifft, gelingt das nur, wenn zwei doppelbrechende Filter eingesetzt sind, oder in meinem De-bayering zeitliche Filter verwende.

Beide Methoden kappen vorwiegend hohe Ortsfrequenzen. Nun muss man sich fragen, in welchen Grössenordnungen das liegt.

Bei sehr grossen Sensoren liegt das eher im Bereich der ohnehin eingebauten OLPF und bei Verwendung von doppelbrechenden Filtern, stellt sich die Frage, sie anstelle der OLPF zu verwenden. Vorteil ist, dass man billige Objektive einsetzen kann, denn weder die spatiale Auflösung, noch die Abbildungsleistung ist hinterher besonders hoch.

Ich glaube, das war's so im Wesentlich.

Oder so ??? Verstehe ich zwar nicht klingt aber gut:)

Antwort von mediavideo:

Das mit den 10 bit aus 8 bit Pixeln ginge theoretisch schon, nur leider in der Praxis nicht.

Ich lasse mal die Rundungsproblematik weg, die das Ergebnis an sich schon sehr fragwürdig macht.

Das ist ganz einfach herzuleiten:

Wenn ich aus einer Überabtastung mit 8 bit letztendlich 1920 x 1080 Pixel in 9 oder 10 bit haben möchte ist das nur dann möglich:

Ich brauche mindestens 2 Pixel pro R/G/B Farbe um von 8 auf 9 bit zu kommen und mindestens 4 Pixel pro Farbe um von 8 auf 10 bit zu kommen (ergibt plus einen Zwischenwert bei 9 bit und plus 3 Zwischenwerte bei 10 bit).

Soweit zur Theorie, die man probieren kann, aber:

Die Rauschschwelle bei Sensoren liegt bei einer Pixelkantenlänge von 6µm (also ein S35 Chip mit 4k Auflösung - Chipgröße siehe Link unten).

Wir brauchen von 8 auf 9 bit: 6 Pixel (2R/2G/2B), also min. 3x3 Matrix und da sind wir sofort unter 6µm Pixelkantenlänge und das Rauschen wird uns schon einen Teil oder den ganzen Bit-Zugewinn zunichte machen.

Bei 8 auf 10 bit brauchen wir schon 12 Pixel (4R/4G/4B), also min. 4x4 Matrix und das Rauschen wird noch deutlich größer.

Wir reden gar nicht von der geänderten Vorverarbeitung bei den asymetrischen Pixelstrukturen je nach verwendeter Ausleseauflösung (4k/UHD oder 2k/HD) ...

Und dann rechnen wir das mal zur Veranschaulichung mit der Chipgröße:

Da die Optiken im Videobereich meist nur bis S35 ausgelegt sind ( Chipgrößen siehe:

https://www.slashcam.de/tools/sensor-vergleich.pl ):

8 auf 9 bit: 5760 Pixel (Breite) auf 24,89mm sind 4,32µm Pixelbreite.

8 auf 10 bit: 7680 Pixel (Breite) auf 24,89mm sind 3,24µm Pixelbreite.

8 auf noch mehr bit: oh jeh ...

Zum Vergleich:

1/3 Zoll - 3 Chip - Sony, Canon, ... HD Camcorder: 1920 Pixel auf 5,23mm sind 2,72µm Pixelbreite (Das Rauschverhalten will nun wirklich keiner bei hochwerigen available Light Kameras haben)

Größere Sensoren sind auch keine so gute Lösung:

1. Das mit dem Fokus einstellen wird immer problematischer (Tiefenschärfe).

2. Die speziellen Linsenpreise explodieren irgendwann.

Antwort von WoWu:

Ich hatte das so verstanden, dass aus einem fertigen 8 Bit Endformat ein 10 Bit Signal gemacht werden soll.

An den Sensoren besteht heutzutage ja eh kein Problem mehr denn dass Pixel derart ineffizient Ladungsmengen aufnimmt, dass im Verhältnis zum Rauschen nur 8 Bit bedient werden, gibt es doch in heutigen Kameras gar nicht mehr.

Meistens haben wir es am Sensor doch eh mit 11-14 Bit zu tun.

Ich hatte das nicht so verstanden, dass mit Arrays "ladungsloser" Pixels ein 10 Bit Superpixel entstehen sollte.

- Oder war das so zu verstehen- ?

Aber mal abgesehen davon, ist oben in der Rechnung noch ein kleiner Denkfehler, weil sich in der Addition von Pixelwerten der Rauschwert um den Wert der Quadratwurzel aus der Anzahl der benutzten Pixels verringert.

Im Fall von 4 Pixels also um die Wurzel aus 4, also 2.

Damit verdoppelt sich der Störabstand. Man hat also gegenüber z.B. 40e (Noise) - Ladungsanteilen, nur noch 20e Störsignal und damit eine Ratio von 2:1 (40/20).

Insofern ist Pixelbinning ja kein neues Thema.

Antwort von Angry_C:

.....

Von 4k 8bit kommt man aber niemals auf 10bit HD für alle drei Kanäle.

So etwas muss schon ganz früh nach dem Sensor passieren.

...

Aber setzt hier nicht die GH2/3-Hackcommunity an? :-) Also dürfte es zumindest per Hack dann irgendwann machbar sein wenns in der Post nicht funktioniert wie beschrieben ... oder?

Es gibt nur eine GH2 Hackcommunity, und auch da ist der letzte Fortschritt schon Jahre her. Seitdem lässt der Russe sich nur noch die Kohle für die neuen Bodies spenden und freut sich nen Ast... :-)

Antwort von WoWu:

So etwas muss schon ganz früh nach dem Sensor passieren.

Das muss sogar AUF dem Sensor passieren, denn es ist immer ein Verhältnis aus Ladungsmenge und Störabstand.

Beispiel:

Ein Chip kann 18.000 Elektrons bis Full Well aufnehmen, bei einem Readout Noise von 9 electrons.

Das „Signal to Noise“ Ratio ist also 18.000/9 = 2.000.

Das heißt, dass das Pixel 2.000 Graustufen darstellen kann, also einer Bit-Tiefe von 11 Bit.

Hat man aber. zwei Sensoren der identischen Pixelzahl mit einem Dynamikbereich von 10.000 (13,5 Blenden) bei einer Sättigung von 100.000 Elektronen bei einem Read-Noise von 10, der andere Sensor eine Sättigung bei 10.000 Elektronen und einem Read Noise von 1., also ein

identisches Verhältnis: (100.000 zu 10 oder 10.000 zu 1), so kommt man trotzdem auf unterschiedliche Leistung.

Betrachtet man 18% Grau beider Sensoren, wenn sie voll geladen sind und bei 100% Weiß erzeugen, wird der erste Sensor 18% Grau bei 18.000 Elektronen und der zweite Sensor bei 1.800 Elektronen darstellen.

Das SNR Ratio ist bei dem ersten Sensor bei Wert 134, also 7 Blenden und bei dem zweiten Sensor bei 42 (5,4 Blenden) obwohl beide Sensoren die vermeintlich gleiche Dynamikrange haben.

Die höhere (effektive) Kapazität des ersten Sensors bewirkt also eine 1,5 Blenden besseres Rauschverhältnis bei 18% Grau.

(Vorzug der grösseren Pixels).

Und je kleiner die Pixels werden, umso schlechter wird dies Verhältnis.

Und wenn der Sensor diese Ladungsmengen nicht packt, dann kannst Du hinterher auch nichts mehr in der Post (ausser Dither) korrigieren.

Antwort von McReedy:

Was man beim Thema 4K nicht missachten sollte ist die Auflösung der Optik. Da sogar "professionelle" Objektive bei Vollformat selten über 2300Linien auslösen können (im Zentrum) kann man sich vorstellen das eine Farbunterabtastung nicht so wichtig ist wie die eingesetzte Farbtiefe. 10bit mit 1024stufen schafft gerade so noch ein stufenfreies Bild (optisch zumindest), bei 8bit mit 256 stufen wirds ohne dithering nicht mehr funktionieren (vor allem im Log!).

Mich reizt beim Gedanken an 4K weg vom Pixel als Maßeinheit zu kommen, und die Physik der Optik im Bewegtbild wieder zu erleben.

Antwort von Tiefflieger:

8 bit ist "true color" und stufenfrei (ohne Banding).

Mit ungenauer Verarbeitung und Reduktion unter 8 bit Farbtiefe endstehen "Stufen".

(Und Amateurcamcorder können auch den Bereich oberhalb 235 mit Werten bei der Aufnahme versorgen)

Aber mit 10 bit Aufnahme und höher und 10 bit bei Darstellung ist das Problem nicht mehr sichtbar.

Auch ein 6 bit Bild bleibt in 10 bit Darstellung ein 6 bit Bild :-)

Antwort von Frank Glencairn:

Der Punkt ist, daß wir hier immer von lupenreinen, mathematisch sauberen Pixeln reden, die in der freien Wildbahn überhaupt nicht vorkommen, nachdem ein H264/65 oder ProRes einmal drüber gewalzt ist. Eigentlich ist schon nach dem Debayering Sense und große Teile des Bildes nur "erfunden" bzw. geschätzt.

Antwort von wolfgang:

Wenn man das hier so liest - und ich verstehe die technischen Details hier sicherlich nicht, dann frage ich mich, was das in der Praxis bedeutet. Sollte man da nicht eher froh sein, wenn wenigstens ein HD Bild mal mit preiswerteren Kameras in 10bit und wenigstens 4:2:2 vorliegt? Oder ist das auch nur noch "erfunden" oder "geschätzt" (mal abseits der philosophischen Diskussion ob wir mit unseren bildgebenden Verfahren das nicht immer so machen).

Aber Pixel der Anzahl nach sind nicht alles. Nur weil 4K drauf steht - wenn das erst nur 4:2:0 mit 8bit ist, frage ich mich schon was man davon hat?

Antwort von sgywalka:

Idee- G-7!

was ist dann mit der Panasonic G7 die die specs der Gh4

hat aber NUR FULL-HD darf/kann/wird.....und des ganze für

499,-euro.

Klaro?

Ist des dann schlecht?....

Die Sony-leute haben ja mit der rx-10 gut angefangen und

aus Gründen ( die wh. Schutz des Produktes x y z = maybe fs800)

die wir net kennen is der neue Chip in einer APS-C a6000 (und

einmal richtig/ auch codec/und net wieder 4 Modelle/Knopferl da /Knopferl

weg..das geht 2014 nicht mehr) noch nicht der, der es crips könnte etz.

Und so weiter...Die Grenzen werden immer feiner und nativ-konstruktive

Kastrationen werden so lange gemacht, wie ein Markt mitrennt-und bei

jeder Messe die Heerscharen sabbelnd mit gezücktem Geldbörsel gieren...

was wird mit der G-/ sein...????

Nur so ne Idee.. halt

Antwort von rudi:

Das mit den 10 bit aus 8 bit Pixeln ginge theoretisch schon, nur leider in der Praxis nicht.

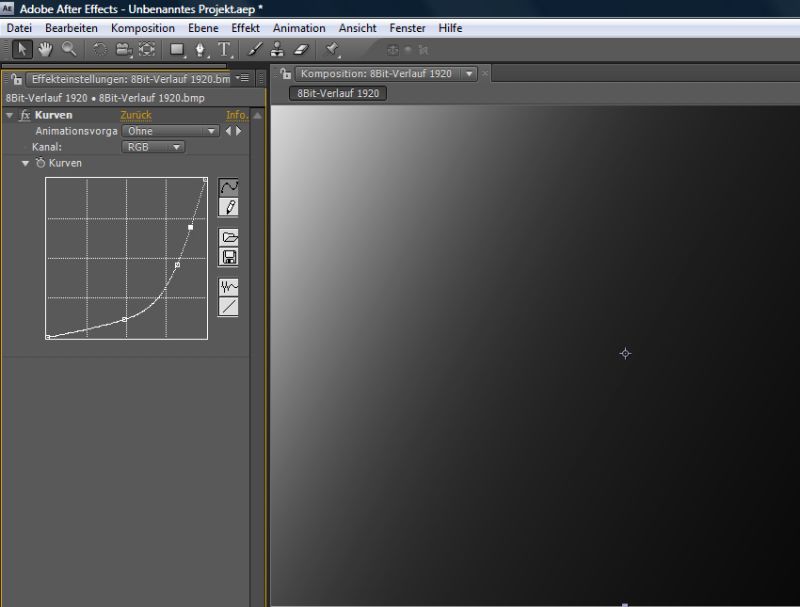

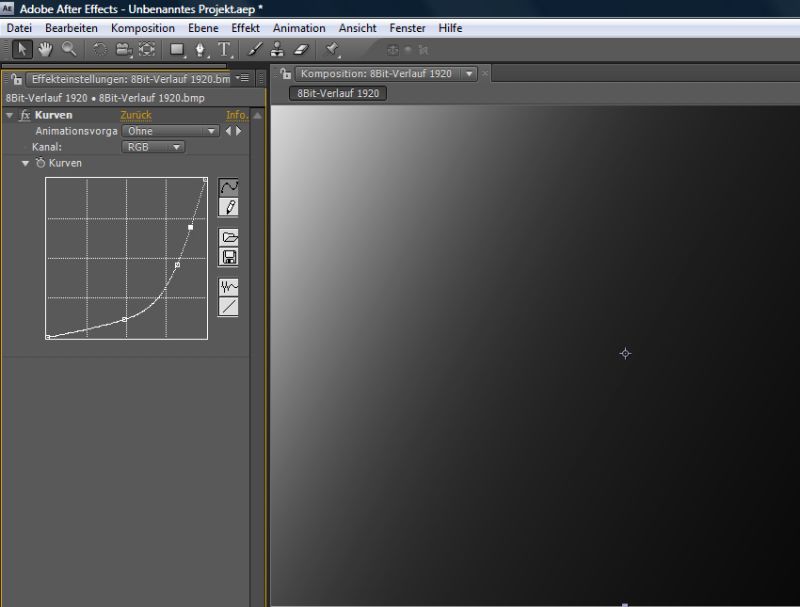

Ich habe dem Artikel jetzt noch mal ein Update verpasst, in dem wir einfach mal praktisch in After Effects einen 8 Bit Layer 50 Prozent runterskaliert haben. Und was soll ich sagen, in der Praxis werden hier aus 8 Bit Farbtiefe offensichtlich sowas wie 10 Bit :)

Selbst wenn man jetzt die Sensor-Gedanken komplett außen vor lässt, sollte dieser Versuchsaufbau doch in jedem Fall auch mit einem 4:2:0 4K File funktionieren, oder?

Ich kann mir selber Grenzfälle vorstellen, in denen das nicht ganz einer echten 10 Bit-Aufnahme entsprechen kann (wenn alle 2 Pixelkanten genau auf 8Bit-Grenzen fallen würden). Aber in der Realität dürfte man hier schon sehr nahe an einer echten 10 Bit Aufzeichnung landen (wenn der Sensor vorher die >10 Bit Dynamik entsprechend auf 8 Bit gestreckt hat.

Antwort von PaterIltis:

Ich habe dem Artikel jetzt noch mal ein Update verpasst, in dem wir einfach mal praktisch in After Effects einen 8 Bit Layer 50 Prozent runterskaliert haben.

Irgendwie fehlen bei dem Update die beiden Bilder.

Antwort von WoWu:

Die Frage ist ja immer, wovon wir reden.

Reden wir von der Reproduktion eines optisch aufgenommenen Bildes, also von der Reproduktion der Wirklichkeit oder reden wir von mathematisch erstellten Farben, die der Rechner an den von ihm bestimmten Plätzen für Richtig hält.

Dann muss man gar nicht erst runter skalieren sondern mapped einfach um.

Ich gebe Frank und Wolfgang da Recht, dass es eigentlich bei HD schon angefangen hat, gar nicht mehr zu passen.

Entweder sind die Objektive zu teuer, oder generieren keine Kontraste und Punktbilder, die über 20 Pixels streuen, das Moire ist zu gross oder die Farbwerte bereits künstlich erzeugt und Details durch schwarz/weisse Linien wieder dazugefiltert und anschliessend werden dann noch, wenn schon hohe Ortsfrequenzen übertragen werden, diese vom Codec abgeschnitten (im ungünstigsten Fall, alles zusammen).

Die Industrie hat uns gelehrt, ein schlechtes Bild als "gutes Bild" zu definieren und macht jetzt immer weiter.

Sie sollen erst einmal ein wirklich gutes HD Herstellen und damit die Möglichkeiten des menschlichen Auges ausschöpfen.

Wenn sie soweit sind, dann kann man mal weiter sehen, aber da sind sie noch nicht und solange brauche ich auch keine Rechnerkopien der Wirklichkeit.

@Rudi

Mediavideo hat zwar geschrieben, es geht 10 aus 8 Bit herzustellen und es ginge in der Praxis nicht ... hat aber einen Denkfehler gemacht, den ich aufgelöst habe, denn es geht und wird munter praktiziert .... durch die Zusammenlegung von Pixels, denn Übertragungswerte entstehen in den Ladungsmengen.

Er hat nicht gesagt, dass optische Farbeindrücke durch rechnerische Manipulation rekonstruiert werden können.

Und nach wie vor geht es bei Video um die Umsetzung natürlicher Bilder.

Antwort von wolfgang:

Also dass man "Zwischenfarben" gegenüber einem 8bit Vergleich erzeugen kann, wenn man mehrere Pixel kombiniert - keine Frage. Das wurde oben in der Diskussion auch durchaus bejaht. Danke für den Test der genau das nochmals erhärtet.

Dass wir hier IMMER von einer Abbildung der Realität aus der Maschine sprechen, nun ich wüßte nicht wie wir das umgehen sollten. Klar wären theoretisch 12bit mit echten 4:4:4 toller - statt Pixel zu interpolieren. Darum fragte ich ja ob es nicht Sinn macht, gleich mit 10bit 4:2:2 (extern) aufzuzeichnen.

Antwort von WoWu:

Absolut.

Nur hier wurde ja gerade das Gegenteil vorgeschlagen: 10 Bit aus einem Inhalt herzustellen, in dem keine echten Nuance enthalten ist sondern lediglich die grobe Struktur und dann alle Zwischenwerte künstlich hinzu zu fügen.

Das ist ja einwenig, wie Nachcolorieren von alten Filmen ... geht auch und sieht zum Teil nicht mal schlecht aus.

Wenn man also mal alle Artefacte, die dabei entstehen, ungeachtet lässt, stellt sich die Frage: "Was hat das noch mit Video zu tun" denn die abgebildete Wirklichkeit verhält sich ja nicht selten anders als die Algorithmen abbilden können und farbliche Übergänge (beispielsweise) eines grünen Blattes vor einem blauen Hintergrund und einem braunen Zweig werden von Algorithmen völlig anders aufgelöst als von einem Objektiv.

Von den Schattierungen mal ganz abgesehen.

Frank moniert schon völlig zurecht, dass es schon jetzt nicht wirklich funktioniert.

Sie sollen doch in der Tat erst einmal vernünftige HD Bilder generieren.

Ich habe auch den Test nicht so verstanden, dass durch Binning von Pixels im Sensor die höhere Farbtiefe erzeugt wird, sondern aus einem 8 Bit Signal in der Post ein 10 Bit Signal gemacht wird.

Antwort von domain:

Macht bestimmt Sinn. Man braucht dann keinen Weißabgleich mehr und kann ruhig falsch belichten.

Wenn ich als Hochzeitsfilmer Aufsehen erregen wollte, dann würde ich auch mit externem Atomos Samurai und Steadycam inkl. Weste herumflitzen.

Boah.. Herr Kameramann, was hat denn ihre Ausrüstung gekostet? Müssen ja tolle Filme werden, was kostet denn so ein Hochzeitsvideo von ihnen, wenn man fragen darf ;-).

Antwort von wolfgang:

Nur wie macht man das praktisch mit einem erträglichen Aufwand? Ich meine, ich kann mir vorstellen ein Ninja oder Blade (können beide nur HD) an eine Kamera zu hängen, diese nach besten Vermögen einzustellen - und dann als HD das 10bit 4:2:2 direkt abzugreifen. (halt nach dem was die Kamera hergibt)

Klar wird sowas auch noch korrigiert - wobei gerade die bsseren Einstellmöglichkeiten eines Samurai Blades bereits bei der Aufnahme nochmals diese aufwerten helfen, was Luminanz und Farbjustierung angeht. Das sollten wir nicht vergessen, dass dies - bei aller Künstlichkeit - noch immer eine dominante Rolle spielt.

Antwort von otaku:

@wowu - ich würde gerne nochmal etwas mehr zu den objektiven hören, denn der sachverhalt ist mir nicht ganz klar.

im bereich billige objektive mag ich die alten nikon ai-s objektive sehr, die sind jetzt gut 30 jahre alt, und von ihrer vergütung her natürlich nicht mehr im ansatz up to date, verglichen mit selbst billigen aspherischen linsen z.b. von lumix sind die sogar von ihrer linsen geometrie schrott, das ist mir alles klar. aber die frage ist, diese objektive waren in der lage einen 35mm film anständig scharf zu belichten, so ein 35mm negativ ist um ein vielfaches grösser als 35mm film negativ, weil quer und nicht hochkant belichtet.

ich habe auch damals mit dem aufkommen der trommelscanner schon kb negative scannen lassen mit datenmengen von 40-80mb/frame. das war alles zuppi, kein problem. wieso sprechen viele davon, das so eine optik für digitales gammel 4:2:0 8bit schrotti video nicht mehr ausreicht?

ich bekomme den zusammenhang in meinem kopf nicht erklärt.

eine zweite frage zur interpolation von 8bit zu 10bit. quantel hatte im henry/editbox ein verfahren das sich dynamic rounding nannte, das war eine art interpolation von 8 zu 10 bit. das hat in der praxis super funktioniert, auch wenn man nie wusste wie es dann auf dem band aussah, aber in der kiste war es klasse. hast du ne idee was die da gemacht haben? weil bänder haben wir ja nicht mehr, damit währe das verfahre heute ja durchaus empfehlenswert.

Antwort von mediavideo:

@rudi

Ja das ist für mich keine Überraschung, das habe ich ja genau so geschrieben:

Wenn Du 4R/4G/4B Pixel in 8 bit hast, dann kannst Du die 3 Zwischenwerte für 10 bit beim 50%-skalieren mathematisch erzeugen (also von UHD -> HD).

Und mein vorangestellter Satz im letzten Post mit der Rundungsproblematik bleibt aber, das hast Du ja auch genau so erwähnt - Zitat:

"Ich kann mir selber Grenzfälle vorstellen, in denen das nicht ganz einer echten 10 Bit-Aufnahme entsprechen kann (wenn alle 2 Pixelkanten genau auf 8Bit-Grenzen fallen würden). Aber in der Realität dürfte man hier schon sehr nahe an einer echten 10 Bit Aufzeichnung landen (wenn der Sensor vorher die >10 Bit Dynamik entsprechend auf 8 Bit gestreckt hat."

Also Vorsicht: Das Ergebnis ist eben nicht das Originale 10 bit HD-Signal, es ist ein ähnliches mit einem gewissen Fehleranteil zum Original.

Aber Du verkennst vielleicht das Problem bei einem Camcorder:

Beim Einchip-Camcorder (z.B. 4 MPixel) hast Du die 4R/4G/4B pro HD-Pixel nicht - das ist das Problem !!!

Du hast pro HD-Pixel nur 2R/1G/1B und da geht das mathematisch nicht mehr. Sobald Du Demosaicen machst sind die restlichen Werte nur geschätzt, da kannst Du auch "gezielt würfeln" - klar?

Deswegen brauchst Du, wie von mir vorgerechnent, eine ca. 32 MPixel Single-Chip (7680x4320) und den gibt es ja so nicht. Oder nimm mal einen micro4/3 Sensor mit 17.3 mm Breite, da hast Du dann bei 7680 Pixel in der Breite noch 2.25µm Pixelkantenlänge - das rauscht dann schon gewaltig ...

Und nochmal zu der Rauschproblematik:

Wowu macht da eine ganz falsche Betrachtung, denn er sagt einfach dass mehr Pixel statistisch eine Rauschreduktion sind (stimmt ja auch, allerdings nur bedingt) und deswegen wäre es keine Rauschzunahme in der Summe. Das ist falsch, denn er tut so als ob der Sensor beim Verkleinern der Pixel nicht deutlich mehr rauschen würde.

Die richtige Sichtweise wählen und der Zusammenhang wird klar:

Man muß die statistische Rauschreduktion durch die mehr Pixel dem Rauschzuwachs der sinkenden Pixelkantenlänge gegenüberstellen und schauen ob sich das aufhebt oder ein Faktor überwiegt. Und da überwiegt der Faktor der Rauschzunahme der kleineren Pixelkantenlänge. Warum? - Ganz einfach: Wenn man eine Grenzbetrachtung in Richtung sehr kleine Pixelkantenlängen macht, dann bekommt man nur noch Schneegestöber im dann sehr hoch aufgelösten Bild. Aber man kann aus dem "Schnee" durch Skalierung das Originalbild nicht mehr erzeugen. Damit sieht man, dass die Rauschzunahme durch die kleiner Pixelkantenlänge bei der Qualität deutlich überwiegt.

Etwas ganz wichtiges betrachtet Wowu schon mal gleich gar nicht:

Die Addition der einzelnen Maximalfehler, die bei z.B. 4 Pixeln dann auch mehr als 4 mal so groß werden (mehr: wegen der Sensorrauschenzunahme), allerdings dann statistisch viel seltener als die Maximalwerte vorher. Da aber der Mensch dieses "harte" Rauschen der höheren Maximalwerte sehr viel mehr wahrnimmt, ist dies ein deutlicher optischer Qualitätsverlust als ein kleineres und öfteres Pixelrauschen um den Mittelwert.

Aus den Gründen halte ich das in der Praxis für nicht sehr sinnvoll, auch wenn es in der Theorie bei idealen Bedingungen (siehe Bildbeispiel von SlashCam) recht gut klappt. Aber jeder darf dazu natürlich eine andere Meinung haben. Und ich wünsche ab jetzt viel Spaß dabei.

Antwort von WoWu:

Das ist falsch, denn er tut so als ob der Sensor beim Verkleinern der Pixel nicht deutlich mehr rauschen würde.

Nee, nee, nee. Deswegen hab ich die Ratio angegeben. das ist immer eine Verhältniszahl und Pixelbinning ist ja nun kein Zauberwerk und wird von diversen Firmen mit grossem Erfolg betrieben und es werden Ergebnisse bis 7:1 damit erzielt. Also erst sehr viel später flacht die Kurve ab.

Es stimmt also nicht, was Du sagst, sonst wäre Pixelbinning nur mit so grossen Pixels möglich, dass man es eigentlich schon gar nicht mehr braucht.

Die Addition der einzelnen Maximalfehler, die bei z.B. 4 Pixeln dann auch mehr als 4 mal so groß werden

Eben nicht, sonst gäbe es kein Pixelbinning.

Rauschen addiert sich nicht linear sondern nimmt nur, wie geschrieben zu.

allerdings dann statistisch viel seltener als die Maximalwerte vorher. Was immer das heissen soll. ??

"harte" Rauschen

Was ist hartes Rauschen ? Von welchem Rauschanteil sprichst Du ?

kleineres und öfteres Pixelrauschen um den Mittelwert.

Was ist ein "kleineres und öfteres Pixelrauschen?

Von welchem Rauschen sprichst Du hier.

Schliesslich kann man jeden der sieben relevanten Rauschanteile exakt in ihrer Entstehung und der Grössenordung bestimmen.

Es wäre also hilfreich, hier konkret zu sagen, welcher Rauschanteil das sein soll.

Nee, nee ... Das sind wohlklingende Worte, ohne Substanz.

Antwort von WoWu:

@ otaku

Bei einem Objektiv muss man ja sehr grundsätzliche Sachen unterscheiden:

Bei welcher Ortsfrequenz wir noch mit welcher MTF aufgelöst.

(Lassen wir also mal optische Verzerrungen und dergleichen zunächst beiseite).

Betrachten wir einmal die Anforderungen, die an Objektive gestellt werden, um ein Gefühl für die Grössenordnug zu erhalten, um die es hier geht.

Bleiben wir daher bei der Videoanwendung.

Die EBU schreibt für Objektive eine Modulationstiefe im Grenzortsfrequenzbereich von mehr als 80% (Bildmitte) vor.

Die Grenzortsfrequenz eines 2/3“ HD Systems mit 1280 aktiven horizontalen und 720 aktiven vertikalen Pixels liegt bei 66 LP/mm.

Bei einem 1080-Zeilen-System benötigt man bei 30 MHz bereits. 81 Lp/mm.

Auf der andern Seite schauen wir uns zum vergleich einmal Hochleistungsobjektive für Film und Video Anwendung an, um auch ein preisliches Gefühl zu bekommen.

Zeiss bietet ein Spitzenprodukt an, das rd 180 Lp/mm liefert und so um die 70.000 $ gekostet hat.

Nun haben wir den Rahmen abgesteckt.

Jetzt kannst Du Dir jeden beliebigen Sensor raussuchen und z.B. ein horizontales Mass (z.B. beim 4/3 Sensor, von 17,3 mm) ausrechnen.

Bei 4K (4000 gerundet) sind das dann rd. 117 Lp/mm die das Objektiv leisten müsste. Wird der Sensor bei gleicher Auflösung grösser, werden die Pixel grösser und die Anforderung entsprechend geringer.

Wird der Sensor kleiner, beispielsweise dieser 1/2.3 für 4k von Sony, dann landet man schon bei (5,7 mm) bei 350 Lp/mm. (350 LP/mm weil die Pixels nur noch 1,4 µ haben. Schau Dir mal die Wellenlänge von Grün bei einer mittleren Blende an :-))

Du siehst, wenn man nur die Objektivleistung der Broadcastanforderung erfüllen will, muss man entweder ziemlich gross mit dem Sensor werden, super spitzen Priems haben oder eben mit der Auflösung runter gehen.

Und noch ein Umstand. Schau Dir von den Objektiven mal die Punktbilder an. Dann wirst Du so etwas erleben, wie auf dem Bild.

(Das Musterpixel ganz links hat zum Vergleich 8 µ)

Du deckt also mit den Informationen des Objektivs immer gleich mehrere Pixels ab und je kleiner die Pixels werden umso heftiger ist das ... gleichwohl auch, je schlechter das Objektiv wird.

Wir sprechen also von guten Objektiven und einer guten Qualitätsanforderung. Wenn Camcorder ihren Schwerpunkt auf "kontrastreich" bei 20 Lp/mm legen, dann tun das auch einfache Objektive, aber sie unterscheiden sich dann eben nicht sonderlich von Handyqualitäten.

Antwort von mediavideo:

Wowu, was soll das ???

Nimm einen Chip mit 1 Pixel und 6µm x 6µm Kantenlänge, das Signal von dem Pixel gilt als "rauschfrei".

Jetzt mach daraus 4 Pixel mit je 3µm x 3µm und jedes der 4 Pixel rauscht nun (also wesentlich mehr wie das rauschfreie 6x6µm Pixel Signal).

Das Rauschen der 4 Einzelpixel wird durch das Zusammenfassen der 4 Pixelwerte zum Summensignal zwar durch statistische Effekte besser, aber der Rauschabstand bleibt immer schlechter als bei einem 6x6µm.

Und wenn wir jetzt weiter auf 9 Pixel mit 2µm gehen, dann wird der Rauschabstand des Summensignals zum 6x6µm immer schlechter und zwar je mehr wir aufsplitten ...

Ist das Dein Ernst: Seit wann kann man ein verrauschtes Siganal durch getrennte noch viel rauschbehaftetere Signalübertragung verbessen ???

Und nun ist es auch wirklich genug zu dem Thema.

Antwort von WoWu:

Du musst differenzieren zwischen Rauschen (als effektiver Wert) und dem Störabstand, als Verhältnis von Ladungskapazität zum effektiven Rauschanteil.

Hier geht es um Störabstand und der verändert sich bei Addition von Ladungspotential um Quadratwurzel aus der Anzahl der benutzten Ladungselemente.

Sowas ist Basiswissen und offenbar haben es alle Hersteller begriffen, die Pixelbinning betreiben, also fast alle.

Und das Pixelbinning funktioniert, wird hier ja sicher nicht bestritten. -oder etwa doch-?

Ich schlage vor, Du liest mal über Mengeneffizienz bei Sensoren nach.

Antwort von otaku:

@wowu - danke für die antwort - jetzt hab ich zumindest ne idee womit ich mich mal auseinandersetzen kann.

Antwort von domain:

Dieser Grauverlauf mit der stark verbogenen Gammakurve und der abnormal starken Spreizung der Lichter ist ein gutes Beispiel dafür, was selbst mit 8 Bit noch möglich ist. Also ein ausgewachsener Teal Orange Effekt ist immer realisierbar.

Hier ist ein Banding ja kaum erkennbar, höchstens ganz zart.

Wisst ihr, wie Banding wirklich aussieht? ;-)

Antwort von Cam1234:

@wowu gibt es zu Deinem Buch irgendwo ein Update (4K). Habe die Version 9.0.5 Edition 1 von 2008?

Danke.

VG

Antwort von WoWu:

Selbstverständlich.

Kontaktier mich mal über

http://provideome.de

Ich schick Dir dann den Update-Link

Antwort von prophet:

Ich glaube, es werden in dieser Diskussion (und überall im Internet, wo es Raw und bits geht) zu viele Begriffe in einen Topf geworfen, die auseinander gehören:

Quantisierung bzw. Wertediskretisierung eines Signals (und die Auflösung des Quantisierers)

Auflösung des Signals selbst (also unterscheidbare Tonwerte in unserem Fall)

IMO, behandelt der Slahcam-Artikel nichts anderes, als den ersten Begriff. Deren Behauptung ist mathematisch vollkommen in Ordnung: für eine rundungsfehlerfreie "Mischfarbe" von 4 Pixeln müsste man die Quantisierungsauflösung um ld(4)=2 bits erweitern (analog zu Fixpunktarithmetik, wo man die letzten 2 bits als Nachkommastellen betrachten kann).

Zur Diskussion über 2: ob diese Pixel nun sinnvolle Tonwerte beinhalten oder verrauscht sind, steht auf einem anderen Blatt, ändert aber nichts an der Behauptung von oben. Im Gegensatz zum (gewollten) Verlust der spatialen Auflösung, findet kein Verlust der Tonwerteauflösung durch Re-Quantisierung von 8->10bit statt.

Dies wurde von Slashcam im (zugegebenermaßen viel zu) idealem Fall beispielhaft vorgeführt.

Das Probelm an ihrem Beispiel ist allerdings, dass es dort nur der Liminanzkanal (oder 4:4:4 gesampltes Bild mit Graustufen) gezeigt wurde.

Beim Downsampling eines 4:2:0 4K-Singal auf FullHD, würde nur die Luminanzauflösung 10bit "erhalten". Die Chroma-Werte "bleiben" nach dem Downsampling weiterhin bei 8 bit, da es hier nur einen Wert pro Farbkomponente und pro 2x2 Region gibt.

Daher ist die Behauptung im Artikel nur halb richtig. Das Ergebnis nach dem Downsampling ist so eine Art 1080p 4:4:4 10:8:8 bit ;-)

Edit: angepasst für bessere Textverständlichkeit

Antwort von WoWu:

Das stimmt nicht so ganz, weil die Farben bereits indiziert sind.

Nehmen wir einen 12 Bit Sensor, der 4098 Helligkeitswerte abgibt und mappen den in ein 709 Datenkanal in 219 Werte; dann werden jeweils 18 individuelle Lumawerte zu einem einzigen Wert gefasst.

17 dieser 18 unterschiedlichen Originalwerte sind unwiderruflich verloren und zu keinem Zeitpunkt mehr bekannt .

Sie können bestenfalls mathematisch durch irgendwelche Wahrscheinlichkeiten aufgefüllt werden, was allerdings nicht mit den realen Werten am Sensor übereinstimmen muss.

Eine Reproduktion ist damit nicht erfüllt.

Die Werte werden bei einer solchen Interpolation gedithert, also nach einem -mehr oder (meist) weniger guten Algorithmus mit einer Pixelstruktur aufgefüllt.

Ausserdem hat das mit dem De-bayering bzw. der Abtastung nun gar nichts zu tun, denn es ist völlig Wurscht, an welcher Stelle man das Mapping ändert.

Ausserdem haben wir es sowieso nur mit Helligkeitssignalen zu tun, ob das nun das Luma von Grün oder einer andern Farbe ist, das ist gehupft wie gesprungen.

Verlust der spatialen Auflösung, findet kein Verlust der Tonwerteauflösung statt.

Dies wurde im (zugegebenermaßen viel zu) idealem Fall beispielhaft vorgeführt.

Mal ganz abgesehen davon, dass es gar nicht um den Tonwertverlust geht sondern darum, dass eine Tonwerterweiterung nicht stattfindet.

Das ist ein kleiner, aber feiner Unterschied. -Nämlich genau das Gegenteil-.

Würde das so prima funktionieren, gäbe es keine teuren Kameras, die 10,12 oder mehr Bit an Tonwerten durchreichen. RAW könnte man sich auch schenken und damit auch alle teuren Aufzeichnungsverfahren und Schnittstellen und Monitorhersteller könnten auf schnelle Hardware verzichten.

- Funktioniert leider in nichts weiter, als in einer Theorie - bzw. einer Phantasie.

Komisch, warum werde ich den Eindruck nicht los, Mediavideo hat sich nur einen andern Nick gegeben und versucht es jetzt nochmal.

Denn an der Substanz hat sich nichts geändert.

Antwort von Kabe:

Hier werden ja munter verschiedene Sachen durcheinander geworfen ;-)

Fangen wir erstmal mit der Luminanz an: Selbstverständlich lassen sich dort 4 8-bit Pixel zu einem echten 10-Bit Pixel verrechnen. Das passiert ohne jeden Rechenfehler durch Runden! Dafür muss man die 4 Pixelwerte einfach nur addieren. Da die 4 Pixel i.d.R. nicht die gleichen Werte haben, wird dabei selbstverständlich auch die Abstufung verbessert.

4* 256 geben max genau die 1024 von 10 Bit, weil die 2 zusätzlichen Bits genau 2^2=4 codieren…

Das ist auch in etwa das, was Slashdot mit seinem Gradienten gezeigt hat.

ABER:

Für die Chrominanzsignale gilt das so aber nicht: Auch dort kann man 4-Pixel zu einem zusammenfassen, und so das 4:2:0 auf 4:4:4 bringen. Neben der Problematik der Verschiebung der Farbebenen durch das Bayer-Pattern ist dieses Signal dann aber trotzdem nur 8-Bit, weil es pro 4 Pixel ja nur einen 8-Bit Quellwert gibt.

Das erzeugte Signal ist als0 4:4:4 mit echten 10 Bit Luminanz.

Antwort von prophet:

@Kabe: das ist ja 1zu1, was ich oben geschrieben habe... vielleicht etwas verständlicher :-)

@WoWu: die unglücklich gewählten Formulierungen im Text oben nachgebessert.

Antwort von TheBubble:

Langsam wird es hier abenteuerlich.

Fangen wir erstmal mit der Luminanz an: Selbstverständlich lassen sich dort 4 8-bit Pixel zu einem echten 10-Bit Pixel verrechnen. Das passiert ohne jeden Rechenfehler durch Runden! Dafür muss man die 4 Pixelwerte einfach nur addieren. Da die 4 Pixel i.d.R. nicht die gleichen Werte haben, wird dabei selbstverständlich auch die Abstufung verbessert.

Du verrechnest die Werte aber nicht zu "einem echten 10-Bit Pixel", sondern bildest nur einen Mittelwert, der mit Nachkommastellen eben gegebenefalls 10 Bit für seine exakte Darstellung benötigt.

Wenn Du mehr rausholen willst, müsstest Du Annhamen über vorhandenes Dithering machen, die in vielen Fällen wohl nicht zutreffen dürften.

Da könnte man auch anders auf mehr Bits kommen: Zwischen zwei Werten interpolieren wir linear einen dritten Wert. Nach dem obgen Schema wäre das ein "9-Bit Pixel".

All dies bringt aber gar nichts, wenn sauber schattierte großflächige Bereiche ohne Farbränder und echter verwertbarer Dynamikumfang benötigt wird, der Spielraum in der Nachbearbeitung erlaubt. Hier machen nur echte Abstufungen einen Sinn, mit obiger Methode ist da leider nichts rauszuholen.

Antwort von Kabe:

Langsam wird es hier abenteuerlich.

Du verrechnest die Werte aber nicht zu "einem echten 10-Bit Pixel", sondern bildest nur einen Mittelwert, der mit Nachkommastellen eben gegebenefalls 10 Bit für seine exakte Darstellung benötigt.

Unsinn, was soll denn ein „echtes Pixel“ sein?

Der Mittelwert entsteht einfach durch Addition, weil der Werteraum größer ist. Da braucht und wird man keinen Mittelwert mit Komma für konstruieren!

Es ist ja nun auch keineswegs so, dass das betreffende Verfahren neu wäre.

„Tausche 2D-Auflösung gegen Tonwertauflösung“ ist in der Bildverarbeitung ein alter Hut.

Antwort von TheBubble:

Der Mittelwert entsteht einfach durch Addition, weil der Werteraum größer ist. Da braucht und wird man keinen Mittelwert mit Komma für konstruieren!

?!?

„Tausche 2D-Auflösung gegen Tonwertauflösung“ ist in der Bildverarbeitung ein alter Hut.

Dann leg mal los, wie Du aus einer Bitmap, die keinerlei Dithering enthält, sondern nur an festen Schwellen quantisierte Werte, einen sauberen Gradienten rekonstruieren willst (allerdings ohne sonstige harte Kanten zu sehr weichzuzeichnen), so wie er ursprünglich vor der Kamera vorhanden war.

Damit Dein Verfahren deutlich wird, gehe bitte von einer binären Bitmap (1 Bit pro Pixel) ohne Dithering als Eingabe aus.

Antwort von Kabe:

Der Mittelwert entsteht einfach durch Addition, weil der Werteraum größer ist. Da braucht und wird man keinen Mittelwert mit Komma für konstruieren!

?!?

Wenn man 4 8-Bit Werte einfach addiert, erhält man maximal einen 10-Bit Wert. Es braucht keine Mittelwertbildung, weil die Addition dieser 4 Werte genau den Mittelwert ergibt.

"Tausche 2D-Auflösung gegen Tonwertauflösung" ist in der Bildverarbeitung ein alter Hut.

Dann leg mal los, wie Du aus einer Bitmap, die keinerlei Dithering enthält, sondern nur an festen Schwellen quantisierte Werte, einen sauberen Gradienten rekonstruieren willst (allerdings ohne sonstige harte Kanten zu sehr weichzuzeichnen), so wie er ursprünglich vor der Kamera vorhanden war.

Damit Dein Verfahren deutlich wird, gehe bitte von einer binären Bitmap (1 Bit pro Pixel) ohne Dithering als Eingabe aus.

Kommen wir zu Deinem binären Input:

Da haben wir also an einer Kante in einem 2x2 Quadrat zwei schwarze und zwei weiße Pixel. Wenn wir diese 4 Einzel-bits in einen 3-bit-Wert überführen, bekommen wir 010 oder eben "Mittelgrau" in 3 Bit. Das ist für den betrachteten Bereich trotz Binärpixeln die "richtige" Antwort

In der Praxis funktionieren diese Verfahren seit Jahren (nennt sich Pixel-Binning), und die Annahme statischer Sensoren ist auch reichlich theoretisch.

Dithering gibt es keines, aber wir haben hier grundsätzlich ein verrauschtes Signal – am Ende zählen wir hier sowie Photonen…

Selbst wenn Du einen absolut homogenen Input hast, zeigt ein Pixel weder selbst über die Zeit noch bezogen auf seine Nachbarpixel den selben Wert an, sondern einen, der statistisch um den "wahren Wert" schwankt. Dein Quantisierungsproblem ist in der Praxis keines, weil so gut sind die Sensoren noch lange nicht ;-)

Klaus

Antwort von WoWu:

Ich hatte das oben schon einmal angemerkt:

Es geht gar nicht darum, ein 10 Bit Pixel aus einem 8 Bit Pixel (auf dem Sensor) zu binnen.

So wir ich das Problem verstanden habe, geht es darum, aus einem bestehenden 8 Bit Videosignal in der Post (Wiedergabe) ein 10 Bit Videosignal zu generieren.

Es geht also gar nicht um Sensortechnik.

Oder habe ich die Problemstellung völlig falsch verstanden ?

Antwort von CCD08:

Vielleicht mal wieder zurück zur Praxis, da die Deteils sicher von so vielen Rabdbedingungen (Sensor, Rauschen, Auflösung, Motiv...) abhängen, dass eine allgemeine Aussage sicher nicht möglich ist.

Was habe ich gelernt:

1. aus einem 4 k Video kann man wegen der höheren Farb-Auflösung ein 4:4:4 1080p Video berechnen (also volle Farbauflösung)

2. will ich ein Video manipulieren ( z.B. Fabrgrading, was dann ja auch mit der "Wirklichkeit" gar nichts mehr zu tun hat), empfiehlt es sich das Video in einen höheren Bitraum abzubilden z.B. von 8 Bit auf 16 Bit, und dort die Manipulationen durchzuführen, um Rundungsfehler möglichst klein zu halten, und kann damit dann auch "Banding" reduzieren oder ganz vermeiden. Dies gilt allgemein für "alle" Auflösungen und hat direkt nichts mit 4k zu tun.

3. Bei Verzicht auf die höhere Farbauflösung kann man tonale Zwischenwerte in einem höheren Bitarum gewinnen, die im Idealfall (Sensor, Rauschen, Motiv...) auch etwas mit der "Wirklichkeit" zu tun haben.

1. und 2. gilt aber immer.

Sehe ich das richtig ?

Antwort von WoWu:

Das magst Du so sehen, aber ich schliesse mich dieser Sichtweise keineswegs an.

Keinem der Punkte.

Was Punkt 2 angeht muss man das auch differenzieren, weil eine andere DCT zur Anwendung in neuen Codierverfahren kommt. Für ältere Codecs mag das für eine begrenzet Wortbreite noch zutreffen.

Differenzieren muss man auch Punkt 3 zwischen Ditherwerten und reale abgebildeten Details, die vom Objektiv aufgenommen wurden.

Reproduktion also: nein, künstliche Pixelstrukturen: ja

Antwort von Kabe:

So wir ich das Problem verstanden habe, geht es darum, aus einem bestehenden 8 Bit Videosignal in der Post (Wiedergabe) ein 10 Bit Videosignal zu generieren.

Das kommt aber aufs Gleiche hinaus, ob ich nun auf dem Sensor zusammenfasse oder in der Post ist letztlich egal.

Der entscheidende Punkt ist einfach, dass man örtliche Auflösung aufgibt und dafür Intensitätsauflösung gewinnt.

Antwort von WoWu:

Nee, ist nicht egal, weil die original Schattierungen (Tonwerte), die vom Objektiv aufgenommen werden, im Mapping indiziert werden und damit nicht mehr bekannt sind.

Es kommt bei Video, anders als in einer theoretischen Betrachtung leider darauf an, was vom original reproduzierbar ist und nicht, ob da irgendwelche Werte eingerechnet wurden.

Insofern besteht ein ganz erheblicher Unterschied, ob ich die Werte im Binning gewinne oder aus einem indizierten Feld.

Antwort von prophet:

Ich hatte das oben schon einmal angemerkt:

Es geht gar nicht darum, ein 10 Bit Pixel aus einem 8 Bit Pixel (auf dem Sensor) zu binnen.

Jain...

So wir ich das Problem verstanden habe, geht es darum, aus einem bestehenden 8 Bit Videosignal in der Post (Wiedergabe) ein 10 Bit Videosignal zu generieren.

... 10bit Signal aus dem herunterskalierten Videosignal zu bekommen.

Beides sind identische Probleme. Das erste passiert in der analogen Welt, das 2. in der digitalen. Der Unterschied ist die Signalabtastung durch den Quantisierer im 2. Fall. (Dass die Anzahl der Elektronen auch "digital" ist, lassen wir an dieser Stelle außen vor).

Antwort von WoWu:

Nur dass bei der Zweiten Abtastung unterschiedliche Werte genommen werden als bei der Gewinnung aus dem analogen Signal.

Das zweite mal wird gedithert, weil weder die fehlenden Originalwerte noch deren spatiale Verteilung bekannt sind.

Dass man Werte einrechnen kann steht ganz ausser Frage.

Die einzige Frage, die sich stellt ist die, wie unterscheiden sie sich und welche Auswirkungen haben sie im Hinblick auf die Artefaktbildung des Endproduktes.

Antwort von CCD08:

Zu der Frage 8 Bit /10 Bit muss ich (leider, wäre ja schön gewesen) WoWu recht geben.

Es gibt sicher Sonderfälle wie lineare Farbverläufe, bei denen man so annähernd "richtige" Zwischenwerte berechnen kann, ist aber eher Glücksache.

Nimmt man als 4 k Bild ein 8 Megapixel Bild mit vollkommen zufälligen farblichen Pixelstrukturen wird keine Abbildung der Welt "genauere" Zwischenwerte für das gesamte Bild berechnen können, weil es die überhaupt nicht gibt.

Man kann jetzt sicher auch die Diskussion beginnen, ob die normalen Bilder/Vdeos eher Farbverläufen oder Zufall entspricht, fände diese Diskussion dann aber eher als abgehoben.

Aber wie schon oben gesagt, Manipulationen wie Grading sollten aus meiner Sicht in einem höheren Bitraum, am besten ganzzahlige Vielfache wie 8 Bit zu 16 Bit durchgeführt werden, um Rundungsfehler möglichst klein zu halten.

@WoWu: gehe davon aus, dass Editprogramm beim Berechnen die Berechnung auf jedes Einzelbild anwendet, also unabhängig von Codec auch jedes einzelne Zwischenbild aufklappt, das heisst berechnet.

Antwort von WoWu:

Davon gehe ich wohl aus, nur wenn ich in der Post mit einem Codec arbeite, der lediglich mit Additionen und Shift funktioniert, dann setzte ich da kein Floatingpoint Verfahren drauf, der mir meine Rundungsfehler erst fabriziert.

Und mit dem "real-World" kann man das ja mal an einem kleinen Beispiel festmachen, um auch die mitzunehmen, denen mathematische Funktionen nicht so viel sagen:

Jeder kann sich eine weisse Wand vor,stellen auf der ein geringer Schatten liegt, der tonal dicht an weiss liegt, aber sichtbar ist.

Und einen Boden vor der Wand, auf den die Weisse Wand ganz leicht abstrahlt, sodass ein Teil des Bodens nicht völlig Schwarz ist, sondern ebenso sehr dicht an schwarz.

Das sind ja Scenarien, aus deren Grund man überhaupt zu mehr als 8 Bit greift, also durchaus nicht abgehoben.

Ein 12 Bit Sensor, vermag das mit seinen 4096 Werten noch zu differenzieren und stellt alle vier Werte da.

Indiziert man die 12 Bit nach 8 Bit, werden jeweils 18 Werte zu einem Wert zusammen gefasst.

Der Schatten bei Weiss wird (mit 17 andern Werten) zum Weisswert und ist damit verschwunden und der Schatten bei Schwarz entsprechend wird (ebenfalls mit 17 andern Werten) zum Schwarzwert zusammen gefasst und mit dem Rest der Indizierungen in 219 Werten in einem 8 Bit Stream übertragen.

Will man nun die beiden Schatten mathematisch reproduzieren, wird in diesem Fall ein 50% Dither aufgetragen, dessen Lage dadurch aber ebensowenig reproduziert werden kann.

Die Werte der ehemaligen Schatten sind weder in Stärke, noch in der Lage reproduzierbar.

Das ist ja einer der Gründe, warum 8 Bit überhaupt so "hart" wirkt. Weil es die echten Zwischentöne nicht gibt und rechnerisch an solchen Stellen dann Kanten entstehen.

Schlimmstenfalls entsteht eine Graufllaeche aus irgendeiner Struktur.

Es funktioniert also nicht.

Antwort von prophet:

Dann leg mal los, wie Du aus einer Bitmap, die keinerlei Dithering enthält, sondern nur an festen Schwellen quantisierte Werte, einen sauberen Gradienten rekonstruieren willst (allerdings ohne sonstige harte Kanten zu sehr weichzuzeichnen), so wie er ursprünglich vor der Kamera vorhanden war..

Die Forderung geht an der Fragestellung vorbei: wir reden hier vom Downsampling eines 4K auf FullHD. Natürlich gehen die hochfrequente Teile des Bildes verloren! Downsampling ist ein Tiefpassfiler.

Damit Dein Verfahren deutlich wird, gehe bitte von einer binären Bitmap (1 Bit pro Pixel) ohne Dithering als Eingabe aus.

Ich weiß nicht, was ihr alle mit dem Dithering habt :-) Das ist ein additives Qaantisierungsrauschen (QR), um eine Annährung an die ursprüngliche (analoge) Singalamplitude statistisch zu erreichen, mit Genauigkeit welche die Quantisierungsauflösung übersteigt. Funktioniert spatial (Farbverläufe) wie temporal (z.B. LCDs).

Ein Bild sagt bekanntlich mehr als tausend Worte. Ich hoffe, das bringt mehr Licht in die Diskussion.

Demonstrieren möchte ich das mit einem 1bit Bild mit Dithering =):

zum Bild

Wie man sieht, sind die Tonwerte nach dem Downsampling alles andere als zufällig oder Dithering. Je nach verwendetem Filter kann man das zugrunde liegende Signal besser oder schlechter rekonstruieren.

Ich hoffe, das ist mehr als ein Beweis, dass man "verlorene" Halbtonwerte wieder rekonstruieren kann. Es ist keine Magie, kein Zufall, und keine Statistik ;-) Und vor allem kein Dithering!

Disclaimer: es gilt natürlich "Garbage in garbage out".

Edit: Tippfehler.

Antwort von WoWu:

Ihr bewegt Euch mittlerweile nicht mehr im Videobereich sondern in Bereich künstlicher Bilder.

Es geht hier aber um Video !

Und darum, dass es kein identisches Ergebnis bringt, ob eine Aufnahme in 10/12 Bit am Sensor aufgelöst wird oder aus einem 8Bit Signal hergestellt wird.

Es geht darum, eine detailgenaue Reproduktion zu erzielen, die vom Original nicht unterschieden werden kann.

Es geht nicht, darum ob ich Pixelstrukturen nach einer ungefähren Genauigkeit erzeugen kann.

Danach könnte man dann übrigens noch die Frage beantworten, warum es eigentlich noch 10/12 Bit Kameras gibt.

Antwort von rudi:

@prophet: Danke für deine Mühen und die sehr informative Grafik. Mir fehlt leider grade die Zeit für sowas.

Es geht hier aber um Video !

Und darum, dass es kein identisches Ergebnis bringt, ob eine Aufnahme in 10/12 Bit am Sensor aufgelöst wird oder aus einem 8Bit Signal hergestellt wird.

...

Danach könnte man dann übrigens noch die Frage beantworten, warum es eigentlich noch 10/12 Bit Kameras gibt.

Ja, es geht aber auch darum, ob man durch Pixelzusammenlegung mehr Farbtiefe erzielen kann. Man opfert Orts-Auflösung zugunsten einer höheren Farbauflösung.

Irgendwie ignoriert Wowu immer, dass man nachher nur noch ein Viertel der Pixel übrig hat. Natürlich ist eine 10 Bit 4K immer besser als eine 8 Bit 4K-Aufnhame und eine Interpolation von 8 Bit 4K auf 10 Bit 4K macht nix besser. Das ist hier glaube ich allen klar.

Aber es ist doch kaum zu leugnen, dass eine Reduktion von 4K auf 2K mehr Farbtiefen-Information generiert, wenn man die Farbinformationen aus 4 Sensorpixeln zusammenfasst.

P.S. am Rande erwähnt: Die Panasonic kann 4:2:0 auch alternativ im vollen Wertebereich von 0...255 schreiben, nicht nur 16.235 wie in der Rec 709. Das bringt zwar nicht viel, aber wenn man schon die Pixel in 8 Bit quetschen muss....

Antwort von srone:

irgendwie habe ich den eindruck, reine spekulation, daß dieses erzeugte 10bit, wahrscheinlich in den meisten fällen (video), nach "neat video"-extrem aussieht. wächserne gesichter vor harmonischen weichen unschärfen, welch graus :-(

das digitale bildverständnis schreitet voran, leider.:-/

lg

srone

Antwort von WoWu:

Aber es ist doch kaum zu leugnen, dass eine Reduktion von 4K auf 2K mehr Farbtiefen-Information generiert, wenn man die Farbinformationen aus 4 Sensorpixeln zusammenfasst.

Natürlich ist das zu leugnen, weil dazwischen eine Indizierung stattgefunden hat.

Hättest Du die Originaldaten von 4 8-Bit Ladungen, dann könntest Du das machen ... also wenn Du das RAW Signal (ohne Verarbeitung) hast.

Aber nicht aus einem indizierten Datenstrom.

Was glaubst Du, warum das nicht gemacht wird ?

Solche Erkenntnisse sind ja nicht neu und jeder Hersteller wurde sich die Hände reiben, wenn er nur noch billige Kameras herstellen müsste und die 10/12 Bit Qualität damit abliefern würde.

Lös mir doch einfach mal mein Beispiel auf, wie Du die beiden Lumanschatten regenerieren willst, die bereits in den beiden s und w Werten verschwunden sind.

Du hast weder eine spatiale Information noch eine Werteinformation. Wie also willst Du die beiden Objekte rekonstruieren ?

Antwort von TheBubble:

Ein Bild sagt bekanntlich mehr als tausend Worte. Ich hoffe, das bringt mehr Licht in die Diskussion.

Demonstrieren möchte ich das mit einem 1bit Bild mit Dithering =):

Und hier liegt der Denkfehler: Wenn Dithering vorhanden ist, dann stecken dort zusaetzliche Informationen drin, die man fuer eine Umrechnung in Grauwerte nutzen kann - das braeuchte nicht einmal ein Downscaling.

Deswegen formulierte ich explizit, das die Eingabe KEIN Dithering enthaelt. Hier gibt es keine Zusatzinformationen. Ich halte die Annahme fuer realistisch, dass kein verwertbares Dithering wie in dem obigen Beispiel vorhanden ist, unter anderem weil sich Dithering in Bitmaps nur bedingt mit gaengigen Kompressionsverfahren vertraegt.

Nimm folgendes 1D-Beispiel mit zunaechst 1 Bit pro Sample:

0000000011111111

Ist bzw. war das nun in meinetwegen 8 Bit Darstellung ein dunkler Bereich links und ein heller Bereich rechts oder ein sanfter Verlauf von dunkel zu hell? Man kann nur raten, die Information, was es war, ist verloren.

Antwort von srone:

nach weiterem nachdenken, komme ich zu dem schluss, neat video unrecht zu tun, median-filter trifft es wohl besser. was es zu beweisen gilt, ist wohl inwieweit überwiegt der vorteil des schärfegewinns durch bikubisches-downscaling den vermatschenden eindruck des "unrealistischen"median filters, welcher zwar 10bit bringt, doch um welchen preis?

lg

srone

Antwort von TheBubble:

Aber es ist doch kaum zu leugnen, dass eine Reduktion von 4K auf 2K mehr Farbtiefen-Information generiert, wenn man die Farbinformationen aus 4 Sensorpixeln zusammenfasst.

Man wirft beim Addieren zur Summe und ausschliesslicher Speicherung dieser Informationen weg (die Summanden), es kommen keine neuen Informationen hinzu.

Antwort von Kabe:

Nee, ist nicht egal, weil die original Schattierungen (Tonwerte), die vom Objektiv aufgenommen werden, im Mapping indiziert werden und damit nicht mehr bekannt sind.

Es kommt bei Video, anders als in einer theoretischen Betrachtung leider darauf an, was vom original reproduzierbar ist und nicht, ob da irgendwelche Werte eingerechnet wurden.

Insofern besteht ein ganz erheblicher Unterschied, ob ich die Werte im Binning gewinne oder aus einem indizierten Feld.

Das Mapping ist im Wesentlichen ein Gammawert, der seine Charakteristik nicht durch Binning ändert!

Die Werte sind Werte des Originals, nur anders zusammengefasst, und wie bereits angemerkt, sind sie allenfalls verrauschte Abbildungen der „Original-Schattierungen“. Da wird nichts „eingerechnet“, sondern lediglich anders zusammengefasst.

Wenn Du ein Video für ein Medium verkleinern musst, hast Du da die selben Bedenken?

Klaus

Antwort von Kabe:

Nimm folgendes 1D-Beispiel mit zunaechst 1 Bit pro Sample:

0000000011111111

Ist bzw. war das nun in meinetwegen 8 Bit Darstellung ein dunkler Bereich links und ein heller Bereich rechts oder ein sanfter Verlauf von dunkel zu hell? Man kann nur raten, die Information, was es war, ist verloren.

Na klar! Die spatiale Information *innerhalb* des neuen Pixels geht verloren, dafür wird eben intensitätsmäßig feiner aufgelöst. Da wird nichts hinzugerechnet, sondern eben weggeworfen…

Der Knackpunkt ist nun aber, dass auch die downgesampelte Information immer noch Full HD ist, aber eben mit mehr Reserven für die Post und nebenbei auch noch rauschfreier. Das ist nicht besser als 4K 4:2:0, aber sehr viel besser zu bearbeiten ;-)

Klaus

Antwort von Tiefflieger:

Die beste Qualität hat man, wenn aus der Kombination

- Optik

- Sensor

- Kalibrierung

- Referenz

(soll/ist) alle analogen Parameter stimmig sind.

Mit digitaler Bildbearbeitung und den Bildparametern ist eine beliebige Auswertung möglich.

- Mit RAW hat man nahezu die Sensorischen Werte (geglättet). Theoretisch könnte Fotoqualität und mehr erreicht werden.

- Mit 8 bit 4:2:0 das aus einer "exakten" RGB Quelle stammt, ist ein stimmiges Farbbild ohne sichtbare Stufung (Banding) erreichbar. Das auch einer Nachbearbeitung standhält.

Bezüglich 4K oder FullHD Aufnahme, dass Gros an Kameras erreichen nicht die Nennauflösung und single Sensorkameras mit (Video-)Debayering sind weit weg von Fotoqualität.

(Eine Ausnahme davon könnten die Sony F65/AX100 und RED Dragon sein die, die volle Sensorfläche mit "Downsampling" zu 4K nutzen können).

Bei Darstellung und etwas Abstand ergeben sich sowieso "Mischpixel" die auch unter dem Marktingbezeichnung "Retina-Display" für gute Farbdarstellung sorgen.

(Native Bildqualität bleibt erhalten und Schriften und Texte erreichen Druckqualität zu einer virtuellen Bildauflösung z.B. 1920 x 1200)

In der Praxis sitzen die Leute sowieso zu weit vom HDTV weg und sehen so SD Bildauflösung oder bestenfalls HD Ready.

Das wird sich auch mit 4K nicht ändern, nur wenn man wenigsten reale 8 bit 4:2:0 oder besser 10 bit 4:2:2 hätte (Quelle in nahezu Fotoqualität), werden die Leute begeistert sein.

(Mit Fotoqualität meine ich nicht super scharfe Bilder mit kurzer Verschlusszeit, sondern gutem Farbverhalten in Bilddetails)

Gruss Tiefflieger

** OT **

In der Computertechnik haben Spezialisten seit Jahren normale PC-Games zu 4K oder 8K aufgebohrt (um Antialiasing und Farbschwächen zu eliminieren) und wieder auf FullHD runtergerechnet um eine optimale Bildqualität zu haben (In Echtzeit und z.B. 60 fps nicht spielbar ;-)

Antwort von rudi:

Lös mir doch einfach mal mein Beispiel auf, wie Du die beiden Lumanschatten regenerieren willst, die bereits in den beiden s und w Werten verschwunden sind.

Du hast weder eine spatiale Information noch eine Werteinformation. Wie also willst Du die beiden Objekte rekonstruieren ?

Lieber Wowu, ich muss dir auf jeden Fall soweit recht geben, dass in dem speziellen Fall in dem alle 2x2 4K-Pixel den gleichen indexierten 8-Bit Wert ergeben, der Sampling Fehler gegenüber eines 10/12Bit Samples beim Downskaling am größten ist (nämlich wenn dieser Wert exakt in der Mitte zwischen zwei 8 Bit LUT-Werten sitzt). Doch wie oft tritt genau dieser Fall an einem Sensor im echten Leben auf? Also 2x2 RGGB Pixel, die nach dem Debayering exakt 4 x den gleichen 12 Bit Luminanz-Wert ergeben?

Ich hoffe ich komme am WOE dazu, hierfür noch eine vielleicht erhellende Information beitragen zu können...

Antwort von WoWu:

Das Mapping ist im Wesentlichen ein Gammawert, der seine Charakteristik nicht durch Binning ändert!

Hab ich auch nicht gesagt.

Im beschriebenen (14 Bit) Fall werden aus einer höherwertigen tonalen Auflösung 18 Grauwerte zu einem einzigen Grauwert eines 709 Signals indiziert. Das sind Limawerte.

17 der 18 Werte gehen unwiderruflich verloren.

Von Gammawerten war gar keine Rede.

Es geht hier nicht um Computergrafik sondern um die Reproduktion natürlicher Bilder.

@Rudi

Solche Versuche haben wir zur Genüge gemacht, weil wir seit 10 Jahren in 10 Bit arbeiten und hin und wieder 8 Bit Material angleichen müssen und immer wieder auf die bekannten Schwierigkeiten gestossen sind.

Leider ist es uns bisher noch nicht gelungen, aus einem 8 Bit Stream einen Stream zu erzeugen, als sei er mit einer 10 Bit Kamera aufgenommen.

Und der Step von 1080 auf 720 entspricht etwa dem von UHD auf HD.

"keep me posted".

Schönes Wochenende.

Antwort von Fader8:

Und wie macht man das Ganze jetzt in der Praxis?

Das würde mich interessieren.

Grüsse

Antwort von Kabe:

Leider ist es uns bisher noch nicht gelungen, aus einem 8 Bit Stream einen Stream zu erzeugen, als sei er mit einer 10 Bit Kamera aufgenommen.

Das glaube ich Dir - aber die meisten 10-bit-Kameras dürften eine höhere Dynamik haben - und in der Hinsicht bringt diese Umrechnung natürlich so ziemlich gar nix.

Klaus

Antwort von WoWu:

das würde im Umkehrschluss heissen, dass auch alle 8 Bit Kameras wesentlich bessere (Tonale) Auflösungen abliefern :-)

Das wiederum würde in der Verlängerung bedeuten, dass man sich die Frage stellen müsste, worum wir hier eigentlich reden, wenn 8 Bit in Wirklichkeit viel besser ist :-))

Nee, nee, 8 Bit sind schon 8 Bit und 10 sind auch nicht mehr als 10, weil einfach nicht mehr Werte in der Tabelle übertragen werden.

Antwort von krokymovie:

Leider ist es uns bisher noch nicht gelungen, aus einem 8 Bit Stream einen Stream zu erzeugen, als sei er mit einer 10 Bit Kamera aufgenommen.

Das glaube ich Dir - aber die meisten 10-bit-Kameras dürften eine höhere Dynamik haben - und in der Hinsicht bringt diese Umrechnung natürlich so ziemlich gar nix.

Klaus

klar...10 bit gleich 400% mehr, als 8 bit.

gruß krokymovie

Antwort von domain:

Früher einmal mussten Fahrschüler auch technisch anspruchsvolle Fragen beantworten können: erklären sie mir die Funktion des Differenzialgetriebes und welche Zahnräder dabei gebraucht werden und wie sie benannt werden.

Wäre heute in erweiterter Form auch noch möglich: schauen sie sich diesen Ausdruck der Fehleranalyse vom Porsche 911 an. Was sagen ihnen die Überdreher auf Stufe 4, bei wieviel Drehzahl wurden sie mit wieviel Impulsen registriert? Wie rechnen sie die Impulse um auf die wahrscheinliche Motorschädigung und abgesehen davon, was sagt ihnen die 3-stellige Fehlermeldung beim Klopfsensor und beim Luftmassenmesser?

Ja hallo, was interessieren einen Normaluser diese Spezialistendiskussionen wie sie hier geführt werden? Tiefstes technisches 19. Jhd, wo man noch in der Schule lernen musste, wie der Telegraf und der Viertaktmotor funktioniert.

Die Frage ist doch nur, was einem unabhängig von der Komplexität 4-K in der Realität derzeit bringt oder bringen wird und speziell auch die Verdichtung auf HD.

Was du WoWu jetzt aber womöglich antworten könntest, weiß ich schon jetzt ;-)

Antwort von WoWu:

Kannst Du gar nicht wissen, bestenfalls könntest Du es ahnen.

Aber was würdest Du sagen, wenn jemand behaupten würde, ab Tempo 60 braucht man eigentlich nur noch 3 Räder am Auto.

Da würdest Du aber schnell mit diskutieren.

Solche Diskussionen sind, zugegeben immer nur für die langweilig, die nicht in der Materie stecken sondern nur den roten Knopf an der Kamera kennen.

Aber so ein Forum kann es nun mal nicht jedem gleichermassen recht machen.

Das liegt in der Natur der Sache. -Schade eigentlich-

Antwort von domain:

Ja natürlich ist es schade, aber dieses Spezialwissen ist für einen Künstler unbedeutend.

Schon Vincent Van Gogh wusste nicht, dass ihm sein aushaltender Bruder die billigsten Gelbfarben kaufte, die später und bis heute degenerieren und nicht mehr Yellow sind, sondern Schwarz werden.

Antwort von Tiefflieger:

Auf der Autobahn ab 120 Km/h wäre technisch aus Energiespargründen ein Antriebsrad am Boden genügend, der Rest ist Aerodynamisch selbstragende Karosserie.

Was die technische Kamera Entwicklung betrifft, ist es nur eine Frage der Zeit bis "künstliche" Einschränkungen fallen.

Folgendes hat nicht direkt mit dem Format zu tun, aber....

Bei Google laufen gerade verschiedene Projekte im Automobilbau, 3D Kameratechnik (Räumliche Vermessung und Darstellung) und RAW Verarbeitung.

Antwort von WoWu:

Tja, Kunst hat sich schon damals nicht verkauf. Daran hat sich ja nichts geändert.

Vielleicht wäre das mit besseren Farben anders gewesen. Weiss man's.

Mit billigen Farben hat das damals zumindest nicht geklappt und die Kunst hat ihm auch nix genutzt.

Das weiss man jedenfalls.

Antwort von domain:

Niemand hat das Recht, das Wertesystem eines anderen abzuwerten, da hast du schon recht.

Aber mit der Zeit und immer näher am Grab denke ich immer mehr an den Himmel, an einen Himmel mit Frauen an den ich nicht glaube, wie bei Cyriak Hackhofers Bildern, die ich mit meiner BMW in 60 Minuten erreiche, mich dort vertiefe und dann einen saftigen Schweinsbraten mit Sauerkraut zu mir nehme.

Antwort von otaku:

@domian du schreibst:

Die Frage ist doch nur, was einem unabhängig von der Komplexität 4-K in der Realität derzeit bringt oder bringen wird und speziell auch die Verdichtung auf HD

jepp - damit hast du den inhalt der unterhaltung doch genau begriffen, auch ohne video profi zu sein. genau darum geht es hier. und auch wenn ich leider meinen senf nicht dazu gebe, weil ich beiden seiten etwas abgewinnen kann, finde ich die argumente schon spannend.

ich teile leider den optimissmuss nicht, das diese fragestellung bald sowieso obsolet ist weil die technik so schnell besser wird. ich sehe die technik zzt ausdrücklich nicht besser werden, sondern sich lediglich zu verändern, und zwar richtung höhere auflösung.

um bei deinem auto beispiel zu bleiben, wenn ich nur einen parameter an einem auto hoch schraube macht das halt noch kein besseres auto, erst recht nicht, wenn sich gleichzeitig andere werte dafür verschlechtern müssen.

ich finde in der unterhaltung 2 argumente sehr stichhaltig, das eine ist wowu der sagt, und es mit dem beispiel der weissen wand auch gut belegt, eine info die einmal verlohren ist lässt sich nicht wieder herstellen (also natürlich auf die farbe bezogen)

das andere argument, das ich auch sehr gut aus der praxis kenne ist,

das die info nicht wieder hergestellt werden kann, kann ja sein, in der praktischen bearbeitung ergeben sich aber dennoch vorteile.

ein sehr typisches beispiel ist z.b. ich habe ein super hoch kompremiertes bild und soll es keyen, wie stelle ich das an, ich wandele von rgb in die farbdifferenz und blur die chroma und wandele zurück zu rgb.

wowu würde mit sicherheit sagen, ja klar kannste machen, aber damit näherst du dich ja nicht dem original, was natürlich 100% stimmt, dennoch stelle ich jetzt aber fest, das ich es besser verarbeiten kann.