Vor der Jahrtausendwende waren sogenannte Videoschnittkarten für PCs und Macs unabdingbar um (semi-)professionell Videos zu bearbeiten. Die (damals noch VGA-Karten genannten) Grafikkarten in den Rechnern gaben keine analogen PAL- oder NTSC-Signale aus und die meisten Videos wurden interlaced produziert, was dem (noch ebenfalls analogen) VGA-Signal eines Computers genauso fremd war. Somit konnte man nur mit speziellen Videoschnittkarten eine korrekte Wiedergabe des Videosignals in der Timeline erreichen. Gleichzeitig waren Videoschnittkarten auch nötig, um das Videomaterial überhaupt in den Rechner zu bekommen. Hierfür mussten die analogen Signale vom Band digitalisiert werden. Dieser Prozess wurde Capturing genannt.

Mit MiniDV fielen analoge Schranken

Mit der Einführung von (Mini)DV um die Jahrtausendwende konnten auch semiprofessionelle Anwender Videoaufnahmen in PAL oder NTSC-Auflösung endlich digital in der Kamera auf Band speichern. Dadurch wandelte sich das Capturing, also das Einlesen der Aufnahmen in den Computer. War dies bis dahin noch eine Analog-Digital-Wandlung wurde es mit MiniDV zu einer rein digitalen Übertragung, die seinerzeit über Firewire erfolgte. Zur zeitlichen Einordnung: Firewire konkurrierte zu dieser Zeit mit USB um die Vorherrschaft als externer digitaler PC-Anschluss. Diesen Kampf gewann schließlich USB und Firewire versank mit dem Aussterben der Mini(H)DV-Kameras anschließend wieder in der Versenkung. Eine dedizierte Videoschnittkarte sollte um die Jahrtausendwende also am besten DV digital über Firewire einlesen und das Interlaced-Format an einen (immer noch) analog angeschlossenen Vorschaumonitor ausgeben können.

Digitale Displays machten Interlaced-Video überflüssig

Der dann folgende Aufstieg von hochauflösenden HD-Formaten war eng mit dem Abgang der Fernseher- und Monitor-Röhre verknüpft. Was gleichzeitig Interlaced-Formate obsolet und HD-Video auf den jetzt aufkommenden Computer-Displays problemlos darstellbar machte.

Mit der Ablösung der Röhre durch Displays wurde auch deren Anschluss digital. Dabei gingen unverständlicherweise Consumer Geräte wie Fernseher andere Wege als Computer Displays oder Studiomonitore, was in drei, bis heute gepflegten Anschlussarten resultierte: HDMI für Consumer, Displayport für Computer und SDI für Professional Video.

In der Praxis kann heutzutage jedoch jeder Anschluss fast jeden Standard übertragen und die Wandlung zwischen den Anschlussarten ist auch sehr einfach und kostengünstig zu bewerkstelligen. Auch deswegen verwischen hier die Grenzen in den letzten Jahren immer mehr.

Das Ende des Capturings

Mit dem Aufkommen der zweiten Generation von HD-Kameras (AVCHD) begann auch der Wechsel von Tape/Kassetten zu digitalen Speicher(karten)-Lösungen wie HDs, SSDs oder Flaschspeicherkarten (z.B. SD-Karten). Damit wurde das Ende des Video Capturings eingeläutet. Anstatt ein Band vor dem Schnitt zur Aufnahme einzulesen musste man ab sofort nur noch die Daten von der Speicherkarte kopieren.

Für das Capturing braucht man deswegen nur noch in sehr speziellen (meist analogen) Fällen eine Videoschnittkarte. Für die Ausgabe und Vorschau beim Videoschnitt sah dies jedoch noch bis vor ein paar Jahren etwas anders aus.

24, 30, 50 oder 60p mit und ohne Frameraten-Konvertierung

Der Grund hierfür liegt vor allem in den "alten" und nationalen Fernsehstandards. Zwar werden fast auf der ganzen Welt Computer-Displays mit 60 Hz betrieben, jedoch hat sich beim Fernsehen hierzulande beispielsweise eine BIldwiederholfrequenz von 50 Hz gehalten. Diese leitet sich aus Kompatibilitätsgründen tatsächlich noch aus PAL-Zeiten (50i) ab, was wiederum auf der europaischen Netzfrequenz von 50 Hz basiert.

Will man also für das hiesige Fernsehen produzieren, so muss man in 25p oder 50p abliefern. Arbeitet man dagegen an einer Kinoproduktion, so produziert man in der Regel mit 24 Vollbildern pro Sekunde (24p).

Sieht man sich 24p, 25p oder 50p an einem Computermonitor mit 60p an, so müssen die einzelnen Bilder der Quelle auf die 60 Vollbilder der Wiedergabe verteilt werden - was man allgemein als Frameraten-Konvertierung bezeichnet. Die meisten Monitore/Player beherrschen dies zwar grundsätzlich, jedoch kann man die Frames niemals gleichmäßig zuteilen. Bei einer 24p nach 60p Wandlung werden beispielsweise manche Frames zweimal und andere dreimal gezeigt, was gerade bei flüssigen Bewegungen unangenehm als sog. Mikroruckler ins Auge fällt.

Eine dedizierte Videoschnittkarte kann dagegen Videos (und Timelines aus Videoschnittprogrammen) mit der nativen Framerate an einen Monitor ausgeben. Eine 50p Timeline wird also wirklich mit 50Hz an den Monitor übermittelt und eine 24p-Wiedergabe überträgt wirklich exakt 24 Vollbilder pro Sekunde. Wenn der Monitor diese Signale auch korrekt annimmt und mit der gewünschten Bildwiederholrate nativ anzeigt, dann (aber auch nur dann) bekommt der Nutzer seine Timeline ohne Mikroruckler zu sehen.

Das aktuelle Problem in dieser ganzen Kette sind dabei jedoch nicht mehr die (fehlenden) Videoschnittkarten sondern die Monitore. Denn nach wie vor garantieren nur wenige Computerdisplays, dass sie wirklich exakt 24 Bilder zeigen, wenn ihnen 24p-Material zugespielt wird. Viele günstigen Computer Displays und Fernseher nehmen zwar mittlerweile klaglos 24-50p Material entgegen, stellen das Bild aber dennoch nach einer internen Frameraten-Konvertierung mit 60Hz dar.

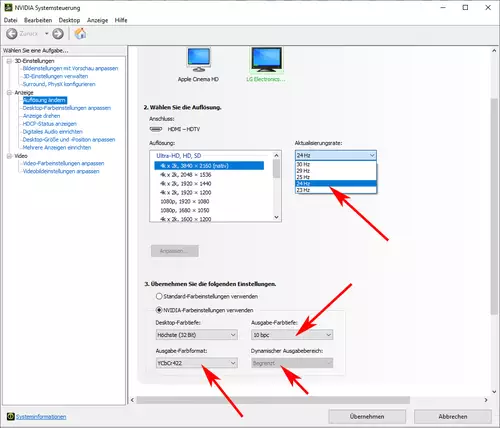

Moderne Grafikkarten mit 10 Bit YUV

Besitzt man einen Monitor der wirklich auch echte 24/50p-Wiedergabe beherrscht, so können aktuelle Grafikkarten von AMD und Nvidia solche Monitore auch mit 24 oder 50Hz ansteuern. Und das sogar mit unterschiedlichen Frequenzen, z.B. bei einer Dual Monitor Vorschau. Um dies jedoch nutzen zu können, müssen die Hersteller von Videoschnittprogrammen bei ihrer Vollbild-Vorschau die Grafikkarte auch mit der richtigen Frequenz ansprechen.

Ähnliches gilt für die Farbkanäle. Professionelle Videoübertragung erfolgt (ebenfalls aus historischen Gründen) fast immer in YUV während Computermonitore in der Regel per RGB angesprochen werden. Doch auch hier wurden von der Computerindustrie mittlerweile alle Schranken abgebaut. Die meisten modernen Grafikkarten-Treiber können Computer Displays (und per HDMI angeschlossene Fernseher und Vorschaumonitore) auch mit YUV-Signalen füttern. Letzteres war bis vor ein paar Jahren noch ein wichtiges Alleinstellungsmerkmal für eine dedizierte Videoschnittkarte.

Solange man keine speziellen Anschlüsse (z.B. SDI) braucht könnte daher heutzutage fast jede aktuelle Grafikkarte eine dedizierte Videoschnittkarte bei der Videovorschau hundertprozentig ersetzen. Einzig die Grafikarten-Treiber und der Hersteller der Videobearbeitungs-Software bestimmen welche Farbräume und Frameraten man letztlich auch nativ für die Videovorschau nutzen kann.

Ob und wie das ganze in der Praxis aussieht, werden wir uns deswegen in Kürze an dieser Stelle näher ansehen...