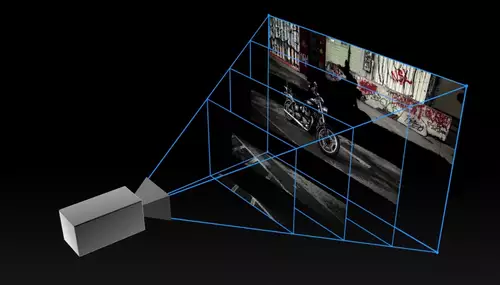

Das Projekt " Local Light Field Fusion: Practical View Synthesis with Prescriptive Sampling Guidelines" errechnet neue 3D Views eines Objekts aus nur wenigen Photos und stellt diese z.B. auf einem Smartphone in Echtzeit dar. Auch diese Methode basiert auf Deep-Learning, sie nutzt neuronale Netze, um anhand einiger Photos über ein errechnetes lokales Lichtfeld neue Ansichten eines Objekts in 3D zu erstellen.

Der Algorithmus ist dabei in der Lage, die Anzahl der benötigten Photos aus leicht verschiedenen Perspektiven zu bestimmen und dem User per Augmented-Reality-Smartphone-App interaktiv eine Hilfestellung zu geben beim Schießen der benötigten Photos.Angezeigt werden die Positionen, von denen aus noch Photos aufgenommen werden müssen, um eine 3D-Teil-Ansicht zu ermöglichen.

Per Deep Learning werden erst aus jedem Photo mehrere Tiefenebenen extrapoliert, aus deren Gesamtheit denen lokale Lichtfelder errechnet werden können, welche dem User dann in Echtzeit die Sicht aus leicht unterschiedlichen Perspektiven auf ein Objekt mobil oder auf dem Desktop ermöglichen und es so dreidimensional erscheinen lassen. Auf der Website des Projekts ist auch der entsprechende Programmcode verfügbar, um diese 3D-Views aus einem Demobildsatz selbst zu erzeugen und interaktiv anzuschauen.

// Top-News auf einen Blick:

- Affinity Photo, Designer und Publisher ab sofort in einer kostenlosen App

- DJI Neo 2 bringt Rundum-Hinderniserkennung samt LiDAR

- Künftige Xbox Next: Vollwertiger Windows-PC mit Potenzial für Videobearbeitung

- LG UltraFine 40U990A-W - 40 5K2K Monitor mit Thunderbolt 5

- Neue Firmware für Panasonic LUMIX S5 II, S5 IIX, S9, GH7 und G9 II