Seit kurzem werden Videos im Internet gepostet, welche mit einer - mutmaßlich - neuen Funktion im KI-Videogenerator Runway Gen2 erstellt wurden. Im Juni wurde ja die zweite Generation des Modells öffentlich zugänglich - eine Image-2-Video Funktion war mitangekündigt, sie erstellt soweit wir wissen jedoch bewegte Variationen auf das gezeigte Motiv. Wie es scheint hat die Community nun eine neue Art entdeckt, Clips aus Einzelbildern zu gewinnen.

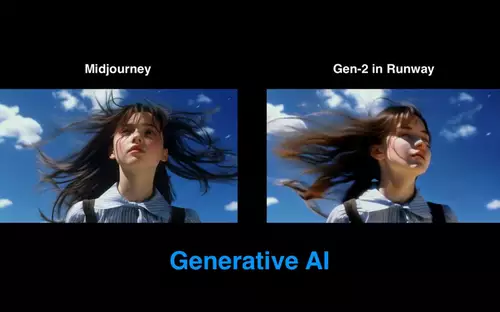

Das besondere an diesen neuen Animationen ist, dass sie wie es scheint ganz ohne Prompt generiert wurden. Es wird einfach ein einzelnes Bild eingegeben, etwa eines aus einem KI-Bildgenerator wie Midjourney oder Stable Diffusion, und Runway Gen2 erkennt selbständig, welche Bildteile sich sinnvoll bewegen könnten. Dies setzt einiges an Objekterkennung und -einordnung voraus, etwa "weiß" Runway, dass Menschen ihre Köpfe drehen, oder Arme bewegen, dass Haare im Wind wehen und ähnliches. Doch auch der Kameraausschnitt wandert.

Auf diese Weise lassen sich einzelne Bilder zu kurzen Clips animieren, jeweils maximal 4 Sekunden (im Basis-Account). Dies funktioniert mit Zeichnungen ebenso wie mit fotorealistischen Aufnahmen, allerdings sicherlich nicht immer und gleich gut. Je komplexer der Bildaufbau, umso seltsamer das Resultat; menschliche Bewegungsabläufe gelingen (noch) nicht überzeugend. Einen Zombiefilm könnte man so wohl am ehesten generieren.

// Top-News auf einen Blick:

- Blackmagic Resolve Studio für 236,81 bei Teltec - und weitere Angebote

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Ausgewählte Angebote - DJI Mavic 4 Pro, Canon R5 C, Sachtler aktiv12T...

- Die besten Black Friday Deals für Sony und Canon DSLMs und Objektive

- Blackmagic bietet bis zu 30% Rabatt auf seine 6K Kameras

- Große Übersicht - Black Friday Deals 2025 für Foto+Video - Kameras, Objektive, Zubehör usw.

Folgendes Video zeigt, wie einfach sich solche Animationen erstellen lassen.