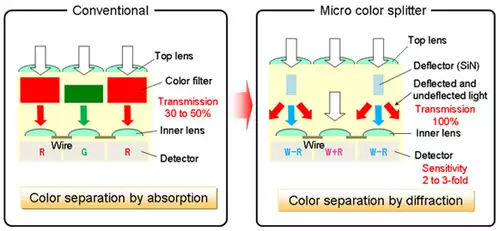

Panasonic-Entwickler stellen in der aktuellen Fachzeitschrift Nature eine neue Sensortechnologie vor, mit der sich eine 1,85-fache Lichtausbeute erzielen lassen soll, verglichen mit normalen CMOS-Sensoren, die Farbinformationen via Bayerfilter registrieren. Letzterer liegt vor einem herkömmlichen (1-Chip-)Sensor und läßt pro Pixel jeweils nur eine der drei Primärfarben durch, damit vom Sensor ein farbiges Bild generiert werden kann, filtert dabei jedoch auch viel Helligkeit raus (bis zu 50-70% des Lichts geht verloren). Bei dem neuen Verfahren liegt statt einem Bayerfilter eine Schicht mit mikroskopisch kleinen Prismen vor dem Sensor. Statt zu filtern wird hier das Licht geplittet, sodaß die dahinterliegenden Pixel verschiedene Farbinformationen erhalten -- praktisch ohne Lichtverlust, laut Entwickler. Wie der Grafik zu entnehmen, scheinen dabei auch eine Art Luma-Pixel vorgesehen zu sein. Dank überlappender Pixelstruktur soll ein Bild mit hoher Farbtreue errechnet werden können.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Die neuen Sensoren können anscheinend in existierenden Halbleiter-Fertigungsprozessen hergestellt werden, doch eine Weile wird man sich sicherlich noch gedulden müssen, bis sie in die Serienproduktion gehen, um dann in Kameras wandern...