Newsmeldung von slashCAM:

Wer keine Möglichkeit hat, seine RTX 4090 auf 96 GB aufzurüsten oder wem das immer noch zu wenig GPU-Speicher ist, für den ist vielleicht folgende Neuentwicklung von San...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

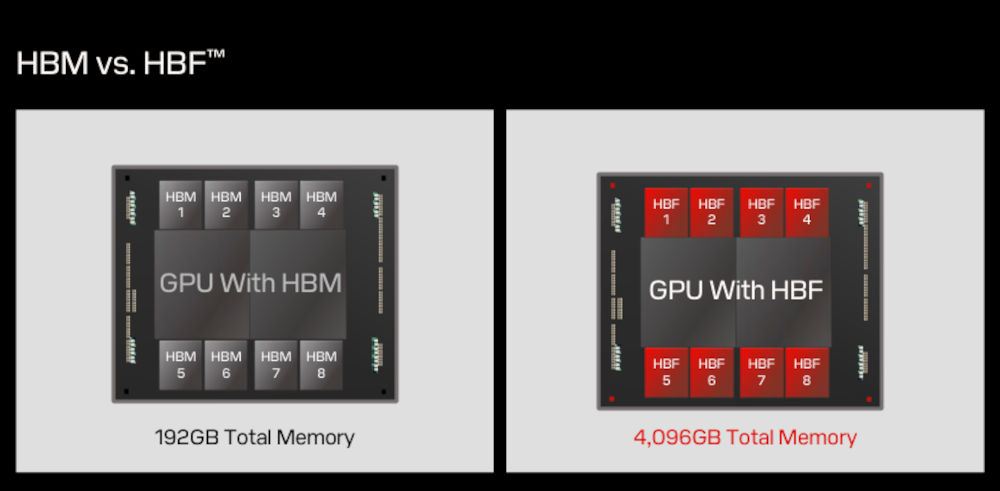

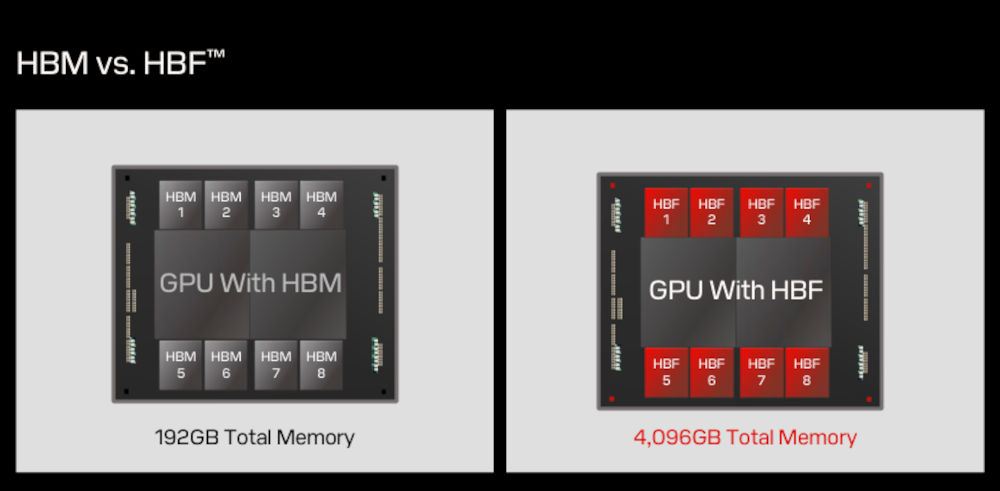

SanDisk stellt Grafikkarten mit 4 TB Speicher dank neuer HBF-Technologie in Aussicht

Antwort von MrMeeseeks:

Nvidia hat in 10 Jahren die Größe der Rams verdoppelt.

4TB gibt es dann im irgendwann im Jahre 2100.

Antwort von MrMeeseeks:

MrMeeseeks hat geschrieben:

Nvidia hat in 10 Jahren die Größe der Rams verdoppelt.

4TB gibt es dann im Jahre 2100 irgendwann.

Antwort von cantsin:

Nvidia wird einen Teufel tun und die RAM-Kapazitäten seiner Consumer-/Gamer-Grafikkarten signifikant erhöhen, weil sie sich damit das Geschäft mit den professionellen KI-Beschleuniger-GPUs kaputtmachen würden, durch das sie die an der Börse wertvollste Firma der Welt geworden sind...

Antwort von teichomad:

Zeiten ändern sich. Wenn Nvidia sich da quer stellt, können sie gern AMD und Intel das Feld überlassen :)

Antwort von pillepalle:

Man verkauft die doppelte Leistung zum doppelten Preis, weil man es kann. Jeder Hersteller wird immer versuchen möglichst viel an den Dingern zu verdienen. Ist bei anderen Produkten wie SSDs, oder Speicherkarten, doch genauso. Warum sollten die sich ihr Geschäft mit derzeit hohen Margen kaputt machen?

VG

Antwort von Totao:

Das Hochskalieren des GPU Speichers ergibt nicht unbegrenzt Sinn, die Geschwindigkeit muss mithalten ansonsten ist die Performance bei KI-Tasks irgendwann unzureichend.

Drüber hinaus wird durch die Deep Research Modelle, die teils zehntausende Tokens damit zubringen nachzudenken, eine gute Performance noch wichtiger als bisher.

Antwort von Frank Glencairn:

Ich denke das wenn man in Zukunft KI lokal halbwegs sinnvoll laufen lassen will, wird das auf dezidierten Rechnern passieren - und nicht auf GPUs. Nvidia hat ja schon einen vorgestellt.

Antwort von cantsin:

"Frank Glencairn" hat geschrieben:

Ich denke das wenn man in Zukunft KI lokal halbwegs sinnvoll laufen lassen will, wird das auf dezidierten Rechnern passieren - und nicht auf GPUs. Nvidia hat ja schon einen vorgestellt.

Wobei das ja jetzt schon geht, auch mit (einigermaßen) normaler PC-Technik:

https://www.youtube.com/watch?v=A8N3zKUJ0yE

Antwort von Frank Glencairn:

LLMs geht einigermaßen aber versuch mal ein 10 Sekunden HD Video lokal.