Newsmeldung von slashCAM:Shane Hurlbut hat auf seinem Blog den zweiten Teil seines aufwendigen URSA Reviews veröffentlicht, in dem er sich mit der Hauttonwiedergabe und der neuen 80 FPS Funktion auseinandersetzt. Eine interessante Ergänzung zum

slashCAM URSA Test. Wie auch wir ist er von der Grading-Möglichkeit des RAW-Materials der URSA ziemlich angetan - die Hauttonreproduktion empfindet er als sehr gelungen - vor allem bei ISO 400 - was nicht weiter überraschen dürfte, da ISO 400 die native ISO der URSA darstellt.

Bei ISO 800 sieht er Noise in dunkleren Bildpartien bei Tageslichtshots hinzukommen, den er als unorganischer als bei der Canon EOS C300 oder RED Dragon empfindet. Die 80FPS Aufnahmen empfindet er als cinematisch und gut vom Bewegungsablauf her gelöst.

zur News

Antwort von CameraRick:

vielleicht bin ich da nicht mehr so zeitgemäß, aber wenn ich "graded" an ein Bild schreibe (und damit nicht nur die Benutzung einer x-beliebigen LUT meine) und dann der Himmel dermaßen rosa erscheint... also, warum macht man das?

Antwort von r.p.television:

Mir haben sich auch die Rückenhaare aufgestellt.

These 1:

Ein paar Wichtigmacher haben sich eine URSA geliehen, ein Model für lau aus nem Cafe gezogen, ganz wichtig ein paar Ständer mit Reflektoren und Farbcharts auf den Gehweg gestellt und dann die Raws total verhunzt.

Für meinen Geschmack total übersättigt und auf den ersten Blick zuviel ins Orange gezogen. Warum der Himmel dann noch rosa wird kann ich auf Anhieb auch nicht sagen. Aber sowas ins Netz stellen mit dem Adjektiv "graded" würde ich mich niemals trauen.

These 2:

Das Farbmanagment in der URSA ist das reinste Kasperle-Theater.

Sollte die URSA an ähnlichen Problemen leiden wie die BMPC 4k dann ist eine gewisse Problematik nicht von der Hand zu weisen. Was aber nicht heisst dass man sowas wie in den Videos hinnehmen muss.

Antwort von Frank Glencairn:

1. Rosa Himmel: EIn Kanal clippt und die wissen nicht wie man das in Resolve löst.

2. Raw hat kein Farbmanagement in der Kamera.

Antwort von r.p.television:

2. Raw hat kein Farbmanagement in der Kamera.

Hat es schon. Nur weil bei Raw gerne die Marketing-Phrase fällt "Image direct from the sensor" ist dem nicht so. Irgendwie muss immer das Abbild des Sensors aufbereitet werden. Und dazu gehören auch die Farben.

Sonst könnte man grundsätzlich jedem Sensor ein gewisses Farbverhalten zuweisen, aber auch bei Foto-Kameras werden den Raws verschiedene Looks mitgegeben. Es gibt einige Beispiele bei gleichem Sensor in verschiedenen Kameras (verschiedener Hersteller) und komplett anderen Ergebnissen bei gleicher Raw-Engine im Bearbeitungsprogramm.

Antwort von CameraRick:

Ich frag mich nur wieso man das ins Netz stellt. Der Hurlbut ist sicher kein Amateur, aber rosa Himmel als Graded anzugeben und sich dann andauernd selber auf die Schulter klopfen ist schon grenzwertig.

Zumal der Resolve auch jetzt nicht unbedingt so kompliziert ist, dass man den nicht in drei Klicks weg hätte - daher tippe ich auf x-beliebige LUT.

Antwort von r.p.television:

Ich frag mich nur wieso man das ins Netz stellt. Der Hurlbut ist sicher kein Amateur, aber rosa Himmel als Graded anzugeben und sich dann andauernd selber auf die Schulter klopfen ist schon grenzwertig.

Zumal der Resolve auch jetzt nicht unbedingt so kompliziert ist, dass man den nicht in drei Klicks weg hätte - daher tippe ich auf x-beliebige LUT.

Ich glaube gar nicht mal dass da ein simples LUT drüber geklatscht wurde. Entweder man hat sich an dem rosa Himmel aus subjektiver Sichtweise nicht gestört oder man war nicht fähig eine anständige sekundäre Farbkorrektur zu machen. Es ist nur extrem suboptimal in diesem Kontext einen rosa Himmel mit dem Wort "graded" als Endergebnis zu verkaufen ohne auf den Himmel einzugehen.

Warum das gemacht wird?

Das ist doch immer öfter zu beobachten dass sie viele einfach zu weit aus dem Fenster lehnen.

Erst wird ein Test angekündigt und in der Subline steht dann sowas wie "wir hatten nicht viel Zeit", "wir konnten das nur so und so machen" und mussten mit dem Kompromiss leben etc. etc.

Aber hauptsache eine Schlagzeile im Netz generieren um die Klickzahlen für die Homepage anzukurbeln. Nur so kann man den Banner-Space gut verkaufen.

Antwort von Frank Glencairn:

2. Raw hat kein Farbmanagement in der Kamera.

Hat es schon. Nur weil bei Raw gerne die Marketing-Phrase fällt "Image direct from the sensor" ist dem nicht so. Irgendwie muss immer das Abbild des Sensors aufbereitet werden. Und dazu gehören auch die Farben.

Raw ist schwarz/weiß, die Farben entstehen erst beim Debayering im Rechner.

Antwort von r.p.television:

2. Raw hat kein Farbmanagement in der Kamera.

Hat es schon. Nur weil bei Raw gerne die Marketing-Phrase fällt "Image direct from the sensor" ist dem nicht so. Irgendwie muss immer das Abbild des Sensors aufbereitet werden. Und dazu gehören auch die Farben.

Raw ist schwarz/weiß, die Farben entstehen erst beim Debayering im Rechner.

Und woher nimmt der Rechner die Farben?

Antwort von klusterdegenerierung:

Den Noise Test der Alexa vs C500 finde ich viel interessanter.

Die C500 macht ja wirklich fett was her!

Antwort von Frank Glencairn:

Und woher nimmt der Rechner die Farben?

Er errechnet sie - was Rechner (wie der Name schon sagt) halt so machen ;-)

Ich hab den Eindruck, daß du nicht die geringste Ahnung hast was raw ist, und wie es funktioniert.

Antwort von mediavideo:

@Frank Glencairn

Heute ist doch nicht Freitag der 13. - oder nur eine lange Nacht gehabt?

RAW ist nicht schwarz/weiß sondern beinhaltet die R/G/B Informationen bzw. Farben der Bayermaske der Sensor- bzw. Chipaufnahme.

Ist nicht böse gemeint, aber das mit dem RAW weißt Du bestimmt viel besser ...

... korrigiere bitte die beiden Posts von Dir noch mal, das verwirrt die Leute doch nur. Und das wolltest Du bestimmt nicht. Muss ja keine förmliche Entschuldigung bei r.p.television sein ...

Antwort von Angry_C:

@Frank Glencairn

RAW ist nicht schwarz/weiß sondern beinhaltet die R/G/B Informationen bzw. Farben der Bayermaske der Sensor- bzw. Chipaufnahme.

Jo richtig und genau die Informationen benötigt ein Raw-Converter, eine Grabbersoftware etc., um daraus ein Farbbild zu generieren.

Eine CameraLink Grabberkarte z.B., bei der man mit der entsprechenden Software das Debayering ein- und ausschalten kann, zeigt das RAW Video mit ausgeschaltetem Debayering immer schwarz-weiss an.

Antwort von Frank Glencairn:

RAW ist nicht schwarz/weiß sondern beinhaltet die R/G/B Informationen bzw. Farben der Bayermaske der Sensor- bzw. Chipaufnahme.

Ist nicht böse gemeint, aber das mit dem RAW weißt Du bestimmt viel besser ...

Selbstverständlich weiß ich es besser ;-)

Nochmal zum mitschreiben:

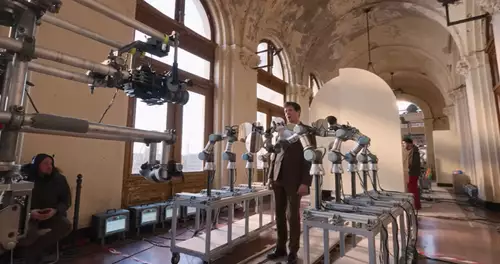

Raw hat nur einen Kanal und der ist s/w bzw Luminanz (2 auf dem Bild unten)

Was du RGB Informationen nennst, ist - vereinfacht gesagt - eine Tabelle, die der Software sagt, an welchen Stellen, welche Farbfilter sitzen, damit die jeweiligen Stellen entsprechend eingefärbt werden können (3 auf dem Bild unten) - danach werden die fehlenden Informationen noch interpoliert (4)

zum Bild

.. korrigiere bitte die beiden Posts von Dir noch mal, das verwirrt die Leute doch nur. Und das wolltest Du bestimmt nicht. Muss ja keine förmliche Entschuldigung bei r.p.television sein ...

Aber sonst geht's dir gut?

Antwort von r.p.television:

Was du RGB Informationen nennst, ist - vereinfacht gesagt - eine Tabelle, die der Software sagt, an welchen Stellen, welche Farbfilter sitzen, damit die jeweiligen Stellen entsprechend eingefärbt werden können (3 auf dem Bild unten) - danach werden die fehlenden Informationen noch interpoliert (4)

Genau damit meinte ich vereinfacht "Farbmanagment".

Und sowohl die Farbadressierung der BMPCC als auch der BMPC 4k ist nicht gerade "linear". Ich weiss nicht wie ich es anders beschreiben soll. Aber das Graden von diesem Material birgt desöfteren bezüglich Farbshifts mehr Überraschungen als bei anderen Kameras. Da werden beispielsweise Himmel türkis oder rosa oder andere Farbflächen die eher neutralgrau sind bekommen eine Lasierung.

Das macht sie nicht unbrauchbar, aber man muss damit umgehen können.

Antwort von Frank Glencairn:

Das hat aber nix mit der Bayer-Tabelle zu tun, das passiert wenn man in der Post nicht weiß was man tut, oder die falschen Tools einsetzt.

Die meisten Probleme die ich bei ner Menge von Leuten, im Zusammenspiel von Resolve und BM Kameras gesehen habe, sind gar keine, sondern beruhen auf einem mangelnden Verständnis/Kenntnis von Soft und Hardware, sowie einem falschen Workflow.

Antwort von r.p.television:

Aber Du musst doch auch beobachtet haben dass sich beim Graden von diesen Kameras (BMPC, BMPCC) die Farben weniger linear verhalten als bei anderen?

Ich weiss nicht wie ich es anders ausdrücken soll aber wenn man das Material einer BMPCC gradet dann shiftet schnell irgendein Farbkanal wo man es eher nicht erwartet.

Klar kann man das wieder gerade biegen und für einen ernsthaften Coloristen kein Problem. Wenn aber kein richtiger Colorist oder jemand mit Skills am Arbeitsplatz ist kommt eben sowas wie hier raus. Ein rosa Himmel. Ich orakele jetzt einfach mal dass das mit Sony Raw oder ARRI Raw nicht passiert wäre - wobei ich mich da nicht festlegen will. Keine Ahnung was die da gemacht haben.Vielleicht haben die auch eine Lasur über das Material gelegt. Man muss das wie schon mal geschrieben nicht zwangsläufig der URSA zuschreiben obwohl es mit meinen Erfahrungen zusammenpasst. Wobei ich jetzt noch nie einen rosa Himmel bei simpelsten Basis-Grading hatte.

Antwort von sgywalka:

Mann kann immer etweas machen.

Und stimmig wird es erst WENN MANN NEBEN DEN

LEUTEN STEHT UND WIR GEMEINSAM ZEITGLEICH

AUF DEN SELBEN FILMSTREIFEN GUCKEN--dann kann man

des mögl.sogar übereinstimmend bewerten.

Habe 1 woche neben einem der Coloristen von se

Hollywood verbracht und meine Klappe gehalten..

noch nei so viel gelernt oder wieder aus dem Gedächtniss geholt.

der bauklotz is zu gross zu teuer und,, ja.

wenns doch nur den zweifünfer Sensor quasi verdoppelt hätten.

der taugt ma mher. egal.

bin ja nur ein kleines Rädchen--out

Antwort von r.p.television:

der bauklotz is zu gross zu teuer und,, ja.

Zu gross kann man sagen. Die hätten sie definitv kompakter und leichter machen können. Zu teuer finde ich die URSA nicht. Gerade wenn man jetzt betrachtet dass sie 80fps und 4k kann und die interne Aufzeichnung auch keine weiteren Hürden darstellt ist sie schon eine interessante Kamera.

Sie ist halt nur wegen einiger Sachen vermeidbar unausgegoren.

Vom Potenzial traue ich BM hier noch einiges zu und das ist gut für den Wettbewerb. Die anderen dürfen nicht pennen.

Antwort von CameraRick:

So richtig linear arbeitest Du mit dem Material ja auch nicht unbedingt :) debayert wird doch idR zum LOG Profil, nicht linear. DaVinci arbeitet, sofern ich das überblicke, intern auch in YRGB, nicht linear (wie zB Nuke).

Einer unserer Coloristen arbeitet auch nicht gern auf BMCC Material, weil die einzelnen Farben zu wenig Separation hätten. Ist mir selbst so noch nicht aufgefallen, kann natürlich auch am BMD Film LOG liegen was da nicht optimal arbeitet, wer weiß das schon.

Es kann schon sein, dass das mit ARRI/Sony Material (bei Sony kommt es halt auch stark drauf an, woher es kommt) nicht passiert wäre. In DaVinci zumindest hast bei ARRIRAW auch denkbar keine Möglichkeit, das RAW richtig falsch einzustellen (das muss man sich mal geben: der Nuke hat deulich mehr Optionen das ARRIRAW einzurichten, als der DaVinci). Da reicht ja ein falscher Click und schon hast Du die rosarote Brille auf.

So oder so, egal von wo das Material kommt, so etwas darf Dir halt nicht passieren wenn Du einen Vergleich von Farbwerten ziehen willst; und dann noch "graded" daneben schreiben. Der Kamera kann man immer die schuld geben - das meine ich sogar wörtlich, im Zweifel kann man so etwas ja im Text anmerken.

Ansonten zeigt das eher nur, dass Du in diesem Unterfangen eine Pfeiffe bist.

Antwort von r.p.television:

So oder so, egal von wo das Material kommt, so etwas darf Dir halt nicht passieren wenn Du einen Vergleich von Farbwerten ziehen willst; und dann noch "graded" daneben schreiben. Der Kamera kann man immer die schuld geben - das meine ich sogar wörtlich, im Zweifel kann man so etwas ja im Text anmerken.

Ansonten zeigt das eher nur, dass Du in diesem Unterfangen eine Pfeiffe bist.

Das meine ich auch.

Die haben sich mit dieser Darstellung jedenfalls keinen Gefallen getan.

Wenn sie den rosa Himmel kommentiert hätten von wegen dass ein simples Grading in einem rosa Himmel resultierte obwohl dies bei anderen Raw-Kameras nicht passiert dann würde das gleich anders aussehen. Und dann mit einer sekundären Farbkorrektur den Himmel das Rosa wegzaubern.

Aber so wie es jetzt steht wirkt es einfach unprofessionell und hinterlässt mindestens Fragezeichen bei den Lesern.

Antwort von mediavideo:

@Frank Glencairn

Mir geht es bestens, nur Dir vielleicht gleich nicht mehr, wenn Du Deinen geschriebenen Quatsch selbst erkennen mußt:

1. Eine übliche Farbkamera hat auf dem Sensor vor jedem Pixel eine Farbfilter-Beschichtung. Diese ist im wechselnden Bayer-Muster R/G/B filterbeschichtet (

https://de.wikipedia.org/wiki/Bayer-Sensor ).

Damit kann man dann auch hinter dem Filter am Sensor nur R, G, oder B Farbwerte messen und keine echten Schwarz/Weiß-Werte. Das kann nur eine Kamera, z.B. die RED EPIC MONOCHROME, denn da fehlt die R/G/B Filterbeschichtung vor den Pixeln.

2. Nun sind RAW Daten quasi die direkten und möglichst unverfälschten Sensorauslesedaten.

Da nur Farbwerte im Sensor gemessen werden, können die RAW Daten auch nur Farbwerte sein (genau genommen: Farbhelligkeitswerte der entsprechenden Filterbeschichtungsfarbe). Dass man diese im ersten Bearbeitungsschritt (vor dem Debayern) gerne nur schwarz-weiß darstellt, heißt eben nicht, dass das Schwarz-Weiß-Werte sind, da kannst Du noch so viele Bilder in schwarz-weiß posten - das solltest Du eigentlich mittlerweile verstanden haben.

3. Was Du mit den Metadaten meinst, hat nichts damit zu tun, dass das keine Farbwerte sind.

Die Metainformationen zu den Farben braucht man nur um zu wissen welche R/G/B Farbfilter genau vor den Sensorpixeln sind, denn das muss man für das Debayern möglichst genau wissen. Nimm z.B. mal die F5 und F55, da steht bei Sony ganz deutlich, dass die Sensorbeschichtung unterschiedlich sei. Damit braucht man genau die Informationen, also die Farbinformation der Filterbeschichtung, sonst kann man nicht ordentlich debayern. Das schmeisst Du aber alles gehörig durcheinander und reimst Dir da was zusammen.

Ich hätte eigentlich erwartet, dass Du den Denkfehler spätestens dann bemerkt hättest nachdem r.p.television geschrieben hat: Und woher nimmt der Rechner die Farben, wenn das doch alles nur schwarz-weiß Werte sein sollen?

Aber Dir scheint das wirklich nicht klar zu sein wie das genau funktioniert.

Du wirst doch hoffentlich nicht weiter behaupten wollen, dass man hinter Farbfiltern was anderes misst als die entsprechenden Farbwerte bzw. Farbhelligkeitswerte der Grundfarben, die aber eben keine schwarz-weiß Werte sind.

Antwort von domain:

Entweder man hat sich an dem rosa Himmel aus subjektiver Sichtweise nicht gestört oder man war nicht fähig eine anständige sekundäre Farbkorrektur zu machen. Es ist nur extrem suboptimal in diesem Kontext einen rosa Himmel mit dem Wort "graded" als Endergebnis zu verkaufen ohne auf den Himmel einzugehen.

Weder clippte da ein Kanal, noch wäre da eine sekundäre Farbkorrektur notwendig gewesen. Sondern wie schon erwähnt, hätte eine ganz einfache

Verbiegung der Gammakurven gereicht, damit sich bei einigen bei dem rosa Himmel die nicht borstigen Rückenhaare aufgestellt hätten.

Auf den Himmel hat er doch gar nicht geachtet, sondern nur auf die Hauttöne.

Gegradetes Original

zum Bild http://img5.fotos-hochladen.net/uploads/himm7vndli9w1y.jpg

Primär nachkorrigiertes gegradetes Original

zum Bild http://img5.fotos-hochladen.net/uploads/himmel38vda52y0r.jpg

Antwort von CameraRick:

Wow.

Hey Frank, ich hoffe da erholst Dich jetzt übers Wochenende von diesem Tiefschlag, da fällt einem ja gar nichts mehr ein, haha :)

Antwort von r.p.television:

Entweder man hat sich an dem rosa Himmel aus subjektiver Sichtweise nicht gestört oder man war nicht fähig eine anständige sekundäre Farbkorrektur zu machen. Es ist nur extrem suboptimal in diesem Kontext einen rosa Himmel mit dem Wort "graded" als Endergebnis zu verkaufen ohne auf den Himmel einzugehen.

Weder clippte da ein Kanal, noch wäre da eine sekundäre Farbkorrektur notwendig gewesen. Sondern wie schon erwähnt, hätte eine ganz einfache

Verbiegung der Gammakurven gereicht, damit sich bei einigen bei dem rosa Himmel die nicht borstigen Rückenhaare aufgestellt hätten.

Auf den Himmel hat er doch gar nicht geachtet, sondern nur auf die Hauttöne.

Gegradetes Original

zum Bild http://img5.fotos-hochladen.net/uploads/himm7vndli9w1y.jpg

Primär nachkorrigiertes gegradetes Original

zum Bild http://img5.fotos-hochladen.net/uploads/himmel38vda52y0r.jpg

Ich hab ja auch nirgends geschrieben dass da ein Farbkanal clippt noch habe ich behauptet dass hier zwingend eine sekundäre Farbkorrektur notwendig ist.

Aber man kann nicht einfach nur Hauttöne "graden" ohne darauf zu achten was mit anderen Farben passiert. So einfach darf man es sich nun wirklich nicht machen. Zu einem Grading gehört eben dass keine surrealen Farbverschiebungen stattfinden - es sei denn es ist ausdrücklich so gewünscht - was aber hier nicht der Fall ist. Und wenn sowas passiert wie hier sollte man zumindest drauf eingehen, sonst entsteht der Eindruck dass man das was man macht entweder nicht unter Kontrolle hat oder dass man kein Auge für eventuell verschluderte Ergebnisse hat.

Das das Geradebiegen des Himmels jetzt keine Zauberei ist hast Du ja selbst demonstriert (auch wenn hier einiges wieder anders verschoben wurde)- Wieso stellt man also sowas ins Netz? So wie es vorzufinden ist hat es keinen Wert sondern stiftet eher nur Verwirrung.

Antwort von domain:

Frank:

1. Rosa Himmel: EIn Kanal clippt und die wissen nicht wie man das in Resolve löst.

Stimmt schon, du hast es nicht geschrieben und im übrigen ist das auch ganz einfach in fast jedem NLE zu korrigieren, hat mit Resolve gar nix zu tun.

Nur Augen im Kopf sollte man halt schon haben.

Übrigens spielen die Kontraste in einem Gesicht eine wesentliche Rolle. Dürfen bei Portraits von Jugendlichen nie zu stark sein.

Habe sie etwas zurückgenommen, damit sieht die Haut etwas weicher aus

Antwort von TaoTao:

Wenn man hier mal was lernt dann nur wenn sich zwei Leute gegenseitig ans Bein pinkeln.

Am besten garnicht mehr nachfragen wenn man ein Problem hat sondern einfach irgendeine Behauptungen aufstellen, denn Wichtigtuer die immer Recht haben wollen gibt es genügend...:D

Antwort von r.p.television:

Wenn man hier mal was lernt dann nur wenn sich zwei Leute gegenseitig ans Bein pinkeln.

Am besten garnicht mehr nachfragen wenn man ein Problem hat sondern einfach irgendeine Behauptungen aufstellen, denn Wichtigtuer die immer Recht haben wollen gibt es genügend...:D

Und ich habe gelernt dass Du im Prinzip ausser solchen Stänkerein gegen andere Forenmitglieder wenig beizutragen hast.

Leute die mehr wissen als Du sind immer automatisch Besserwisser oder Wichtigtuer. So kann man sich seine kleine Welt schön reden.

Antwort von Frank Glencairn:

@Frank Glencairn

Mir geht es bestens, nur Dir vielleicht gleich nicht mehr, wenn Du Deinen geschriebenen Quatsch selbst erkennen mußt:

..

Damit kann man dann auch hinter dem Filter am Sensor nur R, G, oder B Farbwerte messen und keine echten Schwarz/Weiß-Werte. Das kann nur eine Kamera,..

Da nur Farbwerte im Sensor gemessen werden, können die RAW Daten auch nur Farbwerte sein (genau genommen: Farbhelligkeitswerte der entsprechenden Filterbeschichtungsfarbe). Dass man diese im ersten Bearbeitungsschritt (vor dem Debayern) gerne nur schwarz-weiß darstellt, heißt eben nicht, dass das Schwarz-Weiß-Werte sind, da kannst Du noch so viele Bilder in schwarz-weiß posten - das solltest Du eigentlich mittlerweile verstanden haben....blah.

LOL - tolles Eigentor.

Du hättest den von dir verlinkten Wikipedia Artikel vielleicht vorher lesen sollen, bevor du dich darauf berufst.

Erster Satz: "Die lichtempfindlichen Zellen einer einzelnen Fotozelle auf dem Halbleiter können nur Helligkeitswerte erfassen."

Daran ändert sich auch nix, wenn man einen Farbfilter davor macht. Es bleibt ein Luminazwert - sprich s/w (wenn man es genau nimmt ist es eigentlich nur der Wert einer Spannung - im Prinzip sind das kleine Solarzellen, die halt mehr oder weniger Strom abgeben.)

Wenn du in diesem - von dir verlinkten Artikel - runter scrollst, findest du mehrere Bilder.

Das erste ist mit " Original-Sensorbild (Helligkeitsinformation in Schwarz-Weiß)" beschriftet.

zum Bild

Dem gibt es nichts mehr hinzuzufügen. Alles andere was du schreibst hat sich damit sowieso erledigt.

Frank:

1. Rosa Himmel: EIn Kanal clippt und die wissen nicht wie man das in Resolve löst.

Stimmt schon, du hast es nicht geschrieben und im übrigen ist das auch ganz einfach in fast jedem NLE zu korrigieren, hat mit Resolve gar nix zu tun.

Doch das hat schon was mit Resolve zu tun. Das mit dem Rosa passiert in manchen Fällen bei einzelnen geclippten Kanälen, wenn man das "clipping " Kästchen aktiviert hat. Wenn man es ausschaltet verschwindet auch das Rosa sofort. Diesen Bug gibt es seit mindestens 3 Versionen - hat sich entweder noch nicht bis zu Shane durchgesprochen, oder es war ihnen einfach egal, weil es ihnen auschließlich um die Hauttöne ging.

Antwort von dienstag_01:

Nach dieser Logik haben wir alle nur S/W-Kameras, bringt doch nichts, diese Wortklauberei ;)

Doch das hat schon was mit Resolve zu tun. Das mit dem Rosa passiert in manchen Fällen bei einzelnen geclippten Kanälen, wenn man das "clipping " Kästchen aktiviert hat. Wenn man es ausschaltet verschwindet auch das Rosa sofort. Diesen Bug gibt es seit mindestens 3 Versionen - hat sich entweder noch nicht bis zu Shane durchgesprochen, oder es war ihnen einfach egal, weil es ihnen auschließlich um die Hauttöne ging.

Kannst du mir mal erklären, wie der rosa Himmel bei diesen (seinen) Werten clippen kann. Kommt mir echt gefährlich vor, dieses Resolve ;)

Antwort von Starshine Pictures:

Ihr habt Probleme ... Der Himmel war das letzte auf was ich an dieser Szene geachtet habe ... :-P <3

Antwort von klusterdegenerierung:

Doch das hat schon was mit Resolve zu tun.

Aber kannst Du Dich noch erinnern das ich das auch in ACR hatte?

Hatten wir hier mal drüber diskutiert, wo von das wohl kommen könnte und da hast Du mir auch den Tipp mit Resolve gegeben, aber im ACR bekam man es nur weg wenn man es mit den Lichter erhalten nicht so übertrieb, anders war da nix zu machen!

Antwort von klusterdegenerierung:

Kannst du mir mal erklären, wie der rosa Himmel bei diesen (seinen) Werten clippen kann.

Meiner Meinung nach ist das im dem Sinne kein echtes Clippen, denn clippen bedeutet ja das man die höhen rausdreht bis sie wegbrechen.

Hier ist es aber eher andersrum, es kommt dann wenn man versucht das clippen zu verhindern.

Das liegt wie Frank aber schon sagt, nur am Häkchen setzten in Resolve, ich meine das hatte Sinngemäß die Bedeutung "Spitzlichter erhalten".

Sollte man auf jeden Fall vorher rausnehmen und das hatten die lediglich vergessen.

Für einen erfahrenen Resolver, ist das also Wuppe, der weiß woher das kommt und wird das weg machen wenns Zeit wird.

Ausserdem ist es schon ziemlich vermessen und überheblich, Shane unterstellen zu wollen, das er oder sein Team zu blöde für sowas sind!!

Antwort von CameraRick:

Ihr habt Probleme ... Der Himmel war das letzte auf was ich an dieser Szene geachtet habe ... :-P <3

Ich bin liiert und bin über die rosa rota Farbe raus, da fällt Dir das direkt ins Gesicht ;)

Ne mal im Ernst. Das haut einem doch direkt ins Auge.

Hat doch das Farbchart direkt dabei, kann er doch abgleichen wenn er wollte.

Antwort von klusterdegenerierung:

Ihr habt Probleme ... Der Himmel war das letzte auf was ich an dieser Szene geachtet habe ... :-P <3

Ich bin liiert und bin über die rosa rota Farbe raus, da fällt Dir das direkt ins Gesicht ;)

Ne mal im Ernst. Das haut einem doch direkt ins Auge.

Hat doch das Farbchart direkt dabei, kann er doch abgleichen wenn er wollte.

Oh man, die gucken sich die Hautfarbe an, sowie die Colorchecker!

Wozu sollen die jetzt das Rosa aus dem Himmel drehen wenn es nur dort ist und die sich einen Pup dafür interessieren, zumal sie wissen das es eine Standarteinstellung ist die man rausnimmt wenn man möchte.

Ich meine, wenn einer Farbrauschen im SW zeigen möchte, ist es dann wichtig, irgendwo im Bild auch farbige Flächen zu haben? Nö!

Antwort von domain:

.. sehr gelungen - vor allem bei ISO 400 - was nicht weiter überraschen dürfte, da ISO 400 die native ISO der URSA darstellt.

Mich überrascht das schon bzw. verstehe nicht ganz. Wieso ist bei 400 im Gegensatz zu 200 ASA und bei natürlich angepasster Belichtung hier plötzlich eine Durchzeichnung im Himmel vorhanden?

zum Bild http://img5.fotos-hochladen.net/uploads/modell400asa0ij7akqlmx.jpg

Antwort von Axel:

.. sehr gelungen - vor allem bei ISO 400 - was nicht weiter überraschen dürfte, da ISO 400 die native ISO der URSA darstellt.

Mich überrascht das schon bzw. verstehe nicht ganz. Wieso ist bei 400 im Gegensatz zu 200 ASA und bei natürlich angepasster Belichtung hier plötzlich eine Durchzeichnung im Himmel vorhanden?

Ich habe den Thread bis hierher nicht gelesen und den zugrundeliegenden Hurlbut-Artikel nur überflogen. Ich kann mich irren, aber die "Ungraded"-Aufnahmen sehen mir nach typischem ProRes-Log aus und nicht nach Raw. In ProRes sehen wir bereits eine Interpretation. "Iso" ist keine elektronische Signalverstärkung oder -Abschwächung, sondern eine Kurve. Natives Iso 400 = 11 Blenden mehr oder weniger linear. Iso 200 = höhenbetont, Tiefen abgeflacht. Warum der Himmel dann clippt?. Weil (per ND) gar nicht auf den Himmel belichtet wurde, sondern auf die Frau in ihrer dunklen Jacke. Iso 200 erscheint per se "dunkler". Hellt man die Mitten auf, clippen die Höhen. Iso 800 = tiefenbetont. In beiden Fällen hat man nicht mehr die ursprünglich mögliche Dynamik. Stellt sich die Frage, wieso man von der nativen abweichende Isos benutzt. Antwort: Wenn man es nicht besser weiß.

Wie bereits erschöpfend dagelegt, haben für BM-Kameras Iso-Einstellungen keinen echten Einfluss bei Raw. Es werden nur andere Metadaten geschrieben, die von Resolve benutzt werden, um eine Darstellungskurve anzuwenden ("wie Aufnahme"), aber jederzeit in der Post verwerfbar. In ProRes sind die Änderungen permanent, Stichwort "eingebacken".

Antwort von domain:

Ja stimmt,

die Sinnlosigkeit von ASA- bzw. Gainverstellungen wurde hier schon öfters diskutiert und speziell von WoWu angesprochen. Man muss sich also quasi vorstellen, dass man für alle Lichtsituationen immer nur einen 400 ASA Negativfilm in der Kamera hat, egal welche Empfindlichkeit man auch immer einstellt.

Es geht demnach nur mehr darum, dem Sensor ein möglichst brauchbares Lichtquantum innerhalb seiner Dynamikfähigkeiten zukommen zu lassen.

Der Rest wird aus der „Entwicklung“ herausgekitzelt, wie es ja auch schon im Negativ-Positiv-Prozess üblich war und übrigens auch mit ziemlich denselben Effekten, wie z.B. tolles Korn, wenn man die zarte Durchzeichnung bei Schattenbildern über hart eingestelltes Papier (Variokontrast über Gelb- und Magentafarben belichtet) und gequält verlängerte Entwicklung noch zu halbwegs normalen Bildern bringen wollte.

Antwort von Axel:

Stimmt für BM. Soweit ich weiß kann es bei anderen Kameras durchaus komplexer sein, wo es echten Gain gibt, auch wenn er irreführenderweise dort Iso genannt wird. Oder halt Mischformen, wo bei der Aufnahme mit Gain gearbeitet wird und vor der Kompression noch weiß-der-Teufel-was an Lumaverbiegung passiert.

Antwort von klusterdegenerierung:

Es gäbe aber auch noch die Variante, das sie zwischen den Shots etwas Zeit vergehen liesen und Wolken gezogen sind und vorher war es nur Grau am Himmel :-)

Antwort von mash_gh4:

Stimmt für BM. Soweit ich weiß kann es bei anderen Kameras durchaus komplexer sein, wo es echten Gain gibt, auch wenn er irreführenderweise dort Iso genannt wird.

ja -- bei den foto-orientierten kameras/sensoren verhält es sich durchwegs ein bisserl anders.

Antwort von domain:

U.a. bei BM fehlt offenbar die gesamte Intelligenz von riesigen Entwicklerstäben bei der vorverdauenden Bildaufbereitung schon in der Kamera ;-)

Das notwenige Know-How wird auf den User abgeladen und wie man sieht, sind die oft hoffnunglos überfordert.

Wie sagt Axel so schön:

„Mischformen, wo bei der Aufnahme mit Gain gearbeitet wird und vor der Kompression noch weiß-der-Teufel-was an Lumaverbiegung passiert.“

Weiß der Teufel was, aber unsereiner nicht :-)

Antwort von CameraRick:

Oh man, die gucken sich die Hautfarbe an, sowie die Colorchecker!

Wozu sollen die jetzt das Rosa aus dem Himmel drehen wenn es nur dort ist und die sich einen Pup dafür interessieren, zumal sie wissen das es eine Standarteinstellung ist die man rausnimmt wenn man möchte.

Der klassische Macbeth würdigt Hauttöne mit den "ersten" beiden Farben (klassische Anordnung, nicht wie hier zu sehen). Der rest geht um andere, natürlich vorklommende Farben (das ist zuumindest die Idee). Daneben ja auch weiß, grau, schwarz. Sogar himmelblau! Aber das weißt Du natürlich und Du wirst ja immer künstlich sauer wenn man Dir Dinge erzählt die Du weißt, also führe ich mal aus wieso ich das interessant finde.

Da die Charts nicht so sind, kann man sich eher das Clippen eines Kanals vorstellen. Bzw, die Einstellung im RAW Dialog, die Frank erwähnte.

Da 200ASA aber so einen zerfressenen Himmel hat, 400ASA hingegen nicht, könnte man meinen es wurde Prores - nicht RAW - gedreht (sonst sollte der Himmel ja noch da sein). Das führt uns jetzt an einen interessanten Punkt, weil man sich fragt: wieso ist der Himmel also rosa, wenn es nicht das einfache Entwicklungs-Setting war, und das Grading sich ja nur auf die Haut bezieht?

So oder so wäre es interessant dazu was im Artikel darüber zu finden. Weils schon ein schlechtes Licht auf die Cam wirkt, oder auf die Grading-Skills. Denn selbst wenn es ausschließlich um Hauttöne geht, sollte jeder Colourist mit zwei Gehirnzellen im Kopf behalten dass man in einem Grading auf mehr als nur Haut schaut (egal, wie lasziv die junge Dame in die Kamera blickt.

Dich kümmert das offenbar alles nicht, aber ich find das schon einen sehr wichtigen Punkt. Also frage ich mich weiter: technische Probleme, oder einfach eine Pfeiffe?

Antwort von r.p.television:

Finde ich auch.

Wenn da steht "graded" dann verstehe ich darunter eben gegradet und nicht nur eine Gammkurve reingehauen die mir die Kontraste und die Sättigung anhebt. Das kann jedes Kind.

Dafür brauch ich keine Farbcharts und vier Leuchtenstative auf einen Gehweg zerren. In diesem Context wirkt das einfach peinlich.

Wenn die schon Headlines schreiben wollen die Klicks für ihre Bannerwerbung

generieren dann sollten sie sich schon ein wenig mehr Arbeit machen. Das gehört zum Job.

Antwort von Axel:

Ganz eindeutig ist das schlampiges "Grading", denn in Resolves "Log"-swatches ist es null Problem, den rosa Stich zu entfernen, ohne die anderen Bereiche zu beeinflussen, egal, ob es Raw, ProRes oder was anderes ist. Und auch egal, ob hier Kanäle clippen, der "Colorist" eine Abendstimmung erzeugen wollte oder der verwendete IR-Filter nicht tief genug sperrte. Erstaunlich höchstens, dass sich der Für-jedes-Objektiv-einen-eigenen-Kamerabody-Superprofi Hurlbut nicht schämt, das mit seinem Namen in Verbindung zu bringen.

Antwort von domain:

Kann wohl nicht stimmen Axel. Es hängt nur am Häkchen am Kästchen von Resolve ;-)

Frank Glencairn:

....passiert in manchen Fällen bei einzelnen geclippten Kanälen, wenn man das "clipping " Kästchen aktiviert hat. Wenn man es ausschaltet verschwindet auch das Rosa sofort.

Ist das aktivierte Kästchen übrigens eine Defaulteinstellung? Das wäre natrürlich schon bedauerlich, gell Frank

Antwort von CameraRick:

Ist kein Default.

Was spannend ist: er erwähnt den Himmel doch auch.

Manch einer hier hat ja bemerkt dass es nur um Hauttöne geht und da guckt man nicht in den Himmel, aber gelesen haben die den Artikel wohl nicht (gell, kluster?). Er erwähnt doch explizit wie der Himmel mehr und weniger ausfrisst.

Egal ob das jetzt eine technische Unzulänglichkeit ist oder schlampiges Grading -

jemand, der das online stellt ohne es weiter zu beleuchten und mir versucht was über gute Hautfarben zu erzählen, dem stehe ich skeptisch gegenüber.

Antwort von mediavideo:

@Frank Glencairn

Versuche einfach mal RAW zu verstehen:

@Frank Glencairn

Mir geht es bestens, nur Dir vielleicht gleich nicht mehr, wenn Du Deinen geschriebenen Quatsch selbst erkennen mußt:

1. Eine übliche Farbkamera hat auf dem Sensor vor jedem Pixel eine Farbfilter-Beschichtung. Diese ist im wechselnden Bayer-Muster R/G/B filterbeschichtet ( https://de.wikipedia.org/wiki/Bayer-Sensor ).

Damit kann man dann auch hinter dem Filter am Sensor nur R, G, oder B Farbwerte messen und keine echten Schwarz/Weiß-Werte. Das kann nur eine Kamera, z.B. die RED EPIC MONOCHROME, denn da fehlt die R/G/B Filterbeschichtung vor den Pixeln.

2. Nun sind RAW Daten quasi die direkten und möglichst unverfälschten Sensorauslesedaten. Da nur Farbwerte im Sensor gemessen werden, können die RAW Daten auch nur Farbwerte sein (genau genommen: Farbhelligkeitswerte der entsprechenden Filterbeschichtungsfarbe). Dass man diese im ersten Bearbeitungsschritt (vor dem Debayern) gerne nur schwarz-weiß darstellt, heißt eben nicht, dass das Schwarz-Weiß-Werte sind, da kannst Du noch so viele Bilder in schwarz-weiß posten - das solltest Du eigentlich mittlerweile verstanden haben.

3. Was Du mit den Metadaten meinst, hat nichts damit zu tun, dass das keine Farbwerte sind. Die Metainformationen zu den Farben braucht man nur um zu wissen welche R/G/B Farbfilter genau vor den Sensorpixeln sind, denn das muss man für das Debayern möglichst genau wissen. Nimm z.B. mal die F5 und F55, da steht bei Sony ganz deutlich, dass die Sensorbeschichtung unterschiedlich sei. Damit braucht man genau die Informationen, also die Farbinformation der Filterbeschichtung, sonst kann man nicht ordentlich debayern. Das schmeisst Du aber alles gehörig durcheinander und reimst Dir da was zusammen.

Ich hätte eigentlich erwartet, dass Du den Denkfehler spätestens dann bemerkt hättest nachdem r.p.television geschrieben hat: Und woher nimmt der Rechner die Farben, wenn das doch alles nur schwarz-weiß Werte sein sollen?

Aber Dir scheint das wirklich nicht klar zu sein wie das genau funktioniert.

Du wirst doch hoffentlich nicht weiter behaupten wollen, dass man hinter Farbfiltern was anderes misst als die entsprechenden Farbwerte bzw. Farbhelligkeitswerte der Grundfarben, die aber eben keine schwarz-weiß Werte sind.

Da Du das nicht logisch kapieren willst oder kannst, dann eben mathematisch ( z.B. aus dem YUV Farbmodell: http://de.wikipedia.org/wiki/YUV-Farbmodell ):

Y (Schwarz-Weiß-Wert) = 0,299 * R (Rot-Wert) + 0,587 * G (Grün-Wert) + 0,114 * B (Blau-Wert)

1. Wenn man Farbwerte an den Pixeln bei üblichen Bayer-Sensoren misst, also z.B. R oder B oder G Wert:

Um aus einem Farbwert den Schwarz-Weiß-Wert Y zu bekommen musst Du also "eine Gleichung" mit "drei Unbekannten" lösen - und das geht leider nicht!

Da braucht man nicht zur technischen Uni, Hauptschule 9. Klasse Mathematik reicht dafür um zu sehen, dass man aus einem Farbgrundwert (z.B. R) niemals den Schwarz-Weiß-Wert korrekt errechnen kann.

2. Wenn man Schwarz-Weiss Werte an den Pixeln misst, also z.B. mit der RED EPIC Monochrome (ohne R/G/B-Grundfarben-Sensorbeschichtung):

Um aus dem Schwarz-Weiß-Wert Y einen Grundfarbwert (z.B. R) zu bekommen musst Du ebenfalls "eine Gleichung" mit "drei Unbekannten" lösen - und das geht wieder nicht! (Lassen wir mal die wenigen Sonderfälle wie z.B. Schwarz weg)

Auch hier reicht die Hauptschule 9. Klasse Mathematik um zu sehen, dass man aus einem Schwarz-Weiß-Wert niemals einen Farbgrundwert (z.B. R) korrekt errechnen kann.

Da wir am Ende der RAW-Kette ein Farbbild haben, können wir niemals in der Bearbeitungskette nur Schwarz-Weiß-Werte haben, dann gingen keine Farbbilder mehr - mathematisch kapiert ?

1. Möglichkeit für Dich:

Du siehst ein, dass es ein kompletter Quatsch ist, dass im RAW alles Schwarz-Weiß Werte sind, dann hast Du nun folgendes kapierst:

Man kann niemals mehr aus Schwarz-Weiß-Werten die einzelnen Farbwerte zurückrechnen und bekäme so maximal nur noch ein Schwarz-Weiß-Bild.

2. Möglichkeit für Dich:

Du polterst hier wirklich im Forum herum und scheiterst schon an 9. Klasse Hauptschule Mathematik, die man dringend für Dein Videohobby bei der RAW-Betrachtung braucht.

Mit der Entscheidung lasse ich Dich nun alleine und die Leser sollten nun wissen was von Deiner RAW-Meinung mit Schwarz-Weiß-Werten zu halten ist.

Allerdings finde ich es eine Frechheit gegenüber anderen im Forum, wenn man hochtraben offensichtlich völligen Mist schreibt, es selber auch nach einfacher Erklärung noch nicht einmal kapieren will und Leute wie r.p.television versucht runter zu machen ... - Schämst Du Dich überhaupt nicht?

Antwort von iasi:

Ja stimmt,

die Sinnlosigkeit von ASA- bzw. Gainverstellungen wurde hier schon öfters diskutiert und speziell von WoWu angesprochen. Man muss sich also quasi vorstellen, dass man für alle Lichtsituationen immer nur einen 400 ASA Negativfilm in der Kamera hat, egal welche Empfindlichkeit man auch immer einstellt.

Es geht demnach nur mehr darum, dem Sensor ein möglichst brauchbares Lichtquantum innerhalb seiner Dynamikfähigkeiten zukommen zu lassen.

Der Rest wird aus der „Entwicklung“ herausgekitzelt, wie es ja auch schon im Negativ-Positiv-Prozess üblich war und übrigens auch mit ziemlich denselben Effekten, wie z.B. tolles Korn, wenn man die zarte Durchzeichnung bei Schattenbildern über hart eingestelltes Papier (Variokontrast über Gelb- und Magentafarben belichtet) und gequält verlängerte Entwicklung noch zu halbwegs normalen Bildern bringen wollte.

So einfach ist das aber eben doch auch nicht.

Schon ein 400 ASA Negativfilm reagiert je nach Entwicklung und Belichtung unterschiedlich.

Eine interessante Diskussion dazu gibt es hier

http://www.reduser.net/forum/showthread ... nd-for-all!

das lässt sich durchaus auf andere Kameras übertragen.

Es wäre aber kein gutes Zeichen, wenn wirklich ein Clippen vorliegen würde - das sollte bei einem Test nicht geschehen, denn bestmögliche Belichtung und Ausleuchtung wäre doch eigentlich gefordert.

Antwort von mash_gh4:

Schon ein 400 ASA Negativfilm reagiert je nach Entwicklung und Belichtung unterschiedlich.

ja -- natürlich gilt das auch für digitale kameras und sensoren:

je länger die entwicklung dauert, umso empfindlicher werden sie -- aber halt leider auch grobkörniger und kontrastreicher. wenn dagegen die entwicklung rascher als normaler erfolgt, müssen die aufnahmen ständig überbelichtet werden, aber man kann wenigstens vom tollen dynamikumfang schwärmen.

od. so ähnlich halt... ;)

Antwort von CameraRick:

Da wir am Ende der RAW-Kette ein Farbbild haben, können wir niemals in der Bearbeitungskette nur Schwarz-Weiß-Werte haben, dann gingen keine Farbbilder mehr - mathematisch kapiert ?

Oh ist das unangenehm diese Beiträge zu lesen :/

Vielleicht solltest Du mal in die Kanal-Ansicht in Photoshop gehen, die hilft Dir vielleicht weiter. Bunt ist da auf einem Sensor nichts, nur Helligkeitswerte, nur schwarz, grau, weiß.

Es wäre aber kein gutes Zeichen, wenn wirklich ein Clippen vorliegen würde - das sollte bei einem Test nicht geschehen, denn bestmögliche Belichtung und Ausleuchtung wäre doch eigentlich gefordert.

Das stimmt, aber man denkt an diesem Punkt ja, es liegt am Prores - weil das nun mal (früher) nur dort passiert. Und das war Dir ja auch nicht neu, kein Geheimnis.

Die RED Argumentation ist dann nur bedingt vergleichbar, denn die macht eben nur RAW

Antwort von Frank Glencairn:

Da Du das nicht logisch kapieren willst oder kannst, dann eben mathematisch]

LOL, ich hab das ja nur ein paar Jahre an der Uni unterrichtet, aber klar, lass mal hören.

1. Wenn man Farbwerte an den Pixeln bei üblichen Bayer-Sensoren misst....

..und raus bist Du.

2. Möglichkeit für Dich:

Du polterst hier wirklich im Forum herum und scheiterst schon an 9. Klasse Hauptschule Mathematik, die man dringend für Dein Videohobby bei der RAW-Betrachtung braucht.

Mein "Videohobby" - soso.

Mit der Entscheidung lasse ich Dich nun alleine und die Leser sollten nun wissen was von Deiner RAW-Meinung mit Schwarz-Weiß-Werten zu halten ist.

Ich fühl mich schon ganz alleine.

Allerdings finde ich es eine Frechheit gegenüber anderen im Forum, wenn man hochtraben offensichtlich völligen Mist schreibt, es selber auch nach einfacher Erklärung noch nicht einmal kapieren will und Leute wie r.p.television versucht runter zu machen ... - Schämst Du Dich überhaupt nicht?

Immer wenn man denkt das Niveau hat bereits Ground Zero erreicht, kommt einer der es schafft das ganze nochmal tiefer zu legen.

...

Okay, schluß mit lustig.

Hör zu. Ich tu jetzt mal einfach mal so, als hätte ich diese Mischung aus Bullshit und Beleidigungen nicht gelesen.

Du besorgst dir ein paar Fachartikel/Bücher und arbeitest dich erst mal in das Thema ein. Wenn du dann noch Fragen hast, kannst du die gerne hier stellen.

Antwort von Jensli:

2. Möglichkeit für Dich:

Du polterst hier wirklich im Forum herum und scheiterst schon an 9. Klasse Hauptschule Mathematik, die man dringend für Dein Videohobby bei der RAW-Betrachtung braucht.

die Leser sollten nun wissen was von Deiner RAW-Meinung mit Schwarz-Weiß-Werten zu halten ist.

Nun, immerhin wissen die Leser jetzt, was von dir zu halten ist. Ich habe keine Ahnung, wer du bist, aber jeder, der sich länger hier im Forum aufhält, weiß, wer Frank Glencairn ist und was für Referenzen hinter ihm stehen. Du solltest den Ball mal flach halten. Ich kenne nur wenige, die sich so blamiert haben, wie du gerade mit deinem ahnungslosen Post...

Antwort von Angry_C:

Ich hatte beruflich mit dem CMV2000 Sensor, also mit der 2K Version zu tun und kann daher ein Lied von der "rosa Highlights Problematik" singen.

Ganz einfach ausgedrückt liegt es daran, dass der Sensor in der 200 ASA Einstellung im negativen Gainbereich gefahren wird, was nicht nur Dynamik kostet, sondern auch eine entsprechende Gammaanpassung benötigt. Das hat Blackmagic anscheinend nicht berücksichtigt und fährt die gleiche Gammaeinstellung wie bei ISO400/800.

Antwort von kundesbanzler:

@ Frank & mediavideo:

Ich bin etwas verwundert über eure Auseinandersetzung, da ihr schlicht verschiedene Begrifflichkeiten benutzt, aber euch beiden das konsequent nicht auffällt.

Frank, du meinst bei "Schwarz-Weiß" ein Bild oder Wert, das oder der lediglich einen Kanal aufweist, und somit zb auf einem Anzeigegerät nur in S/W angezeigt werden kann. Alles was raw ist, ist natürlich so beschaffen.

mediavideo meint mit "Schwarz-Weiß" ein Bild oder Wert, das oder der der tatsächlichen Luminanz (also der Schwarz-Weiß Information) der Szene entspricht. In diesem Sinne hat er sogar Recht, dass der einzelne Pixel keine "echte" S/W Information beinhaltet, da ein Teil der Farben stets schon rausgefiltert wurden.

Was war jetzt nochmal ausgangs die Fragestellung?

Antwort von Frank Glencairn:

Es ging darum ob raw Daten vor dem Debayering s/w oder farbig sind - aus irgendeinem bizarren Grund hat mediavideo noch zusätzlich YUV in's Spiel gebracht, was da natürlich überhauptnix zu suchen hat

Antwort von kundesbanzler:

Es ging darum ob raw Daten s/w oder farbig sind

Ja wie gesagt, das ist ein Streiten über Begriffe.

Nach mediavideos Begrifflichkeit sind raw Daten nicht schwarzweiß, sondern drei verschachtelte schwarzgrüne, schwarzrote und schwarzblaue Bilder, was auf eine pedantische Art schlicht richtig ist. Ob das eine besonders sinnvolle Art ist, sprachlich damit umzugehen ist dann wieder eine andere Frage, aber dass er das so meint, hätte einem zwischendurch schon mal auffallen können.

Antwort von Elsalvador:

Hast du in der Uni auch all deine Ausführungen mit "LOL" begonnen? #slashcam-umganstonoffensive-2015

Antwort von klusterdegenerierung:

Also ich finde das Frank das garnicht gesagt hat was Mediavideo korrigieren möchte!

Die reden an einander vorbei!

Frank meinte, in dem er sagte das ein Raw eigentlich SW sei, das der Sensor nur Luminanz wahrnehmen kann und keine Farben und nennt es zur Veranschaulichung deshalb SW!

Was jetzt gut gemeint ist, führt aber leicht zu Missverständnissen.

Er hat zwar nicht Unrecht, weil der Sensor ja keine Farben sehen kann sondern nur Helligkeitsabstufungen, Farbe wird ja erst daraus, weil Farbfilter darüber angebracht sind, wie man es auch aus dem ersten Wiki Link von Mediavideo entnehmen kann.

Ich denke auch das Mediavideo sich ihn selber nicht durchgelesen hat.

Er behauptet ja, Frank hätte gesagt, ein RAW Bild sei eigentlich SW!

Das hat er zwar so nicht gesagt, aber man könnte es so auffassen.

Franks Denke setzt ja schon viel früher an, auf dem einzelnen Sensor unter den Farbfiltern. Lässt man diese und den Rechnenprozess in RGB weg, ist das Raw tatsächlich SW.

Allerdings finde ich, das sich Mediavideo wie ich hier vielleicht manchmal auch, die letzte Post lieber hätte noch mal genauer überlegen sollen, bevor er sie absendet!

Antwort von Frank Glencairn:

Nach mediavideos Begrifflichkeit sind raw Daten nicht schwarzweiß, sondern drei verschachtelte schwarzgrüne, schwarzrote und schwarzblaue Bilder,

Sind aber halt keine verschachtelten Bilder sondern Grauwerte. Sieht man ja schon an der Datenmenge vor und nach dem Debayern.

Ein Grauwert von z.b. 60% mit einem Rotfilter davor, macht im fertigen Bild eben etwas anderes als ein Grauwert von 60% mit einem Grünfilter.

Trotzdem stehen in den raw Daten nur zwei Grauwerte mit jeweils 60%. Erst durch die Interpretation im Rechner, anhand der Tabelle, auf welchem Pixel welcher Filter sitzt, wird aus eine Grauwert von 60%, einmal ein rotes und einmal ein grünes Pixel.

Antwort von kundesbanzler:

Der Punkt ist: dadurch dass du (bzw. deine Software) weißt, an welcher Stelle welcher Filter sitzt macht es das für dich zur Farbinformation, also ist es wenn man so will farbig.

Ansonsten könnte man deine Begriffe auch zu Ende denken und sagen, jedes RGB-Bild ist auch nur schwarzweiß, weil es drei Graustufenbilder sind und nur durch das Wissen darüber, welcher Kanal welche Farbe ist, wird es farbig - durch die Interpretation im Rechner.

Aber hilft es irgendwem weiter, wenn wir festhalten dass wir genau genommen ausschließlich "Schwarzweißbilder" auf unseren Datenträgern haben?

Antwort von r.p.television:

Die Aussage Raw sei SW ist für mich nach wie vor nicht richtig. Ich interpretiere das anders.

Wenn hinter dem Sensor mithilfe der Farbfilter das Signal so zusammengerechnet wird (jetzt mal ganz dilletantisch formutliert) dass mithilfe von verschiedenen Grauwerten später ein Farbbild errechnet werden kann, dann ist das für mich kein SW.

Der Rechner ist hier quasi die Enigma, aber ein reines SW-Bild ist es zu keinem Zeitpunkt, weil ja verschlüsselt die Werte vorhanden sind.

Von daher hat Frank schon recht, aber auch irgendwie nicht. Ist Interpretationssache. Wenn ich aus einem Signal bestimmte Werte herausrechnen kann dann sind Informationen vorhanden, nutzt man diese nicht hat man ein SW-Bild. Hm. Da aber sowieso klar ist dass ein Raw-Bild in einer Raw-Engine zum Debayern landet die mit diesen Werten per default umzugehen weiss ist es für mich halt schwierig von einem SW-Bild zu sprechen.

Dann könnten wir bei PAL auch von SW sprechen wenn wir das Chrominanz-Signal unterschlagen.

Unter dem Strich bleibt das Geschmäckle dass dieser "Test" einfach sehr suboptimal gelaufen ist. Kein Colorist solle für ein repräsentatives Grading der Hauttöne ein Clipping, einen Farbshift oder was auch immer bis zur Publikation stehen lassen ohne darauf einzugehen.

Antwort von klusterdegenerierung:

Die Aussage Raw sei SW ist für mich nach wie vor nicht richtig. Ich interpretiere das anders.

Wenn hinter dem Sensor mithilfe der Farbfilter das Signal so zusammengerechnet wird (jetzt mal ganz dilletantisch formutliert) dass mithilfe von verschiedenen Grauwerten später ein Farbbild errechnet werden kann, dann ist das für mich kein SW.

Der Rechner ist hier quasi die Enigma, aber ein reines SW-Bild ist es zu keinem Zeitpunkt, weil ja verschlüsselt die Werte vorhanden sind.

Von daher hat Frank schon recht, aber auch irgendwie nicht. Ist Interpretationssache. Wenn ich aus einem Signal bestimmte Werte herausrechnen kann dann sind Informationen vorhanden, nutzt man diese nicht hat man ein SW-Bild. Hm. Da aber sowieso klar ist dass ein Raw-Bild in einer Raw-Engine zum Debayern landet die mit diesen Werten per default umzugehen weiss ist es für mich halt schwierig von einem SW-Bild zu sprechen.

Dann könnten wir bei PAL auch von SW sprechen wenn wir das Chrominanz-Signal unterschlagen.

Unter dem Strich bleibt das Geschmäckle dass dieser "Test" einfach sehr suboptimal gelaufen ist. Kein Colorist solle für ein repräsentatives Grading der Hauttöne ein Clipping, einen Farbshift oder was auch immer bis zur Publikation stehen lassen ohne darauf einzugehen.

Nene, Du gehst davon aus das da schon was ist und unterschlagen wird und deswegen ein SW wird!

Richtig ist aber, das es als aller erstes nur aus lichtwerten besteht und diese haben nunmal keine Farbe!

Und da die Farbfilter nicht zum Sensor gehören und nur eine Schicht auf jenem darstellen, kann man durchaus behaupten das ein Raw, welches aus dem Sensor kommt, ein SW Bild ist, ist ja auch so!

Die Farben kommen ja nunmal erst nach dieser ermittlung von Luminanzwerten.

Antwort von r.p.television:

Das ist klar.

Da wir aber niemals Daten direkt vom Sensor bekommen finde ich es schwierig zu sagen das Raw SW ist.

Ich bekomme halt einfach nicht das Bild direkt vom Sensor. Ich bekomme ein Bild in Form eines Streams oder eines Files. Und da ist halt mal die Farbe dabei - in welcher Art und Weise die da anhand von Grauwerten reinverschachtelt ist ist für den User egal.

Was für den User nicht egal ist - und darauf wollte ich ursprünglich hinaus: Bei den BM-Kameras sind diese Farbwerte (ich nenne es jetzt einfach mal so, bitte nicht darauf herumreiten) im Verhätlnis zueinander nicht so linear wie bei anderen Kameras. Deshalb kommt es bei Verschiebungen desöfteren zu solchen seltsamen Farbshifts, teilweise schon beim Entzerren eines Logprofils via der gegensätzlichen Logkurve via Gammakurvenänderung.

Wo nun genau der Fehler zu suchen ist entzieht sich meiner Kenntniss. Ich habe das weder unterrichtet noch schreibe ich Software-Scripts für das Debayern. Für mich sieht das so aus als ob entweder in der Kamera der Fehler passiert oder die Farbtabellen für das Debayern falsch sind bzw nicht für die Kamera und deren Farbfilter angepasst sind.

Antwort von klusterdegenerierung:

Oder die BMC ist ein Fake und sie schaft die 13Blenden garnicht physikalisch und fummelt da was dran, wo der Dynamikumfang nicht mehr reicht.

Bei meiner Pocket ist dies ja immer nur dann aufgetreten wenn es in den Bereich von keine Zeichnung mehr ging, oder halt wenn man das Häkchen hat vergessen raus zu nehmen.

Antwort von r.p.television:

Ein Fake kann es ja eigentlich nicht sein, denn sonst wäre ja eine Zeichnung nicht mehr reproduzierbar. Ich denke einfach dass BM da noch nicht so weit ist um eine fehlerlose (oder eine weniger fehlerlose) Farbreproduktion beim Debayern zu erreichen. Ich habe aber keine Ahnung inwieweit diese Farbtabellen in den Raw-Engines von BM mitentwickelt oder beeinflusst werden oder ob sich BM da an einen genauen Standard halten muss der als Vorlage für die Presets in den verschiedenen Grading-Tools herhalten muss.

Es gibt ja auch immer wieder neue Raw-Images bzw Raw-Formate bei Still-Kameras die Programme wie Photoshop, LR etc. immer wieder via Update "erlernen" müssen.

Vielleicht kann da jemand was dazu sagen. Das würde mich wirklich interessieren und würde vielleicht aufzeigen wo noch Entwicklungspotenzial für ein besseres Debayering verborgen ist.

EDIT: Da bei Raw ja schon das Luminanzsignal (welches den Farbwerten als Basis dient) nicht linear ist, dürfte eine virtuelle Logkurve als Preset sehr schwer anzupassen sein. Vermutlich gibt es deswegen diese ungewöhnlichen Farbshifts. Das Debayern steckt halt doch noch in den Kinderschuhen.

Antwort von schaukelpirat:

Ich weiß nicht, obs hier schon gepostet wurde. Aber unter folgendem link findet ihr ab ca. Min 22 einen Direktvergleichstest zwischen URSA und RED Epic:

Antwort von tom:

@mediavideo

Bitte sachlich argumentieren statt persönlich werden (siehe auch

Nutzungsbedingungen)...

Vielen Dank

slashCAM

Antwort von mediavideo:

@ Frank Glencairn

Was mich stört ist, dass Du hier erst alle Forenleser, inkl. r.p.television, völlig verwirrst mit der verkehrten Darstellung dass RAW alles in Schwarz-Weiß aufnimmt. Dann, wenn z.B. r.p.television verwundert und berechtigt höflich nachfragt wie das gehen soll, wenn die Kamera nur Schwarz-Weiß aufnimmt, woher dann die Farbe kommt, deine unmöglich patzige Antwort: Du hast ja keine Ahnung - fertig!

Und das halte ich nach wie vor für völlig unverschämt. Wenn ich im technisch/wissenschaftlichen Bereich Dir was völlig verzerrtes solange erzähle bis Du unsicher nachfragst, dann darf jeder mit Dir auch so umgehen?

Und das ist völlig korrekt was ich schreibe:

Hinter einem Farbfilter nimmt man Farbwerte auf und nicht Schwarz-Weiß Werte - Ein R/G/B Bild im TGA Format hat drei Farbkanäle mit jeweils Farbwerten bzw. Farbhelligkeitswerten und nicht drei Schwarz-Weiß Kanäle die man später mal irgendwie zu Farben macht. Das ist doch völlig daneben. Vielleicht erkennst Du jetzt dass eine Schwarz-Weiß Bezeichnung für Farbkanäle nirgends sinnvoll verwendet wird und nur verwirrt.

Und zu dem Graustufenbild aus den Raw-Werten nur ein Gedankenexperiment, dass alles zeigt:

Du beschichtest eine Sensor komplett nur mit Rot-Filtern und nimmst ein volles Grün-Bild auf. Jetzt hast Du bei dem Graustufenbild vom RAW Material ein Schwarzbild. Vielleicht kapierst Du jetzt warum der Raw Wert nicht dem Schwarz-Weiß Wert des aufgenommenen Bildpunktes entsprechen kann. Die Bezeichnung Schwarz-Weiß Wert ist völlig verkehrt und führt jeden nur zur irrigen Annahme, dass das RAW Graustufenbild das Schwarz-Weiß Bild des Motives sei, das ist aber definitiv falsch, denn es ist immer nur der Farbhelligkeitswert einer Grundfarbe und der fehlende Restbetrag zum tatsächlichen Schwarz-Weiß Wert ist unbekannt und kann auch nicht errechnet werden.

Und damit ist es dann auch gut jetzt, es darf halt jeder auch einem Irrglauben nachrennen ...

Antwort von klusterdegenerierung:

Hinter einem Farbfilter nimmt man Farbwerte auf und nicht Schwarz-Weiß Werte - Ein R/G/B Bild im TGA Format hat drei Farbkanäle mit jeweils Farbwerten bzw. Farbhelligkeitswerten und nicht drei Schwarz-Weiß Kanäle die man später mal irgendwie zu Farben macht.

Hallo Mediavideo,

ich wundere mich wieso Du das obige geschrieben hast und es Frnak zum vorwurf machst!!!

Fällt Dir denn in dem ersten Satz garnicht auf, das es genau das ist, was keiner gesagt hat, Du aber immer denkst!!!

Da hat niemand geschrieben, das hinter einem Farbfilter SW Werte rauskommen!!

BITTE BITTE, lies es doch nochmal ganz langsam!

VOR dem Farbfilter ist das Signal SW weil es nur aus Luminanzwerten besteht und die haben KEINE FARBEN!!

Frank und die anderen versuchen Dir nicht vor zugaukeln das aus Farbe SW wird!

Der Sensor hat einen Farbfilter, dieser kommt aber erst nach dem ersten Signal, nicht umgekehrt!!

Und bitte verschone uns mit Deiner Fettschreibung, das wird nur noch peinlicher! ;-)

Antwort von Jake the rake:

Das Farbfilter kommt schon vor dem Sensor aber der Sensor misst nunmal nicht die Wellenlänge (Frequenz) des Lichts sondern die Intensität.

Daher ist der rohe Datenstrom "Raw" Schwarz/Weiß.

Dass eine Farbinformation vorhanden ist steht außer Frage.

Antwort von CameraRick:

@ Frank Glencairn

Was mich stört ist, dass Du hier erst alle Forenleser, inkl. r.p.television, völlig verwirrst mit der verkehrten Darstellung dass RAW alles in Schwarz-Weiß aufnimmt. Dann, wenn z.B. r.p.television verwundert und berechtigt höflich nachfragt wie das gehen soll, wenn die Kamera nur Schwarz-Weiß aufnimmt, woher dann die Farbe kommt, deine unmöglich patzige Antwort: Du hast ja keine Ahnung - fertig!

Und das halte ich nach wie vor für völlig unverschämt. Wenn ich im technisch/wissenschaftlichen Bereich Dir was völlig verzerrtes solange erzähle bis Du unsicher nachfragst, dann darf jeder mit Dir auch so umgehen?

Und das ist völlig korrekt was ich schreibe:

Hinter einem Farbfilter nimmt man Farbwerte auf und nicht Schwarz-Weiß Werte - Ein R/G/B Bild im TGA Format hat drei Farbkanäle mit jeweils Farbwerten bzw. Farbhelligkeitswerten und nicht drei Schwarz-Weiß Kanäle die man später mal irgendwie zu Farben macht. Das ist doch völlig daneben. Vielleicht erkennst Du jetzt dass eine Schwarz-Weiß Bezeichnung für Farbkanäle nirgends sinnvoll verwendet wird und nur verwirrt.

Und zu dem Graustufenbild aus den Raw-Werten nur ein Gedankenexperiment, dass alles zeigt:

Du beschichtest eine Sensor komplett nur mit Rot-Filtern und nimmst ein volles Grün-Bild auf. Jetzt hast Du bei dem Graustufenbild vom RAW Material ein Schwarzbild. Vielleicht kapierst Du jetzt warum der Raw Wert nicht dem Schwarz-Weiß Wert des aufgenommenen Bildpunktes entsprechen kann. Die Bezeichnung Schwarz-Weiß Wert ist völlig verkehrt und führt jeden nur zur irrigen Annahme, dass das RAW Graustufenbild das Schwarz-Weiß Bild des Motives sei, das ist aber definitiv falsch, denn es ist immer nur der Farbhelligkeitswert einer Grundfarbe und der fehlende Restbetrag zum tatsächlichen Schwarz-Weiß Wert ist unbekannt und kann auch nicht errechnet werden.

Und damit ist es dann auch gut jetzt, es darf halt jeder auch einem Irrglauben nachrennen ...

Du kniest Dich da zu tief rein, der Frank meint es super simpel (so wie es auch ist)

Wenn da ein Pixel hinter einem blauen Filter hängt und sagen wir mal 62% Auschlag hat wissen wir genau, wie hoch der Farbwert dieses Pixels ist: 62% blau. Aber dieser Pixel hat keine Farbinformation, an und für sich. Beim Sensor kommen "62%" an, nicht "62% blau".

Das ist genau wie früher, wenn Du einen blauen Filter vor einen s/w Film hängst - am Ende ist das Bild immer noch schwarz weiß, aber eben nur der Blaukanal.

Anhand der 62% blau und der Werte der umliegenden Pixel kannst Du nachher die akkurate Farbe berechnen, und Du kannst das auch gerne "Farbwert" nennen - aber die Information liegt erst einmal als Graustufe vor. Da ist nichts bunt.

Ist vielleicht eine Grundsatzfrage, aber das aufgezeichnete Bild ist einfach mal nicht bunt oder farbig oder sonst was. Du kriegst zwar Farbwerte, aber keine Farbe. Die wird errechnet.

Du bringst doch immer die Epic Monochrome vor - stell Dir vor, vor den Sensor der Cam machst Du jetzt eine Bayer-Maske. Ist die Info auf einmal farbig? Nein. Nur die Luminanzinfo wird "verdreht" und daraus Farbe errechnet. Und so funktioniert das nun mal

Antwort von Jott:

Reine Wortklauberei. Es meinen - hoffentlich - alle das Gleiche. RED normal vs. RED Monochrome sind gut zum Grübeln: gleicher Sensor, einmal mit Farbmaske, einmal ohne. Farb-Raw und S/W-Raw darf man nicht sagen, gibt Prügel. Was darf man sagen?

Antwort von mediavideo:

Ja Jott, Du bringst es auf den Punkt. Hier machen einige, speziall aber Frank Glencairn, etliche kapitale Denkfehler.

Und deswegen für alle, die diese völlig falsche Darstellung der RAW-Werte bei Farbkameras als Schwarz-Weiß-Werte verwirrt, mal korrekt dazu:

1. Ein üblicher Kamerasensor misst keine reinen Schwarz-Weiß-Werte (Die falsche Behauptung hier im Forum war: Alle Sensoren messen ja sowieso nur Schwarz-Weiß-Werte)

Dazu schauen wir mal hier:

http://de.wikipedia.org/wiki/Wei%C3%9F

Zitate:

"Weiß ist keine Spektralfarbe, sondern entsteht durch ein Gemisch aus Einzelfarben, das den gleichen Farbeindruck hervorruft wie Sonnenlicht."

...

"Der Farbreiz für das Wahrnehmen von Weiß besteht also darin, dass alle drei Farbvalenzen gleich sind."

...

"... ,wegen der notwendigen Gleichheit der Farbvalenzen bezeichnet man diese Farbe auch als „unbunt“."

...

"Die Sichtbarkeit von Licht wird durch die Empfindung des Auges von Mensch oder Tier bestimmt. Benachbarte Teile des elektromagnetischen Spektrums sind Infrarot und Ultraviolett, die aber nicht mehr mit den visuellen Sensoren in Interaktion treten."

...

"Bei Fernsehgeräten und Computermonitoren entsteht die Farbe ›Weiß‹ durch eine additive Mischung gleicher Intensitäten der Farben Rot, Grün und Blau. Demgemäß hat ›Weiß‹ im RGB-Farbraum den Wert RGB = (255, 255, 255)"

Wir sehen, selbst eine RED EPIC MONOCHROME (Schwarz-Weiß-Kamera) misst fast keine echten Schwarz-Weiß-Werte.

Wer jetzt erst mal verwirrt ist, die Erklärung:

Ein Sensor misst grob gesagt immer die Spektralbereichsintensität bzw. Strahlungsintensität eines Spektralbereiches/Frequenzbereiches. Das diese Werte in über 99,9% keine Schwarz-Weiß-Werte sein können dürfte klar werden wenn man sich vor Augen führt, dass der technische Begriff für Schwarz/Grau/Weiß-Werte eine gleichmäßigen Farbanteil aller Farbbestandteile (z.B. R/G/B-Anteile) voraussetzt. Dies ist im aufgenommenen Originalbild so gut wie niemals der Fall!

2. Wenn schon klar wird, dass selbst eine Schwarz-Weiß-Kamera keine echten Schwarz-Weiß-Bilder aufnimmt, dann kann eine Farbkamera erst recht keine Schwarz-Weiß-Werte messen, da der nach dem Farbfilter aufgenommene Spektralbereich nicht einmal mehr alle Grundfarben abdeckt.

Aber warum bekommen wir ein Schwarz-Weiß-Bild mit einer Schwarz-Weiß-Kamera, wenn doch fast keine Schwarz-Weiß-Werte gemessen werden?

Ganz einfach, es ist eine Falsch-Grauwert-Darstellung. Dies ist so ähnlich wie bei einer Falsch-Farben-Darstellung einer Infrarot-Wärmebildkamera, da sieht man Temperaturbereiche im Bild farbig (blau = kalt ... rot = warm), aber Temperaturen haben natürlich keine echten Farben. Die Falsch-Grauwert-Darstellung beruht auf der Gleichbehandlung von einzelnen Farbwerten und echten Grauwerten. So ergibt ein heller reiner Grünwert z.B. den gleichen Grauwert wie ein weniger heller Grünwert in einem echten R/G/B-gleichen-Grauwert. Ich hoffe das ist verständlich mit der Falsch-Grauwert-Darstellung.

3. Weiterhin misst eine RED EPIC MONOCHROME (Schwarz-Weiß-Kamera) auch nicht den vollen Spektralumfang des Bildes, das würde den Bildinhalt für das menschliche Sehen gefühlsmäßig verfälschen. Es gibt üblicherweise Infrarot/IR-Sperrfilter für niedrige/kleine Frequenzen und einen Ultraviolett/UV-Sperrfilter für hohe/große Frequenzen. Damit soll der Spektralumfang auf das menschliche Sehen begrenzt werden. Und deswegen heißt es nur didaktisch korrekt Schwarz-Weiß-Kamera, denn man sieht letztendlich ein Scharz-Weiß-Bild am Monitor. Würde man eine technisch korrekte Bezeichnung (z.B. Spektralbereichsintensität) für den Messwert nehmen, dann hätten viele Menschen sofort ein Verständnisproblem. Also einigt man sich didaktisch sinnvoll auf einen Schwarz-Weiß-Sensor mit gemessenen Schwarz-Weiß-Werten, die ein Schwarz-Weiß-Bild ergeben.

https://de.wikipedia.org/wiki/CCD-Sensor

Zitat zu Infrarot- und UV-Sperrfilter:

"Ohne diesen Filter werden tiefblaue und tiefrote Flächen für den menschlichen Betrachter zu hell dargestellt. Heiße, aber nicht glühende Gegenstände (Lötkolben) werden ebenfalls zu hell und in unnatürlichen Farben dargestellt. Gegenstände, die infrarotes oder ultraviolettes Licht reflektieren oder emittieren, werden mit falschen Farben dargestellt."

4. Nun kann man sehen warum es sowohl technisch als auch logisch und letztendlich didaktisch "völlig unfähig" ist den gemessenen Farb-Wert eines Farbsensors als Schwarz-Weiß-Wert zu bezeichnen, der ein Farbbild ergibt. Der RAW-Wert ist technisch ein Spektralbereichsintensitätswert einer gemessenen Grundfarbe (Farbwert bzw. Farbhelligkeitswert) bzw. logisch und didaktisch korrekt ein Farbwert bzw. Farbhelligkeitswert. Aber niemals ein Schwarz-Weiß-Wert.

Und darum die Warnung vor folgenden kapitalen Fehlern bei der RAW Betrachtung:

1. Denkfehler:

Frank Glencairn begründet seine RAW Schwarz-Weiß-Werte mehrfach mit einem Graustufenbild (hat er auch hier zweimal gepostet), dass er aus dem RAW-Bild darstellen kann und das ja offensichtlich wie das originale Schwarz-Weiß-Bild aussehen würde. Das ist aber nicht so, denn die Darstellung ist eine Falsch-Graustufen-Darstellung einzelner R oder G oder B-Farbwerte bzw. Farbhelligkeitswerte. (Siehe mein Gedankenexperiment auf der Vorseite). Wer eine quadratische Fehleranalyse vom RAW-Falsch-Graustufenbild und dem letztendlich debayerten Farbbild wieder als Graustufenbild macht, den "trifft der Schlag".

2. Völlig falsche naturwissenschaftlich/technische Vorgehensweise:

Frank Glencairn müsste eine logische Überprüfung seines Ergebnisses vornehmen, da man schnell auf eine optische Täuschung bei so einer Graustufendarstellung reinfallen kann. Hat er nicht gemacht, das Gedankenexperiment hätte zur Kontrolle genügt.

3. Fehlende mathematische Grundkenntnisse:

Frank Glencairn hätte mit den nötigen mathematischen Grundkenntnissen sofort erkennen müssen, dass dies kein echtes Schwarz-Weiß-Bild sein kann, denn dann könnte er niemals mehr ein Farbbild erhalten. (Siehe meine mathematische Begründung auf der Vorseite, dass es niemals ein echtes Schwarz-Weiß-Bild sein kann)

4. Fehlende didaktische Eignung:

Wenn Frank Glencairn etwas erklären will, dann sollte er eine didaktisch vernünftige Darstellung wählen. Die Bezeichnung Schwarz-Weiß-Wert für einen gemessenen Farbwert ist didaktisch völlig unmöglich, dazu auch noch in diesem Fall komplett falsch.

Warum der Typ gegenüber r.p.television und dann auch noch gegenüber mir so patzig wird, das kann wohl nur ein Psychologe verstehen ...

https://de.wikipedia.org/wiki/Rohdatenf ... ografie%29

Und diese Zitat bitte nicht als falschen Beleg zu Schwarz-Weiß-Werten sehen, sondern da geht es um Helligkeitswerte zu den Farben im Farbkanal, also Farbwerte bzw. Farbhelligkeitswerte im RAW.

"pro Farbkanal nur 256 Helligkeitsabstufungen (8 Bit), demgegenüber enthalten Rohdatenformate meist 10, 12 oder 14 Bit an Helligkeitsinformation, was 1.024 bis 16.384 Helligkeitsabstufungen ermöglicht. Aufgrund der Charakteristik des üblicherweise eingesetzten Bayer-Sensors, bei dem vor jedem Bildpunkt ein Filter für eine der drei Grundfarben liegt"

http://lclevy.free.fr/cr2/

Hier steht es direkt richtig als Farbwert, leider nur in Englisch:

"RAW" here means that this file stores information directly coming from the sensor, almost without processing. RAW files can be seen as a digital negative format, and do not contains a "ready to view" picture, like jpeg. RAW file is the best quality/size ratio storage a photograph can use to store his picture, mainly because each primary color (R, G or B) is recorded in 12 or 14bits (8bits for Jpeg), and a lossless compression is used (lossy for Jpeg).

Wer jetzt immer noch stur glaubt das seien bei seiner Farbkamera doch Schwarz-Weiß RAW-Werte, der sollte mal über folgendes nachdenken:

Es gibt seit vermutlich mehr als 25 Jahren 3-Chip Videokameras. Ich habe noch nie in einem Prospekt gelesen bzw. in einer Schemazeichnung gesehen, dass von jedem der 3 Chips ein Schwarz-Weiß-Signalwert gemessen wird und auf magische Weise später zu einem Farbwert wird - es werden immer R, G und B Kanäle mit Farbwerten dargestellt. Und das sind seit mehr 25 Jahre Sensoren mit einem vorgeschalteten Farbfilter, allerdings ist das technisch ein Strahlteiler bzw. Prisma, aber ein technisch/naturwissenschaftlich gleicher Filtertyp.

Und auch in Schaubildern zu Fotoapparaten oder Single-Chip Kameras habe ich bisher nur R/G/B Farbkanäle bzw. Farbwerte in der Darstellung oder dem Text gesehen ...

Antwort von Frank Glencairn:

1. Ein üblicher Kamerasensor misst keine reinen Schwarz-Weiß-Werte

(Die falsche Behauptung hier im Forum war: Alle Sensoren messen ja sowieso nur Schwarz-Weiß-Werte)

Dazu schauen wir mal hier:

http://de.wikipedia.org/wiki/Wei%C3%9F

Zitate:

"Weiß ist keine Spektralfarbe, sondern entsteht durch ein Gemisch aus Einzelfarben, das den gleichen Farbeindruck hervorruft wie Sonnenlicht."

....

Nette Fleißarbeit, leider völlig umsonst, weil du immer noch nicht begriffen hast, daß Kamera-Sensoren ähnlich wie Solarzellen arbeiten, die bei auftreffendem Licht eine gewisse Spannung abgeben. Mehr Licht mehr Strom, weniger Licht weniger Strom - einfach so - sonst nix.

Aus dieser Spannung wird dann - vereinfacht gesagt - ein Helligkeitswert berechnet (z.B. 60%). War vor dem Bucket ein blauer Filter, wird das entsprechende Pixel im später Rechner 60% Blau eingefärbt.

Wir sehen, selbst eine RED EPIC MONOCHROME (Schwarz-Weiß-Kamera) misst fast keine echten Schwarz-Weiß-Werte. .

Die Monochrome hat einfach keine Farbfilter vor dem Sensor und das Raw wird deshalb auch nicht debayert oder interpoliert

Ein Sensor misst grob gesagt immer die Spektralbereichsintensität bzw. Strahlungsintensität eines Spektralbereiches/Frequenzbereiches. Das diese Werte in über 99,9% keine Schwarz-Weiß-Werte sein können dürfte klar werden wenn man sich vor Augen führt, dass der technische Begriff für Schwarz/Grau/Weiß-Werte eine gleichmäßigen Farbanteil aller Farbbestandteile (z.B. R/G/B-Anteile) voraussetzt. Dies ist im aufgenommenen Originalbild so gut wie niemals der Fall!.

RGB wird eine raw Datei erst im Rechner, nicht in der Kamera, und schon gar nicht im Sensor.

Aber warum bekommen wir ein Schwarz-Weiß-Bild mit einer Schwarz-Weiß-Kamera, wenn doch fast keine Schwarz-Weiß-Werte gemessen werden?

Ganz einfach, es ist eine Falsch-Grauwert-Darstellung.

.

Interessant, da weißt du anscheinend mehr als Jarred Land.

The increase in sharpness comes from removing the color filters, so you are using every single pixel for image instead of using a group of pixels to interpolate image data.

...und da geht dein ganzes mühsam zusammengebasteltes Theoriegebäude aus dem Fenster - sorry.

Frank Glencairn begründet seine RAW Schwarz-Weiß-Werte mehrfach mit einem Graustufenbild (hat er auch hier zweimal gepostet), dass er aus dem RAW-Bild darstellen kann und das ja offensichtlich wie das originale Schwarz-Weiß-Bild aussehen würde. .

Ich hab überhaupt nix dargestellt und behauptet.

Das s/w Bild das Ich gepostet hatte, stammt aus dem Wiki-Artikel den DU zum "Beweis" verlinkt hattest, und stellt eine raw Datei vor dem Debayering/Interpolation im Rechner dar, und nicht ein Graustufenbild.

Hättest du dir mal die Mühe gemacht, Artikel die du verlinkst auch zu lesen, wäre dir dieser Unterschied aufgefallen.

Nochmal zum mitschreiben:

Natürlich wird die Kombination der Informationen von Farbfilterposition und Spannung am jeweiligen Bucket, später im Rechner dazu genutzt die entsprechende Farbe und Helligkeit der Bildpixel zu schätzen, was aber nichts daran ändert, daß dies eben erst im Computer passiert, und in der raw Datei nur Graustufen (oder Helligkeitwerte wenn du willst) - zusamen mit der Farbfilter-Tabelle vorhanden sind. Da die Tabelle natürlich immer die selbe ist, ist sie aber auch nicht Bestandteil des eigentlichen Bildes.

2. Völlig falsche naturwissenschaftlich/technische Vorgehensweise:

Frank Glencairn müsste ...

3. Fehlende mathematische Grundkenntnisse:

Frank Glencairn hätte ..

4. Fehlende didaktische Eignung:

Wenn Frank Glencairn etwas erklären will, dann sollte er...

Warum der Typ ....

das kann wohl nur ein Psychologe verstehen ...

.

sowas kommentiere ich nicht.

Antwort von ennui:

Fazit: Frank Glencairn macht alles falsch. Seine Erklärung haut aber schon hin. Vielleicht sollte man sich hier an dem Wort "grau" nicht so aufhängen. Die Sensorzelle kennt nur "Helligkeit" in verschiedener Intensität (und das noch stufenlos analog, wenn ich Wowu richtig verstanden habe), und vielleicht noch "garnix" und "zuviel Helligkeit/Overload". Helligkeit im Sinne von "Wieviele Photonen (Licht) kommen gerade an". Farbe entsteht erst durch verschiedene Farbfilter vor den Sensorzellen und den Rechenhokuspokus hinterher.

Antwort von srone:

Die Sensorzelle kennt nur "Helligkeit" in verschiedener Intensität (und das noch stufenlos analog, wenn ich Wowu richtig verstanden habe)

ganz stufenlos ist das nicht, aber immerhin sind die photonen-stufen hinreichend klein. ;-)

lg

srone

Antwort von Angry_C:

Fazit: Frank Glencairn macht alles falsch.

Nein, definitiv nicht. Man kann ihm höchstens den Fehler ankreiden, überhaupt noch auf dieses Thema einzugehen. Vergebene Liebesmüh" :-)

Antwort von klusterdegenerierung:

Sehe ich auch so! Habe noch nie so ein großes Fettnäpfchen gesehen, da passe ja selbst ich nicht hinein ;-))))

Antwort von klusterdegenerierung:

Fazit: Frank Glencairn macht alles falsch. Seine Erklärung haut aber schon hin. Vielleicht sollte man sich hier an dem Wort "grau" nicht so aufhängen. Die Sensorzelle kennt nur "Helligkeit" in verschiedener Intensität (und das noch stufenlos analog, wenn ich Wowu richtig verstanden habe), und vielleicht noch "garnix" und "zuviel Helligkeit/Overload". Helligkeit im Sinne von "Wieviele Photonen (Licht) kommen gerade an". Farbe entsteht erst durch verschiedene Farbfilter vor den Sensorzellen und den Rechenhokuspokus hinterher.

Ja aber es scheitert doch schon daran, das er immernoch sagt, das der Sensor SW Werte aufzeine und durch wundersame Weise daraus Farbe gezaubert wird.

Schreibt aber jetzt gleichzeitig mit anderen Worten Zitate auf die den gleichen Inhalt haben wie das was Frank die ganze Zeit sagt, nur mit anderen Worten.

Also es kommt nämlich nicht der Begriff SW darin vor.

Was Mediavideo allerdings geritten hat das er dies postet ohne zu verstehen das es das gleiche ist, ist für mich unbegreiflich.

"Weiß ist keine Spektralfarbe, sondern entsteht durch ein Gemisch aus Einzelfarben, das den gleichen Farbeindruck hervorruft wie Sonnenlicht."

...

"Der Farbreiz für das Wahrnehmen von Weiß besteht also darin, dass alle drei Farbvalenzen gleich sind."

...

"... ,wegen der notwendigen Gleichheit der Farbvalenzen bezeichnet man diese Farbe auch als „unbunt“."

@Mediavideo

Was ist denn unbuntes licht?

Genau genau, keine Farbe! Und wie könnte man dann "unbunt" mit ein bisschen goodwill auch bezeichnen, genau SW!

Antwort von ennui:

Ich frag mich ja gerade eher, was eigentlich mit den ganzen weggefilterten Photonen am Farbfilter passiert. Prallen die da irgendwie ab und fliegen dann woanders hin? Oder bleiben sie im Filter stecken, werden die abgebremst? Vermutlich das. Haben Photonen eine Farbe? Nein, aber Licht (Photonen) hat natürlich zugleich auch Wellenlängen und damit Farbe, das ist der Welle-Teilchen-Dualismus. Ohne Farbfilter reagiert die Sensorzelle vermutlich einfach auf alle Wellenlängen im sichtbaren (und auch unsichtbaren) Spektrum. Aber nur im Sinne von "wieviele kommen an", nicht "welche Farbe haben denn die". Bei 100% Helligkeit/weiß sendet die eine dann "100% rot", die andere 100% blau, grün, je nach Filter. Bei 100% reinem grünem Licht (LED...) sieht nur die eine mit grünem Filter was, die anderen zwei gar nix.

Ich glaube, das Konzept von Farbe, das wir so haben, hat auch mehr mit menschlicher Wahrnehmung zu tun als nur mit reiner Physik, denn diverse Tiere sehen ja zb. ganz anders. Was "stimmt" dann? Unseres natürlich.

In punkto Helligkeit sehen aber wohl alle Lebewesen und auch Maschinen ziemlich ähnlich, manche etwas empfindlicher, manche weniger.

Antwort von mediavideo:

Um es nochmal für alle und speziell für die "Schwarz-Weiß-Werte-Fanatiker" auf den Punkt zu bringen, folgende kurze Darstellung:

In diesen Beschreibungen befindet sich ein Fehler:

1. Eine Farb-Kamera misst mit vielen Farbsensoren die Farb-Werte eines Grundfarbenbereiches jedes Bildpunktes/Pixels und gibt sie als Farb-Bild aus

2. Eine Schwarz-Weiß-Kamera misst mit vielen Schwarz-Weiß-Sensoren die Schwarz-Weiß-Werte jedes Bildpunktes/Pixels und gibt sie als Schwarz-Weiß-Bild aus

Frank Glencairn würde jetzt überzeugt schreiben (da laut seiner Meinung die Sensoren ja keine Farben sondern nur Schwarz-Weiß-Werte messen können):

1. Eine Farb-Kamera misst mit vielen Schwarz-Weiß-Sensoren die Schwarz-Weiß-Werte jedes Bildpunktes/Pixels und gibt sie als Farb-Bild aus

2. Eine Schwarz-Weiß-Kamera misst mit vielen Schwarz-Weiß-Sensoren die Schwarz-Weiß-Werte jedes Bildpunktes/Pixels und gibt sie als Schwarz-Weiß-Bild aus

Da kann ich nur sagen: Jetzt sind es schon mehrere Fehler!

Korrekt kann man es so ausdrücken: