Frage von Rodder:Hallo Zusammen,

ich filme mit einer Panasonic GH5, welche ja auch intern mit 10Bit Farbtiefe aufnehmen kann. Bisher habe ich dieses Feature der GH5 nicht nutzen können/wollen, da weder der Windows Media Player die Dateien abspielen kann, noch meine Schnittsoftware Vegas 14 und DaVinci Resolve 14 (Free Version) mit dem Codec im 10Bit format etwas anfangen können. Soweit ist das auch schon ein bekanntes Problem des 10Bit Codecs der GH5...und es gäbe verschiedene Möglichkeiten diesen verarbeiten zu können --> Vegas 15 kaufen, Vollversion DaVinci Resolve Kaufen oder einen Transcoder nutzen, welcher wahrscheinlich auch Geld kostet.

Aber ich habe mir jetzt nochmal grundsätzlich die Frage gestellt, wie dieser ganze 10Bit Postproduction workflow funktionieren soll und ob dieser momentan überhaupt Sinn macht?

Nehmen wir mal an ich nehme im LOG Profil (Panasonic V-Log) mit 10Bit Farbtiefe auf, Color Grade das ganze in DaVinci Resolve und kann dort die Farben bis an die Grenzen bringen ohne in den Banding Bereich zu kommen (das wäre ja ein Vorteil von 10Bit Farbtiefe).

1. Muss ich nun den Clip in 10Bit heraus rendern um diesen Mehrwert zu behalten oder sieht man den positiven Unterschied dann auch beim rendern in 8Bit?

2. Selbst wenn ich den Clip in 10Bit heraus rendere, Youtube convertiert mir den Clip doch ehe wieder auf 8Bit zurück (falls diese Info falsch ist berichtigt mich gerne)? Sehe ich denn dann wirklich einen Unterschied zwischen intern aufgenommenen 8Bit oder 10Bit bei Youtube (bei V-Log + Grading)?

3. Die Endgeräte auf denen wir alle unsere Videos anschauen sind ja in der Regel 8Bit Monitore. Macht denn ein 10Bit aufgenommenes Video + Color Grading + Herausgabe in 10Bit (oder 8Bit siehe Frage 1 :)) überhaupt sinn?

Das sind eine ganze Menge Fragen, welche mich um die Nächte bringen ;).

Danke schonmal im Voraus für eure Antworten!!

Antwort von Starshine Pictures:

Popcorn!!!

Antwort von wolfgang:

Nee, ein Glas Rotwein bitte! ;)

Antwort von WoWu:

Es ist doch ganz einfach...

Wenn Du hinterher 8Bit Content brauchst, lass einfach die Finger von V-Log und belichte anständig.

Antwort von Axel:

Okay, okay, okay, ich linke einen Clip von Nick Driftwood, Schande! Aber er ist nicht der einzige, der das HLG-Profil der GH5 V-Log und auch CinelikeD vorzieht. Nicht nur für HDR, was für viele ja noch ein bisschen neu und schwer einzuschätzen ist. Sondern auch, um natürlichere Graduierung für rec_709 zu haben:

https://www.youtube.com/watch?time_continue=97&v=weKS8dJXx4M

Sinnvoll ist es allerdings nur in 10-bit, da in 8-bit die von Log bekannten Banding-Probleme in noch größerem Maße auftreten. Da womöglich ein verbesserter Sensor zum Greifen nah ist, lohnt es sich nicht, dies sehr zu vertiefen. Wenn die GH5 meine Kamera wäre, würde

ich mich allerdings nicht wegen der Zickigkeiten von Bearbeitungssoftware auf 8-bit beschränken.

Antwort von WoWu:

Dazu braucht man aber auch den Fernseher, der einem die HighLights wieder aufmöbelt, ansonsten sieht das alles nach trübem Wetter aus.

Wer die Melancholie mag ...

Antwort von Axel:

Ich bin weder ein Fan von Driftwood noch schätze ich ihn als einen begnadeten Koloristen ein. Der Clip zeigt aber ziemlich schlüssig, dass, wenn es einem um Dynamik geht, man die Standardprofile schön vergessen muss. Andere Testshots zeigen, dass zweitens V-Log wohl zumindest für die GH5 nicht ganz das Richtige ist. HLG schon. Dort sind Farben und Farb

reichtum ohne weiteres mit Ursa Mini gleichauf. Allerdings in 10-bit.

Antwort von WoWu:

Ich finde nur diesen Weisspunkt bei 50% ziemlich gewöhnungsbedürftig.

Man nimmt ihn eben als grau wahr.

Auch die Hauttöne sehen immer so aus, als hätten die Menschen schweren Eisenmangel.

Antwort von Bruno Peter:

Eigenartig, das obige Video kommt nach dem Download in "Originalqualität - 172 MB" per 4K-Downloader

nur im Farbraum BT.709 an und nicht als HDR(HLG)...

Bei dem dort angegebenen Link zum Video auf der Pansonic-Seite ist es auch so, zumindest zeigt es

MediaInfo hier so an.

Antwort von Axel:

"Bruno Peter" hat geschrieben:

Eigenartig, das obige Video kommt nach dem Download in "Originalqualität - 172 MB" per 4K-Downloader

nur im Farbraum BT.709 an und nicht als HDR(HLG)...

Bei dem dort angegebenen Link zum Video auf der Pansonic-Seite ist es auch so, zumindest zeigt es

MediaInfo hier so an.

Du sprichst von "Isobel":

https://www.youtube.com/watch?v=ju35M4gnDBE&feature=youtu.be

- zu dem es in der Beschreibung heißt:

*This content is recorded with LUMIX GH5 in HLG (Hybrid Log Gamma) mode. Enjoy the stunning video quality on HLG-compatible TV or display.

Achtung! Halbwissen-Verbreitung mit der Bitte um Korrektur:

Bei HLG handelt es sich von der Gradation her (die Farben sind wieder eine andere Geschichte) um "709 +". Das bedeutet, dass Weiß (ein weißes Blatt Papier) identisch ist und das Bild nur in HLG noch durch Abstufungen von Superweiß erweitert wird, falls so aufgenommen, d.h. mit Sonne oder anderen starken Lichtquellen im Bild, allem, was für gewöhnlich clippen würde. Weil es in der Natur weitaus größere Helligkeit gibt als Mattweiß oder die höchste Helligkeit eines standard SDR TVs/Monitors - 100 nits. Die Clips ähneln sehr stark LOG, sehen aber im 709-Farbraum nicht ganz so flat aus.

Im Gegensatz zu HDR10 oder DolbyVision, die je eine eigene Version benötigen, würde HLG lediglich einen, äh, LUT für die korrekte Wiedergabe auf SDR-Geräten brauchen.

So, wie ich es verstanden habe, signalisieren gewöhnliche Computer Youtube nicht, dass ein HLG-fähiges Display angeschlossen ist, wodurch beim Download dieser LUT eingebacken würde. Zur Wiedergabe bräuchtest du einen Smart-TV mit HLG-Unterstützung und müsstest dieses auch im Menu aktivieren. Vielleicht (k.A.) brauchst du sogar so einen Chromecast-Stick.

Das alles macht HDR (und nicht nur HLG) für Youtube z.Zt. zur Nische innerhalb der Nische, denn wie viele Leute surfen auf ihrem TV?

Ich halte es für wahrscheinlich, dass in den nächsten Monaten hier etwas passiert.

Antwort von Uwe:

Axel hat geschrieben:

"Bruno Peter" hat geschrieben:

Eigenartig, das obige Video kommt nach dem Download in "Originalqualität - 172 MB" per 4K-Downloader

nur im Farbraum BT.709 an und nicht als HDR(HLG)...

Bei dem dort angegebenen Link zum Video auf der Pansonic-Seite ist es auch so, zumindest zeigt es

MediaInfo hier so an.

Du sprichst von "Isobel":

- zu dem es in der Beschreibung heißt:

*This content is recorded with LUMIX GH5 in HLG (Hybrid Log Gamma) mode. Enjoy the stunning video quality on HLG-compatible TV or display.

Achtung! Halbwissen-Verbreitung mit der Bitte um Korrektur:

................

Hab es mal auf die Schnelle mit einem eigenen HLG-Test ausprobiert - auch nach dem Download wird BT2020 angezeigt...

https://vimeo.com/243529154

Antwort von domain:

Axel hat geschrieben:

Das alles macht HDR (und nicht nur HLG) für Youtube z.Zt. zur Nische innerhalb der Nische, denn wie viele Leute surfen auf ihrem TV?

Ich halte es für wahrscheinlich, dass in den nächsten Monaten hier etwas passiert.

Was soll denn deiner Meinung nach passieren? Soll YT vor dem Abspielen mitgeteilt werden ob eine HDMI 1.4b, eine HDMI 2.0a Schnittstelle oder ein Displayport 1.4 beim Abspielgerät vorhanden ist und wenn nein, eine korrigierende LUT schon beim Transfer anzuwenden ist oder was?

Antwort von Axel:

@ Uwe:

Da ist kein Download-Button.

Interssant: Auf Safari stotterte das Video ganz schön an unterschiedlichen Stellen, was mich vermuten lässt, dass es HEVC im Original ist, stimmt das? Hab noch kein High Sierra. Aber die Bilder sehen sehr HDR-mäßig aus, kräftige Farben und sehr stark leuchtend (Display mit 500 nits ist keine Referenz, aber "HDR ready", erlaube erweiterte Dynamik ist in Monitor-Einstellungen aktiviert).

EDIT: da war noch irgendwas, dass Safari keine Youtube UHD-4k Videos abspielt. Und tatsächlich: die höchste Auflösung für "Isobel" wird mir mit "HD 1440p" angezeigt - Chaos!

Firefox: Ruckelfrei, dieselben schönen Farben. Video-Downloader-Hinweis: Video wird beim Download zu H.264 konvertiert. Nein Danke!

ClipGrab mit Safari (Qualität: Original "HDR"): Ein H.264 File, das stark nach LOG aussieht, total flau und matschig.

domain hat geschrieben:

Axel hat geschrieben:

Das alles macht HDR (und nicht nur HLG) für Youtube z.Zt. zur Nische innerhalb der Nische, denn wie viele Leute surfen auf ihrem TV?

Ich halte es für wahrscheinlich, dass in den nächsten Monaten hier etwas passiert.

Was soll denn deiner Meinung nach passieren? Soll YT vor dem Abspielen mitgeteilt werden ob eine HDMI 1.4b, eine HDMI 2.0a Schnittstelle oder ein Displayport 1.4 beim Abspielgerät vorhanden ist und wenn nein, eine korrigierende LUT schon beim Transfer anzuwenden ist oder was?

Der Markt wird entscheiden, dass das etwas weniger anspruchsvolle HLG gegenüber HDR10 der Standard wird. Standardisierung erlaubt Vereinfachung. Bisher ist, wie Uwes Test bei mir zeigt, die Veröffentlichung von HDR von diversen Faktoren abhängig, die man schlecht kontrollieren kann. Von den Unwägbarkeiten bei der Distribution abgesehen ist der Workflow recht speziell (bei 1'46" einsteigen):

https://www.youtube.com/watch?v=o5E1kVxRdDs

Bewusst provokativ formuliert: erst, wenn es in iMovie einen Button "HDR" gibt, und das war's, ist der Standard gültig. Das wird nicht allzu lange brauchen.

Antwort von Bruno Peter:

Hallo Axel

Na ja, ist kann es nicht in HDR(HLG) sehen, noch nicht zumindest.

Ich lade aber ja nur die Datei in der sog. "Originalfassung" von YT runter und schaue nur mit MediaInfo

in die Datei nach den Eigenschaften rein und da steht eben nichts von dem erweiterten Farbraum.

Es gibt andere Downloads in YT, da bekommt man tatsächlich eine HLG-Datei nach dem Download, von

MediaInfo wird es so erkannt, auch EDIUS mit dem HLG-Workflow erkennt das. Spiele ich diese Datei

auf dem PC ab, sehe ich natürlich nur den Farbraum BT.709, mehr kann ja mein Monitor nicht, auch logisch.

Ich habe mal ein Testvideo mit EDIUS 9 als HLG-Video erstellt aus DSR-Videoclips meiner Kamera,

YouTube hat sich bedankt für den Upload mit der Bestätigung, dass ich tatsächlich eine HLG-File hochgeladen

habe. Gut, habe anschliessend das File wieder mit dem 4K-Downloader als "Originaldatei" runtergeladen, mit

MediaInfo nachgeguckt und tatsächtlich hatte ich wieder ein HLG-Video vorliegen, jedoch mit einer geringeren

Bitrate als mein Upload, auch klar YT hat es es ja für seinen Server "verwurstet". Eine Woche lang konnten

sich Bekannte von mir das File runterladen und auf dem Smartphohe Samsung S8 direkt und einem HDR(HLG)

per Stick ansehen. Nach einer Woche ungefähr gab es das File bei YT überraschend für mich nur noch im

Farbraum BT.709 zum Download, nicht mehr mit HLG... Ich verstehe das alles nicht so Recht.

Hier: https://www.eoshd.com/2017/08/panasonic ... -firmware/

kann man sich Original HLG-Footage der GH5 runterladen und experimentieren.

Ich werde daraus nochmal ein HLG-Testvideo mit EDIUS 9 erstellen und den Upload/download verfolgen was da

passiert. Habe auch noch Original HLG-Footage der Sony FZ700 hier liegen, diese packe ich auch da rein.

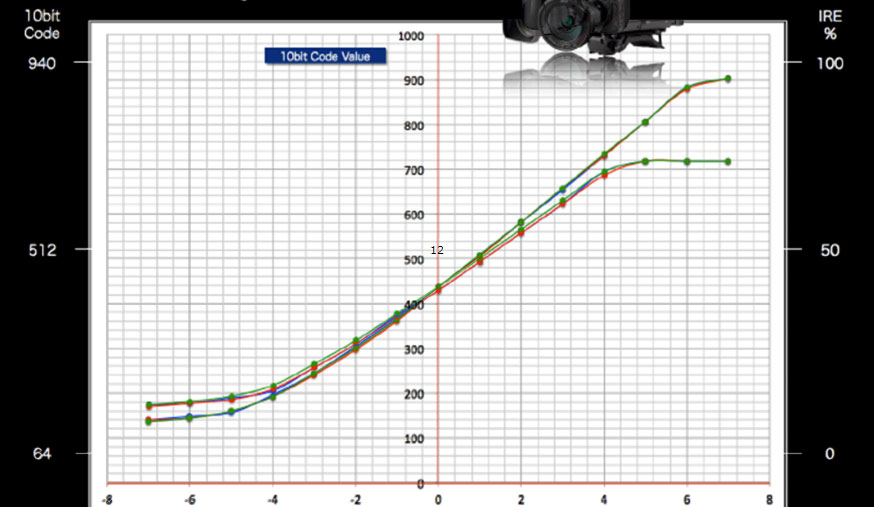

Wenn man sich vom hier das vorgestellte Driftwood-Video die Kamera Settings der GH5 ansieht, dann sehen diese

bezüglich der Bildprofilparameter so aus:

zum Bild

Im obigen Link meines Postings stehen die Bildprofilsetting alle auf "0"...

Die Settings für die Verarbeitung in DaVinci Resolve sind so eingestellt:

zum Bild

OK, das geht mit EDIUS 9 viel einfacher!

Es ist richtig Axel, auch ich habe den Eindruck, es wird einem nur "Halbwissen" präsentiert/vermittelt.

Eigentlich nicht im Interesse der Industrie, warum liefert die Industrie dann nicht Unterlagen/Workflows wie

das mit dem HDR(HLG) von der Kamera über den Videoschnitt bis zum HDR(HLG)-TV und natürlich

auch zum SDR-TV korrekt gehandelt werde soll, denn HLG soll ja auch auf dem vorhandenen SDR-TV abgespielt

werden können.

Da HLG-Videos sowohl auf dem HDR(HLG)-TV als auch auf dem SDR-TV lauffähig sein sollen, dann ist es doch eigentlich

"wurscht" ob es auf einem SDR oder HDR- Schnittsystem gegradet wird. Wenn ich also mit dem EDIUS 9-HLG-Workflow

auf meinem SDR-Schnittsystem grade, muß es automatisch auch auf einem HDR(HLG) gut aussehen, vielleicht nach

einer leichten Korrektur der Helligkeitswiedergabe denke ich.

Bin schon gespannt auf Meinungen/Korrekturen/Anmerkungen hier zu diesem umfassenden Thema!

Antwort von WoWu:

@Axel

Was soll der Button denn bewirken?

Es bleibt dabei, dass Du Weiß 50% unter Systemweiss anlegst, das Bild also ziemlich grau gestaltest und die restlichen 50% für die Auflösung der Spitzlichter verwendest.

Was also soll der Button bewirken ?

Hebt er den Kontrast von 50% wieder auf Systemweiss an, hast Du wieder den Clip.

Der Trick bei HDR-TV ist ja, dass Du bei 50% Weiß die Abstrahlleistung von 100Nits hast und die restliche Lichtmenge dann für die helleren Werte genutzt wird.

HDR taugt eigentlich nur für entsprechende Monitore.

Die Kompartibilität von HDR10 bezieht sich nur auf den Bereich von 0-50%, weil die Kurve da exakt 709 entspricht und das Bild im unteren Bereich nicht grau wird, wie bei LOG Entzerrungen.

Antwort von Bruno Peter:

Uwe hat geschrieben:

Hab es mal auf die Schnelle mit einem eigenen HLG-Test ausprobiert - auch nach dem Download wird BT2020 angezeigt...

https://vimeo.com/243529154

Das ist ein BT.2020

transfer_characteristics : PQ

-Video, kein HLG-Video laut MediaInfo...

Damit fängt auch hier die Verwirrung an, wir diskutierten gerade über HLG-Videos!

Antwort von Axel:

@Bruno

Ich sehe da Parallelen zum Standard "HD", der bei seinem Aufkommen auch noch viel Hersteller-spezifisches Gewurstel mit sich brachte und im Grunde noch nicht restlos geklärt ist - nach über zehn Jahren! Kürzlich sah ich die "heute show", und Oliver Welke sagte, Leute, eine Neuigkeit, ab heute sind wir in HD! Wir slashCAM-Videoten dagegen hätten als Kinder 720p schon nicht mehr als HD bezeichnet, sehr überspitzt gesagt. HD war "weg von SD", von 4:3, zu guter Letzt von Interlace, insofern ist 720p HD. Ähnlich wird es mit HDR sein. Dass Sony und Canon HLG in 8-bit erlauben gehört hier hinein.

@WoWu

Die Kameras (Smartphones werden dazurechnen oder fangen bereits an, es zu tun, ich bin da nicht auf dem Laufenden) werden HLG unterstützen, aber auf Consumerseite wohl eher so, dass man nichts mehr "graden" muss. Der Button wäre dafür da, ich habe einen HDR-TV, will also "meinen Film" "teilen" für mich. Oder, ich will den Film jemandem geben, der es nicht in HDR sehen kann. Oder so. Wie gesagt, war nur als Provokation gemeint. Wahrscheinlich braucht man auch gar keinen Knopf, weil der gescheite Fernseher erkennt, aha, HLG.

Antwort von WoWu:

Ja, aber was macht der „gescheite Fernseher“ dann ?

Zieht er 50% wieder auf 100% und generiert denselben (kompatiblen) Eindruck zu einem -nicht HDR- Signal, wenn er kein HDR kann ?

Dann wäre HDR aber nicht abwärts kompatibel, denn es gibt Millionen TV Geräte, die HDR als flaues Bild präsentieren.

Antwort von Bruno Peter:

WoWu hat geschrieben:

Dann wäre HDR aber nicht abwärts kompatibel, denn es gibt Millionen TV Geräte, die HDR als flaues Bild präsentieren.

Nein, diese TV-Geräte spielen das richtig ab, weil die TV-Sender HDR(HLG) senden werden - zwei Formate in einem Video-Stream, - oder schon vereinzelt senden. HDR(HLG) ist abwärtskompatibel, die andere drei Sorten von HDR eben nicht, deshalb wird sich HDR(HLG) auch durchsetzen!

Antwort von Alf_300:

Nach Weihnachten , wenn alle Fernseher verkauft sind,

gibts wieder tolle Filme aus den 70ern HD Remastered auf Blu Ray

;-(

Antwort von WoWu:

@Bruno

Es sind keine 2 Formate in einem Videostream.

Der Transportstream -bzw. PS- besteht nur aus einem einzigen Signal.

Der Stream besteht nur aus einem Signal, das (wenn HLG aufgenommen), einen versetzten Weisspunkt hat.

Kein bisheriges TV Gerät remapped die Übertragungsfunktion.

Die TV Geräte stellen sie so da, wie sie ankommt.

Antwort von Bruno Peter:

WoWu hat geschrieben:

@Bruno

Es sind keine 2 Formate in einem Videostream.

Der Transportstream -bzw. PS- besteht nur aus einem einzigen Signal.

Der Stream besteht nur aus einem Signal, das (wenn HLG aufgenommen), einen versetzten Weisspunkt hat.

Kein bisheriges TV Gerät remapped die Übertragungsfunktion.

Die TV Geräte stellen sie so da, wie sie ankommt.

Ich habe es mißverständlich ausgedrückt, es ist ein Videofile, richtig.

Ich schrieb ja, es ist nur ein Videostream!

Anders ausgedrückt die Datei wird nur dann in HDR(HLG) abgespielt wenn einem HDR(HLG) TV die Erkennung angeboten wird, auf den anderen TVs wird es automatisch in SDR abgespielt.

Antwort von WoWu:

Ja, aber SDR heisst, dass der Weisspunkt bei 50% liegt, denn die Übertragungsfunktion bleibt die von HDR und ist nicht 709.

Antwort von Uwe:

Axel hat geschrieben:

@ Uwe:

Da ist kein Download-Button.

Interssant: Auf Safari stotterte das Video ganz schön an unterschiedlichen Stellen, was mich vermuten lässt, dass es HEVC im Original ist, stimmt das? ...

Nein, im Original ist es HLG/AVC/10bit/400mbps => in DR14 Export DNxHR HQX (Rec 2020 HLG ARIB STD B67) => Hybrid HEVC (hier liegt der Grund für PQ statt HLG) ... werde die Einstellungen dort nochmal prüfen. Danke Bruno für den Hinweis.

Für das Abspielen von HDR-Videos ist der mpv-Player sehr gut geeignet: https://mpv.io/

Antwort von Bruno Peter:

WoWu hat geschrieben:

Ja, aber SDR heisst, dass der Weisspunkt bei 50% liegt, denn die Übertragungsfunktion bleibt die von HDR und ist nicht 709.

Darüber habe ich auch schon nachgedacht, das Bild müsste dann stark angegraut aussehen und bin deshalb zu einem

vorläufigen Fazit für mich gekommen:" ich bleiben bei meinen Leisten" also Videos in SDR im voll zulässigen IRE-Bereich

von BT.709 ohne Luminanzverluste!

Vermutlich sieht das dann so aus wie bei der TV-Übertragung aus dem Vatikan:

zum Bild

vom 8. Dezember 2015.

Hinweis dazu:

Das Vatikanische Fernsehzentrum CTV hat damals Sony bei der 4K-Liveproduktion der Zeremonie des Öffnens der Heiligen Pforte durch Seine Heiligkeit Papst Franziskus im Petersdom in Rom unterstützt.

Link: https://www.sony.at/pro/article/broadca ... k-ultra-hd

und: https://www.sony.co.uk/pro/article/broa ... -holy-door

Antwort von Axel:

Mal ganz abgesehen von der Frage, wie die unterschiedliche Übertragungsfunktion dem (alten) SDR-Fernseher klargemacht werden würde, ist die mühelose Abwärtskombatibilität von HLG ja der ganze Witz, und die BBC wird schon wissen, wie.

Aber ich meinte was viel Einfacheres. Der Gelegenheits- Urlaubsfilmer hat also ein HDR-Kamerachen UND einen HDR TV. Er hat jetzt die Wahl, seine Clips im Original, ungeschnitten, abzuspielen oder mit Resolve zu schneiden (unwahrscheinlich). Er sollte in einem einfachen NLE in der Lage sein, HDR-kompatibel zu “erstellen”, und zwar sogar unabhängig davon, ob er es monitoren kann. Der Button würde zugleich eine normalisierte Vorschau zeigen. Aber dieses Problem mendelt sich eh langsam aus, da Displays tendenziell immer heller werden (siehe 700 nits beim iPhoneX).

Antwort von Bruno Peter:

Axel hat geschrieben:

Er sollte in einem einfachen NLE in der Lage sein, HDR-kompatibel zu “erstellen”, und zwar sogar unabhängig davon, ob er es monitoren kann.

Genau das geht eben mit EDIUS 9 schon - kompletter HLG-Workflow -, allerdings zählt EDIUS nicht zu den "einfachen(billigen)" NLEs.

Antwort von Uwe:

"Bruno Peter" hat geschrieben:

Axel hat geschrieben:

Er sollte in einem einfachen NLE in der Lage sein, HDR-kompatibel zu “erstellen”, und zwar sogar unabhängig davon, ob er es monitoren kann.

Genau das geht eben mit EDIUS 9 schon - kompletter HLG-Workflow -, allerdings zählt EDIUS nicht zu den "einfachen(billigen)" NLEs.

Ja das geht mit Edius, aber eben auch nur ohne korrekte Vorschau der Farbsättigung + Helligkeit wenn man keinen HDR-Monitor/HDR-TV (incl. Karte) für die Vorschau hat...

Antwort von WoWu:

@Axel

Da musst Du nun unterscheiden, zwischen (nur) heller werden und steuerung der Hintergrundbeleuchtung.

Wenn HDR nur „heller werden“ bedeutet, bräuchte man den ganzen Zauber nicht.

Und die BBC bezieht sich mit der Kompartibilität nur auf den Bereich, der den identischen Verlauf bis 100 Nits hat ... und das ist der lineare Teil der HLG Übertragungsfunktion für den es dem alten Fernseher nicht extra klar gemacht werden muss, nur muss man sich die Funktion eben mal anschauend und wird sehen, dass die 100 Nits ihren Wert bei 50% Weiß erreichen.

Die BBC hebt in der Kompatibilität im Grunde genommen darauf ab, dass es ein System ist, bei dem das TV Gerät keine Metadaten verstehen muss.

Insofern ist HDR prima, wenn man es auf HDR- Geräten anschaut, aber düster auf andern Geräten, weil den paar Weisswerten (Spitzlichtern) die restlichen 50% des gesamten Videosignals eingeräumt werden.

Was den Workflow betrifft .... worin siehst Du denn deny Unterschied bei HDR10 ?

Bei HDR10+ und allen Verfahren, in denen Metadaten anfallen, ist das klar, aber bei HLG ... wenn man mal von 2020 absieht?

Antwort von Bruno Peter:

Uwe hat geschrieben:

"Bruno Peter" hat geschrieben:

Genau das geht eben mit EDIUS 9 schon - kompletter HLG-Workflow -, allerdings zählt EDIUS nicht zu den "einfachen(billigen)" NLEs.

Ja das geht mit Edius, aber eben auch nur ohne korrekte Vorschau der Farbsättigung + Helligkeit wenn man keinen HDR-Monitor/HDR-TV (incl. Karte) für die Vorschau hat...

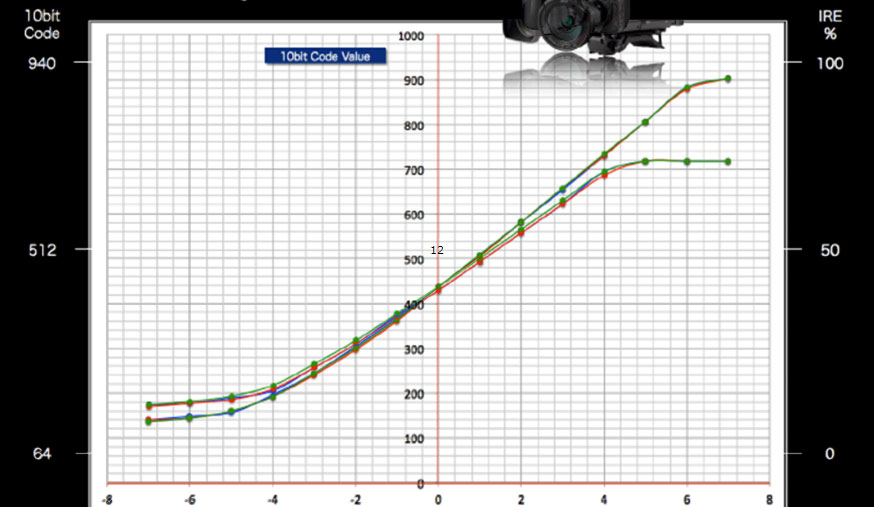

Ich kontrolliere das mit dem Wellenform-Monitor in EDIUS.

Hier mit einem HLG-File aus der FZ300:

zum Bild

Gegenüberstellung mit dem Wellenformmonitor in DaVinci Resolve 14.

Antwort von Uwe:

"Bruno Peter" hat geschrieben:

Uwe hat geschrieben:

Ja das geht mit Edius, aber eben auch nur ohne korrekte Vorschau der Farbsättigung + Helligkeit wenn man keinen HDR-Monitor/HDR-TV (incl. Karte) für die Vorschau hat...

Ich kontrolliere das mit dem Wellenform-Monitor in EDIUS...

Kannst Du alles machen... Edius bietet dann aber keinen Vorteil mehr ggü. anderen Programmen wie z.B. Premiere Pro. Da kannst Du genauso ein HLG-File reinschmeissen und auf den Waveform-Monitor schauen, was da abgeht. Und das Endergebnis vor allem bei den Farben ist dann immer eine "Wundertüte"...

Antwort von Roland Schulz:

Wenn man sich mal auf die Überschrift zurückbesinnt und diesen ganzen nicht zu Ende "definierten", mit Interpretationsspielraum behafteten "HDR Wildwuchsquatsch" beiseite lässt (der so wie aktuell gehandhabt schneller an Akzeptanz verlieren wird als nahezu jede andere "Idee" der letzten Jahre) , kann man die Frage ganz einfach und schnell mit "Ja" beantworten - 10bit bietet in nahezu jedem Fall Vorteile gegenüber 8bit - in REC709, Cinegamma sowie xLOG usw.!!

Sobald die Quelle Anpassungen in Kontrast und Farbe (Grading) erhält macht 10bit Sinn! Quantisierungsfehler vergrößern sich in jedem Aufnahme/Grading Workflow zwangsweise, 10bit bietet 4x mehr Abstufungen als 8bit, von daher wird eine wertdiskrete 10bit Berechnung immer näher am theoretischen, linearen Ergebnis liegen als eine wertdiskrete 8bit Berechnung.

Man kann sogar Unterschiede sehen wenn man 8bit Material in einem 10bit Workflow gradet und später in 10bit (auf dem TV/Monitor) wiedergibt (was derzeit in der Praxis jedoch recht selten anzutreffen sein wird).

Die ursprünglichen, groben Abstufungen der Signale finden nach einer Verrechnung/Anpassung im 10bit Raster ein genaueres Ergebnis als wieder in einem 8bit Raster. 10bit hilft nahezu in jedem Fall diesen Fehler vergleichsweise klein zu halten und das unabhängig ob nun REC709, xLOG oder HDR irgendwas zum Einsatz kommt.

Das soll nicht bedeuten dass 8bit minderwertig ist, das soll nur bedeuten dass 10bit technisch bedingt Vorteile liefern kann.

Antwort von Bruno Peter:

Uwe hat geschrieben:

Und das Endergebnis vor allem bei den Farben ist dann immer eine "Wundertüte"...

Also bis jetzt ist immer das dabei rausgekommen was ich wollte, bei der Betrachtung auf meinem HDTV.

Wie es auf einem HDR(HLG)-Sichtgerät aussieht, habe ich selbst noch nicht gesehen, man hat mir aber

bestätigt, dass es dort auch nicht schlecht aussieht.

Würde ich das HLG-Grading auf einen HDR(HLG) Equipment durchführen, müsste das File dann auf meinem

HDTV ebenfalls noch gut aussehen nach diesen Versprechungen zu HLG:

Das ist das Ergebnis eines gemeinsamen Forschungsprojekts zwischen der BBC in Großbritannien und dem japanischen nationalen Sender NHK,

es ist darauf ausgelegt eine praktischere HDR-Lösung für die Broadcast-Welt zu liefern als das HDR10-System, das von den meisten aktuellen HDR-Quellen und Displays verwendet wird.

Die bisher gezeigten HLG-Demo-Inhalte haben gezeigt, die eine niedrigere Auflösung als natives 4K Ultra HD verwendet werden kann - häufig reicht "Full HD" aus.

Alles zusammen führt sowohl auf der Senderseite als auch auf der Heimvideoseite zu akzeptablen Kosten.

Auch der Hobbyvideofilmer wird sich das leisten können!

Antwort von Roland Schulz:

HLG ist die "Rolle rückwärts" und ein Eingeständnis in die Versäumnis, HDR verbindlich und rechtzeitig zu definieren und zu kontrollieren bzw. die Aufgabe in die Annahme, "HDR" als übergreifenden Standard weltweit alleinstehend zu etablieren.

Antwort von WoWu:

Was der Werbetext da sagt, heißt aber eben nicht, dass es genau so aussieht.

Es ist eben die einfachste, billigste und weitestgehend kompatible Variate von (richtigem) HDR.

Antwort von Roland Schulz:

"Bruno Peter" hat geschrieben:

...Hier mit einem HLG-File aus der FZ300...

"Der Wildwuchs" herrscht auch bei denen die uns die Ordnung erklären wollen...

Antwort von Uwe:

"Bruno Peter" hat geschrieben:

Also bis jetzt ist immer das dabei rausgekommen was ich wollte, bei der Betrachtung auf meinem HDTV.

Wie es auf einem HDR(HLG)-Sichtgerät aussieht, habe ich selbst noch nicht gesehen, man hat mir aber

bestätigt, dass es dort auch nicht schlecht aussieht.....

Klar, bei einem guten Kameramann wird auch das Ergebnis nicht schlecht aussehen. Du wirst nur einige Informationen in den Lichtern verlieren (wenn ich mich richtig erinnere so um die 30%). Aber selbst da gibt es inzwischen einen Workaround mit LUT + Effekt in PP. Aber mal ehrlich Bruno, warum willst Du es dann nutzen? Du könntest dann genauso gut mit einem Cinelike D, Natürlich... oder sonstwas Modus filmen. HLG ist in erster Linie für HDR gemacht.....

Antwort von Bruno Peter:

Uwe hat geschrieben:

Aber mal ehrlich Bruno, warum willst Du es dann nutzen? Du könntest dann genauso gut mit einem Cinelike D, Natürlich... oder sonstwas Modus filmen. HLG ist in erster Linie für HDR gemacht.....

Hihi..., weil ich das Recht habe mir einen UHD(HLG) zuzulegen und dann auch noch eine HLG-Kamera, alles im nächsten Jahr.

EDIUS 9 mit dem HLG-Workflow habe ich schon und deshalb teste ich mal den Workflow zu HDR(HLG) vorab.

Antwort von Roland Schulz:

"Bruno Peter" hat geschrieben:

Uwe hat geschrieben:

Aber mal ehrlich Bruno, warum willst Du es dann nutzen? Du könntest dann genauso gut mit einem Cinelike D, Natürlich... oder sonstwas Modus filmen. HLG ist in erster Linie für HDR gemacht.....

Hihi..., weil ich das Recht habe mir einen UHD(HLG) zuzulegen und dann auch noch eine HLG-Kamera, alles im nächsten Jahr.

EDIUS 9 mit dem HLG-Workflow habe ich schon und deshalb teste ich mal den Workflow zu HDR(HLG) vorab.

...auf die HLG Kamera bin ich mal gespannt, dachte nach Deinem Posting weiter oben dass deine FZ300 das ja schon könnte. Zumindest bei Panasonic finde ich dazu nichts.

Panasonic ist im Vergleich zu Sony aber trotzdem nicht weniger rotzfrech und bewirbt aktuell auch die VXF999 als HDR Camcorder.

8bit -> damit weder HLG noch HDR! Aber anscheinend ist das auch hier einigen Leuten völlig egal.

Antwort von Bruno Peter:

Mit der GH5 kannst Du schon in HLG aufnehmen..

Herkömmliche UHD-SDR-Bildprofile, wie Cinelike D mit D-Gammakurve kann man z.B. in meiner FZ300 so tunen,

dass sie ungefähr den gleichen Dynamikumfang abbilden kann wie ein dezidiertes Log-Profil. Damit kann man vorab den Workflow

mit getunten UHD-SDR Videomaterial - entsättigt, zurückgeschraubte Bildprofilparameter, S-Gammakurve für eine größere Detailerfassung - testen.

Cinelike D nutzt beispielsweise viel mehr Quantisierungsstufen der internen 8 Bit-Aufzeichnung als die anderen Kamera-Bildprofile.

Der Sensor dieser Kamera hat eine Eingangsdynamik von etwa 10 EV im Bereich von ISO 100-800 lt. Messdiagramm im Kamerabuch von M+T, dann fällt das ab...

Ich grade diese Aufnahmen in EDIUS 9 mit der Primären Farbkorrektur und diversen LUTs, auch ein HLG-File kann man daraus mit dem EDIUS HDR-Workflow

machen, natürlich geht das auch. Ob das sinnvoll ist steht auf einem anderen Blatt. Für den Test habe ich hier auch echte HLG-Kameraaufnahmen

zu Verfügung.

Antwort von Roland Schulz:

"Bruno Peter" hat geschrieben:

Mit der GH5 kannst Du schon in HLG aufnehmen..

Denke ne GH5 ist ne ganz vernünftige Wahl, "formal" kann die Kamera HDR und die ~12 Blenden sind denke ich schon ganz ok. Das ist auf jeden Fall qualitativ hochwertiger und sauberer als bei der FZ300, wobei DxO hier zumindest im Fotomodus ~11 Blenden feststellt. So schlecht ist das Bild aus der FZ300 auch gar nicht - nur ist und wird es formal kein HDR.

Antwort von Bruno Peter:

"Roland Schulz" hat geschrieben:

So schlecht ist das Bild aus der FZ300 auch gar nicht - nur ist und wird es formal kein HDR.

Auf keinen Fall, welcher Zipfel sagt sowas?

Ich habe das nie behauptet.

Man kann mit dem EDIUS-Workflow allerdings ein HLG-File daraus machen!

Antwort von Roland Schulz:

"Bruno Peter" hat geschrieben:

"Roland Schulz" hat geschrieben:

So schlecht ist das Bild aus der FZ300 auch gar nicht - nur ist und wird es formal kein HDR.

Auf keinen Fall, welcher Zipfel sagt sowas?

Ich habe das nie behauptet.

Man kann mit dem EDIUS-Workflow allerdings ein HLG-File daraus machen!

Jein - wenn ich gegradete a6500 Clips in 10bit ausgebe habe ich nur schadenbereinigtes 8bit mit 10bit Wertedynamik.

HLG fordert 10bit. 8bit Material in nem 10bit Stream ist und bleibt maximal 8bit, wird damit weder HLG noch HDR.

Du hast trotzdem nen HLG File... gut, glaube Du verstehst was ich meine...

Antwort von Bruno Peter:

Du das stimmt nicht, ich habe von der Sony FDR-AX700 - HLG hier Original HLG-Kameraclips in 8bit!

Aus EDIUS 9 heraus kann man HLG exportieren in:

1. 8-bit - 4:2:0 oder 4:2:2 als UHD oder FHD

2. 10-Bit - 4:2:0 oder 4:2:2 als UHD oder FHD

Antwort von Roland Schulz:

Wir hatten dazu schon nen Thread - sämtliche Normen und Standards fordern zu HDR und HLG 10- oder 12bit.

Deshalb schrieb ich auch ich wolle das Sony Fass nicht wieder aufmachen.

Antwort von Bruno Peter:

Gut, verstehe was Du willst oder nicht willst, ich berichte lediglich darüber was

jetzt aus meiner Erfahrung heraus vorhanden und möglich ist.

Die Medienindustrie entscheidet ob HDR(HLG) Top oder ein Flop wird wie 3D,

nach dem kein MM-Besucher mehr fragt.

Antwort von wolfgang:

Rodder hat geschrieben:

Hallo Zusammen,

ich filme mit einer Panasonic GH5, welche ja auch intern mit 10Bit Farbtiefe aufnehmen kann. Bisher habe ich dieses Feature der GH5 nicht nutzen können/wollen, da weder der Windows Media Player die Dateien abspielen kann, noch meine Schnittsoftware Vegas 14 und DaVinci Resolve 14 (Free Version) mit dem Codec im 10Bit format etwas anfangen können. Soweit ist das auch schon ein bekanntes Problem des 10Bit Codecs der GH5...und es gäbe verschiedene Möglichkeiten diesen verarbeiten zu können --> Vegas 15 kaufen, Vollversion DaVinci Resolve Kaufen oder einen Transcoder nutzen, welcher wahrscheinlich auch Geld kostet.

Aber ich habe mir jetzt nochmal grundsätzlich die Frage gestellt, wie dieser ganze 10Bit Postproduction workflow funktionieren soll und ob dieser momentan überhaupt Sinn macht?

Nehmen wir mal an ich nehme im LOG Profil (Panasonic V-Log) mit 10Bit Farbtiefe auf, Color Grade das ganze in DaVinci Resolve und kann dort die Farben bis an die Grenzen bringen ohne in den Banding Bereich zu kommen (das wäre ja ein Vorteil von 10Bit Farbtiefe).

1. Muss ich nun den Clip in 10Bit heraus rendern um diesen Mehrwert zu behalten oder sieht man den positiven Unterschied dann auch beim rendern in 8Bit?

2. Selbst wenn ich den Clip in 10Bit heraus rendere, Youtube convertiert mir den Clip doch ehe wieder auf 8Bit zurück (falls diese Info falsch ist berichtigt mich gerne)? Sehe ich denn dann wirklich einen Unterschied zwischen intern aufgenommenen 8Bit oder 10Bit bei Youtube (bei V-Log + Grading)?

3. Die Endgeräte auf denen wir alle unsere Videos anschauen sind ja in der Regel 8Bit Monitore. Macht denn ein 10Bit aufgenommenes Video + Color Grading + Herausgabe in 10Bit (oder 8Bit siehe Frage 1 :)) überhaupt sinn?

Das sind eine ganze Menge Fragen, welche mich um die Nächte bringen ;).

Danke schonmal im Voraus für eure Antworten!!

Die ganze Diskussion geht an der Fragestellung des Threadstarters eigentlich ziemlich vorbei?

Ad 1) 10bit macht grundsätzlich in der Postpro immer Sinn, weil es eine höhere Verarbeitungsqualität sichert. Das bedeutet nicht dass es in der finalen Darstellung auf 8bit Geräten einen großartigen Unterschied geben muss.

10bit wird - und darum sind die HDR-Postings doch nicht ungerechtfertigt - aber bei HDR in Zukunft immer gefordert sein. Sei es auf den Displays, sei es auf Kaufcontent (Scheiben, Download). Das hängt damit zusammen dass sich der größere Dynamikumfang sonst nicht mehr fehlerfrei darstellen läßt.

Ad2) Bei der Frage nach dem Grading gibt es bereits heute auch bei YouTube die Möglichkeit, entweder zu rec709 oder zu PQ oder HLG zu graden. Was hier noch kaum einer weiß ist, dass Youtube beim Abspielen die Art des Monitors beim Abspielenden abfrägt - und wenn jemand einen HDR-Clip auf einem rec709 Display anschaut, dann macht YouTube daraus einen rec709 Clip, fragt das aber nicht ab. Nur bei vimeo kann man - falls frei gegeben - über das Originalmaterial sich auch den Originalclip runter laden.

Für dich ist vielleicht wesentlicher zu wissen und zu realisieren, dass wir in Zukunft entweder auch log Material zu rec709 oder zu HDR (egal ob PQ oder HLG) graden können. Wozu du gradest ist die Entscheidung des Anwenders.

Sobald du aber zu einem HDR-Format gradest, musst du zwingend 10bit einhalten - weil wie bereits gesagt: bei HDR kann man den Unterschied zu 8bit dann sehr wohl sehen.

Ad3) Endgeräte werden wohl noch in den nächsten Jahren in der Mehrheit rec709 Geräte bleiben. ABER das wird sich mehr und mehr ändern. Wenn du log filmst musst du zwingend graden. Wenn du zu rec709 gradest kannst sicherlich noch eine Weile zu 8bit ausgeben. Wenn du aber HDR filmst musst du unterscheiden - bei PQ musst zwingend graden. Bei HLG kannst du auch ohne graden weg kommen (mal von den gewissen hier schon angesprochene Helligkeitsveränderungen bei HLG abgesehen, auf einem rec2020 Display, im Vergleich zu einem rec709 Display). Wenn du für HDR ausgibst bist du dann endgültig bei 10bit gelandet.

|

Antwort von Bruno Peter:

wolfgang hat geschrieben:

Was hier noch kaum einer weiß ist, dass Youtube beim Abspielen die Art des Monitors beim Abspielenden abfrägt - und wenn jemand einen HDR-Clip auf einem rec709 Display anschaut, dann macht YouTube daraus einen rec709 Clip, fragt das aber nicht ab.

Lieber Wolfgang nun bist Du endlich hier und gleich mit einer sehr interessanten Information.

Kannst Du die Quelle benennen?

Bei mir ist es so, ich lade ein HLG-File von YT-runter, sehe es mir gar nicht an, schaue lediglich mit MediaInfo rein und nix ist mit HLG, BT.709 wird als File-Eigenschaft genannt obwohl ich angeblich das "Original" runtergeladen habe.

Jetzt erfahre ich von Dir, YT wäre bekannt welchen Monitor ich besitze..., schlimm ist das...

Allerdings in einigen Fällen bekomm ich schon eine HDR-Datei runtergeladen, die vorher hier von Axel zum Beispiel oder auch viele viele andere, manches aber eben nicht.

Antwort von Bruno Peter:

WoWu hat geschrieben:

Da musst Du nun unterscheiden, zwischen (nur) heller werden und steuerung der Hintergrundbeleuchtung.

Wenn HDR nur „heller werden“ bedeutet, bräuchte man den ganzen Zauber nicht.

Und die BBC bezieht sich mit der Kompartibilität nur auf den Bereich, der den identischen Verlauf bis 100 Nits hat ... und das ist der lineare Teil der HLG Übertragungsfunktion für den es dem alten Fernseher nicht extra klar gemacht werden muss, nur muss man sich die Funktion eben mal anschauend und wird sehen, dass die 100 Nits ihren Wert bei 50% Weiß erreichen.

Die BBC hebt in der Kompatibilität im Grunde genommen darauf ab, dass es ein System ist, bei dem das TV Gerät keine Metadaten verstehen muss.

Insofern ist HDR prima, wenn man es auf HDR- Geräten anschaut, aber düster auf andern Geräten, weil den paar Weisswerten (Spitzlichtern) die restlichen 50% des gesamten Videosignals eingeräumt werden.

Lieber WoWu,

ich danke Dir für die erhellenden Argumente die meiner eigenen Fortbildung als Hobbyvideofilmer - der ich immer bleiben will - sehr dienlich sind.

zu: Insofern ist HDR prima, wenn man es auf HDR- Geräten anschaut, aber düster auf andern Geräten,

EDIUS 9 bietet die Möglichkeit an ein HLG-Projekt auch in FHD-8bit 4:2:0 zu exportieren was die Möglichkeit

eröffnet sich das "eigene Werk" auf einem FHD-TV das "düstere Bild" anzusehen.

Ich stelle fest, dass mein Samsung HDTV über viele Knöpfchen und Schieberegler verfügt um das HLG-File

"aufzuhübschen", es sieht unter dem Strich dann gar nicht so schlecht aus. Auf einem UHD-HDR(HLG)-TV

wird es natürlich noch viel hübscher aussehen wenn man es in UHD-10bit und 4:2:2 dafür exportiert.

Antwort von Roland Schulz:

HDR sieht wenn überhaupt nur gut aus wenn man nen TV hat der sagen wir mal min. 1.000nits liefert und bei nem LCD vernünftiges (direktes) Local Dimming unterstützt (OLED liefert systembedingt dunklere Tiefen/Kontrast, das auch pro Pixel, dafür eine geringere Helligkeit).

Sony z.B. hat aber auch Geräte "nachgerüstet" (FW Upd.) die gerade mal ~400cd schaffen, zudem trotzdem kein Local Dimming haben (z.B. X85C, max. Edge LED).

"Glaube" auch das war nicht im Sinne der Erfindung von HDR. Niemand kontrolliert oder zertifiziert sowas aber. Genau das Gleiche wie auf Kameras HDR draufzudrucken die in 8bit ~10, mit Augen zu vielleicht 11 Blenden erfassen können.

So ist das alles ziemlicher Unfug mit HDR!

Das Backlight im TV wird zudem nicht unmittelbar durch Metadaten beeinflusst, das ist rein vom Bildinhalt abhängig, nicht anders als bei SDR auch.

Antwort von wolfgang:

Also HLG ist nicht düster auf anderen Geräten - da kann ja HLG nichts dafür wenn das Display nicht mehr als 100 oder 200 nits kann.

Die Quelle für die YouTube Frage habe ich im Videotreffpunkt irgendwann gepostet - findest dort Bruno.

Roland, 1000nit oder 500nits oder 200nits - aber bitte immer mitzudenken, bei wieviel Prozent der Bildfläche das Gerät diesen Wert darstellen kann. Das fällt nämlich mit steigendem Bildanteil rapide ab. Aber sehr oft sind es auch nur kleinere Bildausschnitte die die Spitzenlichter haben.

Das Prinzip hat wenig mit Unsinn zu tun, sondern mit dem technologischem Stand. Wenn du viel Kohle hast, kannst ja versuchen einen Dolby Pulsar mit 4000 nits zu kaufen! Bin mir nur nicht sicher ob der verkäuflich ist und wenn ja, zu welchem Preis. Selbst heutige Referenzmonitore wie der ca. 30.000 Euro schwere Sony 300er kann "nur" 1000nits.

Dein Sony 65-Zöller kann übrigens bereits heute weit über 1000nits, da er auch noch kein OLED ist.

Antwort von Axel:

WoWu hat geschrieben:

Da musst Du nun unterscheiden, zwischen (nur) heller werden und steuerung der Hintergrundbeleuchtung.

Wenn HDR nur „heller werden“ bedeutet, bräuchte man den ganzen Zauber nicht.

Déjà vu, zum wiederholten Male!

Ich beschäftige mich seit ein paar Wochen (noch) rein hypothetisch mit dem Thema, zeitweise sehr verwirrt über die Variablen. Alles wird klarer, wenn ich mir vor Augen führe, dass HDR im Endgerät, also dem Fernseher, erzeugt wird.

Und da gibt es zwei andere Variablen:

1. Der Kolorist kann nicht wissen, welche höchste Helligkeit der Endverbraucher-HDR-Fernseher erreicht.

2. Der Kolorist muss sich darüber klar sein, dass es, wie alle ausführlicheren HDR-Essays irgendwo erwähnen (u.a. der von Alexis van Hurkman für Resolve) in allen Geräten eine automatische Helligkeitsbegrenzung gibt, aus Gründen der Energieeffizienz. Grob verkürzt gesagt: wenn ein (spezifischer) Fernseher 1000 nits erreicht, tut er dies für 2% des Bildes. Werden 4 % der Pixel angesteuert sind es nur noch 500 nits, usw.

Wenn also Danny Boyles "Sunshine" mal für HDR gegradet wird - hieße das nicht, dass die liebe Sonne sich mit knapp über 100 nits bescheiden müsste?

Antwort von Roland Schulz:

wolfgang hat geschrieben:

Die ganze Diskussion geht an der Fragestellung des Threadstarters eigentlich ziemlich vorbei?

+1 und mein Versuch von 14:28!

Der TO stellte die Frage ob ein 10bit Workflow Sinn macht und das kann man ganz einfach mit "Ja" beantworten!

Bis auf den höheren Anspruch an Bandbreite und Rechenleistung gibt es keine Nachteile!

Irgendwie ist jetzt aber nen halber HDR Thread draus geworden, der verwässerteste "Standard" der jüngsten Vergangenheit.

Solange für HDR keine Zertifizierung notwendig wird ist das wertlos, da macht jeder was er will (400cd Edge Lit "8bit" LCD Fernseher, 8bit/10stop Kameras, Grading quer durch den Acker...). Denke so wird da auf Dauer keiner mit glücklich. Dolby Vision erhält auf der anderen Seite dagegen kaum Akzeptanz, wird womöglich aus anderen Gründen sterben.

Antwort von Roland Schulz:

wolfgang hat geschrieben:

Also HLG ist nicht düster auf anderen Geräten - da kann ja HLG nichts dafür wenn das Display nicht mehr als 100 oder 200 nits kann.

Die Quelle für die YouTube Frage habe ich im Videotreffpunkt irgendwann gepostet - findest dort Bruno.

Roland, 1000nit oder 500nits oder 200nits - aber bitte immer mitzudenken, bei wieviel Prozent der Bildfläche das Gerät diesen Wert darstellen kann. Das fällt nämlich mit steigendem Bildanteil rapide ab. Aber sehr oft sind es auch nur kleinere Bildausschnitte die die Spitzenlichter haben.

Das Prinzip hat wenig mit Unsinn zu tun, sondern mit dem technologischem Stand. Wenn du viel Kohle hast, kannst ja versuchen einen Dolby Pulsar mit 4000 nits zu kaufen! Bin mir nur nicht sicher ob der verkäuflich ist und wenn ja, zu welchem Preis. Selbst heutige Referenzmonitore wie der ca. 30.000 Euro schwere Sony 300er kann "nur" 1000nits.

Dein Sony 65-Zöller kann übrigens bereits heute weit über 1000nits, da er auch noch kein OLED ist.

Wolfgang, das wollte ich ausdrücken. Auch ein LCD kann keine bildschirmfüllenden 2.000nits sondern irgendwo ~800. Durch das direkte Local Dimming aber entsteht trotzdem ein sehr hoher Kontrast, da "Bildbereiche" sehr dunkel neben sehr hellen (dann ~2.000nits) dargestellt werden können.

Es gibt aber auch "HDR" gelabelte Geräte die weder direktes Local Dimming noch eine hohe Helligkeit liefern. Wenn ich mir da so einige HDR LCD Computerbildschirme ansehe fällt einem auf dass da was nicht stimmen kann.

|

|

Antwort von wolfgang:

"Roland Schulz" hat geschrieben:

Wolfgang, das wollte ich ausdrücken. Auch ein LCD kann keine bildschirmfüllenden 2.000nits sondern irgendwo ~800. Durch das direkte Local Dimming aber entsteht trotzdem ein sehr hoher Kontrast, da "Bildbereiche" sehr dunkel neben sehr hellen (dann ~2.000nits) dargestellt werden können.

Es gibt aber auch "HDR" gelabelte Geräte die weder direktes Local Dimming noch eine hohe Helligkeit liefern. Wenn ich mir da so einige HDR LCD Computerbildschirme ansehe fällt einem auf dass da was nicht stimmen kann.

Die erscheinenden HDR Computerbildschirme begeistern mich eigentlich bisher überhaupt nicht. Bei denen ist zu wenig definiert.

Da sind ja die OLEDs noch Gold dagegen.

Und bei HLG ist man durchaus ganz gut definiert - bei PQ sind Teile offenbar undefiniert.

Was das mit 10bit zu tun hat? Na man braucht 10bit dafür. Aber ob das die Frage trifft?

Antwort von Roland Schulz:

Ich bin überzeugt dass Standards wie HDR eine Zertifizierung benötigen, so kann da jeder fast machen was er will. HDR nachzuvollziehen ist zudem nicht so einfach wie bei nem 4K TV die Pixel zu zählen oder den Gewinn an Auflösung zu erkennen.

SDR Content kann auf einem "HDR" TV sehr ansprechend mit vergleichbarem Effekt dargestellt werden ohne dass jemand im Nachhinein nachweisen kann ob es überhaupt HDR ist und mit den entsprechenden Absichten produziert wurde. Kameras nehmen irgendwie irgendeinen Dynamikumfang auf der nicht einem bestimmten Qualitätsmindestansruch entspricht, bei TV"s der gleiche Wildwuchs. Ob da die richtige Übertragungsfunktion jetzt wirklich noch ne Rolle spielt...

"Für mich" ist das Thema so vorerst uninteressant, ich sehe den Vorteil so nicht und wenn ich zudem 4K BD"s kaufe die dann auch noch in 2K gemastert wurden fühle ich mich komplett verarscht!!

Das Thema hat man für mich schon jetzt komplett vor die Wand gefahren bevor es überhaupt angefangen hat.

Die Standards geben in der Theorie ohne Frage ne Menge her, nur muss auch sichergestellt werden dass das annähernd genutzt wird und der Kunde Vorteile und Ergebnisse sieht.

Solange es hier keinen "TÜV" bzw. eine Qualitätskontrolle bzgl. Einhaltung der Spezifikationen gibt ist das ziemlicher Nonsense.

Gut, vom Wiederholen wird"s wahrscheinlich nicht besser...

Wenn ich die Wahl habe ne Kamera mit 10bit zu kriegen nehme ich eine mit 10bit. Gibt"s die "Wunschkamera" nicht mit 10bit sollte sich der mögliche Qualitätsverlust durch Portabilität oder andere Punkte ausgleichen. 8bit sollte kein komplettes No Go sein. Ich würde 8bit S35 z.B. (fast) immer 10bit S16 vorziehen!

Antwort von Uwe:

"Roland Schulz" hat geschrieben:

.... Solange es hier keinen "TÜV" bzw. eine Qualitätskontrolle bzgl. Einhaltung der Spezifikationen gibt ist das ziemlicher Nonsense............

Deutscher geht's nicht ;-) Mann, schaut euch einfach an, was bisher mit HDR gemacht wird - entweder es gefällt euch, oder nicht. Wenn nicht, kein Problem. Aber das endlose Genöhle muss ja nun auch nicht sein...

Antwort von wolfgang:

Ich wüßte nicht wie man da einen TÜV gestalten sollte?

Abgesehen davon, die Sache startet erst gerade. Sie jetzt schon für gescheitert zu erklären ist doch ein wenig verfrüht. Filme mal in log, grade das log zu PQ oder HLG, und lerne aus diesen Tätigkeiten entsprechend.

Denn jenseits des ganzen Zerdiskutierens gibt's auch immer die Variante dass man das einfach mal in der Praxis macht und schaut, wo einem das hinführt.

Antwort von Starshine Pictures:

Wenns kompliziert wird muss immer der Allister ran. Vielleicht hilft das zum Verständnis.

https://youtu.be/m2KLt3qgh50

https://youtu.be/dvTYhWkBXaU

Antwort von blueplanet:

...zusammengefasst und wenn ich es richtig verstanden habe:

- in HLG aufzunehmen macht nur wirklich Sinn, wenn der entsprechende Monitor (incl. ein techn. geeigneter Smart-TV mit (!) der Möglichkeit eines Farbprofilwechsels Rec709 vs BT2020) vorhanden ist. Wenn nicht, tut es aber auch nicht "weh", das Bild ist halt etwas dunkler und von der angestrebten Dynamikerweiterung bleibt im Grunde nix übrig (aber das sagte bereits @WoWu ganz am Anfang der Diskussion). Zieht man zudem in Betracht, das im Moment und wohl noch auf ein paar weitere Jahre gesehen ein Großteil der TV-Consumer kaum einen Unterschied zwischen "schlechtem" HD-Ready und "gutem" FHD, geschweige denn zwischen "sehr gutem" FHD und UHD in HDR erkennen, dürfte es schwer werden, sie zum Extra-Kauf eines "HLG-fähigen" Gerätes zu bewegen. Oder mit anderen Worten: HLG ist im Grunde "nice to have" bzw. ein "einfaches" V-LOG tut es im Moment (wenn schon, denn schon) besser.

- was mir noch nicht ganz klar ist: gerade wenn keine Möglichkeit besteht explizit am Monitor zwischen Rec709 und BT2020 umzuschalten, was geschieht mit den Farben?! Dann ist der Bildeindruck nicht nur "dunkler" (was man ja vielleicht bis zu einem gewissen Grad noch regeln könnte), aber die Farben in Abhängigkeit von der Helligkeit dürften nicht wirklich zu kalibrieren sein?! Richtig?

- und/aber was hier und durchaus auch im Zusammenhang mit 10Bit noch gar nicht beleuchtet wurde, sind die angeblichen Unterschiede des Rauschverhaltens der Kamera bei einer HLG vs. V-LOG-Aufzeichnung?! Hier soll ja HLG einen besseren "Job machen" als V-LOG und Kumpanen.

Aber vielleicht liegt das auch nur wieder daran, das für meine Eindrücke an einem 8Bit-Monitor ohne BT2020, 10Bit V-LOG-Bilder gerade in den Schatten (richtig belichtet!) eine besser Durchzeichnung haben als HLG-Bilder. Bzw. wo mehr "schwarz" ist, "rauscht es auch weniger"?!

Oder mit anderen Worten: was ich an Spitzlichtern und "Rauschfreiheit" gewinne, vergebe ich in der Durchzeichnung in den Tiefen. Oder?

Und wenn ich ganz, ganz ehrlich bin, mich weit aus dem Fenster lehne und einen Vergleich, ein Fazit zwischen der GH4 mit CineLike-Profil (NR -5, etc.), Knee +10 und 8Bit/Rec709 und einer GH5 mit HLG 10Bit/BT2020 oder V-LOG 10Bit/Rec709 wage, dann tendiere ich zumindest in Punkto End-Farben (kein exzessives Colourgrading) und im Besondern bei der"Rauschfreiheit" bis ISO 3200 fast zur GH4 ;). Denn ich denke, man muss immer die Gesamtperformance einer Kamera im Blick behalten. Einfach etwas herausgreifen: "es" kann HLG mit ...= besser, wird so nicht funktionieren.

Antwort von Alf_300:

Blueplanet.

Mußt Dir wirklich kene Sorgen machen,denn Alle haben Kabel oder Satelitenfernsehen

Da gibts in Deutschland sowieso nur tolles aufgeblaenes SD mit niedriger Bitrate.

Antwort von Roland Schulz:

blueplanet hat geschrieben:

...zusammengefasst und wenn ich es richtig verstanden habe:

...HLG ist im Grunde "nice to have" bzw. ein "einfaches" V-LOG tut es im Moment (wenn schon, denn schon) besser.

Panasonic V-LOG hat mit HLG überhaupt gar nichts zu tun und ist nicht vergleichbar! V-LOG ist eine reine Aquisitionsübertragungsfunktion - "das kann man unbearbeitet nicht ansehen". HLG kann dagegen beides und liegt im unteren Bereich ganz nah an REC709, zeigt aber im Post deutliche Einschränkungen in den Möglichkeiten der Nachbearbeitung.

Antwort von blueplanet:

"Roland Schulz" hat geschrieben:

Panasonic V-LOG hat mit HLG überhaupt gar nichts zu tun und ist nicht vergleichbar!

...is klar ;)! Ich wollte es auch nicht vergleichen, sondern als praktikable Alternativen betrachten. HLG kann ich wie Rec709 irgendwie ansehen, aber eben nur irgendwie (ohne die richtigen technischen Anzeigegeräte). Die Frage, macht es dann überhaupt Sinn, es jetzt anzuwenden oder gar als massenkompatibel einzustufen?! V-LOG würde man im Ursprung ohnehin niemanden anbieten, aber man erhält sich damit (im Moment) eben die größte Flexibilität! Oder - man bleibt gleich (noch) bei "wie Rec709".

Antwort von Roland Schulz:

...oder man freundet sich mit einem Kompromiss wie einer Cinegamma an - wobei das in Bezug auf HDR alles in ganz verschiede Richtungen geht und ich zudem die Eignung einer Cinegamma in der Panasonicschiene nicht bewerten kann. "Für mich" ist die Cinegamma bei den 8bit Sonys allerdings der beste Kompromiss.

Antwort von Uwe:

blueplanet hat geschrieben:

... HLG kann ich wie Rec709 irgendwie ansehen, aber eben nur irgendwie (ohne die richtigen technischen Anzeigegeräte). Die Frage, macht es dann überhaupt Sinn, es jetzt anzuwenden oder gar als massenkompatibel einzustufen?! V-LOG würde man im Ursprung ohnehin niemanden anbieten, aber man erhält sich damit (im Moment) eben die größte Flexibilität! Oder - man bleibt gleich (noch) bei "wie Rec709".

Am Anfang hatte ich auch gedacht, dass das V-Log L der GH5 gut geeignet sein müsste für eine HDR-Bearbeitung. Leider ist dem nicht so: Man bekommt oft Artefakte/Sky-Banding in den Lichtern. Ich schätze, dass es daran liegt das die "L"-Variante ab IRE 80% nach oben alles absägt. Und bei HDR kommt es dann wohl zu diesem negativen Effekt. Wer also für die Zukunft in Sachen HDR mit der GH5 flexibel sein will, der sollte (so wie Bruno es machen will) in HLG filmen. Die fehlenden 30% nach oben bei SDR lassen sich mit einem Effekt in PP + DR weitestgehend zurückholen...

Antwort von Alf_300:

Wenn ein SDR (Altdeutsch: normales Bild)

mit enem unterbelichteten und einem überbelichteten Bild gemischt wird

ist das für mich ein kaputtes Bild-

Antwort von blueplanet:

Uwe hat geschrieben:

Am Anfang hatte ich auch gedacht, dass das V-Log L der GH5 gut geeignet sein müsste für eine HDR-Bearbeitung. Leider ist dem nicht so: Man bekommt oft Artefakte/Sky-Banding in den Lichtern. Ich schätze, dass es daran liegt das die "L"-Variante ab IRE 80% nach oben alles absägt. Und bei HDR kommt es dann wohl zu diesem negativen Effekt.

....versteh' ich nicht ganz. Man kann doch nur entweder oder?! Ergo in V-LOGL ODER in HDR drehen. Oder?? Weshalb willste denn aus V-LOG HDR machen. Das beißt sich doch in sich. V-LOG ist absolut kritisch in den Highlights und HLG will ja im Prinzip noch mehr Highlights.

PS.: sitze gerade über ein paar Clips mit meinen ersten V-LOG-Versuchen in 10Bit der GH5. Schwanke so zwischen total begeistert und ziemlich frustriert (stimmt, habe oft ebenfalls Banding, ausbrennen in den Highlights) Irgendwie muss das Band wo richtig belichtet wird ziemlich unpraktikabel schmal sein oder ich muss noch üben, üben üben. Ist man einen deut zu hell gewesen, ist es schwer auch mit 10Bit die Kiste auf die anderen Helligkeitstufen bezogen zu retten. Hat man eher unterbelichtet ist zwar viel Platz nach Oben, aber dann rauscht es auch kräftig in den Tiefen (LOG: V-LOGL zu Rec709 V35Panasonic).

Weiss nich', werd' wohl wieder und auch mit der GH5 nach CineLike in Rec709 switchen. Scheint irgendwie stressfreier zu sein. Oder gibt es noch einen generelen V-LOG-Joker an der GH5?

Antwort von Uwe:

blueplanet hat geschrieben:

.......versteh' ich nicht ganz. Man kann doch nur entweder oder?! Ergo in V-LOGL ODER in HDR drehen. Oder?? Weshalb willste denn aus V-LOG HDR machen....

Als Grundvoraussetzung nimmt ja den Modus für HDR, der am meisten Dynamikumfang hat. Und das ist bei der GH5 ja V-Log L. Aber klappt nicht aus den genannten Gründen. Dieser Artikel von Mystery Box ist da sehr hilfreich: https://www.mysterybox.us/blog/2016/10/ ... ng-for-hdr

So in summary, when choosing your kit for HDR, consider:

1.16 bpc > 14 bpc > 12 bpc > 10 bpc > 8 bpc: 10 bpc should be your minimum spec.

2.RAW > LOG > Linear > Gamma 2.4: avoid baking in your gamma at all costs!

3.Camera Native / BT.2020 > DCI-P3 > Rec. 709 color primaries

4.RAW > Compressed RAW > Intraframe compression (ProRes, DNxHR, AVC/HEVC Intra) > Interframe compressed (AVC/H.264, HEVC).

Und was HLG angeht: Der User Jonpais hat da im EOSHD-Forum einen ganz guten Fred dazu: https://www.eoshd.com/comments/topic/26 ... -d/?page=1

Und im DVXuser-Forum: http://www.dvxuser.com/V6/showthread.ph ... LG-Footage

Beide basieren auf der LUT von Paul Leeming (hab sie früh zum Sonderpreis von Paul gekauft). Aber wer das Geld nicht ausgeben will, man kann natürlich in jeder guten Software sich eine eigene Lut dazu basteln...

Antwort von wolfgang:

Also v log l zeigt bei mir kein Banding, ich nehme allerdings mit dem Shogun in 10bit 422 auf. Das ist auch nicht mit dem relativ geringen Dynamikumfang der GH4/5 Sensoren erklärbar, was es da bei dir hat weiß ich nicht.

HLG ist ein Kompromiss als Lieferformat für SDR und HDR Displays, mit geringen Helligkeitsunterschieden. Es ist nicht gut für die direkte Aufnahme geeignet. Ein Pferdefuß ist der zugrunde gelegte Farbraum - entweder nimmt man rec709 und ist damit wirklich kompatibel mit SDR Displays, oder rec2020 für HDR Schirme.

Und ohne passender HDR Vorschau lässt sich das Material am Schnittplatz nicht zuverlässig beurteilen- eine Binsenweisheit. Wird aber aufgrund der Preise der Kontrollmonitore gerne ignoriert.

Antwort von Roland Schulz:

Kenne die GH5 nicht so genau, wenn man sich V-LOG L mal ansieht erkennt man aber schnell den Pferdefuß der zu Banding führen "könnte":

Da die Kamera ohnehin nur einen recht begrenzten Dynamikumfang von in der Praxis zwischen 11-12 stops liefert ist man oft dazu gezwungen, relativ "eng" zu belichten. Die oberste Blende zeigt dann aber schon einen recht flachen Rolloff, der sich in Bezug auf die "eingeschränkte" 10bit Gesamtdynamik recht wenige Inkremente teilen muss.

Antwort von Uwe:

"Roland Schulz" hat geschrieben:

Kenne die GH5 nicht so genau, wenn man sich V-LOG L mal ansieht erkennt man aber schnell den Pferdefuß der zu Banding führen "könnte":

...

Es wäre eben auch meine Vermutung, aber ich bin da mehr der Praktiker als der Theoretiker. Als ich es das erste mal entdeckt hatte, habe ich es natürlich mehrmals mit anderen Aufnahmen gegen gecheckt. Aber man sah es mehr oder weniger auch da. Und es liegt auch nicht an der Komprimierung von Vimeo oder YT (verstärkt es aber). Ich sehe es schon nach dem Rausrendern des DNxHR HQX 10bit aus DR14. Auch der Vlogger Dave Dugdale berichtet in einem seiner letzten Videos davon. Sagt aber, wenn man es als unkomprimierte Datei ausgibt sieht er es nicht (bezieht es aber nicht auf HDR)...

Vielleicht kann ja Wolfgang mal ein paar bearbeitete + gegradete Test-Clips als HDR bei Vimeo oder YT hochladen (natürlich mit ordentlich Himmel im Bild)...

Antwort von blueplanet:

...ich bin auch mehr der Praktiker, aber genau um die geht es ja -eigentlich- ;) So entstand mein V-LOGL-Test-Material spontan auf einer Kurzreise, wobei die GH5 im Vorfeld natürlich richtig (so hoffe ich) eingestellt wurde und diverse "Stolperfallen" stets im Hinterkopf waren.

Trotzdem ist ein ziemlich durchwachsenes Material entstanden. Wie gesagt von himmelhoch jauchenzend bis zu "geht gar nicht" ist alles dabei und wenn es etwas "Ernstes" gewesen wäre, hätte es mich sicher mehr als geärgert. Ich hab' auch den Eindruck, dass die Aussage ob V-LOGL an der GH5 Top oder Flop ist, sehr von den Lichtverhältnissen abhängt. Allzu starke Kontraste sind genauso wenig geeignet, wie zu wenig Licht. Das wiederum korreliert eben mit der verwendeten Kamera und ist V-LOGL an sich nicht explizit auf die Fahne zu schreiben. Wie gesagt: möglicherweise ist die GH5 wie schon die GH4 nur bedingt dafür geeignet, stellt die Verwendung von V-LOGL nicht die Lösung für alle Belichtungssituationen dar - denn Grau ist alle Theorie. Ich kann mich jedenfalls bei der run and gun-Methode mit einem gut gepimpten CineLike D mehr auf die Gesamtheit der Ergebnisse verlassen als prozentual mit V-LOGL. Und das ändert speziell bei der GH5 auch kein 10Bit.

Antwort von Bruno Peter:

blueplanet hat geschrieben:

Ich kann mich jedenfalls bei der run and gun-Methode mit einem gut gepimpten CineLike D mehr auf die Gesamtheit der Ergebnisse verlassen als prozentual mit V-LOGL. Und das ändert speziell bei der GH5 auch kein 10Bit.

Das tue ich auch und fahre gut damit.

Antwort von Roland Schulz:

blueplanet hat geschrieben:

...Ich kann mich jedenfalls bei der run and gun-Methode mit einem gut gepimpten CineLike D mehr auf die Gesamtheit der Ergebnisse verlassen als prozentual mit V-LOGL...

...das ist genau das was Wowu und ich hier ständig „vorschlagen“ ;-)!

Antwort von wolfgang:

In den zwei oberen Blendenstufen verglichen zur Variacam oder der EVA1 kommt es nicht zu banding - sondern dort clippt der Prozessor einfach. Und bei jedem Prozessor hast ein clipping, aber das ist kein Banding weil dort hast ja überhaupt keine auswertbaren Signale mehr.

Banding gibt's für mich bei vlog l eher nur wenn man mit ungenügender Bittiefe arbeitet - also etwa mit 8bit. Und/oder eventuell wenn man meint mit HLG filmen zu müssen.

Und WoWu ist ein alter Log-Verweigerer... nur das für sich ist keine Lösung und daher keine Alternative.

Antwort von WoWu:

Das ist doch völliger Quatsch, was Du sagst, ich sei „LOG Verweigerer“.

Das Einzige, was ich sage, ist dass nicht jedes LOG für jede Belichtungssituation geeignet ist und man die Auswahl der Übertragungsfunktion möglichst genau seiner Szenensituation anpassen sollte.

Dahingegen verwendest Du nur noch V-LOG als Allheilmittel und wenn es, wie zu erwarten, nicht richtig funktioniert, schiebst Du es auf die zu geringe Bittiefe.

Du machst Dir erst gar nicht die Mühe, mal zu differenzieren.

Du scheinst auch von Belichtung nicht viel zu halten.

In den meisten Belichtungssituationen, wenn vernünftig ausgeleuchtet ist, braucht man einfach kein LOG (von mehreren, zur Auswahl stehenden) und erst, wenn die Belichtungssituation es verlangt, setzt man ein LOG ein, dass sowohl den mittleren, als auch den oberen Lichtverhältnissen angepasst ist.

V-LOG dahingegen ist nur noch einer sehr engen, mittleren Lichtsituation angepasst und trifft nur auf sehr wenig Lichtverhältnisse befriedigend zu.

Das liegt auch daran, dass das Verfahren für den GH5 Sensor gar nicht gedacht ist und lediglich die Kompartibilität zu VariCam Material gewährleisten soll.

Wenn BluePrint also mit CineLike viel bessere Ergebnisse erzielt, macht er genau das, was ich vorschlage ... die richtige Auswahl zu seiner Szenensituation treffen.

Antwort von wolfgang:

Das ist doch alles Quatsch! Ich verwende log sicher nicht alls Allheilmittel. Woher willst du das wissen? Ich schieße etwa mal in HG und mal in log - je nach Situation. Und rede mir nicht etwas ein, was ich bei mir nicht sehe: ich sehe bei 10bit v log l kein Banding, das ist so.Und ich soll also von Belichtung nichts halten? Woher willst du das wissen wie ich filme? Ich bin ein ziemlicher Verfechter der richtigen Belichtung - und nutze durchaus die Ansätze von Alister Chapman für slog.

Erkläre mir lieber mal wie du einen Dynamikumfang von 14 Blendenstufen aufzeichnen willst. Und kom mir nicht damit dass man das nicht braucht - ebenso wie du uns immer erzählen willst das rec709 mehr als 6-7 Blendenstufen haben soll. Nur leider ist dein Appendx in kaum einer Kamera implementiert.

Ich hätte ja gerne von dir eine differenzierte Vorgehensweisen als Vorschlag gesehen - seltsamerweise kann ich mich daran aber nicht erinneren sowas von dir je gelesen zu haben.

Antwort von wolfgang:

Uwe hat geschrieben:

Es wäre eben auch meine Vermutung, aber ich bin da mehr der Praktiker als der Theoretiker. Als ich es das erste mal entdeckt hatte, habe ich es natürlich mehrmals mit anderen Aufnahmen gegen gecheckt. Aber man sah es mehr oder weniger auch da. Und es liegt auch nicht an der Komprimierung von Vimeo oder YT (verstärkt es aber). Ich sehe es schon nach dem Rausrendern des DNxHR HQX 10bit aus DR14. Auch der Vlogger Dave Dugdale berichtet in einem seiner letzten Videos davon. Sagt aber, wenn man es als unkomprimierte Datei ausgibt sieht er es nicht (bezieht es aber nicht auf HDR)...

Vielleicht kann ja Wolfgang mal ein paar bearbeitete + gegradete Test-Clips als HDR bei Vimeo oder YT hochladen (natürlich mit ordentlich Himmel im Bild)...

Wozu soll ich Beispiele hochladen wenn bei mir alles ok ist? Lade doch lieber du ein Beispiel hoch wo du Banding siehst (aber als Originaldatei die man testen kann).

Antwort von WoWu:

Das Thema wird seit etwa 8 Jahren hier diskutiert.

Wenn Du etwas nicht gelesen haben solltest, liegt das nicht daran, dass es nicht geschrieben wurde.

Und wenn Du kein Banding siehst, dann liegt das an unkritischem Material und nicht daran, dass es kein Bandig gibt.

Vielleicht solltest Du Dir mal die Ausarbeitung von Piet Barten ansehen, dessen Ramp-Verlauf auch als Orientierung für HDR repräsentativ ist.

Daraus kannst Du sehr genau ableiten wo und wann bei welcher Bittiefe Banding auftritt. Aber sowas gilt für Dich ja alles nicht...

Und wenn Du sagst, dass Du Bandong bei Dir nicht siehst, dann heißt das noch nicht, dass es nicht vorhanden ist .... es heißt lediglich, dass Du es nicht siehst.

Antwort von blueplanet:

...hier ein paar Screenshots unkommentiert zur Beruhigung der Gemüter und vielleicht kann sich damit jeder seine Wahrheit untermauern ;)

Ich bin dabei vom "täglichen" Filmen und graden ausgegangen. Ergo so, wie ich (!) mir ein Bild vorstelle/wünsche. Was fehlt ist das Beispiel mit 10Bit. Da ich aber bei UHD bleiben wollte und das intern mit 50fps nicht geht - muss es so genügen. Anhand dieses Beispiels würde es zudem ohnehin kaum ins Gewicht fallen (fast keine Möglichkeit eines banding-Problems). Die Aufnahmen sind optimal nach ETTR belichtet, die Blende blieb unverändert und durchgängige kam ISO 400 (incl. Vario Graufilter) zum Einsatz. Die LUTs sind vom angesehenen Produzenten

Paul Leeming und unterliegen (welchem auch immer) LOGL und HGL zu Rec709/BT2020-Standart.

Screen GH5_VLOL_Original.jpg

Screen GH5_VLOL_LUT One Panasonic VLOGL_grading_-20 Prozent Sättigung.jpg

Screen GH5_CineLike D gepimpt_UHD_50fps_8Bit_Original.jpg

Screen GH5_CineLike D gepimpt_UHD_50fps_8Bit_grading_-10 Prozent Sättigung.jpg

Screen GH5_HLG_UHD_50fps_8Bit_BT2020_Original.jpg

Screen GH5_HLG_UHD_50fps_8Bit_BT2020_LUT One Panasonic HLG.jpg

Screen GH5_HLG_UHD_50fps_8Bit_grading_-10 Prozent Sättigung.jpg

Antwort von Roland Schulz:

Puh, schwer zu beurteilen - Abrisse sind zu sehen, ja, aber eigentlich in allen Screenshots. Sieht mitunter aber auch nach Clipping aus, auch wenn die RGB Parade das nicht unbedingt zeigt, da wäre noch ein paar Prozent Luft bis ~0,7.

Würde mich hier wirklich schwer tun einen systematischen V-LOG L „Fehler“ zu identifizieren.

Antwort von blueplanet:

...vielleicht ist/sind es keine "Fehler", sondern einfach nur Physik(?!) bzw. das Unvermögen des Kameramanns ;). "Meine" Wahrheit tendiert mit der GH5(!) zu einem gepimten CineLike D.

Weshalb? Es macht null Sinn für reine Grenzsituationen, für vielleicht einen Dynamiksprung bzw. a little bit mehr Durchzeichnung in den Tiefen wie Highlights soviel Zeit und Energie für das Endprodukt aufzuwenden und damit generell V-LOGL zu avancieren. Wie @WoWu bereits ausführte, dass "Geheimnis" liegt im Erkennen solcher Grenzsituationen und dem entsprechenden Gegenwirken bzw. Umschalten. V-LOGL hat unbestritten seine Daseinsberechtigung und wer mit 90 prozentiger Sicherheit damit umgehen kann, um so besser! Bei HLG bin ich mir für den Moment und speziell im Zusammenhang mit der GH5 da bei weitem nicht so sicher. Das Gratations- und damit Farbverbiegen ist unter meinen technischen Bedingungen jedenfalls zu heikel. Ich möchte am Ende ein sehr gutes und ausgewogenes 8Bit, FHD-Bild. Dafür bietet CineLike D den sichersten, schnellsten und irgedwie auch logischsten Weg.

Die Presets an der GH5 wie bereits an der GH4:

CineLike D

Kontrast: 0

Schärfe: -5

NR: -5

Farbe: -4

Dynamik: 0

Helligkeitsverteilung (Tag-Profil)

Shadow: 0

Highligths: -2

Helligkeitsverteilung (Lowlight-Profil)

Shadow: +2

Highligths: +2

Schwarzpegel (Tag-Profil)

+ 5 (mehr Durchzeichnungsmöglichkeiten in den Shadows, ergo: "Absaufen" kann man es immer lassen, aufhellen eher schwer)

Schwarzpegel (Nacht-Profil)

+10 (wesentlich bessere ISO-Rauschverhalten)

alles ander ist auf "off"

Zebra: 80%

Standart ISO Tag 400

Standart ISO Lowlight 1600

Standartblende Tag 4,0

Standartblende Lowlight 2,8

Standartshutter bei UHD 50fps Tag: 1/100

Standartshutter bei UHD 50fps Lowlight: 1/50

Belichtet sowohl bei Tag als vorallem in Lowlightsituationen immer nach ETTR habe ich "augenscheinlich" bis 3200 ISO kein störendes Rauschen im Bild, natürliche Farben, ein gutes Kontrastverhältnis und kann in der Post zu 95% davon ausgehen, das ich die Highlights auf den Gesamtbildeindruck (!) bezogen in den Griff bekomme. Mein Verfahrensweise, meine Meinung.

LG

Jens

Antwort von Roland Schulz:

...dem ist auch nichts entgegenzusetzen, bin selbst (Sony a6500) Cinegamma Verfechter da ich damit den „selben“ DR erziele, zudem in den „wichtigeren“ Bereichen mehr Abstufungen zur Verfügung habe und visuell „lebendigere“ Bilder mit mehr Tiefe erhalte.

Eine Cinegamma ist näher am „Endprodukt“ als ein xLOG - wo im Post später weniger verbogen werden muss entstehen weniger Verluste/Nachteile.

Das ist allerdings primär bei 8bit Geräten wichtig - derzeit gibt‘s leider keine 10bit „a6500“ bzw. vergleichbare Kameras.

Antwort von Bruno Peter:

blueplanet hat geschrieben:

Die Presets an der GH5 wie bereits an der GH4:

CineLike D

Kontrast: 0

Schärfe: -5

NR: -5

Farbe: -4

Dynamik: 0

Helligkeitsverteilung (Tag-Profil)

Shadow: 0

Highligths: -2 LG

Jens

Meine Kamera Presets bei der Panasonic FZ300, diese Kamera hat viele Eigenschaften der GH4 "geerbt":

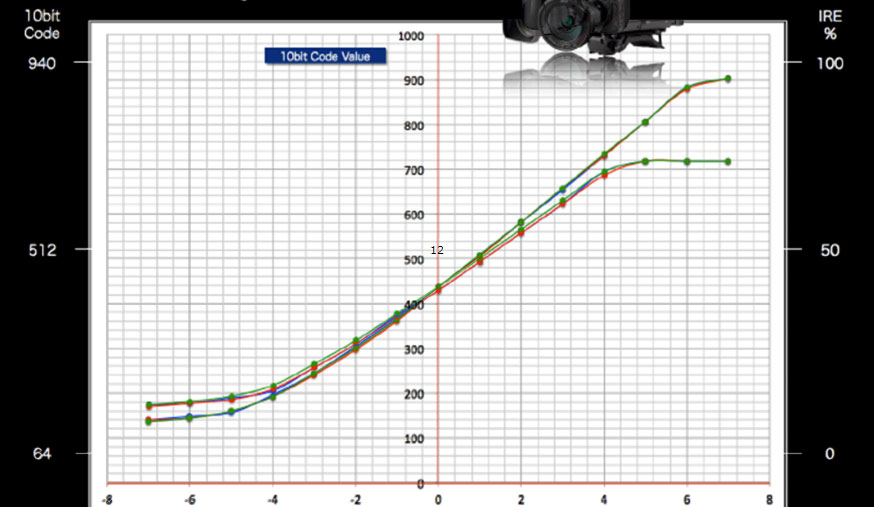

Trübwetteraufnahme mit Einblendung der "halben" Wellenform in EDIUS 9:

zum Bild

Nach dem Grading im BT.709 Farbraum mit passender LUT:

zum Bild

Antwort von ruessel:

Gestern im Privat-TV: Sind Weihnachtplätzchen aus Fertigteig genauso gut wie selbstgemacht? Eine Story für 3 Minuten über den TV geflimmert, in HD produziert....... Alles schön mit bewegter Kamera gedreht. Die Testerinnen stellten zum Schluss die Ergebnisse vor und waren sich einig, selbstgemacht sieht schon wesentlich besser aus, viel gelber wegen dem Ei und der richtigen Butter - nur auf dem Bildschirm sahen beide Backbleche völlig identisch aus. Der Kameramann ging noch in Großaufnahme auf beide Bleche - wieder nix, beide Gelbtöne sehen gleich aus. Im "Off" hört man dazu: "Sieht nicht nur besser aus, schmeckt auch besser....." Eine bildliche Farce, nein, eine bildliche Katastrophe.

Keine Ahnung welche Kamera...... keine Ahnung ob 10 Bit........ ist im Prinzip mir egal. Vielleicht gibt es manchmal wichtigere Bildparameter als 4K mit 10 Bit, besonders bei Kameras unter, sagen wir mal, 5000,- EUR. Eine gute Farbdifferenzierung kann manchmal den Film unterstützen, ihn sogar erst glaubhaft machen, egal ob 8Bit oder sogar 12 Bit.

Antwort von Jörg:

Vielleicht gibt es manchmal wichtigere Bildparameter als 4K mit 10 Bit, besonders bei Kameras unter, sagen wir mal, 5000,- EUR. Eine gute Farbdifferenzierung kann manchmal den Film unterstützen, ihn sogar erst glaubhaft machen, egal ob 8Bit oder sogar 12 Bit.

natürlich, du wirst nur Schwierigkeiten haben, das hier, ausgerechnet hier, als Fakt zu installieren...;-))

Antwort von ruessel:

als Fakt zu installieren...;-))

Möchte ja gar nix installieren. Ich weiß nur, das meine BMD Pocket Kamera 10 Bit hat und vom Bild her manche neueren Kameras vom Bildeindruck doch noch schlägt (Dynamik). Aber trotz den 10 Bit, würde ich nur ungern ein Film mit viel Rottönen (Feuerwehr etc.) damit drehen wollen, das ist nicht ihr Ding. Nicht das man keine Feuerwehren auf die SD Karte bekommt aber bei einer Feuerwehr prall in der Sonne kann es kritisch werden, der Sensor macht bei geschätzten 80-90% Belichtung schon vorher dicht - es clippt.

Bei einer 2000,- Euro Kamera bleibt nach Abzug der MwSt. gerade 1680,- über, dann Abzug Gewinn Handel, minus Transport, minus Marketing, Garantierückstellung,.....etc. Es bleibt wohl 1000,- über für die Herstellung der Kamera. da ist der Techniker wirklich am Grübeln, Bildsensoren sind echt teuer im Vergleich zu den restlichen Chips. Dann lieber günstigen 0815 Bildchip einbauen und nachher schön den Signalweg mit 12Bit hastenichgesehen betiteln und viele Picture Profile mit liefern, die viel können aber nix richtig. Scheint dann für viele Konsumenten zu reichen......

Antwort von Bruno Peter:

Ich denke für mich lohnt sich der Umstieg auf die neue HDR-HLG und 10bit Technologie nicht wirklich.

Bin eigentlich mit dem bisherigen Weg von UHD auf FHD in 8bit kreativ zu schneiden und mit Authoring

auf eine Bluray zu brennen vollauf zufrieden.

Ich beschäftige mich halt nur aus Neugierde für die neue Technologie!

Antwort von Uwe:

"Bruno Peter" hat geschrieben:

... Ich beschäftige mich halt nur aus Neugierde für die neue Technologie!

Neugierde ist der Antrieb für Fortschritt ;-). Mir bringt es einfach Spaß ein bisschen zu experimentieren mit HDR. Darum werde ich in Zukunft immer zweigleisig fahren, wenn es die Zeit erlaubt. V-Log L (10bit) ist für SDR OK - habe gute Ergebnisse damit erzielt. Für HDR ist es erst einmal für mich erledigt. Bin jetzt am überlegen, ob ich weiter in Cinelike D oder HLG filme, um die Türen offen zu halten für ein HDR Editing/Grading in der Zukunft. Die Ergebnisse, die einige in HLG z.B. mit der Leeming LUT (Rec709) erzielen sind teilweise sehr reizvoll. Hier ein Clip als Beispiel von dem Jon Pais (ab 2:25)

https://www.youtube.com/watch?v=lzhCxgin0UY

Antwort von Alf_300:

Mit Aurora 2018 oder Photomatrix HDR

läßt sich HDR gut verabschaulichen.

Antwort von rob:

***nach offtopic verschoben von admin***