Das Perzeptron

Das kleinste und "urspünglichste" Element eines KI-Modells ist das sogenannte Perzeptron. Dieses wurde schon vor über einem halben Jahrhundert erfunden und ist irgendwie ein bisschen einer menschlichen Nervenzelle nachempfunden. Ein Perzeptron ist über viele Eingänge und Ausgänge mit anderen Perzeptren verbunden. Diese Verbindungen waren ein erster Versuch, die stark vernetzten Nervenleitungen im menschlichen Gehirn mathematisch abzubilden.

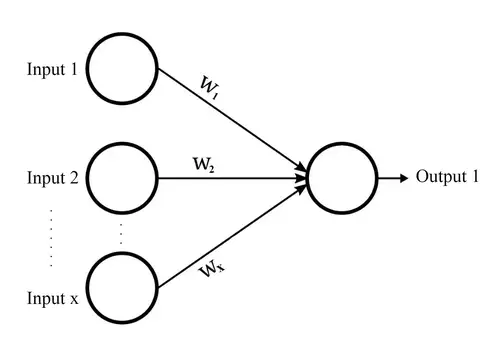

Wie eine Nervenzelle bekommt auch ein Perzeptron als Input Signale von anderen Perzeptren, fasst diese zusammen und gibt diese als Output an andere Perzeptren weiter.

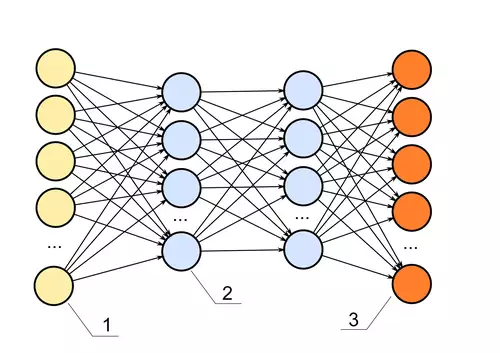

Im allgemeinen KI-Sprachgebrauch hat sich mittlerweile der Begriff "Neuron" für ein Perzeptron als gleichbedeutend etabliert. Für neuronale Netze, die lernen sollen, schaltet man nun solche Neuronen in Schichten zusammen. Dabei werden immer die Ausgänge der Neuronen mit den Eingängen aller Neuronen der nächsten Schicht verbunden.

Mehr als 5 Schichten gelten heutzutage bereits als relativ viel, weil mit jeder Schicht der Rechenaufwand stark ansteigt. Aber erst mit einer gewissen Schichtenanzahl kommt man zu wirklich interessanten (weil komplexen) Lernergebnissen. So spricht man bei vielen Schichten von "tiefen", ergo "Deep" Neural Networks. Und davon abgeleitet etablierte sich schließlich der Begriff Deep Learning.

Diese Schichten sind in der Regel so verbunden, dass jede Schicht seine Signale von der davor liegenden Schicht als Input erhält und jedes Perzeptron einer Schicht seinen Output an die nächste Schicht weitergibt. Ein vereinfachtes Netzwerk darf man sich dann so vorstellen:

Jede Verbindung eines Perzeptrons zu einem anderen wird durch einen Pfeil symbolisiert. Jeder Pfeil entspricht einem "Gewicht" der Verbindung. Dieses Gewicht beschreibt, wie stark jedes Signal des absendenden Perzeptrons beim eingehenden Perzeptron ankommen soll. Eine Verbindung mit kleinem Gewicht sendet also ein schwaches Signal und eine Verbindung mit großem Gewicht sendet immer ein starkes Signal.

Denken wir uns nun ein Netz, bei dem die Gewichte zwischen den einzelnen Neuronen zufällig erstellt wurden.