Nach Bild- und Text-generierenden KIs gibt es noch weiteres Feld, in welchem gerade per künstlicher Intelligenz enorme Fortschritte gemacht werden und zwar bei der Synthese von menschlichen Stimmen per DeepLearning. So gibt es nicht nur immer mehr Text-zu-Sprache Dienste, mit deren Hilfe beliebige Texte durch KI-Stimmen vertont werden können, sondern diese werden auch immer besser. Die Qualität der generierten Stimmen ist mittlerweile dank KI weit entfernt von den monotonen Computerstimmen früherer Tage und sogar existierende Stimmen können nahezu realistisch nachgeahmt werden - benötigt wird dafür immer weniger Trainignsmaterial. So kommt OpenAIs VALL-E zum Beispiel mit nur noch 3 Sekunden Stimmsamples aus, um eine Stimme simulieren zu können.

Allerdings täuscht die Anzahl der Text-2-Voice/Speech Services bezüglich der tatsächlichen Vielfalt, da viele Dienste "unter der Haube" per API einen Text-to-Speech Dienst wie etwa den von Microsofts Azure Cloud nutzen. Einige aber sind wirklich innovativ und entwickeln eigene Algorithmen und trainieren diese aufwändig. Eines der besten Tools zur Sprachgenerierung ist das des Startups Elvenlabs. Dessen Sprach-KI, die mit rund 500.000 Stunden Audiomaterial trainiert wurde, kann menschliche Stimmen erstaunlich echt simulieren bzw. klonen, inklusive eines real anmutenden Tonfalls, Sprechrhythmus und korrekter Betonungen. Ebenso lassen sich anhand mehrerer Parameter vollkommen neue Stimmen erschaffen.

Virtuelle Stimmen mit menschlichen Emotionen

Die Text-to-Voice Technologie ist so weit fortgeschritten, dass generierte Stimmen kaum mehr (von Menschen) als solche erkannt werden können und somit als "echt" durchgehen - ähnlich wie bei den per KI generierten Bildern und Texten. Das eröffnet völlig neue Anwendungsmöglichkeiten, die bisher verschlossen waren, weil die Stimmen dafür einfach noch nicht gut waren.

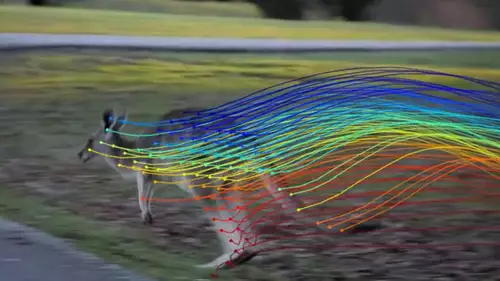

Elvenlabs KI versucht durch eine Art Textanalyse zu verstehen, in welcher Gefühlslage - ist der Sprecher traurig, glücklich oder wütend? - ein Satz im Kontext des gesamten Textes gesprochen werden soll. Das funktioniert so gut, dass mit der jetzt erreichten Stimmenqualität (die stetig noch weiter verbessert wird) Audiobücher, Podcasts, Hörspiele oder beliebige andere Texte vertont werden können, auf Wunsch in beliebig vielen unterschiedlichen, jeweils individuellen Stimmvarianten - vielleicht nicht in einer Qualität, die professionellen Sprechern gleichkommt, aber für viele Anwendungen und Hörer dennoch gut genug ist. Auch für den Filmbereich ergeben sich dadurch neue Chancen: so kann etwa der Sprecher eines Dokumentarfilms mit kleinem Budget jetzt durch eine per KI erzeugte Stimme ersetzt oder es können Dubversionen eines Films in anderen Sprachen generiert werden (per KI lassen sich sogar nachträglich die Lippenbewegung der Schauspieler anpassen). Für professionelle Sprecher könnte dieser technische Fortschritt allerdings bedeuten, dass viele Jobs wegfallen und vielleicht nur die besten Sprecher weiter genügend Arbeit finden werden.

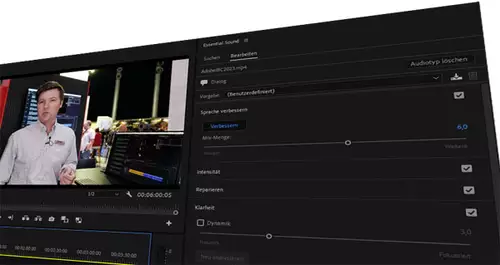

Das folgende Beispiel demonstriert die Möglichkeiten einer solchen Sprach-KI für Kreative (erforderte allerdings auch einige Durchläufe und Editierarbeit):

Echte Stimmen klonen

Viele weitere Anwendungsgebiete ergeben sich dadurch, dass schon vorhandene Stimmen in überraschend guter Qualität (zum Beispiel auch Akzente) geklont werden können. Die geklonte Stimme kann einen beliebigen Text sprechen oder alternativ auch Gesprochenes aus einer anderen Stimme konvertieren:

Für Filmemacher bieten sich dadurch interessante Möglichkeiten. So lassen sich nachträgliche Stimmaufnahmen - zum Beispiel zum Dubbing oder zur Korrektur von Versprechern beim Dreh - im Studio machen, ohne dass die Schauspieler vor Ort sein müssten. Da allerdings bisher keine besondere Berechtigung nötig ist, kann im Prinzip jede beliebige Stimme, von der man etwas Audiomaterial hat, simuliert werden, was natürlich schon zu einem kleinen Skandal geführt hat.

Der Missbrauch ist nicht weit

Denn User der berüchtigten Internetplattform 4chan haben Elvenlabs Sprach-AI dazu genutzt, Audiofakes mit den Stimmen von bekannten Persönlichkeiten zu produzieren. So zirkulieren unter anderem Clips, in welchen die Schauspielerin Emma Watson einen Auszug aus Adolf Hitlers "Mein Kampf" liest und der amerikanische Präsident Joe Biden ankündigt, Truppen in die Ukraine zu schicken - zum Teil auch noch per DeepFake als Video einigermaßen realistisch animiert.

Hier eine Demo dieser Fähigkeit, Stimmen zu klonen:

Dieser - wenig überraschende - Missbrauch der Technik hat dazu geführt, dass Elvenlabs den bisher anonymen kostenlosen Zugang jetzt beschränkt hat. Zwar gibt es noch die Möglichkeit, kostenlos Sprechersamples zu generieren (mit bis zu 10.000 Zeichen pro Monat), aber User müssen sich davor samt Kreditkarteninformationen registrieren, um nicht mehr ganz so anonym wie bisher zu sein und können nur noch vorgefertigte Stimmen verwenden. Zudem ist die Voice Lab Funktion, mit deren Hilfe beliebige Stimmen nachgeahmt werden können, nurmehr im bezahlpflichtigen Dienst zugänglich. Überlegt wird auch, in Zukunft das Klonen von Stimmen nur noch anhand eines speziellen, extra einzusprechenden Textes zu erlauben, also nicht mehr über x-beliebige Samples.

ElevenLabs versieht ferner jeden Audioclip mit einem Wasserzeichen, um ihn bei Missbrauch zu dem User zurückzuverfolgen, welcher ihn generiert hat und diesen zu sperren. Auch soll demnächst ein Tool veröffentlicht werden, mit dessen Hilfe geprüft werden kann, ob ein Audioclip einer Stimme mit mittels der Elvenlab Technologie erstellt wurde.

Es wird sich zeigen, ob diese Schutzmaßnahmen ausreichen, um Missbrauch zu vermeiden. Allerdings gibt auch noch weitere Sprach-KIs, die sich nicht diese Beschränkungen auferlegen. Es ist also nur eine Frage der Zeit, bis zum nächsten Skandal mit einer Fakestimme.

Individueller gefährlicher sind Stimmfakes aber im privaten Bereich, wo die Möglichkeiten durch die neue Technologie auf noch größtenteils ahnungslose Menschen trifft, welche nicht vorbereitet sind auf täuschend echt gefälschte Stimmen.

Da wenige Sekunden Audiomaterial reichen, um eine Stimme realistisch nachzuahmen (heutzutage leicht in Videos in den sozialen Netzwerken zu finden), könnten AudioFakes bald allgegenwärtig sein, etwa in Form eines Liebesgeständnisses, das jemandem in den Mund gelegt wird, oder Hasstiraden, falschen Aussagen uä. Noch realistischere Enkeltricks mit der Originalstimme oder andere Betrügereien sind ohne viel Phantasie denkbar. Die Stimme hat damit als untrügliches Authentifizierungsmerkmal ausgedient - erst recht im Zusammenspiel mit per ChatGPT (bzw. einer zukünftig noch besseren Text-KI) in Echtzeit erzeugten Dialogtexten.

Was kostet es? Können KIs auch deutsch?

Mehrere Text-to-Speech Services bieten eine kostenlose Lizenz an, diese umfasst aber meist nur einige unterschiedliche Sprecherstimmen, wenig Text bzw. kurze Sprechzeiten und darf in der Regel auch nicht kommerziell genutzt werden. Aber schon ab wenigen Euro bzw. Dollar pro Monat (bei Elvenlabs 5 Dollar, bei MURF 19 Dollar, bei Play.ht rund 15 Dollar) wird auch die kommerzielle Nutzung erlaubt, es stehen mehr Sprecherzeit und auch mehr Stimmen zur Verfügung.

Noch funktioniert die Stimmgenerierung von Elvenlabs KI nur auf Englisch, aber es ist nur eine Frage der Zeit, bis die Auswahl immer größer wird. Es gibt jedoch bereits andere hochwertige Text-to-Voice oder auch Voice-to-Voice Dienste, die auch Deutsch beherrschen, wie etwa MURF oder Play.ht.

Welche Erfahrungen habt Ihr gemacht beim Gebrauch von solchen Sprach-KIs?