Seit ein paar Tagen ist es endlich soweit: die Text-zu-Bild KI Stable Diffusion wurde veröffentlicht und kann kostenlos auf dem eigenen Computer genutzt werden - damit ist jetzt erstmals die Generierung von Bildern per Textinput auch auf einem normalen PC (mit einer Extra GPU) möglich. Dank Stable Diffusion kann damit jeder/e Interessierte selbst den Zauber von KI-generierten Bildern ausprobieren und sich ein Bild davon machen, wie mächtig solche Algorithmen sind - und vielleicht eine davon Idee bekommen, wie diese neue Technologie in die eigene Arbeit integriert werden kann.

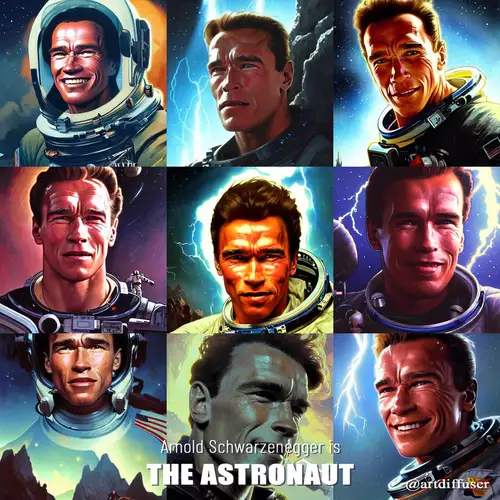

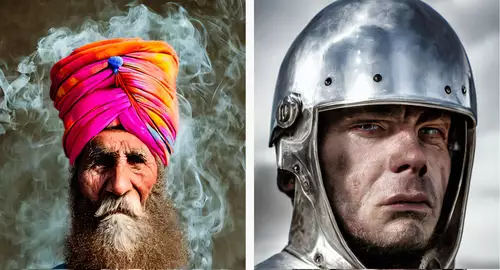

Mittels einer einfachen Texteingabe können Bilder beliebiger Subjekte in verschiedenen Stilen erzeugt werden. Die Bildstile können dabei von realistischen Photographien bis hin zu phantastischen Gemälden im Stile berühmter Maler reichen und die Bildinhalte können sowohl alltägliche Gegenstände in beliebiger Komposition sein, als auch Skulpturen, Städte, (Innen-)Architektur, Landschaften oder neugeschaffene Wesen - der Phantasie sind keine Grenzen gesetzt. Im Gegensatz zu DALL-E2 erlaubt Stable Diffusion sogar Bilder mit bekannten Persönlichkeiten. Und Dank der offenen Lizenz CreativeML Open RAIL-M sind die Bilder des veröffentlichten Modells auch kommerziell nutzbar.

Gute Bilder durch gute Prompts

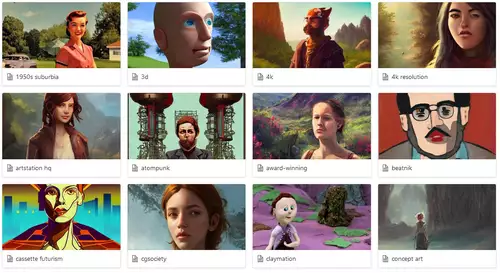

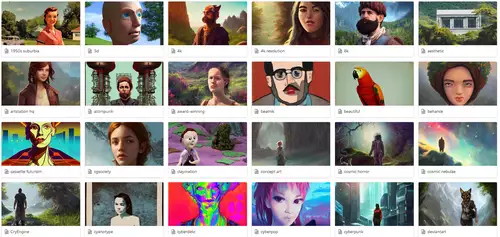

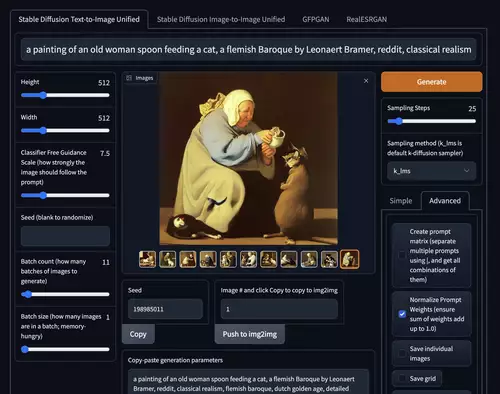

Etwas Übung erfordert allerdings die Kommunikation mit dem Programm - meist benötigt es eine Reihe von Anläufen, um zu einem gewünschten oder besonders schönen Ergebnis zu kommen. Es hilft beim sogenannten Prompt-Design - einer sich gerade entwickelnden, quasi eigenen Wissenschaft, für das es schon hilfreiche Anleitungen gibt - sich zunächst eine Reihe von Bildern anzusehen, die andere User generiert haben und deren Texteingaben zu studieren, um eine Ahnung zu bekommen von der Bandbreite der möglichen Inputs, die das Aussehen des resultierenden Bildes beeinflussen können.

Praktisch ist es auch, gleich eine Reihe von alternativen Versionen eines Bildes zu generieren, die sich manchmal erstaunlich unterscheiden. Mittels verschiedener Modifikatoren kann das Aussehen eines bestimmten Motivs in die unterschiedlichsten Stilrichtungen verändert werden - hier einige Beispiele.

Stable Diffusion auf dem eigenen PC

Voraussetzung für die Nutzung von Stable Diffusion auf dem eigenen PC ist eine GPU mit mindesten 4 GB VRAM (wie etwa eine Nvidia GeForce GTX 1660, RTX 2060 oder eine AMD Radeon RX 5600), um 512x512 Pixel große Bilder in wenigen Sekunden zu erzeugen. Zwar werden offiziell nur Nvidia GPUs unterstützt, aber inzwischen klappt das ganze erfreulicherweise auch mit AMD GPUs und https://replicate.com/blog/run-stable-diffusion-on-m1-mac Apples M1 Chips). Die Installation erfordert noch einige manuelle Schritte, es werden vermutlich aber bald auch komfortable Installer erscheinen.

Ein schönes Userinterface zu Bedienung von Stable Diffusion samt zahlreicher praktischer Funktionen bietet das Projekt Stable Diffusion web UI, welches unter anderem einen Bildeditor samt Image2Image (plus der Möglichkeit nur Teile eines Bildes zu manipulieren) sowie einen KI Upscaling-Algorithmus integriert und die Einstellung vieler Parameter der Generierung ermöglicht.

Alternativen zum eignen PC: Per Webdienst oder Google Colab

Wer keine entsprechende Grafikkarte hat, muss aber nicht auf Stable Diffusion verzichten: es gibt inzwischen zahlreiche Möglichkeiten, Bilder auch kostenlos (wenn auch in begrenztem Umfang bzw. etwas langsamer) online selbst zu generieren, wie zum Beispiel bei Hugginface oder in einer verbesserten Version namens Dreamstudio, in welcher 1.024 x 1.024 große Bilder erzeugt werden können und man einfache Kontrolle über die verschiedenen Einstellungen der Generierung hat, auch bei Stability.ai selbst. Dreamstudio erlaubt eine Reihe von kostenlosen Läufen, bevor man zur Kasse gebeten wird. Weitere kostenfreie Online-Dienste mit einem simplen Interface zum Ausprobieren findet man auf dieser umfangreichen Liste.

Eine weitere Möglichkeit, die aber eher für User mit Programmierkenntnissen geeignet ist, bietet die Nutzung von Googles Colab, einem Online Python-Editor samt Laufzeitumgebung, welcher Nvidia Tesla ML-GPUs der Google-Cloud nutzt und auch in der kostenfreien Standardversion per Stable Diffusion Bilder rendern kann. Dank seiner Programmierumgebung können mittels kleiner Hacks schöne Features wie etwa die Generierung beliebig vieler Alternativen in einem Lauf implementiert werden.

Hier findet sich auch eine noch komfortablere Version mit dem oben genannten Webinterface. Wissenswertes zu Stable Diffusion findet sich im folgenden Wiki. Und wer wissen will wie eine solche Generierung von Bildern funktioniert, findet hier eine Beschreibung in Form eines Twitter Threads bzw. auch im folgenden Video:

Probleme hat Stable Diffusion oft noch mit menschlichen Gliedmaßen oder den Augen, die manchmal seltsam aussehen - das Team von Stability.ai arbeitet aber bereits an einer verbesserten Version.

Die Stable Diffusion Revolution durch bildgenerierende KI

Weil Stability.ai - anders als zum Beispiel OpenAI (DALL-E2) oder Midjourney - erstmalig auch den zugrundeliegenden Programmcode samt trainiertem (und für normale GPUs komprimiertem) Modell veröffentlicht hat, explodieren gerade sowohl die Nutzerbasis als auch die darauf basierenden Tools und Online Dienste - nahezu täglich entwickeln User weitere - meist ebenfalls offene - KI Tools, die neue Möglichkeiten eröffnen. So gibt es jetzt zum Beispiel die spezialisierte Suchmaschine Lexica, mit deren Hilfe man 5 Million mit Stable Diffusion erzeugte Bilder nach Bildmotiven und Prompts durchsuchen kann und so Inspirationen für eigene Projekte finden. Andere Projekte feilen an Bildern mit einer noch höheren Auflösung oder interaktiver Bearbeitung.

Viele Künstler experimentieren schon mit Stable Diffusion und entdecken für sich neue Möglichkeiten und Workflows in Interaktion mit der KI. Wie in Zukunft die professionelle Zusammenarbeit von Künstlern mit einer bildgenerierdenen KI aussehen könnte, demonstriert das im Verein mit Stable Diffusion veröffentlichte und darauf basierende Tool img2img, welches mehr Kontrolle über den Generierungsprozess ermöglicht als Stable Diffusion selbst, denn es kann als Vorlage für eine exakte Bildkomposition eigene Skizzen nutzen. Da img2img auch einfach vorgegebene Bilder in andere Stile umwandeln kann, gibt es auch schon damit produzierte Animationen von Videos, allerdings hapert es dabei noch an einer zeitlichen Kohärenz der Bilder.

Das folgende Video demonstriert schön, wie mit Hilfe von Stable Diffusion in Form eines Photoshop-Plugins (des noch in einer privaten Betaphase befindlichen Alpaca ) ganz gezielt künstlerische Visionen umgesetzt werden könnten:

Was bringt die Zukunft?

Entwickelt wurde Stable Diffusion von Forschern der CompVis Gruppe der Ludwig-Maximilians-Universität München und EleutherAI, der Non-Profit-Organisation LAION sowie dem KI-Unternehmen Stability AI. Erklärtes Ziel von stability.ai ist die stetige Weiterentwicklung von Stable Diffusion - die Bereiche Audio und Video werden als nächstes angepeilt.

Man kann bislang nur ahnen, welche Auswirkungen die allgemeine Verfügbarkeit einer solchen bildgenerierenden KI auf die Gesellschaft hat - welche Jobs (wie etwa Illustratoren) werden überflüssig gemacht (oder ändert sich einfach deren Arbeitsgebiet?), welche neuen Möglichkeiten wird es geben? Wird die Bildgenerierung per KI ein Massenphänomen und für die Produktion von Memes wie ein Turbobeschleuniger wirken? Wird die Entwicklung mittelfristig zum Tod von unter anderem Stock Photo Portalen führen und die davon abhängigen Künstler arbeitslos machen?

Wird die kreative Revolution per Internet und Smartphones ("jeder ist ein Produzent") durch KI Tools in allen Bereichen (jetzt Bild, bald auch Animation, 3D, Sound und Video) für das extrem einfache Generieren und Editieren von beliebigen Ideen und Inhalten noch um ein vielfaches verstärkt werden? Besonders wenn - wie gerade bei TikTok geschehen - solche Tools in Apps und soziale Netzwerke einfach integriert werden? (Alp-)Traummaschinen für jedermann?