Eine oft gelesene Regel für die Nutzung von Festplatten lautet, sie nie über 80% ihrer Speicherkapazität zu füllen - allerdings hält sich kaum jemand daran, warum sollt man auch wertvollen Festplattenspeicherplatz nicht nutzen, und so zum Beispiel auf 200GB von 1000 GB oder auf 1 TB von 5 TB Speicherplatz verzichten?

Der verlinkte Artikel erklärt anhand des technischen Basiswissens den Hintergrund der 80%-Regel. Sie ist wichtig, weil die Leistung von Festplatten bei abnehmendem Speicherplatz stark einbricht. Dabei differiert diese Leistungsabnahme zwar von Modell zu Modell, aber sie ist bei jeder HDD deutlich. So beträgt die Lesegeschwindigkeit einer 2 TB Western Digital (WD2003FYYS) HDD ganz außen 101.62 MB/s und sinkt dann bei einer Nutzung von 50% des Speicherplatzes auf den inneren Spuren auf 78.70 MB/s und bei 90% auf 49.02 MB/s - etwas mehr als eine Halbierung der Leistung auf den innersten Sektoren.

Je weiter innen desto langsamer

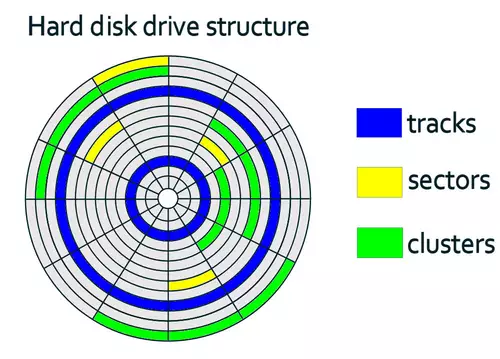

Der Grund dafür ist ein physikalischer: aufgrund der ringförmigen Anordnung der Daten in Spuren (Tracks) passen mehr Informationen auf eine Spur je weiter diese am Rand der Scheibe positioniert ist, weil der Umfang und damit ihre Länge größer ist. So werden bei einer einzigen Umdrehung innerhalb des gleichen Zeitraums mehr Daten auf einer äußeren Spurch gelesen (d.h. die Geschwindigkeit der Datenübertragung ist höher) als bei einer weiter innen liegenden.

Da deshalb Festplatten immer von außen nach innen beschrieben werden, nimmt die Lese- und Schreibgeschwindigkeit immer weiter ab, je voller sie sind d.h. je weiter innen sich die gelesenen bzw zu schreibenden Daten befinden. Die 20%-Regel gibt dabei einen groben Fingerzeig, ab welcher Füllmenge die Geschwindigkeit einer Festplatte sehr stark einbricht. Je weiter innen also der genutzte Bereich einer Festplatte liegt, desto langsamer ist der Zugriff darauf.

Die Beachtung der 20%-Regel für den Speicherplatz bringt aber auch noch weitere Vorteile: wird ihr gefolgt, bleibt immer genügend Platz für die Defragmentierung von Daten durchs Betriebssystem und für eventuelle temporäre oder Cache-Dateien (wenn es sich ums Hauptlaufwerk handelt).

// Top-News auf einen Blick:

- Blackmagic Resolve Studio für 236,81 bei Teltec - und weitere Angebote

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Ausgewählte Angebote - DJI Mavic 4 Pro, Canon R5 C, Sachtler aktiv12T...

- Die besten Black Friday Deals für Sony und Canon DSLMs und Objektive

- Blackmagic bietet bis zu 30% Rabatt auf seine 6K Kameras

- Große Übersicht - Black Friday Deals 2025 für Foto+Video - Kameras, Objektive, Zubehör usw.

Im Endeffekt bleibt dem User nur die Abwägung zwischen Geschwindigkeit und Speicherplatz: entweder wird der vorhandene Speicherplatz maximal ausgenutzt auf Kosten der Geschwindigkeit (eventuell ist die Hälfte der Maximalgechwindigkeit bei schnellen Festplatten ja noch schnell genug) oder das Ziel ist eine durchgehend große Geschwindigkeit für welche Speicherplatz geopfert werden muss - im Resultat müsste also dann immer 20% mehr Speicher gekauft werden als nominell vorhanden ist.

Und SSDs?

Zwar gilt die 80% nur für HDDs, nicht aber SSDs - allerdings sollten SSD User (aus anderen technischen Gründen) eine ähnliche Regel beachten. Die meisten SSDs organisieren den Speicherplatz schon so, daß versteckt ungefähr 10-15% frei bleiben - je nach Modell (da das sogenannte Over-Provisioning schon für unsichtbare Reserve von bis zu 28% des Speicherplatzes sorgt). Manchmal - z.B. bei Samsung SSDs - kann der User per SSD-Tool sogar selbst die Größe des Over-Provisionings bestimmen.

Grund für die Notwendigkeit von freiem Speicherplatz bei SSDs ist allerdings natürlich nicht die physikalisch unterschiedliche Länge der Tracks. Bei SSDs wird freier Speicherplatz als Reserve für ausfallende Speicherzellen und zur Verlängerung der Lebensdauer der Speicherzellen per TRIM und Verschleiß-Nivellierung (Wear-Leveling) genutzt und sorgt für so Ausfallsicherheit. Außerdem steigert Reserve-Speicherplatz per Over-Provisioning für eine deutlich höhere Schreib-Performance.

Geraten wird bei SSDs deswegen zusätzlich zum Over-Provisioning zu einer immer mindestens zur Verfügung stehenden Speicherplatzreserve von 10-15%. Man kann diese Reserve auch einfach fest definieren indem man einfach entsprechend viel Platz keiner Partition zuweist - dieser Platz wird von der SSD dann automatisch fürs dynamische Over-Provisioning eingesetzt. Einer Studie von Intel zufolge erhöhte eine 10% Reserve fürs Over-Provisioning die Performance (Random IOPS) ums 2.5fache und die Lebensdauer um mehr als das doppelte.