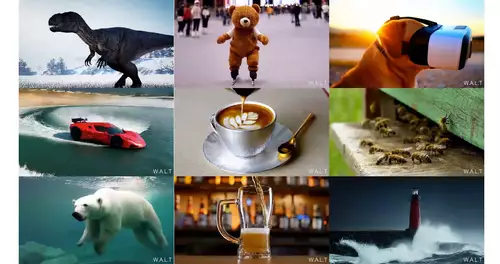

W.A.L.T. bei Bewegtbildern steht nicht mehr nur für Disney sondern für einen transformerbasierten Ansatz zur fotorealistischen KI-Videoerzeugung mittels Diffusionsmodellierung.

Googles neues Modell für generative KI-Videos beruht auf zwei Säulen: Einem einheitlichen Latent Space, der mit Bildern UND Videos trainiert wurde. Und einem Attention-Mechanismus, der nicht nur örtliche (spatiale), sondern auch zeitliche (spatiotemporale) Tokens verarbeitet.

Sehr vereinfacht gesprochen: Zeit, bzw Zeitpunkte werden bei diesem Modell ebenfalls zu Lern-Parametern. Dies ermöglicht W.A.L.T. in der ersten Version eine Text-zu-Video-Generierung mit einer Auflösung von 512 x 896 bei 8 Bildern pro Sekunde.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30–40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

So sind die gezeigten Videos von beeindruckender zeitlicher Konsistenz und können dabei schon relativ komplexe Bewegungsabläufe teilweise fehlerfrei wiedergeben. Auch Randmotive und Hintergründe sind nur von wenigen unbeabsichtigten Veränderungen geplagt.

Kurz gesagt, es handelt sich vielleicht nicht um einen Meilenstein, aber immerhin um einen weiteren soliden Schritt in Richtung fotorealistische KI-Videogenerierung.

Um sich selbst eine Meinung über W.A.L.T. bilden zu können, hat Google eine eigene Webseite mit Sample-Videos ins Netz gestellt - die natürlich nur die gelungensten Ergebnisse des W.A.L.T.-Modells offenlegt. Aber das ist bei Präsentationen von anderen, konkurrierenden KI-Modellen ja ebenso der Fall. Man darf sich also durchaus ein paar Minuten Zeit nehmen und berechtigt über die neuen Ergebnisse staunen..