Von der ETH Zürich kommt ein hochinteressantes Paper über "extrem gelernte Bildkomprimierung" mit neuronalen Netzen. Das wirklich spannende kann man dabei auf der verlinkten Projektseite mit der eigenen Maus am Bildschirm ausprobieren.

Denn auf der Seite befindet sich ein Bild, das mittels Javascript eine Verschiebung zwischen der "gelernten Kompression" und einer Vergleichs-Kompression ( BPG, WebP, JPEG2000, JPEG und unkomprimiertes Originalbild) ermöglicht.

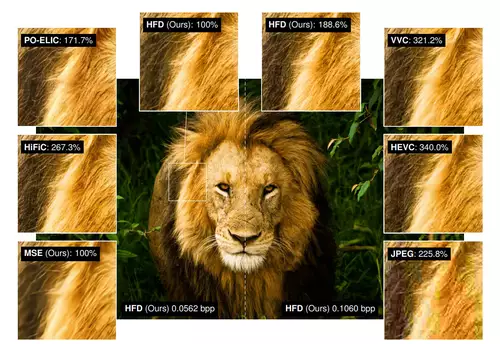

Bei sehr niedrigen Datenraten schneidet die neuronale Kompression dabei deutlich sichtbar besser ab. Doch spannend ist vor allem der Vergleich mit dem Originalbild. Denn während bei den herkömmlichen Kompressionsverfahren die Details in blöckrigem Brei verschwinden, "erfindet" die neuronale Kompression die fehlenden Details.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

Dies passiert, weil das Bild synthetisch aus gelernten Bildern erzeugt wird. Und weil das Original bei der Kompression nur mehr oder weniger als Objektreferenz-Beschreibung genutzt wird. Schaut man sich jedoch den Bus oder die Fassaden näher an, so stellt man fest, dass bis auf die korrekte Positionierung im Bild die Objekte vom Original deutlich abweichen.

Was ist bei niedriger Datenrate also besser? Keine Details oder erfundene Details? Wir denken das kommt auf den Anwendungsfall an. Auf jeden Fall riecht es schon jetzt danach, dass ein digitales Bild mit einem derart phantasievollen Decoder wohl bei Nutzung irgendwie gekennzeichnet werden sollte.

Ach ja, für flüssige Bewegtbild-Kompression dürfte sich dieses Verfahren bis auf weiteres nicht nutzen lassen, weil die Entscheidung, welche Details bei welchem Objekt genutzt werden schon durch einen minimalen Perspektivenwechsel "kippen" kann. So könnte sich dann schon mal der Modelltyp eines Autos zwischen zwei Frames sprunghaft ändern...