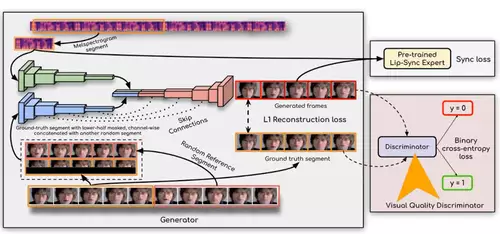

Der neue DeepLearning Algorithmus "Wav2Lip" eines indischen Forscher-Teams kann die Lippenbewegungen eines Sprechers an die Worte aus einer beliebigen Audioaufnahme in Echtzeit angleichen. Er zeigt schön die ständigen Fortschritte auf, welche die Machine Learning Technologie macht, denn die neue Methode liefert deutlich bessere Ergebnisse als ältere Projekte. Sie funktioniert nicht nur in Echtzeit sondern - und das ist der eigentliche Fortschritt - sie ist auch universeller, denn sie kommt mit jedem Gesicht, jeder Sprache und jeder Stimme zurecht und synchronisiert diese.

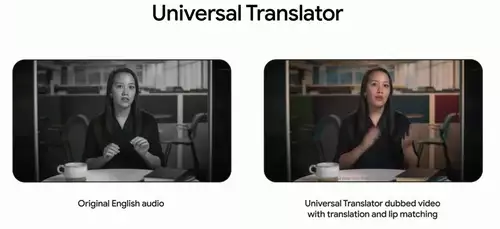

Der Nutzen eines solchen Algorithmus für die Arbeit mit Video ist offensichtlich - wie schon im Demovideo gezeigt, kann mit seiner Hilfe die Lippenbewegung einer sprechenden Person in einem Video an eine in einer anderen Sprache erstellte Synchronversion angepasst werden, um die für viele Zuschauer sonst störenden Asynchronizität von Mundbewegungen und Worten zu beseitigen. Praktisch ist das sowohl für nachsynchronisierte Filmversionen als auch für die Lippensynchronisation von Vorlesungen, Pressekonferenzen oder von Figuren animierter Filme in anderen Sprachen.

Und nicht zuletzt könnte diese Technologie auch grundsätzlich dabei helfen, statt O-Ton in szenischen Produktionen die Stimmen in der Postproduktion einfacher per Overdub nutzen zu können. Auch kleinere Sprachfehler (die sonst eine Szene gleich unbrauchbar machen würden) ließen sich hiermit bequem ausbügeln, indem die Lippen mal kurz automatisiert "nachgeführt" werden.

// Top-News auf einen Blick:

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Sony und slashCam verlosen eine FX2 Cinema Line Kamera

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

- Blackmagic PYXIS 12K - Sensor-Test - Rolling Shutter und Dynamik

Per Deep Learning Algorithmen wäre es so auch denkbar, anderssprachige Versionen von beliebigen Clips zum Beispiel auf YouTube automatisiert anzubieten. Eine automatische Transkription liefert YouTube ja schon jetzt, die nächsten Schritte sind auch schon möglich mithilfe verschiedener Deep Learning Algorithmen: die Übersetzung des transkribierten Textes in eine andere Sprache, die Sprachsynthese mit der Stimme der Originalstimme und dann die Lippensynchronisation des Videos mit dem neuen Ton.

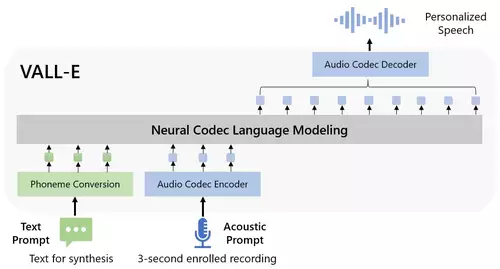

Natürlich kann die Technik aber auch dazu missbraucht werden, um Clips zu generieren, in denen Personen Sachen zu sagen scheinen, die sie nie gesagt haben - das neue Audio kann ebenfalls per neuronalem Netzwerk generiert werden, um die echte Stimme nachzuahmen.

Wie gut der Wav2Lip-Algorithmus ist, kann jeder auf der Demo-Website des Projekts selbst ausprobieren und einen kurzen (maximal 20 Sekunden) Videoclip einer sprechenden Person plus Sprachaudioclip hochladen, um dann eine Ausgabe des neu lippensynchronisierten Clips zu erhalten. Wer mehr ausprobieren will, findet auf GitHub den entsprechenden Programmcode. (Danke an unser Forenmitglied Ruessel für die News)