Das gerade veröffentlichte, quelloffene Text-zu-Video-Modell CogVideoX hat das Potential, die Video-KI Revolution nochmals deutlich zu beschleunigen, denn der Code wurde nicht nur samt seiner Modellgewichte zum freien Download gestellt, sondern läuft schon auf handelsüblichen Grafikkarten. Somit könnte jeder User mit einer nur halbwegs leistungsstarken GPU auf seinem Home-PC per KI Videos generieren, ohne sich angesichts zu vieler Versuche um die die Kosten Sorgen machen zu müssen - ldiglich der verbrauchte Strom schlägt zu Buche.

Konkurrenz für Runway, Luma und Kling?

Das von Forschern der Tsinghua University und von Zhipu AI - richtig, auch dies ist ein chinesisches Projekt - neuentwickelte CogVideoX ( hier das Paper ) generiert Videos von bis zu 6 Sekunden Länge in einer Auflösung von 720x480 Pixeln. Der einzige Wermutstropfen ist allerdings die geringe Bildwiederholungsrate von 8 Bildern pro Sekunde - diese könnte aber nachträglich mittels intelligenter Interpolation per KI noch erhöht werden.

Hot New Release: CogVideoX-5B, a new text-to-video model from @thukeg group (the group behind GLM LLM series)

— Gradio (@Gradio) August 27, 2024

- More examples from the 5B model in this thread

- GPU vram requirement on Diffusers: 20.7GB for BF16 and 11.4GB for INT8

- Inference for 50 steps on BF16: 90s on… pic.twitter.com/GAyWmst5GW

Die erste Version von CogVideo erschien bereits 2022, aber erst die aktuelle Version CogVideoX liefert jetzt Ergebnisse, die laut Benchmarks der Forscher Konkurrenten wie Videocrafter 2.0 und Sora übertreffen soll. Anhand der gezeigten Beispiele kann sich jeder dazu seine eigene Meinung bilden - allerdings ist die Messlatte für die Qualität von Video-KIs gerade durch das neue chinesische Modell MiniMax nochmal deutlich erhöht worden. Die auf einem Heim-PC generierten Clips des YouTube-Videos unten jedenfalls entsprechen nicht dem aktuellen Qualitätsstandard.

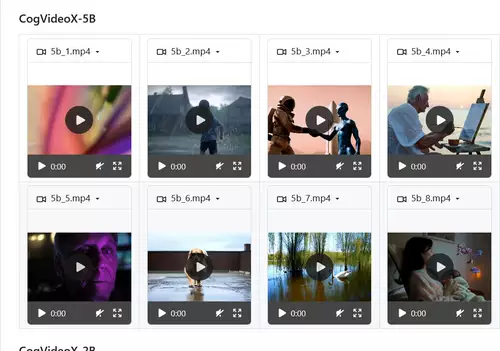

CogVideoX just released the weights for its 5B model!

— apolinario (@multimodalart) August 27, 2024

It&s the best open weights text-to-video model - competitive with Runway / Luma / Pika. With @diffuserslib, it fits on < 10GB VRAM 🤏

(ah, and they changed the smaller 2B model license to Apache 2.0 ) pic.twitter.com/5fxAk6BuLv

CogVideX kommt in zwei unterschiedlichen Versionen, welche sich in ihrer Modellgröße und demzufolge auch der erzielten Bildqualität und jeweiligen Hardware-Anforderungen unterscheiden. Standardmässig läuft das kleinere Modell CogVideoX-2B schon auf älteren GPUs wie der GTX 1080TI mit 11 GB VRAM und das größere CogVideoX-5B Modell mit 5 Milliarden Parametern auf Mittelklasse-GPUs wie der RTX 3060 mit 12 GB VRAM - mit Hilfe spezieller Parameter kann der Speicherhunger von CogVideoX-5B allerdings noch weiter verringert werden, sodass es schon auf auf Grafikkarten mit nur 5 GB VRAM arbeitet. Unterstützt wird momentan aber nur die Generierung per Text-to-Video - Image-to-Video bzw. Start-/End-Keyframes (noch) nicht.

2

Das CogVideoX-2B Modell wurde unter der großzügigen Apache 2.0 Lizenz veröffentlicht, das CogVideoX-5B unterliegt der leicht eingeschränkten CogVideoX Lizenz, welche Nutzern die gebührenfreie Nutzung der Software gewährt - für die kommerzielle Nutzung ist eine Registrierung und kostenlose Basislizenz erfordert, welche die kommerzielle Nutzung mit bis zu 1 Million Besuchen pro Monat erlaubt.

// Top-News auf einen Blick:

- Neue Gerüchte: Nvidia soll die GPU-Produktion 2026 um 30-40% runterfahren

- Adobe Firefly bekommt Upscaling per Topaz, Editing per Prompt und mehr

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

Selbst ausprobieren

Die freie Demo von CogVideoX-5B auf Hugginface integriert auf Wunsch schon ein Upscaling auf 1.440 x 960 Pixel und eine Interpolation der Bildrate auf 16 fps - hier finden sich auch mehrere Democlips. CogVideoX kann aber auch auf dem eigenen PC installiert werden, eine genügend leistungsstarke GPU mit ausreichend VRAM vorausgesetzt.

Wir wagen die Voraussage, dass CogVideoX großen Einfluss auf die Entwicklung von Video-KIs nehmen wird aufgrund der Tatsache, dass sein Code frei öffentlich verfügbar ist und deswegen leicht verwendet und vor allem weiterentwickelt oder integriert werden kann. Die Hardwareansprüche sind so gering, dass auch die Einsatzhürde sehr niedrig ist, da jeder Gaming-PC dafür ausreicht. Damit wird - wie schon bei quelloffenen LLMs wie Metas Llama - sichergestellt, dass die Weiterentwicklung und der Einsatz in Sachen KI nicht nur finanzstarken Großkonzernen vorbehalten ist, die das nötige Kapital für ein Training solcher Modelle haben.

Natürlich erhöht diese freie Zugänglichkeit einer hochwertigen Video-KI auch die Gefahr von noch mehr Fake-Videos - es ist noch nicht klar, ob die Forscher irgendwelche vorsichtsmaßnahmen eingebaut haben (bzw. ihre Trainingsdaten oder die Promptmöglichkeiten beschränkt haben), aber selbst wenn, wird die quelloffene Natur von CogVideoX wahrscheinlich bald zur Umgehung derselben einladen.

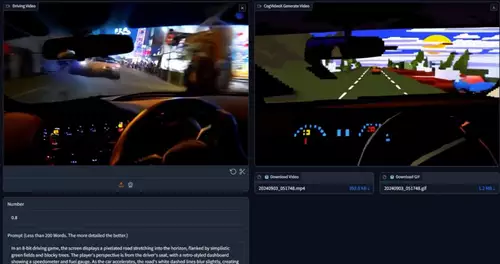

UPDATE 4. September : Ab sofort unterstützt CogVideoX auch Video-to-Video, d.h. ein Video kann in ein stilistisch anderes umgewandelt werden, wie wird zum Beispiel das Video einer Autofahrt aus der Ich-Perspektive in eine Computerspielgrafik umgewandelt:

Video-to-Video for CogVideo

— cocktail peanut (@cocktailpeanut) September 3, 2024

CogVideo video-to-video diffusers pipeline just dropped---it lets you take any video and turn it into another video.

So I've added a "video-to-video" tab to the CogVideo Gradio app.

Example: Turn a car driving video into a video game version. pic.twitter.com/cFzuP0Lm7l