KI-gestützte Bilderzeugung entwickelt sich mit rasanter Geschwindigkeit, doch eine der größten Herausforderungen bleibt die kreative Kontrolle. Stand der Technik ist bis auf weiteres das Erstellen von Szenen mit Text (sog. Prompting).

Die Beschreibung kann jedoch niemals alle Details beinhalten, die man als Anwender beabsichtigt. Und feine Details wie Komposition, Kamerawinkel oder Objektplatzierung sind zudem alleine durch Text nicht eindeutig oder exakt zu vermitteln. Deswegen ist man bei vielen Modellen dazu übergegangen, dass man dem KI-Modell auch ein Bild als eine Art Skizze von der eigenen Idee zum Prompt mitliefert.

Eine zweite Schwierigkeit besteht oft darin, einen Workflow aufzubauen, der Input- und Output des Modells letztlich zusammenbringt. Hierfür bedient man sich oft einer Node-Struktur und einer Oberfläche, mit welcher sich die einzelnen Funktionen visuell einfach verknüpfen lassen. ComfyUI ist hier eines der meistgenutzten Programme aus der Open Source Community, jedoch schreckt das nicht ganz triviale Setup so manchen potentiellen Anwender ab.

In diese Bresche will Nvidia mit seinen NIM-Microservices und Blueprints springen. Unter NIMs darf man sich von Nvidia kuratierte und optimierte KI-Modelle vorstellen, die sich leicht installieren und verknüpfen lassen. Solche NIM Microservices können beispielsweise ein Large Language Modell aber auch eine KI-Sprachausgabe sein. Meistens basieren die NIM Services dabei auf Open Source Modellen. Einen aktuellen Überblick findet man unter anderem hier.

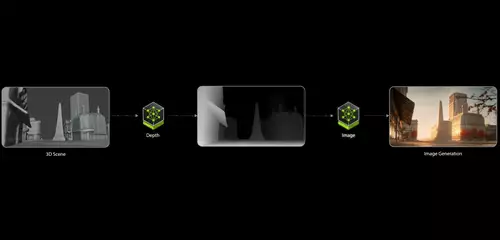

Gleichzeitig entwickelt und verteilt Nvidia auch sogenannte KI Blueprints. Dies sind Beispiel-Workflows, welche NIMs zu einer nutzbaren Applikation verknüpfen. Ein solcher Blueprint für 3D-gesteuerte generative KI steuert nun die Bildgenerierung, indem er einen 3D-Szenenentwurf in Blender verwendet , um dem Bildgenerator (FLUX.1-dev von Black Forest Labs) eine Depth-Map bereitzustellen, die zusammen mit einer Benutzereingabe anschließend die gewünschten Bilder generiert.

// Top-News auf einen Blick:

- Erste Black Friday Angebote von Atomos, Nanlite, DZOFILM und mehr

- SanDisk stellt Extreme Fit vor: Aktuell kleinster 1TB USB-C-Speicherstick

- Apple plant OLED-MacBook Pro, Mac Studio M6 Ultra und Mini-LED Studio Display

- DJI Avata 360 - Leaks zeigen DJIs neue 360°-Drohne

- ARRIs Color KnowHow könnte Millionen Wert sein - als Workflow Lizenz für Dritte

- Canon EOS C50 im Praxistest: Kompaktes Arbeitstier mit 7K 50p Raw - die neue FX3 Konkurrenz

In der Praxis sieht die Anwendung so aus:

Die Depth-Map hilft dem Bildmodell zu verstehen, wo Dinge platziert werden sollen. Der Vorteil dieser Technik besteht darin, dass keine hochdetaillierten Objekte oder hochwertigen Texturen erforderlich sind, da die Objekte sowieso in Graustufen umgewandelt werden. Weil die Szenen in 3D vorliegen, können Benutzer Objekte problemlos verschieben und Kamerawinkel ändern. Natürlich ist hierfür jedoch ein Basis-Verständnis von der Blender-Bedienung notwendig.

Für die technisch interessierten: Hinter dem Blueprint verbirgt sich weiterhin ComfyUI, welches sich besonders leicht installieren lässt. Für die Grafikausgabe ist als NIM- Microservice ein FLUX.1-dev-Modell zuständig, das für GeForce RTX-Grafikprozessoren optimiert wurde. Dieser konkrete KI-Blueprint für 3D-gesteuerte generative KI erfordert mindestens eine NVIDIA GeForce RTX 4080 Grafikkarte.