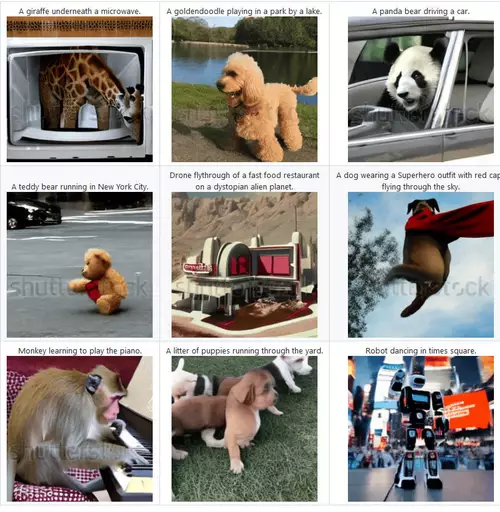

Schneller als noch vor kurzem gedacht verbessert sich die Qualität von Text-zu-Video-KIs. Waren vor kurzer Zeit vorgestellte Video-KIs wie Metas Make-a-Video, Googles Imagen und Phenaki oder das quelloffene VideoFusion noch beschränkt auf die Erzeugung kleiner Videos (256 x 256 bzw. 128 x 128 Pixel, nur Imagen erreichte 1.280 x 768) erzielt die neue Video-KI von Nvidia jetzt Auflösungen von bis zu 1.280 x 2.048 Pixeln bei 24 fps und zeigt deutlich weniger temporale Artefakte bzw. eine bessere Kohärenz zwischen den einzelnen Frames.

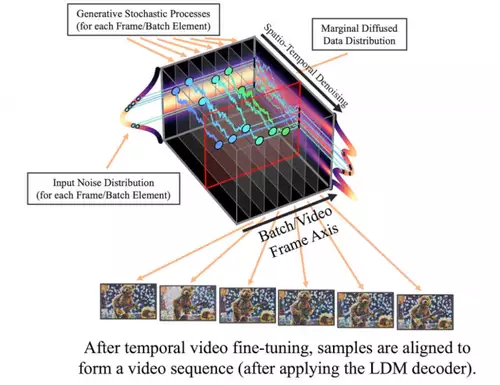

Mitgearbeitet im Forscherteam von NVIDIA haben mit Andreas Blattman und Robin Rombach zwei Experten der LMU München, die auch schon die Bild-KI Stable Diffusion mitentwickelten. Wie diese nutzt auch die neue Video-KI ein latentes Diffusionsmodell (LDM) für Standbilder. Aus dem Standbildgernerator wird ein Videogenerator, indem eine zeitliche Dimensionsvariable in das Diffusionsmodell mit eintrainiert wird. Da das genutzte Modell von Stable-Diffusion-Gewichten abgeleitet wurde, liegt die primäre Output-Auflösung noch deutlich unter HD.

Deswegen bekommt auch der darauffolgende Diffusion Upsampler ebenfalls eine zeitliche Komponente spendiert, was dann zu einer zeitlich konsistenten Video-Superresolution führt. Mit dieser Verkettung sind dann mehrere Sekunden lange Videos mit einer Auflösung von bis zu 1.280 x 2.048 Pixel bei "vertretbarem" Rechenaufwand möglich. Die Framerate wird zweimal mit der Hilfe eines speziellen Latent Diffusion Modells hochgesamplet, um relativ flüssige Bilder mit 24 fps zu ermöglichen.

Eine ganze Reihe von 4.7 Sekunden langen Beispielvideos kann man auf der Demoseite in voller Auflösung betrachten, wenn man sie jeweils in einem extra Fenster öffnet.

// Top-News auf einen Blick:

- ByteDance Vidi2 produziert selbstständig fertige Videos aus Rohmaterial

- Blackmagic DaVinci Resolve 20.3 bringt Support für 32K-Workflows und mehr

- Kommt die Sony Alpha 7 V am Dienstag?

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- DJI Neo 2: Verbesserte Mini-Drohne für Solo-Creator und Einsteiger

- Blackmagic PYXIS 12K - Sensor-Test - Rolling Shutter und Dynamik

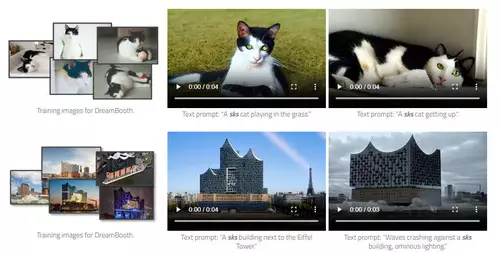

Interessant ist auch die Möglichkeit, per DreamBooth eigene Objekte in die synthetisierten Videos einzubinden, also die Text-to-Video KI zu personalisieren:

Es gibt auch einen ganz besonderen Anwendungsfall, in welchem die neue Methode sogar mehrere Minuten lange kohärente Videos - allerdings nur mit einer Auflösung von 512 x 1.024 Pixeln - erzeugen kann, nämlich Videos von Fahrszenen in freier Wildbahn. Im folgenden ein 9-sekündiger Clip - das ganze 5-minütige Video findet sich hier.

Bei der aktuellen Entwicklungsgeschwindigkeit dürfte es nicht mehr lange dauern, bis auch noch längere, wirklich fotorealistische Videos per Texteingabe frei erzeugt werden können.