Als die ersten Videos von OpenAIs Video-KI Sora erschienen, war klar, dass demnächst - früher als erwartet - massenhaft täuschend echt aussehende Filme von KIs generiert werden können, zusätzlich zu den jetzt schon kursierenden DeepFakes, die leichter zu produzieren sind.

Schon jetzt stolpert man gelegentlich über Videos, bei denen sich die Frage stellt, ist das echt oder gefälscht? Zwar gibt es - noch - einige Merkmale an denen man mit bloßem Auge erkennen kann, ob ein Video "fake" ist, aber das wird in Zukunft angesichts des stetigen Fortschritts von Video-KIs immer schwieriger werden. Zudem hat nicht jeder Betrachter das für eine Erkennung von Video-KIs notwendige Wissen. Eine vollautomatische und zuverlässige Erkennung - am besten gleich in den sozialen Netzwerken interiert - wäre also ideal.

Bisher haben sich Algorithmen zur Erkennung von KI-Videos allerdings schwer getan und keine zuverlässigen Resultate erzielt. Warum? Weil sie Methoden einsetzten, die eigentlich zur Erkennung von KI-generierten Bildern entwickelt worden waren. Doch die einzelnen Frames von KI-erstellten Videos weisen ganz andere typische Merkmale auf, als die Bilder von Bild-KIs wie etwa Stable Diffusion, DALLE3 oder Midjourney. Forscher der Drexel University in Philadelphia schlagen jetzt eine verbesserte Methode vor, um solche Videos sicherer als bisher identifizieren zu können.

OpenAI’s new Text to video model “Sora” just announced pic.twitter.com/fvhcwxc6qb

— AI Breakfast (@AiBreakfast) February 15, 2024

// Top-News auf einen Blick:

- Leak: Samsungs plant SATA-Aus - Kommt der Preisschock auch bei SSDs?

- Kompaktkameras wieder im Trend - trotz Smartphones

- Von Mickey Mouse bis Darth Vader - Disney lizenziert seine Figuren an OpenAIs Sora

- Verstehen Video-KIs die Welt? Physik-IQ enthüllt Grenzen der Modelle

- CineBias by RED - 9 neue, kostenlose Nikon Bildrezepte

- Datacolor SpyderPro - Überragendes Feature-Upgrade für Videografen

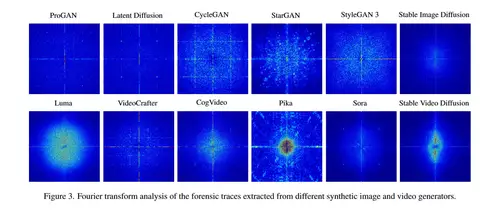

Interessant ist auch die Visualisierung der Eigenheiten der verschiedenen Bild-/Video-KIs, indem deren charakteristische Rauschmuster extrahiert werden - diese variieren teils erheblich von KI zu KI, was sich nutzen läßt, um die betreffenden KIs zu identifizieren. Anhand der Rauschmuster kann auch eingeschätzt werden, wie ähnlich die unterschiedlichen Video-KIs in ihrer grundsätzlichen Stuktur sind - im folgenden Bild ist gut zu sehen, dass Pika (über dessen Algorithmus wenig bekannt ist) offensichtlich ein anderes Verfahren nutzt als z.B. Sora. Und dass Video-KIs generell andere Muster erzeugen als Bild-KIs.

Die Ergebnisse der Studie sind hoffnungsvoll: mit der vorgeschlagenen Methode lassen sich jetzt - und auch in nächster Zukunft - ziemlich zuverlässig von KIs generierte Videos erkennen. Es liegt allerdings in der Natur der Sache, daß diese Erkenntnisse auch dazu verwendet werden können, die typischen Merkmale von KI-Videos nachträglich zu verschleiern, um deren Entarnung zu vernhindern.