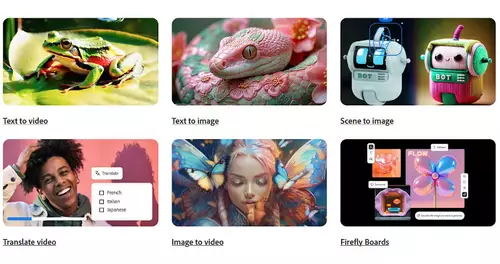

An generativen Fähigkeiten für Video arbeitet Adobe schon länger - schon letztes Jahr wurde Firefly für Video geteasert. Nun zeigt Adobe erstmals eigene, KI-generierte Clips. Solche künstlich erstellte Sequenzen sollen den Editing-Alltag vereinfachen, indem sich beispielsweise fehlende Establishing-Shots oder Schnittbilder herbeizaubern lassen, oder - bei zu kurz gehaltenen Einstellungen - extra Frames für einen Schnittübergang.

Laut Adobe gelingen Naturvideos ihrem Videomodell derzeit besonders gut, also Landschaften, Tiere oder Pflanzen. Was im Umkehrschluss vermuten läßt, dass Firefly Menschen in Bewegung noch nicht perfekt meistert; solche Bilder fehlen im präsentierten Demomaterial. (An menschlichen Bewegungen scheitern bisher allerdings praktisch alle KI-Videogeneratoren, lediglich das zuletzt vorgestellte Video-01-Modell von MiniMax zeigt in dieser Hinsicht deutliche Fortschritte). Detailansichten von menschlichen Gesichtern erstellt Firefly für Video jedoch wie es scheint anstandslos.

Für Motion-Graphics oder Videoanimationen ist Firefly in der Lage, bewegte Elemente wie Feuer, Rauch, Staub oder Wasser vor schwarz oder blau zu erstellen, welche sich dann in Premiere oder After Effects via Ebenenmodi oder einem Key mit Echtfootage überlagern lassen. Auch lassen sich mit Firefly bei der Projektentwicklung verschiedene Ideen auf die Schnelle visualisieren und mit Kunden oder Team teilen (auch in verschiedenen Stilen wie Strichzeichnung oder Claymation).

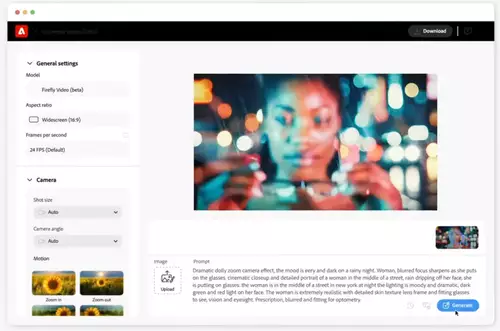

Bedienung und Optionen

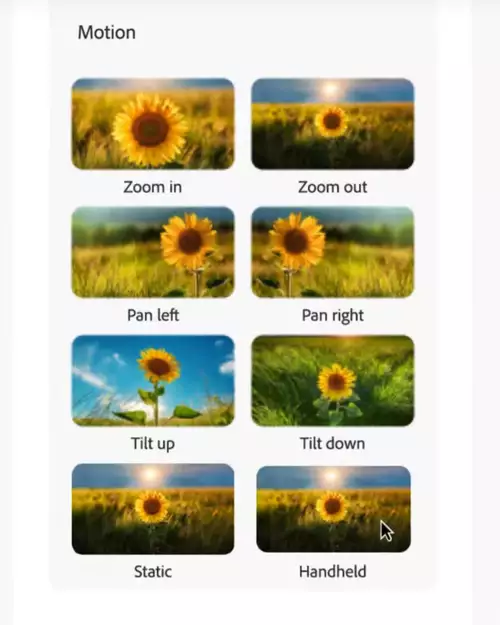

Firefly für Video wird Clips ausgehend sowohl von Textprompts (Text-to-Video) als auch von einem Referenzbild (Image-to-Video) generieren, dabei lassen sich auch recht konkrete Angaben zum gewünschten Look und zur Kamerabewegung machen - in einem Beispiel wird neben einer anfänglichen Unschärfe etwa ein Dolly-Zoom verlangt und geliefert (letzteres überrascht natürlich nicht, schließlich sind diese Clips handverlesen).

// Top-News auf einen Blick:

- Blackmagic Resolve Studio für 236,81 bei Teltec - und weitere Angebote

- Bis zu 1.000 Euro sparen: Cashbacks auf Kameras von Sony, Nikon, Canon und Panasonic

- Ausgewählte Angebote - DJI Mavic 4 Pro, Canon R5 C, Sachtler aktiv12T...

- Die besten Black Friday Deals für Sony und Canon DSLMs und Objektive

- Blackmagic bietet bis zu 30% Rabatt auf seine 6K Kameras

- Große Übersicht - Black Friday Deals 2025 für Foto+Video - Kameras, Objektive, Zubehör usw.

Die im Democlip gezeigte Anwenderoberfläche enthält einige weitere Hinweise darauf, welche Parameter beim Generieren angegeben werden können (bis zum Launch kann sich das finale Interface freilich nochmal ändern). Dies wären neben dem Seitenverhältnis die Framerate, die Einstellungsgröße, der Kamerawinkel sowie die Kamerabewegung. Außerdem fällt ein Dropdown-Feld mit der Bezeichnung "Model" auf - Adobe hatte ja zur NAB in Aussicht gestellt, auch Videomodelle von anderen (OpenAIs Sora, Runway etc.) integrieren zu wollen. Davon ist in der aktuellen Demo nicht explizit die Rede, jedoch taucht der entsprechende Menüpunkt also nachwievor (oder schon) auf.

Bis zu welcher Länge sich KI-Sequenzen generieren lassen, wird nicht angegeben; die gezeigten Einstellungen sind alle ca. 4 Sekunden lang. Sie wurden laut Adobe in unter 2 Minuten errechnet. Da auch das Adobe Firefly Video-Modell ausschließlich an dafür lizenziertem Material trainiert wurde, ist die Nutzung der generierten Clips auch im kommerziellen Umfeld unbedenklich.

Auch wann Firefly für Video zugänglich werden soll, ist noch offen - später im Jahr soll jedoch die ebenfalls zur NAB geteaserte Generative Extend-Funktion in Premiere Pro Einzug halten. Außerdem hat Adobe gerade zur IBC 2024 noch weitere neue Funktionen für Adobe Premiere Pro und After Effects vorgestellt.